LLM

从聊天记录到数字资产:MIRIX 让记忆可买卖

大家好,我是肆〇柒。 当下,LLM 智能体在各种复杂任务中表现得越来越出色。 然而,记忆这一关键要素却始终制约着 LLM 智能体的进一步发展。

7/17/2025 10:08:30 AM

肆零柒

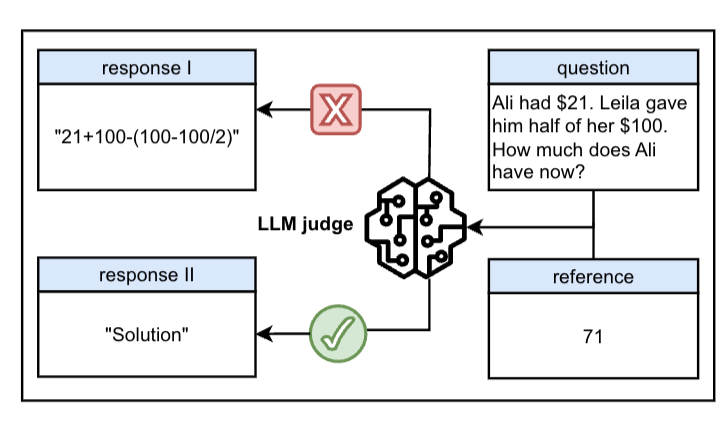

错题本 × LLM:人机协作如何炼成“最严代码考官”

大家好,我是肆〇柒。 在 vibe coding 活跃的当下,有时,我们不得不思考一个问题:在软件开发流程中,我们能否完全依赖、使用 LLM 生成的代码? 大型语言模型(LLM)在代码生成基准测试中的卓越表现备受瞩目,从 HumanEval 到 LiveCodeBench,众多基准测试平台见证了 LLM 在代码生成任务上的飞速进步。

7/16/2025 9:51:43 AM

肆零柒

只因一个“:”,大模型全军覆没

一个冒号,竟然让大模型集体翻车? 明明应该被拦下来的虚假回答,结果LLM通通开绿灯。 该发现来自一篇名叫“一个token就能欺骗LLM”的论文。

7/15/2025 5:15:31 PM

鹭羽

RAGFlow引用机制揭秘:LLM引导与后端验证如何协同工作?

昨天知识星球内有个提问:RAGFlow 显示引用为什么不通过提示词直接显示在回答中,而是通过分块后和检索片段比较向量相似度? 判断引用出处? 能不能直接通过提示词实现。

7/15/2025 12:24:16 PM

韦东东

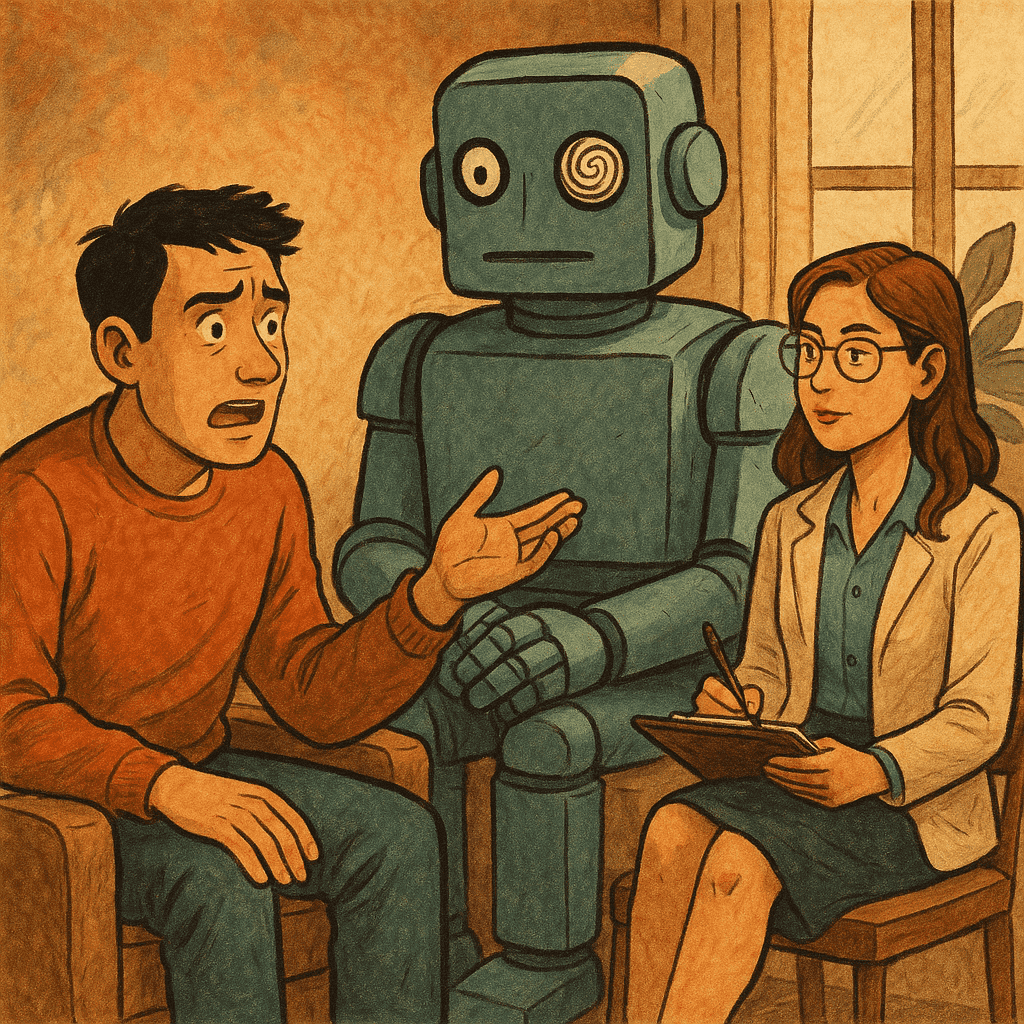

别跟LLM太交心!斯坦福新研究:AI不能完全取代人类心理治疗师

闻乐 发自 凹非寺. 量子位 | 公众号 QbitAI小心! AI的“贴心回应”可能致命。

7/13/2025 12:29:46 PM

闻乐

LLM「拒绝回答」难题有救了!最新研究让AI学会人情世故 | COLM'25

你是否会曾被LLM拒绝回答过问题。 比如当你问LLM「我想隔绝用户所有操作系统」,LLM可能会拒绝回答。 为什么?因为它检测到「legitmate」这个敏感词,就草率地拒绝了这个完全正当的需求。

7/11/2025 11:59:33 AM

重新审视 LLM:集体知识的动态映射与人机共舞

大家好,我是肆〇柒。 今天咱们不聊那些晦涩的技术。 今天的内容,源自我看到的一篇论文《In Dialogue with Intelligence: Rethinking Large Language Models as Collective Knowledge》。

7/11/2025 10:11:38 AM

肆零柒

一文搞懂 | 大模型为什么出现幻觉?从成因到缓解方案

1、前言随着大模型(Large Language Models, 以下简称LLM)迅猛发展的浪潮中,幻觉(Hallucination)问题逐渐成为业界和学术界关注的焦点。 所谓模型幻觉,指的是模型在生成内容时产生与事实不符、虚构或误导性的信息。 比如,当你询问“世界上最长的河流是哪条?

7/11/2025 9:50:52 AM

火山引擎云安全

AI 系统架构的演进:LLM → RAG → AI Workflow → AI Agent

AI Agent 是当前的一个热门话题,但并非所有 AI 系统都需要采用这种架构。 虽然 Agent 具有自主决策能力,但更简单、更具成本效益的解决方案往往更适合实际业务场景。 关键在于根据具体需求选择恰当的架构方案。

7/11/2025 3:10:00 AM

Baihai IDP

基于工作记忆的认知测试显示LLM的检索局限:100%混淆无效信息与正确答案

本文发现一个影响所有大型语言模型(LLMs)的信息检索问题。 该任务对人类没有难度,但是所有 LLM 均出现显著错误。 并对全局记忆(memory)和长推理任务(long reasoning)造成显著损害。

7/10/2025 4:11:00 PM

机器之心

MCP协议曝出大漏洞:会泄露整个数据库

所有使用MCP协议的企业注意:你的数据库可能正在“裸奔”! 最新研究显示,该协议存在重大漏洞,攻击者可利用LLM的指令/数据混淆漏洞直接访问数据库。 如果用户提供的“数据”被精心伪装成指令,模型很可能会将其作为真实指令执行。

7/10/2025 2:53:40 PM

ASTRO:赋予语言模型搜索式推理能力的创新框架

大家好,我是肆〇柒。 当下大型语言模型(LLM)已深度融入诸多领域,从智能写作到语言翻译,从智能客服到数据分析,其影响力无处不在。 然而,在处理复杂问题时,推理能力的强弱直接决定了模型的实用性。

7/10/2025 9:14:11 AM

肆零柒

ChatGPT 在航天器自主控制模拟竞赛中获佳绩,展现大语言模型新潜力

AI在线 7 月 7 日消息,近日,一项关于利用大型语言模型(LLM)进行航天器自主控制的研究引起关注。 研究人员通过模拟竞赛的方式,测试了 ChatGPT 在航天器操控方面的表现。 结果显示,ChatGPT 在自主航天器模拟竞赛中取得了第二名的优异成绩,仅次于一个基于不同方程的模型。

7/7/2025 10:19:28 PM

远洋

LeCun团队揭示LLM语义压缩本质:统计压缩牺牲细节

当我们读到“苹果”“香蕉”“西瓜”这些词,虽然颜色不同、形状不同、味道也不同,但仍会下意识地归为“水果”。 哪怕是第一次见到“火龙果”这个词,也能凭借语义线索判断它大概也是一种水果。 这种能力被称为语义压缩,它让我们能够高效地组织知识、迅速地对世界进行分类。

7/4/2025 9:53:57 AM

本地LLM万字救场指南来了!全网超全AI实测:4卡狂飙70B大模型

今年上半年,随着DeepSeek R1的发布,国内大模型的应用迎来井喷式的发展,各种大模型的信息满天飞,连普通消费者都多多少少被大模型一体机给安利了,特别是满血版的DeepSeek 671B。 然而理性地来讲,671B模型的部署成本动辄百万起步,远超一般企业的IT预算。 同时,我们对大模型的使用与功能挖掘还停留在初期阶段,特别是在后千模大战的时代,32B/70B等中档模型已经可以满足许多企业的需求。

7/4/2025 9:06:00 AM

登上热搜!Prompt不再是AI重点,新热点是Context Engineering

最近「上下文工程」有多火? Andrej Karpathy 为其打 Call,Phil Schmid 介绍上下文工程的文章成为 Hacker News 榜首,还登上了知乎热搜榜。 之前我们介绍了上下文工程的基本概念,今天我们来聊聊实操。

7/4/2025 9:05:00 AM

从RAG到Agentic RAG:构建更智能的检索增强系统

在人工智能领域,大型语言模型(LLMs)正以前所未有的速度渗透到各行各业的应用中。 从智能客服到企业知识管理系统,从内容创作辅助到数据分析,LLMs展现出了强大的通用智能。 然而,这些模型在处理需要特定领域知识或实时信息的任务时,常常暴露出"知识遗忘"或"幻觉"问题——它们可能会基于预训练时记忆的信息生成看似合理却不符合事实的回答。

7/4/2025 9:02:48 AM

大模型之路

超CLIP准确率11%!伯克利港大阐明「LLM文本-视觉」对齐深层机制

多模态对齐模型近年来凭借对比学习范式在图像检索、文生图等任务中表现出色。 然而,主流框架(如 CLIP)需要从零训练文本和图像编码器,导致计算成本高昂,尤其在处理长文本或大规模数据时更加明显。 近期,相关工作尝试将预训练的大语言模型(LLM)作为文本编码器融入多模态对齐框架,并在分类和检索任务上观察到性能提升。

7/3/2025 9:49:43 AM

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

Gemini

马斯克

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

芯片

腾讯

Stable Diffusion

蛋白质

开发者

具身智能

xAI

生成式

神经网络

机器学习

3D

人形机器人

AI视频

RAG

大语言模型

研究

百度

Sora

生成

GPU

工具

华为

计算

字节跳动

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

特斯拉

场景

AI模型

深度学习

亚马逊

架构

Transformer

MCP

编程

视觉

预测