LLM

一文讲清楚大模型中六个关键词及原理:LLM、Transformer、Bert、预训练、微调FineTuning、机器学习

什么是大模型,相信每个人都能说上一个一二三点来。 比如:OpenAI、ChatGPT、DeepSeek、豆包、Manus等。 也知道大模型需要做训练与推理。

6/10/2025 1:00:00 AM

Zack之云原生

文档解析LLM MonkeyOCR震撼登场:3B小模型完胜Gemini

随着大语言模型(LLM)技术的迅猛发展,文档解析领域迎来了一位新星——MonkeyOCR。 这款轻量级文档解析模型以其卓越的性能和高效的处理速度,迅速成为业界关注的焦点。 MonkeyOCR:小模型,大能量MonkeyOCR以仅3B参数的轻量级架构,在英文文档解析任务中展现出惊艳的性能。

6/9/2025 12:00:56 PM

AI在线

多模态LLM+RAG:突破生成瓶颈的下一代AI架构革命

译者 | 朱先忠审校 | 重楼通过整合文本、图像、音频等数据,多模态大型语言模型(MLLM)开始突破传统RAG的文本局限,赋予AI感知能力。 其核心架构采用CLIP、Whisper等编码器实现跨模态语义统一,通过投影层对齐多模态信息。 不过,多模态大型语言模型的评估需要综合检索质量、生成忠实度及跨模态一致性等一系列指标实现。

6/9/2025 8:42:23 AM

朱先忠

真实联网搜索Agent,7B媲美满血R1,华为盘古DeepDiver给出开域信息获取新解法

大型语言模型 (LLM) 的发展日新月异,但实时「内化」与时俱进的知识仍然是一项挑战。 如何让模型在面对复杂的知识密集型问题时,能够自主决策获取外部知识的策略? 华为诺亚方舟实验室研究团队提出了 Pangu DeepDiver 模型,通过 Search Intensity Scaling 实现了 LLM 搜索引擎自主交互的全新范式,使得 Pangu 7B 模型在开域信息获取能力上可以接近百倍参数的 DeepSeek-R1,并优于 DeepResearcher、R1-Searcher 等业界同期工作!

6/6/2025 9:07:00 AM

LLM 协作革命:Group Think 如何重塑推理边界

大家好,我是肆〇柒。 今天和大家聊聊 Group Think。 顾名思义,它通过让单个 LLM 模拟多个并行推理智能体,并以 token 级别的细粒度协作,提出了推理协作的新范式。

6/6/2025 8:57:42 AM

肆零柒

RAG、向量数据库和LLM搜索:人工智能驱动商业智能的未来

译者 | 李睿审校 | 重楼本文对RAG、向量数据库和LLM搜索如何塑造人工智能驱动的商业智能未来进行探讨。 RAG通过集成知识检索提升LLM性能,解决其无法及时纳入最新或专有信息的问题,尤其在客户服务领域影响显著。 向量数据库则支持快速相似性搜索,理解查询语义。

6/6/2025 8:39:15 AM

李睿

LLM 的 SFT 与 RL:差异几何?

在大型语言模型(LLM)的训练领域,监督微调(SFT)和强化学习(RL)是两种备受瞩目的训练策略。 尽管它们各自有着独特的机制和侧重点,但笔者经过深入研究和实践观察发现,二者之间的差别并非如表面上那般显著,以下是具体的分析与对比。 一、核心原理的相近性SFT 的本质 :SFT 主要是利用标注好的数据集对预训练的 LLM 进行进一步训练,通过最小化模型输出与标注答案之间的差异,来调整模型的参数。

6/6/2025 4:10:00 AM

小智

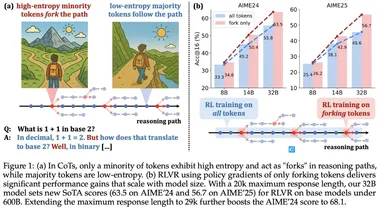

NVIDIA 新成果:ProRL 拓展 LLM 推理边界

大家好,我是肆〇柒。 本文想和大家分享一篇来自 NVIDIA 研究团队的前沿论文——《ProRL: Prolonged Reinforcement Learning Expands Reasoning Boundaries in Large Language Models》。 这篇论文挑战了强化学习在大型语言模型(LLM)中作用的传统认知,还提出了一种创新的训练方法 ProRL,通过长时间的强化学习训练,显著提升了模型的推理能力。

6/5/2025 11:51:14 AM

肆零柒

构建生产级LLM应用完整指南:从原型到落地的全流程实践

一、LLM应用落地的真实挑战当Jasper AI的写作助手因意外流量在数小时内崩溃时,人们意识到:让LLM应用从实验室走向真实用户,绝非简单的代码迁移。 根据Anthropic 2024年开发者调查,73%的LLM应用在触达用户前折戟沉沙,问题并非出在AI模型本身,而是支撑系统无法应对真实世界的复杂性——用户的不可预测输入、API的偶发故障、成本的突然飙升,这些都是原型阶段未曾遭遇的“暗礁”。 本文将以实战为导向,结合代码示例与架构设计,详解如何将一个基于OpenAI API的简单聊天机器人,升级为具备容错能力、成本可控且可弹性扩展的生产级系统。

6/5/2025 2:45:00 AM

大模型之路

LSTM之父22年前构想将成真?一周内AI「自我进化」论文集中发布,新趋势涌现?

让 AI 实现自我进化是人类一直以来的梦想。 早在 2003 年,AI 先驱、LSTM 之父 Jürgen Schmidhuber 就提出过一种名为「哥德尔机(Gödel Machine)」的构想——它使用一种递归的自我改进协议,如果能够证明新代码的策略较佳,就会重写自己的代码。 但这终究只是一个假想。

6/3/2025 9:14:00 AM

LeCun新作反杀AGI派!AI连「鸟」都搞不懂,拿什么超越人类?

LLM真的可以像人类一样「思考」了? 图灵奖得主Yann LeCun联手斯坦福团队最新论文,狠狠打脸了LLM类人的神话。 论文链接:,LeCun认为,大模型就是随机鹦鹉,它们的智力甚至连阿猫阿狗都不如。

6/3/2025 9:02:00 AM

微软再放LLM量化大招!原生4bit量化,成本暴减,性能几乎0损失

最近,微软亚研院的研究团队开源了原生1bit精度的大模型:BitNet b1.58 2B4T。 还没过几天,原班人马带着第二代BitNet v2来了! 这次性能几乎0损失,但占用内存和计算成本显著降低!

6/3/2025 8:49:00 AM

全流程拆解:如何使用 LM Studio 优化本地 LLM ?

Hello folks,我是 Luga,今天我们来聊一下人工智能应用场景 - 如何通过 LM Studio 优化本地 LLM 性能。 在人工智能浪潮席卷全球的 2025年,本地 LLM 的性能优化已成为开发者和企业关注的焦点。 随着计算资源需求激增,如何在本地环境中提升模型的效率、降低延迟并释放其最大潜力,成为了亟待解决的关键挑战。

6/3/2025 8:40:00 AM

Luga Lee

UC伯克利新作颠覆认知:LLM靠「自信爆表」学会推理?无需外部奖励超进化

就在刚刚,UC伯克利CS博士后Xuandong Zhao,分享出来自己「今年参与的最鼓舞人心的工作」。 他和同事们发现,在没有外部奖励的情况下,LLM竟然只靠「自信爆棚」,就学会了复杂推理? 论文地址:,竟能学会复杂推理LLM不靠外部奖励,就能自己学会复杂推理,这个结论实在很出乎意料。

6/3/2025 8:38:00 AM

ICML 2025 Spotlight | 谁导致了多智能体系统的失败?首个「自动化失败归因」研究出炉

想象这样一个场景:你开发了一个由多个大型语言模型 Agent 组成的智能团队,它们协作完成复杂任务,比如一个 Agent 负责检索,一个负责决策。 然而任务失败了,结果不对。 问题来了:到底是哪个 Agent 出了错?

6/3/2025 8:26:00 AM

首次解释LLM如何推理反思!西北大学谷歌新框架:引入贝叶斯自适应强化学习,数学推理全面提升

推理模型常常表现出类似自我反思的行为,但问题是——这些行为是否真的能有效探索新策略呢? 对此,西北大学与Google、谷歌DeepMind团队质疑了传统强化学习与反思的关系,并提出了贝叶斯自适应的强化学习方法,首次解释了为什么、如何、以及何时应该反思并探索新策略。 图片通过对比分别使用传统强化学习和新方法训练的模型,研究人员发现:在完成“模型需要在3步内输出三个连续相同字符”这一合成任务中,传统RL往往一条路走到黑,而新方法懂得排除无效假设,适时切换新策略。

6/3/2025 3:15:00 AM

量子位

RAG中基于图的重排序:利用图神经网络革新信息检索(含代码)

一、信息检索的演进与图重排序的崛起在大数据与人工智能技术爆发的时代,信息检索(IR)系统面临着前所未有的挑战:用户查询日益复杂,跨领域知识需求激增,传统基于词法匹配或单一语义向量的检索模型逐渐暴露局限性。 两阶段检索架构——初始检索与重排序——虽已成为主流,但第一阶段的快速检索常因忽略文档间关联而引入噪声,第二阶段的传统重排序器(如交叉编码器)又难以捕捉结构化知识与全局语义关系。 在此背景下,基于图的重排序(Graph-Based Re-ranking)技术应运而生,通过图神经网络(GNN)建模文档、实体与查询间的复杂关系,为信息检索领域注入了全新的活力。

6/3/2025 2:11:00 AM

大模型之路

Claude 团队打开大模型“脑回路”,推出开源 LLM 思维可视化工具

Claude 团队来搞开源了 —— 推出“电路追踪”(circuit tracing)工具,可以帮大伙儿读懂大模型的“脑回路”,追踪其思维过程。

5/31/2025 10:36:22 PM

汪淼

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

Gemini

马斯克

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

芯片

腾讯

Stable Diffusion

蛋白质

开发者

具身智能

xAI

生成式

神经网络

机器学习

3D

人形机器人

AI视频

RAG

大语言模型

研究

百度

Sora

生成

GPU

工具

华为

计算

字节跳动

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

特斯拉

场景

AI模型

深度学习

亚马逊

架构

Transformer

MCP

编程

视觉

预测