模型

北京发布开源生态三年行动方案!2028年前打造10个国际顶级开源项目,AI大模型落地目标100个

中国开源生态迎来政策强引擎。 近日,《北京市开源生态体系建设实施方案(2026— 2028 年)正式印发,明确提出:到 2028 年,培育 10 个具有国际影响力的开源项目(其中不少于 5 个达到国际引领水平),打造 30 个国内明星开源项目(AI领域占比超1/3),并推动 100 个行业大模型实现规模化落地应用。 这一方案标志着北京正以国家战略高度系统性构建全球领先的开源创新高地。

亚马逊 SageMaker已部署 Mistral AI 的 Voxtral 模型

近日,Mistral AI 推出了其 Voxtral 模型,旨在结合文本和音频处理功能,为多种应用场景提供支持。 Voxtral 系列包括两种不同的模型:Voxtral-Mini-3B-2507和 Voxtral-Small-24B-2507,前者为一个优化过的3亿参数模型,适合快速音频转录和基础的多模态理解,而后者则拥有240亿参数,支持更复杂的音频文本智能和多语言处理,非常适合企业级应用。 这两个模型均支持长达30至40分钟的音频上下文,具有自动语言检测功能,并可以处理多达32,000个标记。

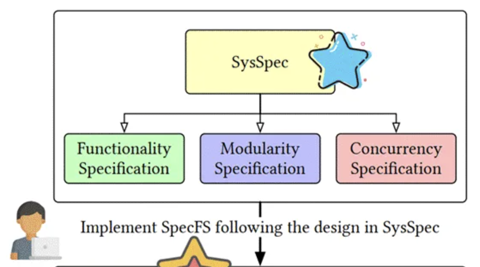

AI生成操作系统新突破!上海交大提出文件系统开发新范式:从此只需写规约

非羊 整理自 凹非寺. 量子位 | 公众号 QbitAI还记得《流浪地球2》里的那台550W量子计算机吗? 电影里,MOSS最让人印象深刻的点,除了其强大算力,还有它可以根据需求,实时生成底层操作系统的能力。

商汤大装置助力全国规划资源领域首个基础大模型-“云宇星空大模型(专业版)”正式发布

近日,全国规划资源领域首个基础大模型 “云宇星空大模型(专业版)” 在上海正式发布,该模型由上海市规划资源局联合商汤大装置共同研发。 云宇星空大模型(专业版)基于海量高质量 “文本 - 图像 - 空间” 多模态的行业语料,进行了城市空间治理领域全链路认知与决策能力的突破性构建,构建了集 “时空理解生成、知识整合检索、模型智能调度” 于一体的技术底座,具备了 “问不倒、能调图、会统计、能识图、会报告” 五大核心专业能力,将成为上海规划和自然资源行业专业人员处理各类专业问题的 “AI 伙伴”。 作为全国规划资源领域首个基础大模型,云宇星空行业基座大模型打造了 “基座大模型 六大垂类模型” 的 “1 6” 模型体系,兼顾通用能力与行业深度,支撑复杂空间治理场景下的专业智能需求;同时围绕不同业务目标,搭建面向多领域、多任务的智能体体系。

抖音SAIL团队联合港中文MMLab推出SAIL-Embedding:打通「视、文、音」的全模态嵌入

在短视频推荐、跨模态搜索等工业场景中,传统多模态模型常受限于模态支持单一、训练不稳定、领域适配性差等问题。 近日,字节跳动抖音 SAIL 团队联合香港中文大学 MMLab 提出 SAIL-Embedding——一款专为大规模推荐场景设计的全模态嵌入基础模型,不仅实现了视觉、文本、音频的统一表征,更在抖音真实业务场景中带来显著效果提升,相关技术报告已正式公开。 论文标题:SAIL-Embedding Technical Report: Omni-modal Embedding Foundation Model技术报告: 能力概览突破传统局限:全模态 工业级优化双管齐下现有多模态嵌入模型主要分为两类:以 CLIP 为代表的双塔架构,虽高效但模态融合浅;以 MLLM 为基础的融合架构,虽语义能力强却多局限于图文模态。

说话像ChatGPT,统统拉黑!「AI腔」正毁掉社交,奥特曼都受不了

遇到AI,直接拉黑。 不是AI,说话像AI的也拉黑! 自ChatGPT发布以来,「AI腔」就一直颇受网友诟病。

大模型如何准确读懂图表?微软亚研院教它“看、动手、推理”

多模态大模型(MLLM)在自然图像上已取得显著进展,但当问题落在图表、几何草图、科研绘图等结构化图像上时,细小的感知误差会迅速放大为推理偏差。 线性、刚性的“链式思考”流程也难以支撑复杂任务中必要的回溯与分支探索。 为此,微软亚洲研究院联合清华大学、香港科技大学提出PixelCraft:以高保真图像处理与非线性多智能体推理为两大支柱,系统性提升结构化图像理解的准确性、鲁棒性与可解释性,在多个图表与几何基准上给出一致的性能增益。

AI正悄悄宠坏你!斯坦福研究证实:AI正用谄媚降低我们修复人际关系的能力

斯坦福、卡内基梅隆大学的一项研究证实,AI可能正在用一种极其隐蔽的方式,让我们变得更固执,更不愿意修复重要的人际关系。 研究揭示了一个令人不安的真相:我们偏爱并信任的AI模型,恰恰是那些通过无条件肯定我们,从而损害我们亲社会行为的模型。 这形成了一个危险的闭环。

综述238篇遥感微调!清华院士团队指出9大方向 | CVMJ

近年来,在大数据与大模型的共同驱动下,遥感图像解译的热点正从模型结构设计转向「基础模型 微调」的新范式。 在丰富且复杂的任务场景中,依托预训练的通用表征作为基础,通过任务化适配,可以实现更强的迁移能力和应用效果。 面对土地调查、农业监测、天气预报、海洋导航等关键应用领域所面临的「小样本、长尾目标、算力受限」的现实挑战,微调技术以其独特的优势,在更低的数据和资源成本投入下,取得更好的任务性能和更高的部署效率。

突发!arXiv CS新规:未经同行评审,一律不收

arXiv重磅新规! 从现在起,arXiv中的CS板块,关于「综述/调研」和「立场」类的论文,全部经由同行评审后,才可以被收录。 也就是说,以后不带「同行评审通行证」,就别想上车!

锁定角色,「多主体」也可控!个性化文生图,给你PS般交互体验

大型扩散模型(如 Stable Diffusion)让我们能够从文字生成高保真的图像。 但当用户希望「生成我和我的朋友们在不同场景中的照片」时,现有的个性化生成方法(如 DreamBooth、IP-Adapter)仍面临两个根本问题:缺乏交互性:无法自由控制人物的空间位置、大小与关系。 难以扩展到多主体:每多一个人,内存和算力就线性增长。

AI首胜人类博士,顶会论文秒变代码!港大90后开源刷爆8k星

在AI领域,学术论文往往承载了算法、模型架构等方面的最前沿突破。 但想要真正理解论文的核心知识,并成功复现其中的算法和实验结果,却经常面临巨大挑战。 问题的主要症结,在于「关键实现细节」上的缺失!

谁杀死了那篇好论文?AI顶会乱象:好论文被刷,低分论文被捧上天

在AI顶会上当审稿人,本该是一份体面又严肃的工作。 但对这位AAAI 2026的评审来说,今年的经历却奇怪得离谱。 他在Reddit上写道:这是我见过最混乱的审稿流程。

断网后才发现脑子空空?132页论文实证:「脑腐」或成AI头号内伤

所有人都在加速拥抱AI,却几乎没人追问:它把我们的大脑变成什么? X用户Alex Prompter,刚啃完了一篇132页的研究,结论足以让任何创作者、营销人、创业者后背发凉。 独立研究人员、高级项目经理Rénald Gesnot,从认知、社会、伦理与哲学等多维视角审视AI如何重塑人的思维。

RAE的终极形态?北大&阿里提出UniLIP: 将CLIP拓展到重建、生成和编辑

本文作者来自北京大学和阿里通义万相实验室。 其中论文第一作者是汤昊,北京大学 2022 级博士生,发表多篇 NeurIPS, CVPR,ICCV 和 ECCV,目前主要关注统一的多模态理解和生成。 指导教授是王立威老师,北京大学智能学院教授,曾获 NeurIPS 2024 和 ICLR 2023 最佳论文奖。

硅谷今夜学中文!Cursor被曝「套壳」国产,AI顶级人才全是华人

如果你关注最近硅谷的AI圈子,你会发现最近出现一个神奇的现象。 当国内都在学英语看文献的时候,国外的AI圈子都说中文了! 简直是倒反天罡。

内存直降50%,token需求少56%!用视觉方式处理长文本

在处理短文本时,大语言模型(LLM)已经表现出惊人的理解和生成能力。 但现实世界中的许多任务——如长文档理解、复杂问答、检索增强生成(RAG)等——都需要模型处理成千上万甚至几十万长度的上下文。 与此同时,模型参数规模也从数十亿一路飙升至万亿级别。

Cursor“自研”模型套壳国产开源?网友:毕竟好用又便宜

美国顶流AI产品“套壳”中国开源大模型,这事儿上“热搜”了(doge)。 𝕏网友都在感叹:大家都认为中国大模型正在迎头赶上。 不,它们已经赶上了。

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

AI新词

大模型

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

英伟达

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

代码

AI for Science

苹果

腾讯

算法

Agent

Claude

芯片

Stable Diffusion

具身智能

xAI

蛋白质

开发者

人形机器人

生成式

神经网络

机器学习

AI视频

3D

RAG

大语言模型

字节跳动

Sora

百度

研究

GPU

生成

工具

华为

AGI

计算

AI设计

生成式AI

大型语言模型

搜索

视频生成

亚马逊

特斯拉

AI模型

DeepMind

场景

深度学习

Copilot

Transformer

架构

MCP

编程

视觉