多模态大模型(MLLM)在自然图像上已取得显著进展,但当问题落在图表、几何草图、科研绘图等结构化图像上时,细小的感知误差会迅速放大为推理偏差。

线性、刚性的“链式思考”流程也难以支撑复杂任务中必要的回溯与分支探索。

为此,微软亚洲研究院联合清华大学、香港科技大学提出PixelCraft:以高保真图像处理与非线性多智能体推理为两大支柱,系统性提升结构化图像理解的准确性、鲁棒性与可解释性,在多个图表与几何基准上给出一致的性能增益。

结构化图像的痛点与PixelCraft的切入

自然图像通常凭借纹理、局部模式等特征即可完成理解;而结构化图像把信息编码进坐标、数据点、连线与数值标注,要求模型在像素级细节上建立可验证的“符号化抽象”。

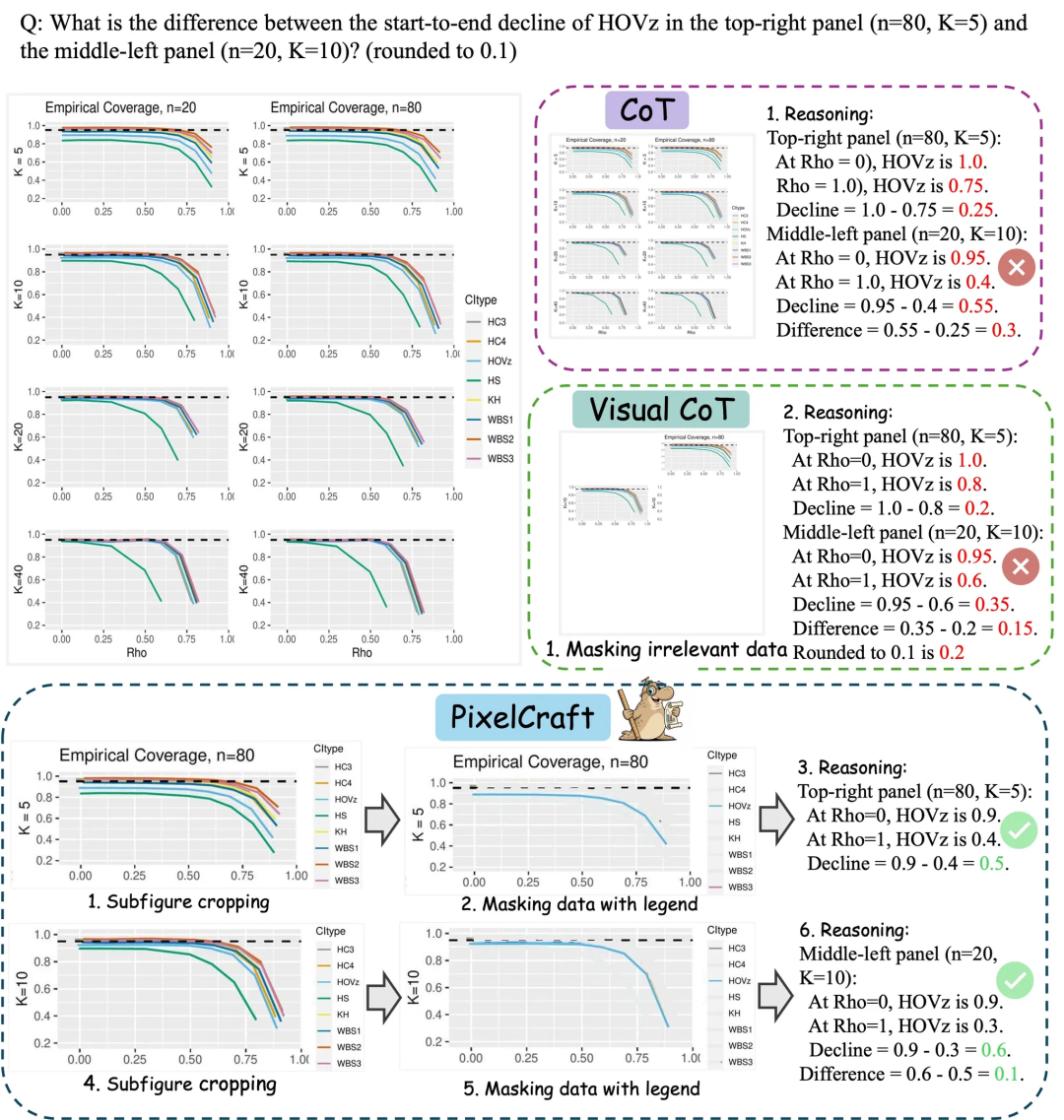

在这样的场景中,传统只依赖文字CoT的方式往往牺牲了空间与结构细节。

“视觉CoT”虽然尝试插入中间图像线索,但受制于低保真的图像处理和简单的线性处理链条,这类方法在应对复杂真实问题时效果有限,这一局限性也在CharXiv、ChartQAPro等更贴近真实场景的基准上得到体现。

PixelCraft将这一问题拆成两端:先把“看准”做扎实,再让“思考”更灵活。

从“聪明的眼睛”到“稳健的双手”,再到“讨论式思考”

- 系统组成:PixelCraft的系统由调度器(dispatcher)、规划器(planner)、推理器(reasoner)、视觉评审与规划评审(critics)以及一组视觉工具代理(toolagents)构成。调度器负责工具和角色的选择与编排;规划器维护图像记忆(imagememory)并管理讨论流程;推理器承担多模态推理;视觉与规划评审分别负责在环质量控制与事后复盘;视觉工具代理执行具体图像操作

- 高保真图像处理:微调后的grounding模型将目标区域的文本指代精准映射到像素级坐标区域,并以此为基础设计了一套半自动生成工具代码的流程。通过得到的视觉工具库将后续推理建立在可验证的中间证据之上。

- 三阶段工作流:围绕“工具选择→协作讨论与回溯→自我审查与再规划”展开。与将所有中间图一次性并入上下文不同,规划器利用图像记忆进行选择性回看与复用,以支持分支探索与回溯,并降低长上下文负担。

高保真视觉处理

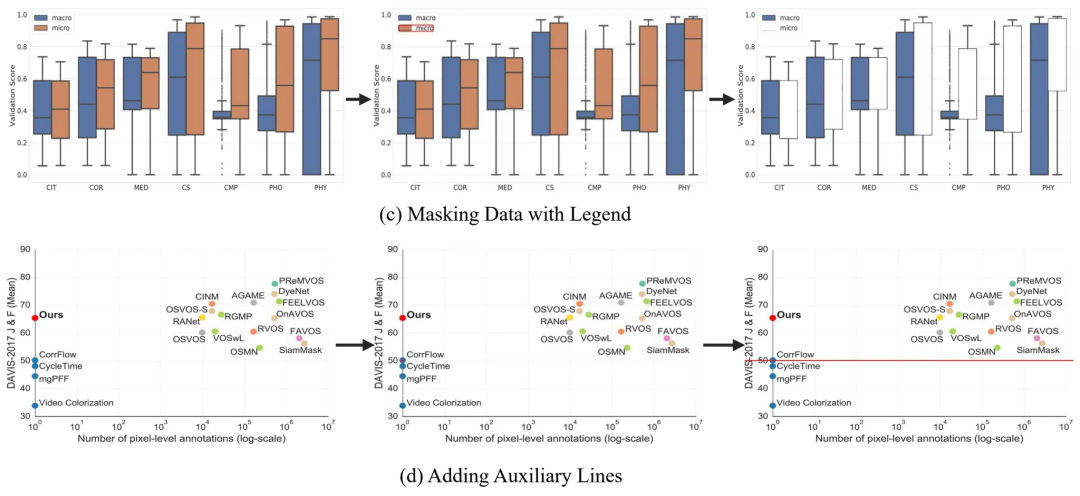

研究在高质量标注数据上对Qwen2.5-VL-3B-Instruct进行微调,得到像素级grounding模型,可以将目标区域的文本指代精准映射到像素级坐标区域。

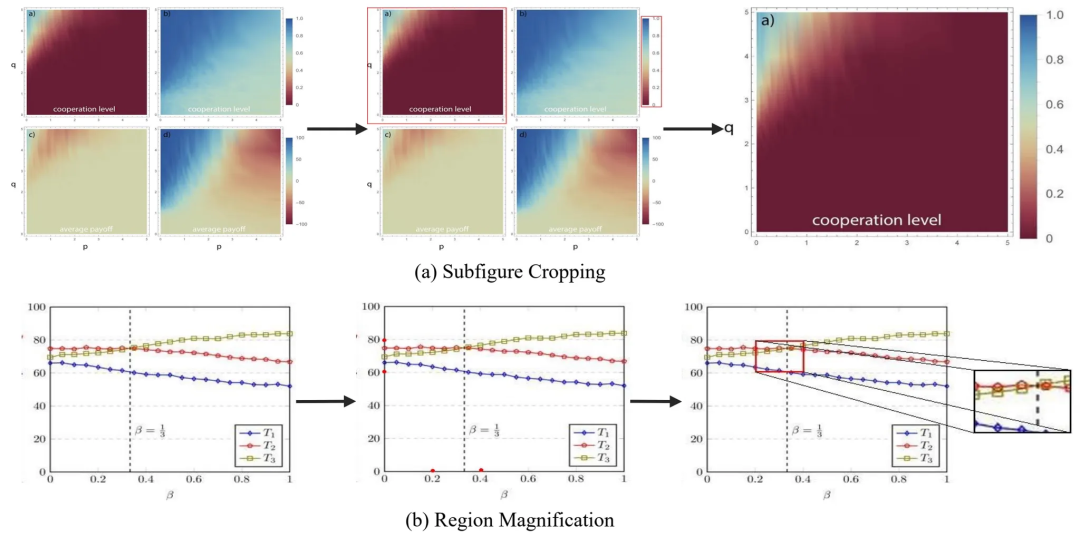

以此为锚,系统通过工具代理调用一组标准化的传统CV操作(如裁切、放大、按图例遮挡、辅助线标注等),使中间编辑步骤可验证、可复现,为后续推理提供稳定证据。

系统的工具并非静态预设,而是通过自动生成—标准化—调用的闭环形成:系统基于任务样本由大模型生成候选工具,经聚类与重写后作为工具库备用(一些具体的工具处理示例如下图所示)。

子图裁剪/局部放大

带图例的数据绘制/添加辅助线

随后结合grounding坐标与调度/规划策略,实现精确、可重复、可回溯的工具调用。

在讨论式推理中,工具按需被动态选择与复用,从而把“看准”(定位与编辑的准确性)与“能做”(可执行操作)有效衔接。

在合成与标注评测集上,微调后的grounding在子图区域、图例区域、文本标签与刻度点的IoU/PCK指标均较基础模型有显著提升。

保持智能体系统的基座模型不变,切换不同grounding模型会传导至下游基准(如CharXiv、ChartQAPro等)的最终精度,说明定位质量对整体性能具有关键影响。

由此,“高保真定位+工具闭环”有效减少了由“截错/标错”引起的误差传播。

非线性、多角色的“讨论式推理”

PixelCraft的讨论式流程由规划器统筹:先选择合适的工具与角色,随后规划器根据当前上下文按需选择下一角色及其输入(图像或文本),并角色间传递中间结果。

推理过程中由视觉评审判定图像处理是否满足目标,再由规划评审事后复盘整条链路,必要时触发再规划再推理。

与“只在上一张图上继续”的线性链不同,图像记忆让规划器能在讨论中主动回看早期证据、尝试备选分支、修订假设。

这一“discussion-centric workflow”在结构化图像场景中尤显必要:细节一旦出错,应尽快止损并回溯而不是被动前行。

实验:多基座、多数据集的一致增益

在三个具有挑战性的图表理解基准CharXiv/ChartQAPro/EvoChart上,PixelCraft在GPT-4o等大模型的基础上取得大幅提升,且跨模型表现一致。

消融实验显示,可靠的图像编辑+在环校验+事后复盘共同支撑了系统的稳定性与可解释。

研究还构造了和常规VisualCoT的对照:把历史中间图像全部并入上下文、让模型在线性链里“带图思考”。

结果显示,在CharXiv与ChartQAPro上,简单的VisualCoT结果明显低于PixelCraft的范式。

这从正反两面印证:不是“把图都塞进去”就能解决问题,选择性记忆+讨论式回溯才是更有效的组织方式。

工具层面,图表类的子图裁切、局部放大、辅助线标注、按图例遮挡覆盖了大多数分析操作。

几何类的点连线、作垂线/平行线为推理提供“草图级”证据。论文给出了工具使用频率与单项贡献的统计,也展示了多种具体处理案例。

PixelCraft提出了一条面向结构化图像的半自动化新范式:包含工具制造,工具选择,工具调用,过程修改。

先以像素级grounding把证据找准,再把证据交给“工具化的双手”去做可验证的编辑,最后在规划器主导的讨论式流程中组织推理,并用图像记忆贯穿回溯与分支探索。

通过这一整套设计,系统在多个benchmark上取得跨模型一致的提升,且中间过程清晰可检。

对需要在图表、几何等结构化图像而言,PixelCraft显著提升了模型推理的准确性和鲁棒性。

论文链接:https://arxiv.org/pdf/2509.25185