AI Agent 是当前的一个热门话题,但并非所有 AI 系统都需要采用这种架构。

虽然 Agent 具有自主决策能力,但更简单、更具成本效益的解决方案往往更适合实际业务场景。关键在于根据具体需求选择恰当的架构方案。

本文将探讨大语言模型(LLMs)的最新进展,并解析 AI 系统的核心设计理念。

我们实践过从不包含示例的提示词技术(zero-shot prompting)到思维链推理,从基于 RAG 的架构到复杂工作流及 autonomous agents 等不同复杂度的 LLM 项目。

这个新兴领域的术语体系仍在演进,不同概念之间的边界尚未界定,分类标准仍不固定。随着该领域的发展,新的框架和工程实践不断涌现,推动构建更可靠的 AI 系统。

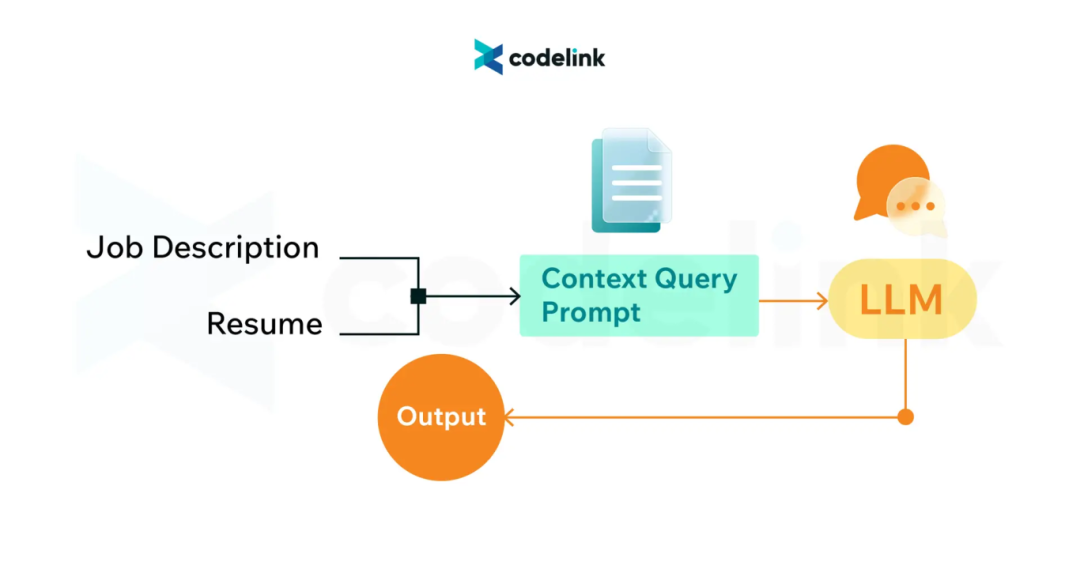

为直观展示不同系统的差异,我们将通过简历筛选这个典型案例,揭示不同架构层级在能力和系统复杂度上的非线性跃升。

1.纯 LLM 架构

纯 LLM 本质上是互联网信息的有损压缩包,是从其训练数据中提取的知识快照。它尤其擅长处理依赖其参数化知识(即训练阶段内化的信息)的任务,典型场景包括:总结小说内容、撰写关于全球变暖的论述、用 5 岁儿童能理解的语言解释狭义相对论、或者创作俳句(译者注:日本有一种特定格式的诗歌,叫做“俳(pái)句”,在形式上堪称世界文学中最短的格律诗。)。

但若没有额外的功能扩展,LLM 无法提供实时信息(例如纽约的当前气温)。这正是纯 LLM 与 ChatGPT 等对话式应用的区别 —— 后者通过实时搜索和其他工具增强了核心 LLM 的能力。

不过,并非所有功能增强都需要外部上下文。通过提示词工程(如上下文学习、小样本学习等技术),LLM 无需检索外部信息也能处理特定问题。

应用示例:

只需采用使用单个示例的提示词技术(one-shot prompting)结合上下文学习,就能让 LLM 根据职位描述对简历进行「通过/不通过」的二分类判断。

image.png

image.png

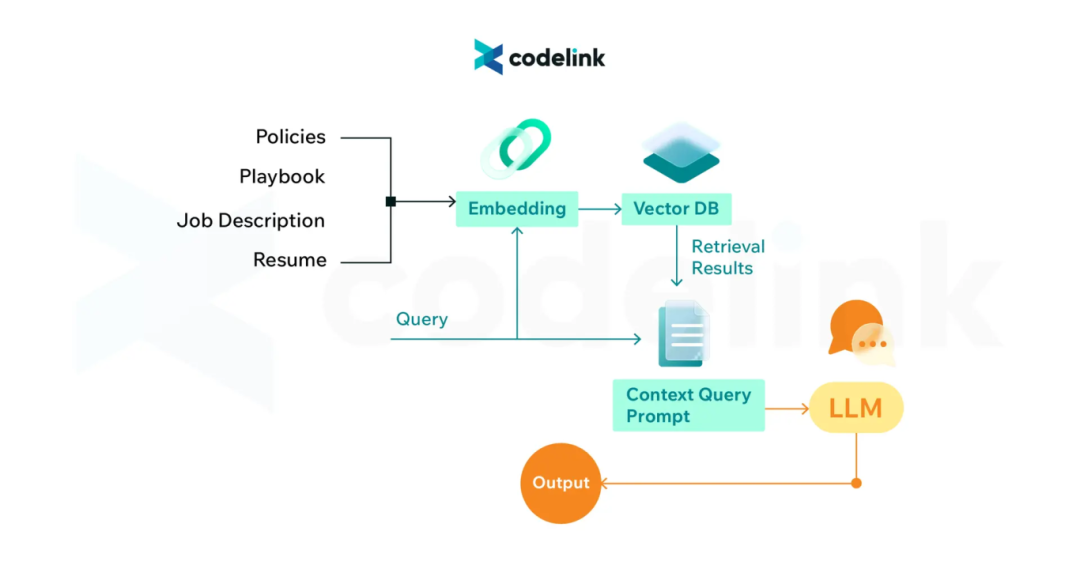

2.RAG(检索增强生成)

检索方法通过提供相关上下文来增强 LLM 的能力,使其输出更具时效性、精确性和实用性。借助这一技术,可以让 LLM 访问并处理内部数据。这些上下文信息使 LLM 能够提取信息、生成摘要并生成响应。RAG 还能通过实时数据检索获取最新信息。

应用示例:

在简历筛选场景中,通过检索公司的内部数据(如工程操作手册、招聘政策及历史简历资料)来丰富上下文信息,从而做出更准确的分类判断。

检索过程通常需要借助向量化工具、向量数据库和语义搜索等技术实现。

image.png

image.png

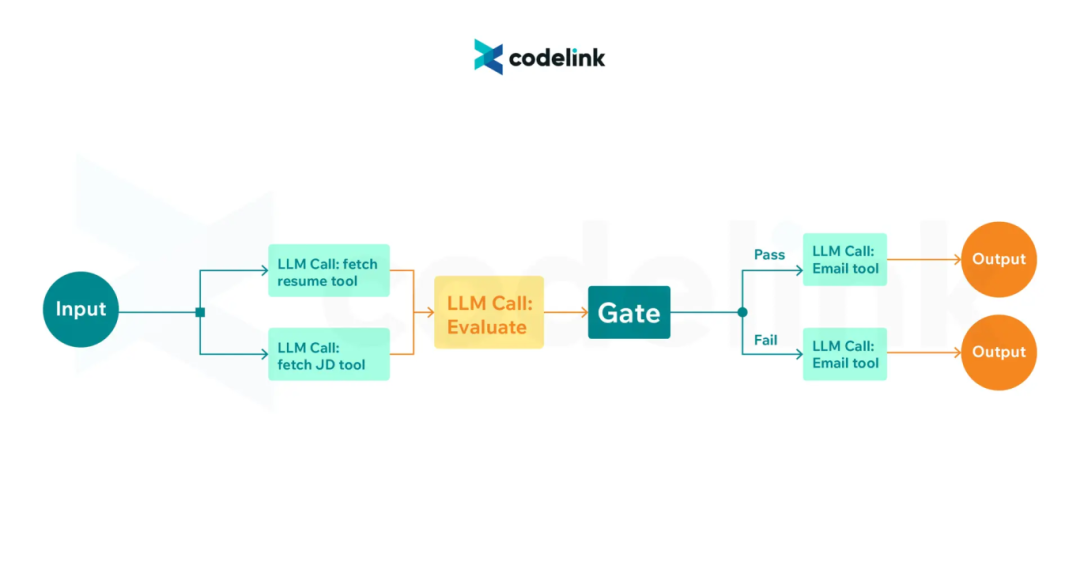

3.工具调用(Tool Use)与 AI 工作流(AI Workflow)

LLM 能够通过定义明确的路径实现业务流程自动化,这类系统最适合处理结构清晰、标准统一的任务。

通过使用工具调用(Tool use)可以实现工作流自动化。通过对接各类 API(包括计算器、日历、邮件服务或搜索引擎等),LLM 可以利用可靠的外部工具,而非依赖其存在非确定性的原生能力。

应用示例:

这个 AI 工作流可以连接招聘门户获取简历和职位描述 → 根据经验、学历和技能评估投递简历者的资质 → 发送相应的邮件回复(拒信或面试邀请)。

要实现这个简历筛选工作流,LLM 需要访问数据库、邮件 API 和日历 API,并按照预设步骤以编程方式实现全流程自动化。

image.png

image.png

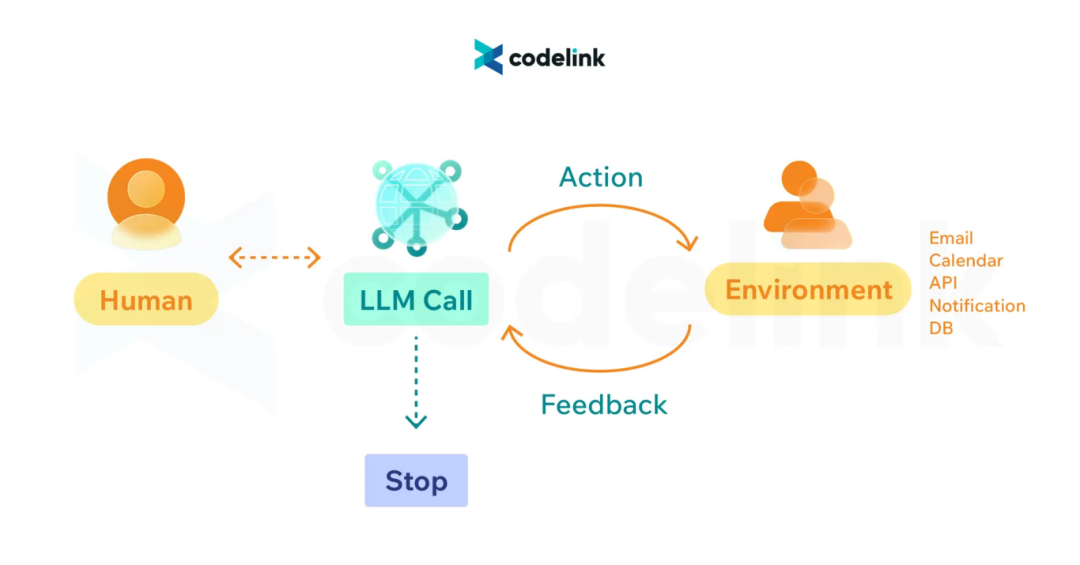

4.AI Agent

AI Agent 是具备自主推理能力和决策能力的系统。它们能够:将任务分解为多个步骤、根据需要调用外部工具、评估执行结果、并自主决定后续动作(存储执行结果/请求人工干预/继续执行下一步)。

这代表着在工具调用和 AI 工作流之上的又一层抽象,实现了规划和决策的自动化。

与 AI 工作流需要明确的用户触发器(如按钮点击)且必须遵循预设路径不同,AI Agent 可以自主启动工作流,并动态决定各环节的执行顺序和组合方式。

应用示例:

AI Agent 可以管理完整的招聘流程,包括:解析简历、通过聊天或邮件协调面试时间、安排面试会议、以及处理日程变更等。

这项综合性任务要求 LLM 具备以下访问权限:数据库、邮件和日历 API,以及聊天和通知系统。

image.png

image.png

5.核心要点

1)并非所有系统都需要 AI Agent

应从简单、可组合的模式入手,按需逐步增加复杂度。某些场景仅需检索功能即可满足需求。以简历筛选为例,当筛选标准和后续操作明确时,基础工作流就能胜任。仅当需要更大的自主性以减少人工干预时,才应考虑采用 Agent 方案。

2)注重可靠性而非丰富的功能

LLM 的非确定性特质使得构建可靠系统颇具挑战。虽然快速验证概念(proofs of concept)可行,但将其扩展到生产环境时往往暴露各种问题。建议从沙盒环境起步,实施统一的测试方法,并通过防护机制确保系统可靠性。

原文链接:https://www.codelink.io/blog/post/ai-system-development-llm-rag-ai-workflow-agent