理论

人工智能触手可及:盘点十个你不能错过的国内免费AI平台

AI浪潮席卷全球,国内的科技巨头和创新企业也纷纷推出了功能强大且对用户友好的AI平台。 这些工具不再是少数技术专家的“玩具”,而是普通人也能轻松上手,提升学习、工作和创作效率的强大助手。 本文为你精选了10个国内优秀的免费AI网页平台,它们涵盖了从智能对话、写作辅助到艺术创作等多个领域。

8/1/2025 8:55:34 AM

用户007

TypeScript开发AI应用,正成为越来越多人的选择

AI技术正在快速发展,越来越多的开发者开始构建基于大语言模型(LLM)、多智能体协作、浏览器端直接推理的新应用。 在这个趋势下,TypeScript 凭借其优秀的类型检查、完善的工具支持和活跃的社区,正在成为开发这些现代AI应用的重要工具。 数据印证趋势:Y Combinator 2023年W23批次统计:约60%-70%专注于AI代理(Agent)的初创公司选择TypeScript作为主要开发语言。

8/1/2025 6:36:49 AM

web前端开发

一日一技:牛指挥马,Cursor驾驶Claude Code起飞

我日常使用的开发工具是Cursor。 虽然用得非常顺手,但天天有人在我耳边说,Claude Code代码能力吊打Cursor,Claude Code可以完全替代Cursor之类的言论,于是我安装上Claude Code试了一试。 整体来说Claude Code写代码的能力确实还行,但这个东西毕竟是命令行工具,用起来非常不方便。

8/1/2025 4:11:00 AM

kingname

测试不同的RAG技术以找到最佳方案

检索增强生成(RAG)技术通过结合大型语言模型(LLMs)与外部数据检索能力,能够提供准确且富含上下文的答案。 无论是构建客户支持聊天机器人还是研究助手,RAG都能通过从数据库中提取相关信息来增强AI的性能。 然而,不同的RAG技术在性能上存在差异,选择最佳技术需要进行测试。

8/1/2025 3:20:00 AM

大模型之路

深度解析AI Agent:从概念、原理到构建模式,一文彻底搞懂!

随着大模型技术的飞速发展,一个重要的概念——Agent(也叫AI Agent)——应运而生,并迅速成为行业热点。 尽管这个词汇现在被频繁提及,但它究竟是什么? 它是如何运作的?

8/1/2025 2:43:00 AM

李木子

一小时内构建基于Gemma与Bright Data的生产级RAG应用

在人工智能快速发展的当下,大语言模型(LLM)的应用日益广泛,但模型幻觉、知识时效性差等问题始终困扰着开发者。 检索增强生成(RAG)技术的出现为解决这些问题提供了有效方案,它能让模型基于真实数据生成可靠回答。 本文将详细介绍如何在一小时内,利用Gemma 3开源模型和Bright Data的SERP API构建一个生产级RAG应用,无需依赖昂贵的商业服务,全程本地运行。

8/1/2025 2:11:00 AM

大模型之路

RAG应用如何进行有效的文本切分

在RAG(检索增强生成,Retrieval-Augmented Generation)应用中,文本分块(Text Chunking)是连接“知识存储”与“检索-生成”的核心预处理步骤,其重要性体现在对检索效率、相关性、生成质量及系统灵活性的多维度影响。 首先松哥和大家讨论第一个问题,就是为什么我们要重视文本切分。 一、为什么文本切分很重要1.1 提升检索相关性:精准匹配用户需求RAG 的核心是“先检索、后生成”,而检索的本质是从知识库中找到与用户查询语义最相关的信息。

8/1/2025 1:55:00 AM

江南一点雨

解构GoldMine OS:AI Agent如何破解RWA“不可能三角”

大家好,我是肆〇柒,随着《香港稳定币法案》从提出到8月1日即将生效,合规稳定币的发行与交易框架首次在香港获得法律背书,这不仅为传统资产上链提供了清晰的监管路径,也让“链上数字货币的规模化合规交易”从概念走向现实。 在这一里程碑事件的背后,市场目光重新聚焦于RWA(Real-World Asset)代币化——如何让黄金、债券、房产等传统资产在区块链世界中焕发新生? GoldMine OS给出了一个惊艳答案。

8/1/2025 1:00:00 AM

肆零柒

OpenAI的“阳谋”:ChatGPT不想再当你枪手了

在AI圈里混久了,我们都心照不宣一个事实:ChatGPT,这个星球上最强大的语言模型,在无数个深夜里,成了学生们最“贴心”的作业枪手和答案搬运工。 OpenAI对此当然心知肚明,与其被动地陷入“作弊与反作弊”的猫鼠游戏,他们选择掀翻桌子,直接重新定义游戏规则。 于是,ChatGPT Study Mode 登场了。

7/31/2025 4:07:01 PM

墨风如雪

全网疯传GPT-5泄露!首次统一GPT和o系列,编程实测demo抢先曝光,下周发布?

GPT-5这回是真的要来了。 现在,全网都在“偶遇”GPT-5。 不仅是ChatGPT上有踪迹:图片而且在MacOS应用的模型列表中也发现了GPT-5。

7/31/2025 4:04:23 PM

全球最快编辑器!开源大神新作:零延迟,可彻底关闭AI;创始人揭秘打造细节!众大佬惊呆:回到极致编程!又有Cursor+VS现代感

编辑 | 云昭出品 | 51CTO技术栈(微信号:blog51cto)在这个 “不接 AI 就显得落伍” 的开发工具时代,一款非常编辑器悄悄走红了它不仅号称自己是“全球最快”的硬核 Vibe Coding 工具,性能惊艳一众开源大佬、创业公司大神、编辑体验丝滑得像本地记事本,还大胆地在官网写了一句醒目的标语——“你可以完全关闭 AI。 ”图片没错,这款编辑器叫 Zed,出自 Atom 编辑器原作者 Nathan Sobo 之手。 2018-2019 年期间,当 Nathan Sobo 着手打造 Zed 项目时,他的目标很简单但野心十足:让它既快又好用。

7/31/2025 3:53:27 PM

云昭

地球版ChatGPT爆诞!谷歌AI 64维压缩人类星球,10米级「上帝视角」秒开

刚刚,Alpha家族又上新了! 这一次,谷歌DeepMind帮人类打开了「上帝视角」——全新AlphaEarth Foundations正以惊人的细节绘制出整个地球。 图片它集成了PB级地球观测数据,可生成统一的数据表示。

7/31/2025 2:07:58 PM

面试Meta可以用AI了!倒向闭源后内部再发公告:AI Coding全面融入编程面试,紧急招募员工试水新题库!网友:小扎真急了

出品 | 51CTO技术栈(微信号:blog51cto)打不过就加入! 面对屡禁不止的 AI 面试作弊,Meta 给出了一个堪称一劳永逸的方案:干脆主动放开,允许候选人在编程面试中使用 AI 助手作答。 听上去像个段子?

7/31/2025 1:45:13 PM

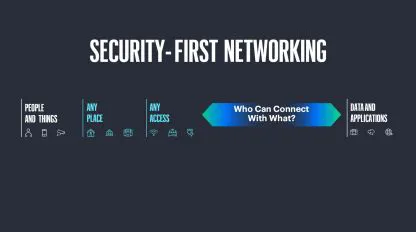

以AI与安全为双翼:HPE Aruba Networking重塑企业网络新范式

在前不久HPE于拉斯维加斯举办的全球Discover大会上,HPE Aruba Networking展示了一系列以 “AI赋能的安全融合网络” 为核心的新技术产品。 究其原因,目前随着AI的快速迭代和演进,一方面,大部分企业通过AI反哺业务增长,但另一方面,这也使企业的网络安全问题越来越棘手。 也就是说,HPE Aruba Networking的技术迭代和产品更新很大程度上是因“企业需求”而生,并因“企业需求”而变。

7/31/2025 11:59:22 AM

GenAI Processors:构建未来的实时AI应用程序

译者 | 布加迪审校 | 重楼想象一下,一个AI应用程序可以处理你的语音、分析摄像头视频,并进行如同人类的实时对话。 就在不久前,为了创建这样一个技术密集型的多模态应用程序,工程师们还在努力应对复杂的异步操作、处理多个API调用以及拼凑代码,后来证明这些代码难以维护或调试。 GenAI Processors应运而生。

7/31/2025 11:10:07 AM

布加迪

合成身份+AI双杀,下一个十亿美元的网络犯罪风口

译者 | 陈峻审校 | 重楼2025年已过半,在线身份欺诈的行为已经从原始的信用卡号盗用和文件伪造,演变成为更具欺骗性的方式--合成身份欺诈(Synthetic identity fraud),即:由人工智能(AI)生成的角色来盗用和冒用你的身份,模仿你的语音与表达习惯,甚至深度融入你的数字生活,创造出令人信服的数字分身。 这些数字幽灵已经成为我们从未预料到的最大威胁之一。 数字幽灵的剖析传统的身份盗窃需要窃取的真实信息包括:社会安全号码、信用报告、驾照照片等。

7/31/2025 10:54:27 AM

陈峻

把指纹焊死在频率上:抗微调神经网络指纹的硬核方案来了

论文第一作者唐灵,张拳石老师课题组的博二学生。 今天要聊的是个硬核技术 —— 如何给神经网络刻上抹不掉的 "身份证"。 现在大模型抄袭纠纷不断,这事儿特别应景。

7/31/2025 9:42:57 AM

刚刚,扎克伯克公开信:Meta不会开源全部模型

Meta 联合创始人兼首席执行官马克・扎克伯格从 OpenAI、谷歌和苹果等公司挖走了众多顶尖 AI 研究人员,并开出了数亿美元的薪酬,此举震惊了整个科技行业。 现在,他正在更多地分享他对超级智能的愿景。 在 Meta 财报电话会议召开前几个小时,扎克伯格一封公开信广为传播。

7/31/2025 9:31:52 AM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

Gemini

马斯克

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

特斯拉

场景

AI模型

深度学习

亚马逊

架构

Transformer

MCP

编程

Copilot

视觉