论文第一作者唐灵,张拳石老师课题组的博二学生。

今天要聊的是个硬核技术 —— 如何给神经网络刻上抹不掉的 "身份证"。现在大模型抄袭纠纷不断,这事儿特别应景。

所谓神经网络指纹技术,是指使用神经网络内部如同人类指纹一样的特异性信息作为身份标识,用于判断模型的所有权和来源。传统方法都在玩 "贴标签":往模型里塞各种人造指纹。但问题是,模型微调(fine-tuning)就像给整容 —— 参数一动,"整张脸" 就变了,指纹自然就糊了。

面对神经网络微调训练的威胁,现有方案都在修修补补,而我们上升到理论层面重新思考:神经网络是否先天存在某种对微调鲁棒的特征?如果存在,并将该固有特征作为网络指纹,那么无论对模型参数如何微调,该指纹就能始终保持不变。在这一视角下,前人的探索较为有限,没有从理论上证明出神经网络内部对微调天然鲁棒的特征。

- 论文地址:https://arxiv.org/pdf/2505.01007

- 论文标题:Towards the Resistance of Neural Network Watermarking to Fine-tuning

方法介绍

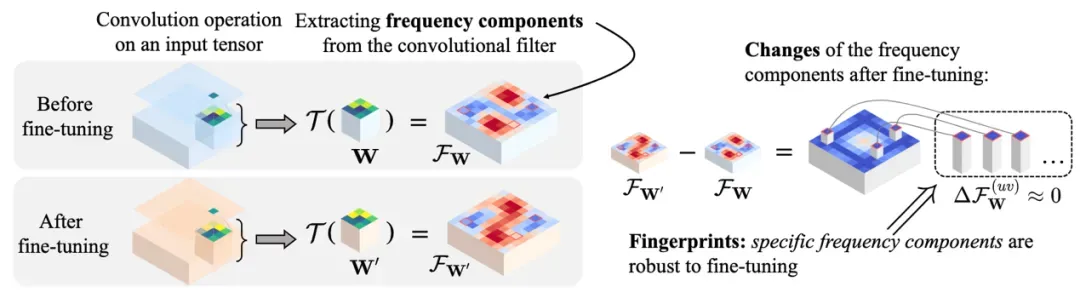

这里我们发现了一个颠覆性事实:卷积核的某些频率成分根本不怕微调。就像给声波做 DNA 检测,我们把模型参数转换到频率域,找到了那些 "焊死" 在频谱上的特征点 —— 我们拓展了离散傅里叶变换,从而定义了神经网络一个卷积核所对应的频谱,并进一步证明:当输入特征仅包含低频成分时,卷积核的某些特定频率成分在微调过程中能够保持稳定。

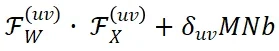

理论框架。我们证明,通过对卷积核 W 进行拓展后的离散傅里叶变换  (不是传统的傅里叶变换)所获得的特定频率成分

(不是传统的傅里叶变换)所获得的特定频率成分 ,在训练过程中保持稳定。因此,我们使用这些特定的频率成分作为对于微调鲁棒的神经网络指纹。

,在训练过程中保持稳定。因此,我们使用这些特定的频率成分作为对于微调鲁棒的神经网络指纹。

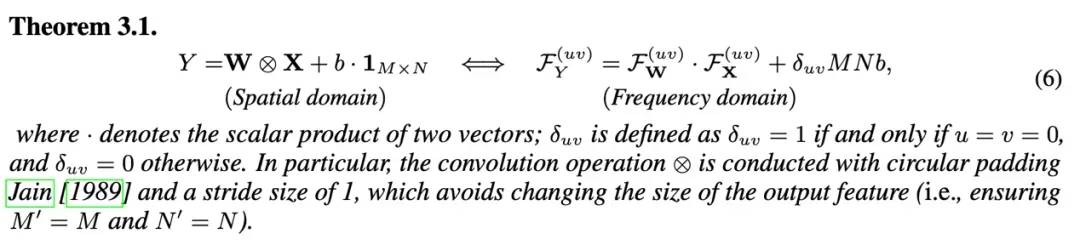

首先,我们发现神经网络时域上的前向传播过程可以写为频域当中的向量乘法。具体而言,给定一个卷积核 W 和偏置项 b,以及对应的输入特征 X,我们通过对卷积核进行扩展的离散傅里叶变换得到频率成分  ,同时对输入特征进行离散傅里叶变换得到频域成分

,同时对输入特征进行离散傅里叶变换得到频域成分 ,其中不同的

,其中不同的  代表不同的频率点。可以证明,空间域中的卷积操作

代表不同的频率点。可以证明,空间域中的卷积操作  严格等价于在频率域中各频率成分之间的向量点积

严格等价于在频率域中各频率成分之间的向量点积 。

。

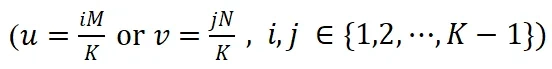

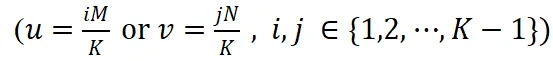

在此基础上,我们进一步证明了当输入特征 X 仅包含基频成分时(除了基频成分  外,其他频率成分

外,其他频率成分  取值为 0),并且频率坐标取值连续的理想情况下,卷积核频谱中特定频率

取值为 0),并且频率坐标取值连续的理想情况下,卷积核频谱中特定频率  上频率成分

上频率成分  在微调过程中能够严格保持不变。其中,M 和 N 为特征图长和宽,K 为卷积核大小。

在微调过程中能够严格保持不变。其中,M 和 N 为特征图长和宽,K 为卷积核大小。

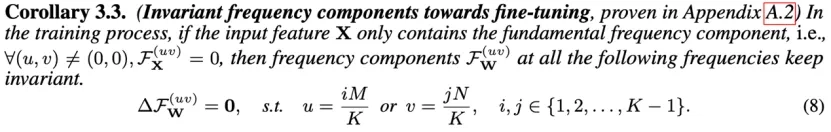

然后,我们将上述理论推广到实际场景中,这时输入特征 X 通常包含低频成分,且频率坐标必须为整数。在这样的条件下,前述特定频率坐标 取整后的频率位置处的卷积核频率成分

取整后的频率位置处的卷积核频率成分  在微调过程中变化极小,近似为零,从而表现出较高的稳定性。

在微调过程中变化极小,近似为零,从而表现出较高的稳定性。

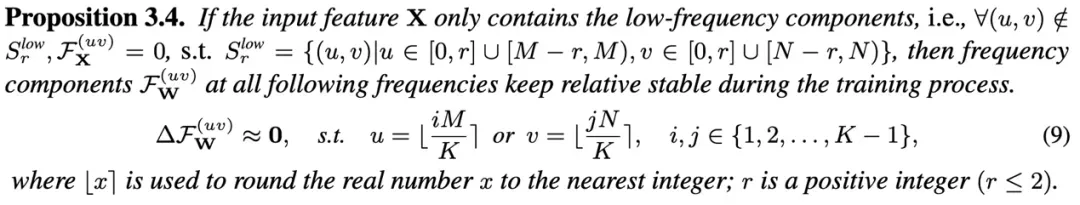

(a) 图中展示了卷积核 W 单个通道的频谱特征,(b) 图展示了卷积核频谱中特定频率坐标上的频率成分

(a) 图中展示了卷积核 W 单个通道的频谱特征,(b) 图展示了卷积核频谱中特定频率坐标上的频率成分  在微调过程中表现出良好的稳定性。

在微调过程中表现出良好的稳定性。

因此,我们使用这些特定频率成分  作为具备理论保障的对于微调鲁棒的神经网络指纹。

作为具备理论保障的对于微调鲁棒的神经网络指纹。

实验

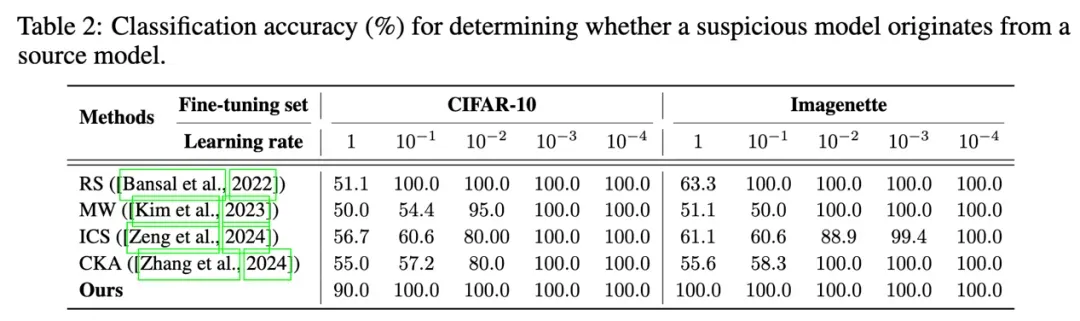

最后,我们开展了一系列实验,以评估所提出神经网络指纹方法对微调操作的鲁棒性。实验结果表明,相较于现有主流的模型指纹与模型溯源方法,在所有数据集和微调使用的学习率设置下,我们的方法在模型溯源任务中均取得了最优表现,尤其在高学习率条件下展现出显著优势。