模型

从手机到手语翻译,Gemma模型家族全面升级亮相Google I/O

在2025年Google I/O开发者大会上,谷歌正式发布轻量级多模态模型Gemma3n,并宣布Gemma模型家族持续扩展,新增面向医疗和无障碍场景的MedGemma与SignGemma。 作为本地运行AI趋势的代表,Gemma3n专为手机、笔记本和平板等低算力设备设计,具备处理文本、音频、图像和视频的能力。 据谷歌介绍,Gemma3n甚至可在低于2GB运行内存的设备上流畅运行,体现出其高效架构优势。

史上最强AI全家桶!谷歌Gemini 2.5双杀OpenAI,上架250美金天价VIP

谷歌又双叒叕搞事情啦! 昨天,谷歌推出了一款超强的编程智能体Jules,已进入全球测试阶段。 任何拥有Google账户的开发者都可以使用,提供每日5次免费任务。

谷歌年度大招:所有AI模型全升级一遍!Gemini2.5大杯中杯霸榜前二,新版视频/图像模型亮相

原生多模态输入输出、智能体、联网搜索……所有前沿AI能力集成在一起会怎么样? 谷歌最新版Project Astra展示了终极AI助手的能力:以下视频来源于谷歌黑板报实时观察周围环境,搜索资料指导小哥修自行车,零件不够还能自动电话询问周边商店有没有货。 在最新的I/O大会上,谷歌连续放大招,就好像大招不要钱。

CoT推理大溃败?哈佛华人揭秘:LLM一思考,立刻就「失智」

DeepSeek-R1火了,推理模型火了,思维链(Chain-of-Thought,CoT)火了! 模型很聪明,问题是:它还听你的话吗? 思维链很好,但代价呢?

ICRA 2025|通用多机器人长时任务规划框架破解任务分配难题,成功率+105%、效率+36%

2025 年 5 月,美国加州大学河滨分校 (UC Riverside) 与宾夕法尼亚州立大学 (Penn State University) 联合团队在机器人领域顶级会议 ICRA 2025 上发布最新研究成果 LaMMA-P(Generalizable Multi-Agent Long-Horizon Task Allocation and Planning with LM-Driven PDDL Planner)。 LaMMA-P 首次将大型语言模型与 PDDL 规划器深度融合,解决了异构多机器人系统中长时任务的自动分解与分配难题,大幅提升多机器人协同规划的智能水平。 该技术在全新基准数据集上经过大量模拟实验验证,相比现有最先进方法 SMART-LLM,任务成功率提高 105%,执行效率提升 36%,在复杂长程任务规划上取得了突破性进展,为异构多机器人协同完成复杂任务提供了全新解决方案。

ICML 2025 Spotlight | 多模态大模型暴露短板?EMMA基准深度揭秘多模态推理能力

「三个点电荷 Q、-2Q 和 3Q 等距放置,哪个向量最能描述作用在 Q 电荷上的净电力方向? 」在解这道题时,我们可以通过绘制受力分析草图轻松解决。 但即使是先进的多模态大语言模型,如 GPT-4o,也可能在理解「同性相斥」的基本物理原则时,错误地判断斥力的方向(例如,错误地将 3Q 对 Q 的斥力方向判断为右下方而非正确的左上方)。

代码、多模态检索全面登顶SOTA!智源BGE向量模型三连击,并全面开放

检索增强技术在代码及多模态场景中的发挥着重要作用,而向量模型是检索增强体系中的重要组成部分。 针对这一需求,近日,智源研究院联合多所高校研发了三款向量模型,包括代码向量模型 BGE-Code-v1,多模态向量模型 BGE-VL-v1.5 以及视觉化文档向量模型 BGE-VL-Screenshot。 这些模型取得了代码及多模态检索的最佳效果,并以较大优势登顶 CoIR、Code-RAG、MMEB、MVRB 等领域内主要测试基准。

英伟达推出人形机器人新模型,助力工业革命新篇章

英伟达首席执行官黄仁勋宣布推出最新的人形机器人基础模型 ——Isaac GR00T N1.5。 此次发布标志着英伟达在机器人开发基础设施上迈出了重要的一步,黄仁勋表示,这一模型将成为 “下一代工业革命的核心构建模块”。 GR00T N1.5模型的一个显著优势是其训练效率的显著提升。

谷歌 DeepMind 通过强化学习微调提升 AI 决策能力

近期,谷歌 DeepMind 团队与约翰・开普勒林茨大学 LIT AI 实验室合作,开展了一项关于人工智能语言模型的新研究。 他们采用了强化学习微调(RLFT)技术,旨在提升语言模型的决策能力。 这项研究的重点在于,通过思维链的强化训练,解决了模型在决策过程中存在的一些关键问题。

手机流畅处理128K长文本,vivo端侧新算法突破内存限制 | ACL 2025

在端侧设备上处理长文本常常面临计算和内存瓶颈。 vivo AI研究院推出的EdgeInfinite算法专为端侧设备设计,让设备处理超长文本时更加高效流畅,该方法能够在不到10GB GPU内存的设备上处理长达128K tokens的输入。 该研究成果已中稿ACL 2025。

多模态检索大升级!智源三大SOTA模型,代码、图文理解能力拉满

检索增强技术在代码及多模态场景中的发挥着重要作用,而向量模型是检索增强体系中的重要组成部分。 针对这一需求,近日,智源研究院联合多所高校研发了三款向量模型,包括代码向量模型BGE-Code-v1,多模态向量模型BGE-VL-v1.5以及视觉化文档向量模型BGE-VL-Screenshot。 这些模型取得了代码及多模态检索的最佳效果,并以较大优势登顶CoIR、Code-RAG、MMEB、MVRB等领域内主要测试基准。

全新音频问答模型 Omni-R1:利用文本驱动的强化学习和自动生成的数据推进音频问答

最近,一项来自 MIT CSAIL、哥廷根大学、IBM 研究所等机构的研究团队提出了一个名为 Omni-R1的全新音频问答模型。 该模型在 Qwen2.5-Omni 的基础上,通过一种名为 GRPO(Group Relative Policy Optimization)的强化学习方法进行优化,显示出在音频问答任务中的出色表现。 Omni-R1在著名的 MMAU 基准测试中创造了新的最先进成绩,涵盖了声音、语音和音乐等多个音频类别。

字节提出从单一主题发展到多主题定制的通用框架UNO,通过情境生成释放更多可控性

字节跳动的智能创作团队提出了一个从单一主题发展到多主题定制的通用框架UNO,从少到多的泛化:通过情境生成释放更多可控性。 能够将不同的任务统一在一个模型下。 在单主题和多主题驱动的生成中都能实现高度一致性,同时确保可控性。

谢赛宁团队提出BLIP3-o:融合自回归与扩散模型的统一多模态架构,开创CLIP特征驱动的图像理解与生成新范式!

BLIP3-o 是一个统一的多模态模型,它将自回归模型的推理和指令遵循优势与扩散模型的生成能力相结合。 与之前扩散 VAE 特征或原始像素的研究不同,BLIP3-o 扩散了语义丰富的CLIP 图像特征,从而为图像理解和生成构建了强大而高效的架构。 此外还发布了包含 2000 万张带详细标题的图片(BLIP3o Pretrain Long Caption)和 400 万张带短标题的图片(BLIP3o Pretrain Short Caption)的数据集。

震撼全网,AlphaEvolve矩阵乘法突破被证明为真!开发者用代码证实

就在刚刚,有人用Claude写代码证实——谷歌DeepMind的AlphaEvolve求解矩阵乘法的突破,100%正确! 即使已经过去好几天,AI圈依然有许多人沉浸在这个AI的余震中。 在时隔半个世纪(56年)后,AlphaEvolve将4×4的复数矩阵计算次数,从1969年Strassen的49次减少到了48次。

英伟达新“桌面超算”800GB大内存,满血DeepSeek R1能装1个半

英伟达官宣新办公室落户中国台湾省台北市,但居然是从太空飞下来的吗? 当然,这只是黄仁勋在Computex大会上展示的CG特效,但背后还有这样一层意思:如此逼真的画面中,只有1/10的像素是显卡渲染的,剩下全部内容为AI预测。 当初是GeForce显卡让AI成为现实,现在AI反过来给GeForce显卡带来颠覆性变革。

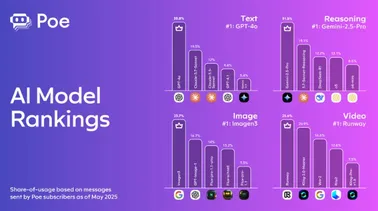

Poe2025春季AI模型使用趋势报告:OpenAI与Anthropic双雄争霸 可灵异军突起

全球知名AI模型集成平台Poe发布《2025春季AI模型使用趋势报告》,基于平台上数百万次用户交互,深入分析了文本、图像、视频、音频和推理模型的需求与使用份额变化。 报告揭示了今年以来OpenAI GPT-4.1、Google Gemini2.5Pro、Kuaishou Kling等突破性模型的快速崛起,以及AI使用模式的深刻转变。 AIbase综合最新动态,独家解读这一报告的核心亮点及其对AI生态的深远影响。

AI生成视频总不符合物理规律?匹兹堡大学团队新作PhyT2V:不重训练模型也能让物理真实度狂飙2.3倍!

本文由匹兹堡大学智能系统实验室(Intelligent Systems Laboratory)的研究团队完成。 第一作者为匹兹堡大学的一年级博士生薛琪耀。 当前文本生成视频(T2V)技术正在从注重视觉质量与模型规模的扩展阶段,迈向更关注物理一致性与现实合理性的推理驱动阶段。

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI新词

AI绘画

大模型

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

英伟达

Gemini

智能体

技术

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

AI for Science

代码

腾讯

苹果

算法

Agent

Claude

芯片

具身智能

Stable Diffusion

xAI

蛋白质

人形机器人

开发者

生成式

神经网络

机器学习

AI视频

3D

字节跳动

大语言模型

RAG

Sora

百度

研究

GPU

生成

华为

工具

AGI

计算

生成式AI

AI设计

大型语言模型

搜索

亚马逊

AI模型

视频生成

特斯拉

DeepMind

场景

Copilot

深度学习

Transformer

架构

MCP

编程

视觉