AI

AI浪潮下,10年后的顶尖高校拼什么? 丨GAIR 2025

AI浪潮下,中国教育能否实现对海外教育的“弯道超车”? 10年后的大学是什么样子,顶尖大学的核心竞争力又是什么? 当下及未来,大学生最重要的求生技能是什么?

不再滚动翻找:ChatGPT AI 可置顶聊天,让重要信息触手可及

AI在线 12 月 19 日消息,OpenAI 公司今天(12 月 19 日)发布推文,宣布 iOS、Android 及网页端 AI 聊天机器人 ChatGPT 即日起上线“聊天置顶”(Pinned Chats)功能,目前已陆续向全球用户推送。 ChatGPT 此前虽然具备根据对话内容自动生成标题的智能标记功能,但在实际使用场景中,随着对话数量的不断累积,旧有的重要对话很容易被淹没在无穷无尽的新对话流中。 用户往往需要花费大量时间滚动屏幕,才能找回之前的关键讨论。

苹果全能视觉 AI 模型 UniGen 1.5 亮相,看图、修图、绘图三合一

AI在线 12 月 19 日消息,科技媒体 9to5Mac 昨日(12 月 18 日)发布博文,报道称苹果研究团队近日发布多模态 AI 模型 UniGen 1.5,成功在单一系统中集成了图像理解、生成与编辑三大核心功能。 与主要依赖不同模型分别处理任务的传统方案不同,UniGen 1.5 最大的突破在于构建了一个统一的框架,仅凭一个模型即可同时完成图像理解、图像生成以及图像编辑任务。 研究人员认为,这种统一架构能让模型利用强大的图像理解能力反哺生成效果,从而实现更精准的视觉输出。

OpenAI 最强智能体编程模型 GPT-5.2-Codex 登场:AI 写代码新巅峰,优化 Win11 原生环境

AI在线 12 月 19 日消息,OpenAI 今天(12 月 19 日)发布公告,宣布推出 GPT-5.2-Codex,是其迄今最前沿、最先进的智能体编程 AI 模型,专为解决复杂的现实软件工程问题训练设计。 该模型在 GPT-5.2 的通用智能基础上,融合了 GPT-5.1-Codex-Max 的终端操作能力,其核心突破在于引入了“上下文压缩”技术,让其在处理代码重构、迁移等长程任务时效率倍增。 针对开发者的实际工作环境,GPT-5.2-Codex 显著增强了在 Windows 10、Windows 11 原生环境下的智能体编码可靠性。

亚马逊任命长期 AWS 高管彼得・德桑提斯领导新 AI 组织

在亚马逊公司最新的消息中,首席执行官安迪・贾西宣布,长期担任 AWS 高管的彼得・德桑提斯将负责公司新成立的人工智能(AI)组织。 这个新的组织将专注于亚马逊的 AI 模型,如 Nova,以及硅片开发和量子计算,旨在提升 AI 工具的速度和效率。 彼得・德桑提斯在亚马逊工作了27年,其中有8年担任 AWS 的高级副总裁。

医生版ChatGPT,估值120亿美元

Jay 发自 凹非寺量子位 | 公众号 QbitAI没想到,医疗场景ChatGPT生意能做这么大……. 最新消息,美国明星创业公司——医生版ChatGPT「OpenEvidence」,新融资将获投约2.5亿美元,估值翻倍至120亿美元。 这意味着,Perplexity、Cursor等超级独角兽的牌桌上,将迎来一家医疗AI公司。

谷歌祭出“降维打击”:Gemini 3 Flash 免费开放,性能反超 Pro?

大模型领域的“性价比之战”再次升级!近日,谷歌宣布正式发布其最新一代轻量化旗舰模型 Gemini3Flash 。 令人惊喜的是,这款主打“极速与低成本”的新模型不仅全面取代了前代产品,成为谷歌搜索AI 模式及 Gemini 应用的默认底层引擎,更在多项实测中上演了“以下克上”的精彩戏码。 🚀速度快3倍,价格却大打折对于企业和开发者而言,Gemini3Flash的出现无异于一次“福利降临”。

OpenAI 正式官宣:开发者可向ChatGPT提交应用程序

OpenAI正式向全球开发者开放 ChatGPT 应用提交权限。 这一举动标志着 ChatGPT 正式从一个“聊天机器人”进阶为类似智能手机系统的“超级应用平台”,开启了属于 AI 原生应用的新纪元。 根据OpenAI 官方公告,开发者现在可以按照最新的应用提交指南提交自己的作品,通过审核后,这些应用将出现在全新的 ChatGPT 应用目录(App Directory)中。

苹果开源 SHARP 模型,1 秒内 AI 让照片变 3D“活”起来

AI在线 12 月 18 日消息,科技媒体 9to5Mac 昨日(12 月 17 日)发布博文,报道称苹果公司开源名为 SHARP 的新型 AI 模型,该技术能在一秒内将单张 2D 照片转换为逼真的 3D 场景。 AI在线援引博文介绍,苹果发布名为《一秒内实现清晰的单目视图合成》(Sharp Monocular View Synthesis in Less Than a Second)论文,详细介绍了如何训练模型,在接收用户输入的一张普通 2D 照片后,能在一秒钟内重建出具有真实物理比例的 3D 场景。 与需要数分钟甚至数小时处理的传统方案相比,SHARP 将合成速度提升了三个数量级,实现了近乎实时的 3D 转换体验。

硬件设计革命:AI 操刀电脑设计,工时压缩 91%

AI在线 12 月 17 日消息,科技媒体 Tom's Hardware 昨日(12 月 16 日)发布博文,洛杉矶初创公司 Quilter 凭借 Project Speedrun 项目,刷新了硬件设计记录:利用 AI 仅耗时一周便完成了一款包含 843 个组件的双印刷电路板(PCB)Linux 电脑设计。 通常情况下,设计这样一款复杂的 PCB 电路板,需要耗时约 3 个月,而 Quilter 仅耗时一周即宣告完成。 更为关键的是,该原型机在制造完成后,首次上电便成功启动并运行了 Debian 操作系统,未出现任何硬件级错误。

何小鹏硅谷归来感悟:物理 AI 迎来三年爆发期,人形机器人将成巨头“大逃杀”

12月17日,小鹏汽车董事长何小鹏在朋友圈发文分享了其赴美交流后的深度洞察。 何小鹏在与硅谷近三十位 AI 专家交流后指出,当前 AI 领域整体不存在泡沫,行业正处于从0到0.1的起步阶段。 他特别强调,虽然数字 AI 领域如 OpenAI 正在全力推进业务落地,但未来三年最有可能产生大变局的是物理 AI 领域。

百姓“平摊”AI 耗电账单,数据称美国数据中心密集区电价五年暴涨 267%

AI在线 12 月 17 日消息,科技媒体 Ars Technica 今天(12 月 17 日)发布博文,美国参议员伊丽莎白・沃伦(Elizabeth Warren)等人于本周二正式致信亚马逊、谷歌、Meta、微软等七家科技巨头,要求其解释数据中心项目如何避免推高居民电费。 参议员援引数据指出,在数据中心活动密集的地区,过去五年的电费涨幅高达 267%。 弗吉尼亚州作为数据中心最集中的地区,预计到 2030 年平均电费将再上涨 25%。

港中文 MMlab×美团新研究:仅用一个模型,应对多种视觉推理任务

在大模型迈向通用视觉智能的浪潮中,单一任务或单一模态的方法正面临瓶颈。 现实世界的视觉理解系统不仅要回答问题,还要理解动态视频、定位事件、跟踪目标、生成描述乃至进行复杂的逻辑推理,这要求模型具备综合的跨任务和跨模态能力。 然而,现有方法多数依赖任务专化模型,难以实现不同视觉任务间的协同与知识共享,这不仅导致系统复杂度高,也限制了模型在综合推理场景中的表现。

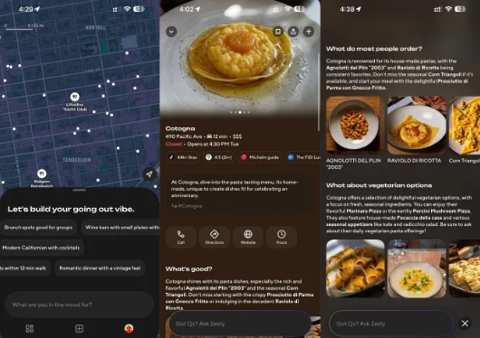

DoorDash 推出 AI 社交应用 Zesty:无需评论,即刻发现周边餐厅

外卖巨头 DoorDash 正式推出一款名为 Zesty 的全新 AI 社交应用。 该应用旨在革新用户发现本地餐厅的方式,通过个性化的人工智能聊天和社交分享功能,帮助用户跳过冗长评论和搜索,快速找到心仪的用餐地点。 AI 驱动的美食发现新范式Zesty 应用的理念是超越传统的外卖和搜索模式,将 DoorDash 的业务范围拓展至社交和美食发现领域。

报道称麦肯锡或将裁员数千人,AI 助力公司内部变革

近日,有消息传出咨询巨头麦肯锡正在考虑裁员,可能涉及数千个职位。 这一决定的背景是,随着人工智能技术的快速发展,公司希望提高运营效率。 在公司庆祝成立100周年之际,麦肯锡发言人表示:“我们正在经历一个由快速的 AI 进步所塑造的时代,这不仅影响了业务,也改变了社会。

UniEdit:首个大型开放域大模型知识编辑基准

随着大语言模型(LLM)的广泛应用,它们在医疗、金融、教育等关键行业扮演着愈发重要的角色。 然而,一个被忽视的现实是:大模型的知识并不会自动更新,更不总是准确。 当模型输出过时信息、错误事实甚至自信满满的“胡说八道”时,如何快速、精准、低成本地纠正它?

免费用:OpenAI 最强 AI 生图模型登场,奥尔特曼变身性感消防员

AI在线 12 月 17 日消息,OpenAI 昨日(12 月 16 日)发布博文,推出“全新旗舰 ChatGPT 图像生成模型”GPT Image 1.5,并罕见公开了该项目背后的庞大研发团队名单,并同步在 ChatGPT 中推出了专用的“Images”(图像)标签页。 此次更新被视为 ChatGPT 图像生成能力的重大飞跃,新模型不仅能生成高保真图像,更在“听懂人话”方面表现出色,即具备极强的提示词遵循能力。 无论是从零创作还是基于上传照片进行编辑,GPT Image 1.5 都能在保留原图核心要素的同时,精准执行用户的指令。

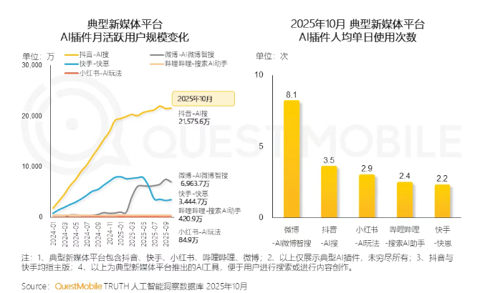

QuestMobile报告:10月抖音、微博、快手平台AI插件月活跃用户规模超三千万

近日,QuestMobile 发布了《2025年新媒体生态盘点》报告,数据表明,2025年10月 AI 相关内容的用户渗透率同比增长了9.9个百分点。 这一增长趋势表明,越来越多的用户开始关注和使用与 AI 相关的内容,而这其中,深度兴趣用户的年龄层则呈现出明显的年轻化特征。 根据报告,抖音、微博和快手等平台的 AI 插件在2025年10月的月活跃用户规模均突破了三千万大关,显示出这些社交媒体平台在 AI 领域的迅猛发展。

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

AI新词

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

英伟达

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

代码

AI for Science

苹果

算法

腾讯

Agent

Claude

芯片

Stable Diffusion

具身智能

xAI

蛋白质

开发者

人形机器人

生成式

神经网络

机器学习

AI视频

3D

RAG

大语言模型

字节跳动

Sora

百度

研究

GPU

生成

工具

华为

AGI

计算

大型语言模型

AI设计

生成式AI

搜索

视频生成

亚马逊

AI模型

DeepMind

特斯拉

场景

深度学习

Transformer

架构

Copilot

MCP

编程

视觉