开源

横评五款开源多智能体框架,AI高手都在用哪个?下一款Manus、Cursor、Devin,谁能撑起来?

编辑 | 云昭出品 | 51CTO技术栈(微信号:blog51cto)Agent 成为共识的速度非常快。 但今年 Agent 的真正转折点在于:多智能体。 从科研自动化到任务编排,从自动开淘宝店到 Vibe 一切,从 AI 浏览器到今天的 ChatGPT Agent,一切都是多智能体的味道。

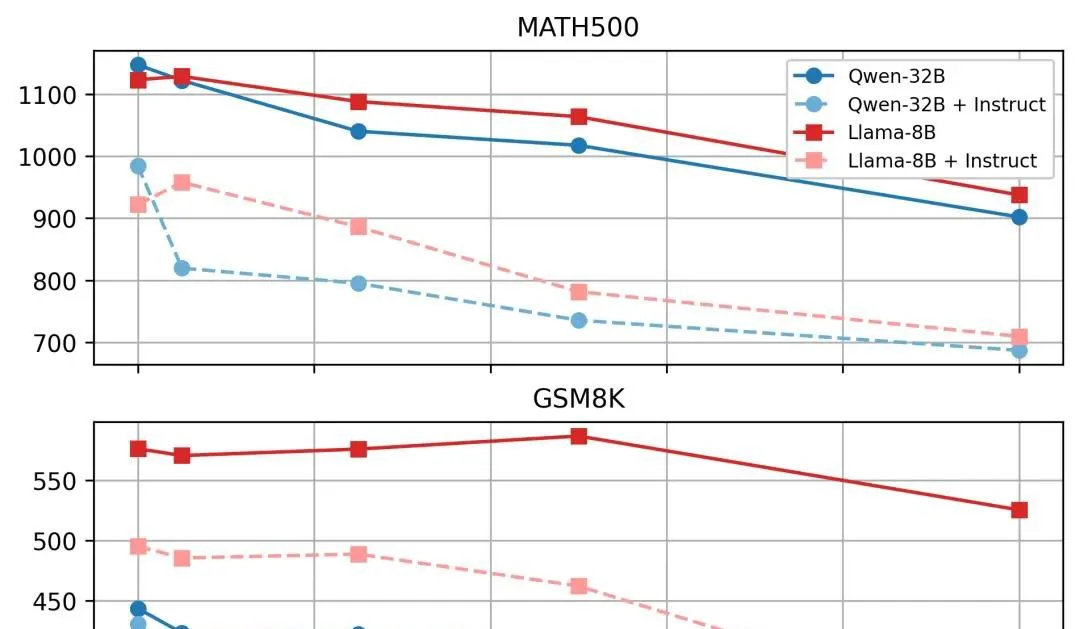

全球最强开源「定理证明器」出世!十位华人核心,8B暴击671B DeepSeek

全球最强的开源「定理证明器」诞生了! 来自普林斯顿、清华、英伟达、斯坦福等八大顶尖机构联手,祭出了第二版Goedel-Prover-V2模型。 项目地址: 2025顶会录用,曾在miniF2F Pass@32刷新SOTA,位列PutnamBench榜首。

Le Chat全方面对标ChatGPT,欧洲AI新贵穷追不舍

最近几个月,由谷歌和 Meta 前研究人员建立的欧洲的 AI 初创公司 Mistral AI 有些躁动不安。 他们接连发布了好些个开源模型,覆盖不同的领域,包含号称「世界上最优秀」的 OCR 模型、「对标 Claude」的多模态模型、首个推理大模型 Magistral 以及两天前发布的「全球最佳」的开源语音模型 Voxtral。 这样似乎也很难让这位欧洲 AI「新贵」感到满意,他们还想在应用层面好好地卷一卷 OpenAI。

1万tokens是检验长文本的新基准,超过后18款大模型集体失智

上下文扩展至1万tokens,LLM集体“失智”! 且“智商”不是均匀下降,而是在一些节点突然断崖式下跌。 比如Claude Sonnet 4,就是在1000tokens后准确率一路下滑,从90%降到60%。

月之暗面开源 Kimi-K2:万亿参数,超强Agent,全线 SOTA

2023年成立的中国AI初创公司月之暗面,刚刚发布了其最新重量级产品Kimi-K2。 这是一款参数规模高达一万亿的开源大模型,以挑战GPT-4.1和Claude Sonnet 4为目标。 Kimi-K2没有配备专门的“推理模块”,却依然在多个关键领域打破性能壁垒,这一策略让人想起早前Deepseek的发布。

一文读懂开源 AI Agent 工作流构建新范式-Sim Studio

Hello folks,我是 Luga,今天我们来聊一下人工智能应用场景 - 构建高效、灵活的计算架构的开源 AI Agent 工作流引擎 - Sim Studio。 在大模型应用爆发的当下,越来越多团队开始尝试构建属于自己的 AI Agent。 然而从 LLM 接入、任务解析、插件整合到执行流程编排,整个链路不仅复杂,而且难以维护。

基于闪电注意力机制,创新高效开源大模型

从数学竞赛、编程到自然语言处理,通过大规模的强化学习的模型正不断提升其推理能力。 但传统的Transformer架构由于其注意力机制的二次计算复杂度,在处理长文本和复杂推理任务时面临着效率瓶颈。 尽管有研究提出了多种改进方法,如稀疏注意力、线性注意力等,但这些方法在大规模推理模型中的应用效果尚未得到充分验证,大多数领先的模型仍然依赖于传统的注意力设计。

完全透明开源的共情语音大模型,三阶段训练,四大模块实现端到端对话

GPT-4o、Gemini这些顶级语音模型虽然展现了惊人的共情对话能力,但它们的技术体系完全闭源。 现在,紫东太初团队联合长城汽车AI Lab直接把整个技术栈都开源了,推出完全透明开源的端到端共情语音语言大模型OpenS2S。 OpenS2S的核心在于提供一个高效、低成本构建共情语音系统的新范式。

五个月估值120亿!OpenAI前CTO自曝首个多模态AI,竟要免费开源

OpenAI前CTO初创,又拿到新融资了! 一早,Mira Murati官宣由a16z领投20亿美元融资,至此,Thinking Machines Lab估值120亿美元。 同时,英伟达、AMD、Accel、ServiceNow等多家明星风投也参与了本次融资。

RAG系列:MinerU、Docling还是Unstructured?用OmniDocBench评测开源文档解析工具

引言从写 RAG 开发入门这一系列文章开始,特别是文档解析这个环节,有很多读者询问某个文档解析工具的能力怎么样,和其它工具对比如何,这表明开源社区虽然涌现出了很多的文档解析工具,但是它们在实际场景的表现到底如何,这在很多人中是没有太明确答案的。 因而,面对众多工具的选择,我们期望能有一个统一的基准来评估其实际效果,而且对于大部分人来说是需要开箱即用的。 本文我将介绍一款由上海人工智能实验室开源的多源文档解析评测框架 - OmniDocBench[1],凭借其多样性、全面性和高质量标注数据以及配套的评测代码,是一个不错的衡量文档解析工具性能的选择。

内部爆料:Alexandr Wang上任第一把火,Meta大模型闭源

曾经被称为「开源之光」的 Meta,之后可能也要走闭源路线了。 据知情人士透露,Meta 新成立的超级智能实验室近期正在讨论一项可能改变其人工智能发展方向的重大决策。 在 Meta 内部,关于 AI 发展路径出现了不同声音。

谷歌T5Gemma重燃架构之战!「套壳」反杀Gemma本尊,9B推理快得离谱

2023年以来,大模型的战场由decoder-only架构一统江湖。 从GPT家族到LLaMA、Gemma、Mistral,再到Claude、Command-R、Yi系列,能叫得出名字的主流LLM,几乎都是清一色的「纯解码器」(decoder-only)。 但今天,Google带着T5Gemma杀回来了——不仅重启了encoder-decoder的技术路线,还略施小技就让它原地起飞,暴打原版Gemma 2。

用AI写代码效率反降19%!246项任务实测,16位资深程序员参与

用AI,有经验的开发者反倒被拖慢了? 在一项基于真实开源项目的实验中,研究者发现使用AI工具不仅没有提升开发效率,反而让任务时间增加19%。 这简直与人们预测的结果完全相反。

杨植麟被梁文锋叫醒了!Kimi新模型发布即开源,1T参数全线SOT

172天过去,Kimi在深夜低调给出了DeepSeek冲击波后的回应。 全新Kimi K2基础大模型,MoE架构,总参数1T,激活参数32B,能力领先性尤其展现在代码、Agent、数学推理任务上。 Kimi援引多个基准评测数据,创造了开源全新SOTA。

WebSailor 突破边界:助力开源智能体跨越复杂推理 “天花板”

大家好,我是肆〇柒,自从互联网时代开启以来,人类社会经历了多次信息技术变革,而互联网犹如一把双刃剑。 一方面,它以每两年数据量翻一番的惊人速度,为人类打开了通往海量知识的大门;另一方面,也向我们的认知能力发起了前所未有的挑战。 当我们面对无边无际的信息数据时,人类有限的记忆容量、脆弱的注意力稳定性,以及线性单一的探索路径,无疑成为了制约我们高效获取精准信息的瓶颈。

微软开源新版Phi-4:推理效率暴涨10倍,笔记本可运行

今天凌晨,微软在官网开源了Phi-4家族的最新版本Phi-4-mini-flash-reasoning。 mini-flash版延续了Phi-4家族参数小性能强的特点,是专门针对那些受算力、内存和延迟限制场景设计的,单个GPU可运行,适合笔记本、平板电脑等边缘设备。 与前一个版本相比,mini-flash使用了微软自研的创新架构SambaY,推理效率暴涨了10倍,延迟平均降低了2—3倍,整体推理性能实现了大幅度提升。

AI版三个臭皮匠!ChatGPT/Gemini/DeepSeek合体拿下AGI测试最高分

不圆 发自 凹非寺. 量子位 | 公众号 QbitAIChatGPT的对话流畅性、Gemini的多模态能力、DeepSeek的长上下文分析……. 能不能让它们强强联合,共同解决问题呢?

DeepSeek推理最高提速6倍!开源研究:加装「思维进度条」,计算量减少30%

DeepSeek推理要详细还是要迅速,现在可以自己选了? 来自特拉维夫大学的研究团队开发出了一种新方法,可以监控和控制LLM中的思考路径长度。 给LLM的推理任务装上进度条,还能控制推理的深度、调整推理速度。

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

AI新词

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

英伟达

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

代码

AI for Science

苹果

算法

腾讯

Agent

Claude

芯片

Stable Diffusion

具身智能

xAI

蛋白质

开发者

人形机器人

生成式

神经网络

机器学习

AI视频

3D

RAG

大语言模型

字节跳动

Sora

百度

研究

GPU

生成

工具

华为

AGI

计算

大型语言模型

AI设计

生成式AI

搜索

视频生成

亚马逊

AI模型

DeepMind

特斯拉

场景

深度学习

Transformer

架构

Copilot

MCP

编程

视觉