资讯列表

新手指南:跟踪LLM应用程序中的token使用

译者 | 布加迪审校 | 重楼引言在构建大语言模型应用程序时,token就是金钱。 如果你曾经使用过像GPT-4这样的 LLM,可能有过这样的经历:查看账单时纳闷“费用怎么这么高? ” 你进行的每次API调用都会消耗token,这直接影响延迟和成本。

11/3/2025 9:00:00 AM

布加迪

硅谷今夜学中文!Cursor被曝「套壳」国产,AI顶级人才全是华人

如果你关注最近硅谷的AI圈子,你会发现最近出现一个神奇的现象。 当国内都在学英语看文献的时候,国外的AI圈子都说中文了! 简直是倒反天罡。

11/3/2025 8:59:00 AM

内存直降50%,token需求少56%!用视觉方式处理长文本

在处理短文本时,大语言模型(LLM)已经表现出惊人的理解和生成能力。 但现实世界中的许多任务——如长文档理解、复杂问答、检索增强生成(RAG)等——都需要模型处理成千上万甚至几十万长度的上下文。 与此同时,模型参数规模也从数十亿一路飙升至万亿级别。

11/3/2025 8:58:00 AM

微软AI新天团曝光!只有1位华人,「谷歌系」超1/3

刚刚,微软AI「新天团」阵容曝光! 在新增的9名核心成员中,5名来自谷歌/DeepMind,另有2位分别是Meta与Snap的前高管。 他们在最近一年内由苏莱曼相继招入麾下。

11/3/2025 8:57:00 AM

L2奶爸车用VLA变Robotaxi!深圳物理AI独角兽,率先无锡换道超车

一凡 发自 副家寺. 智能车参考 | 公众号 AI4AutoRobotaxi赛道,又迎来一位L2升维路线玩家。 智能车参考获悉,元戎启行计划在年底基于消费级量产车落地Robotaxi业务。

11/3/2025 8:53:04 AM

一凡

「上下文工程」 已经30岁了,而你可能刚知道它

AI时代,人不再只是「社会关系的总和」,而是由无数数据、记录和互动的上下文构成的。 这不是科幻。 这是正在发生的现实。

11/3/2025 8:53:00 AM

Cursor“自研”模型套壳国产开源?网友:毕竟好用又便宜

美国顶流AI产品“套壳”中国开源大模型,这事儿上“热搜”了(doge)。 𝕏网友都在感叹:大家都认为中国大模型正在迎头赶上。 不,它们已经赶上了。

11/3/2025 8:52:00 AM

大模型AI扫地机器人 “翻车”:成功率仅 40%!家庭应用仍有待提高

最近,AI 实验室 Andon Labs 进行了一项引人注目的研究,专门评估了搭载顶级大模型的扫地机器人在完成简单家务任务时的表现。 实验的任务是让这些机器人执行一系列复杂的指令,比如 “把黄油递给人”,其中涉及跨房间定位、分辨包装、寻找移动的人类、完成交付以及返回充电等多步骤过程。 然而,结果让人震惊。

11/3/2025 8:51:19 AM

AI在线

OpenAI年收入已远超130亿美元,上市计划仍遥遥无期

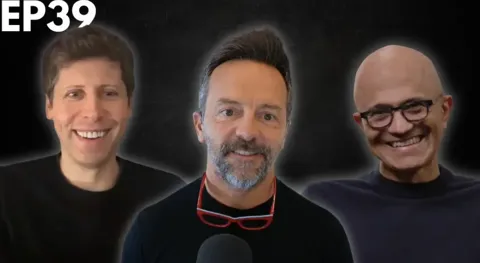

在最新一期的 BG2播客节目中,OpenAI 首席执行官萨姆・奥尔特曼(Sam Altman)与微软首席执行官萨提亚・纳德拉(Satya Nadella)展开了一场深度对话,揭示了关于 OpenAI 财务状况和未来发展的新信息。 奥尔特曼在节目中透露,OpenAI 的年收入已远超130亿美元,而这一数据显然只是冰山一角。 面对主持人布拉德・格斯特纳的提问,奥尔特曼坚决否认了关于 OpenAI 计划于明年上市的传闻。

11/3/2025 8:51:17 AM

AI在线

最新研究:大模型驱动的扫地机器人多任务表现不佳,成功率仅 40%

最近,AI 实验室 Andon Labs 进行的一项评估引发了广泛关注。 研究显示,搭载顶尖大模型的扫地机器人在执行简单家务任务时,其成功率仅为40%,远低于人类的表现。 此次实验要求机器人按照 “把黄油递给人” 的多步骤指令执行任务,涉及跨房间定位、识别包装、寻找移动位置的人类、完成交付并返回充电等复杂环节。

11/3/2025 8:51:16 AM

AI在线

警惕!供应商的AI即是你的风险:这四项条款能救你于隐性责任之外

麦肯锡的一份报告显示,78%的企业表示至少在一个业务职能中使用了AI,这意味着你所在企业对AI的使用已不再是唯一的担忧。 如今,风险暴露的边界已延伸至合作伙伴和供应商对AI的使用。 主要问题在于:他们是否在你未察觉的情况下,将AI嵌入到运营中,直到出现问题你才有所发现?供应商的聊天机器人处理敏感数据不当、算法输出结果存在偏见,或是合作伙伴用你的信息训练其模型,这些情况都可能引发监管处罚和声誉受损。

11/3/2025 7:00:00 AM

Arti

最火VLA,看这一篇综述就够了

ICLR 2026爆火领域VLA(Vision-Language-Action,视觉-语言-动作)全面综述来了! 如果你还不了解VLA是什么,以及这个让机器人学者集体兴奋的领域进展如何,看这一篇就够了。 文章作者Moritz Reuss是2025年Apple AI/ML学者奖得主,曾在RSS、ICLR、NeurIPS等顶级会议多次发表研究成果。

11/3/2025 4:00:00 AM

前OpenAI灵魂人物Jason Wei最新演讲!三大思路揭示2025年AI终极走向

用三句话总结下2025年AI的发展,你会想到什么? 所有能被验证的任务,最终都会被AI解决智能最后会变成商品,知识价格归零AI不会瞬间超过人类最近,前OpenAI核心研究员、CoT(思维链)作者Jason Wei在斯坦福大学AI Club做了一场精彩的演讲。 图片这是他跳槽到Meta后少有的公开分享。

11/3/2025 2:00:00 AM

新智元

MemMamba:用"做笔记"机制突破长序列建模的记忆瓶颈

大家好,我是肆〇柒。 今天要和大家分享的是由中国人民大学统计学院、上海人工智能实验室和上海财经大学联合研究团队在ICLR 2026会议投稿的突破性工作——MemMamba。 这项研究首次系统揭示了Mamba模型的记忆衰减机制,通过受人类"做笔记"行为启发的创新设计,成功解决了长序列建模中的关键记忆瓶颈问题,在400k tokens的极端长序列任务中仍能保持90%的准确率,为高效且强大的序列建模开辟了全新道路。

11/3/2025 1:00:00 AM

肆零柒

奥特曼纳德拉同台回应一切:合作细节、OpenAI未来路线曝光

henry 发自 凹非寺. 量子位 | 公众号 QbitAIOpenAI完成“股改”,奥特曼和微软纳德拉一起露面回应一切了。 从OpenAI新组织结构的影响,到微软与OpenAI的后续合作,再到AI未来,两人在1个多小时的时间里,深入聊了不少外界感兴趣的话题。

11/2/2025 6:23:49 PM

henry

奥特曼回应一切:重组后仍需微软支持,不相信OpenAI的欢迎做空

近期 OpenAI 完成了资本重组,其非营利实体现更名为 OpenAI 基金会(OpenAI Foundation),并持有约 1300 亿美元的营利部门股权,营利部门则改制为一家公益性公司,名为 OpenAI Group PBC。 这意味着,OpenAI 与微软的合作关系也迎来了新篇章。 2018 年,还是非营利性组织的 OpenAI 迫于生存压力与微软达成合作并调整组织结构,成立营利性子公司 OpenAI LP。

11/2/2025 6:06:00 PM

机器之心

跟不上、读不完?上万篇顶会论文,这个工具一键分析

一个研究者一天到底要读多少篇论文才能跟上最新趋势? 在 AI 研究成果爆炸的今天,这个数字变得越来越模糊。 人的阅读速度,早就跟不上 AI 科研地图扩展的速度了。

11/2/2025 6:02:00 PM

机器之心