3D

《三体》“宇宙闪烁”成真!免佩戴裸眼3D屏登Nature

克雷西 发自 凹非寺. 量子位 | 公众号 QbitAI《三体》中的“宇宙为你闪烁”,不再是科幻了。 最新登上Nature的显示屏EyeReal,无需佩戴眼镜就能把3D画面精准投射到你的眼中。

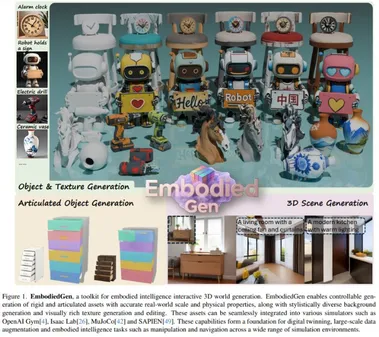

图片生成仿真!这个AI让3D资产「开箱即用」,直接赋能机器人训练

非羊 整理自 凹非寺. 量子位 | 公众号 QbitAI一张照片,就能生成可直接用于仿真的3D资产。 (没错,下图中几乎所有物体都是AI生成的)随着三维建模从传统的静态视觉效果,逐步迈向可用于仿真与交互的物理可动资产,如何直接生成具备物理属性与关节结构的3D对象,成为推动具身智能(embodied AI)发展的关键。

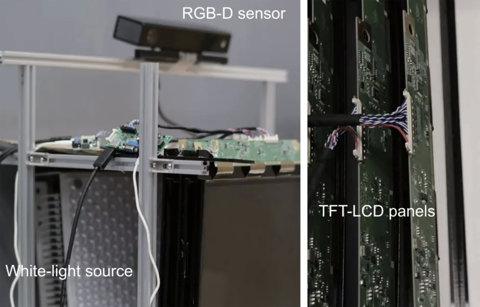

超94%类别第一!3D点云异常检测与修复新SOTA | ICCV'25

在制造质检、机器人抓取与3D打印等场景中,3D点云的异常检测日益关键,但实际应用却常遭遇两大难题:一是物体姿态随机、形变细微,传统离散化表示(体素、点云、视角投影)容易丢失几何细节;二是检测之后如何修复缺陷,业界缺少能直接生成高保真「正常模板」的方法。 为突破这两道关卡,上海科技大学与密歇根大学联合团队提出Pose-Aware Signed Distance Function(PASDF)框架,通过显式姿态对齐与连续的SDF形状表示,实现「检测—定位—修复」的一体化闭环。 论文地址:: AUROC分别为80.2%与90.0%的最新成绩,并在点级定位、可视化修复方面表现突出。

一张照片,一个3D「你」:计算所等提出HumanLift,实现高保真数字人重建

创建具有高度真实感的三维数字人,在三维影视制作、游戏开发以及虚拟/增强现实(VR/AR)等多个领域均有着广泛且重要的应用。 尽管现有技术在从多视角图片重建高质量、可动画化的三维人体模型任务中展现出诸多优势,但从单张参考图像重建真实感三维数字人,依旧面临技术复杂、资源消耗大的挑战。 如何兼顾三维一致性与参考图像一致性,重建出高质量、高真实感的人物外观与姿势,以及如何生成高真实度且细节一致的服饰、人脸等,都是亟待解决的难题。

李飞飞全新「世界模型」问世!单张H100实时生成3D永恒世界

就在刚刚,李飞飞World Labs重磅发布全新实时生成式世界模型——RTFM(Real-Time Frame Model,实时帧模型)! 这是一款效率极高的,在大型视频数据上进行端到端训练的自回归扩散Transformer模型。 仅需一块H100 GPU,RTFM就能在你与之交互时,实时渲染出持久且3D一致的世界,无论是真实场景还是想象空间。

混元3D开源端到端全景深度估计器,代码+精选全景数据已上线,在线可玩

全景图具有完整的视场 (360°×180°),比透视图提供更完整的视觉描述。 得益于此特性,全景深度估计在3D视觉领域正日益受到关注。 然而,由于全景数据的稀缺,以往的方法通常局限于域内设置,导致零样本泛化能力较差。

斯坦福李飞飞团队,带你一句话进入无限3D世界

斯坦福大学的李飞飞教授,又带着她的新成果来“砸场子”了。 只用一张图,甚至一句话,就能直接生成一个可以让你在里面“逛街”的3D世界。 不是图片,也不是视频,而是一个活生生的、可以自由探索、永久存在的3D虚拟空间。

刚刚,李飞飞空间智能新成果震撼问世!3D世界生成进入「无限探索」时代

就在今天,斯坦福大学教授李飞飞的创业公司 World Labs 发布了新成果 —— 限量开放的测试预览版空间智能模型 Marble。 「只需一张图片,就能生成持久存在的 3D 世界,比以往更宏大、更震撼! 」我们先看下面一段视频 demo: 李飞飞对此表示,「这是一个使用我们的 3D 世界生成模型创建的极其庞大的世界,它令我惊叹不已!

首个3D动作游戏专用VLA模型,打黑神话&只狼超越人类玩家 | ICCV 2025

3B多模态大模型在动作角色扮演游戏的战斗任务中,成功率超越GPT-4o和人类玩家,淘天集团未来生活实验室团队提出了CombatVLA,已被ICCV 2025接收。 在复杂的三维环境中实现实时决策仍面临重大挑战,要求模型能在秒级时间尺度做出响应,具备高分辨率感知能力,并能够在动态条件下进行战术推理。 如下图所示,团队给出了CombatVLA推理得到的AoT解释、解析成Python代码的动作指令,以及执行这些动作后的帧序列。

李飞飞押注的「世界模型」,中国自研Matrix-3D已抢先实现了?

一花一世界,一叶一菩提。 千百年来,人类只能凭想象勾勒图画之外的世界,梦境与现实之间始终隔着一层不可触及的纱幕。 而今天,当AI的力量被无限延伸,这层纱幕终于被揭开——Matrix-3D,一个真正从「一图生万境」的世界模型!

刚刚,谷歌摊牌:Genie 3让你1秒「进入」名画,人人可造交互世界!

谷歌摊牌了,彻底不装了! 他们前几天刚刚发布的Genie 3世界模型,正在疯狂展示AI的超能力。 它不只是能从文本中生成交互式的AI空间世界,还能操控图像和视频。

腾讯发布混元3D世界模型1.0:首个支持物理仿真的开源世界生成系统

首个支持物理仿真的开源3D世界生成模型来了! 一句话、一张图就能生成完整3D世界,可编辑、可仿真。 在2025年世界人工智能大会(WAIC)上,腾讯正式发布混元3D世界模型1.0——首个开源且兼容传统CG管线的可漫游世界生成模型。

谢赛宁团队新作:不用提示词精准实现3D画面控制

曾几何时,用文字生成图像已经变得像用笔作画一样稀松平常。 但你有没有想过拖动方向键来控制画面? 像这样,拖动方向键(或用鼠标拖动滑块)让画面里的物体左右移动:还能旋转角度:缩放大小:这一神奇操作就来自于谢赛宁团队新发布的 Blender Fusion框架,通过结合图形工具 (Blender) 与扩散模型,让视觉合成不再仅仅依赖文本提示,实现了精准的画面控制与灵活操作。

如何做到在手机上实时跑3D真人数字人?MNN-TaoAvatar开源了!

TaoAvatar 是由阿里巴巴淘宝 Meta 技术团队研发的 3D 真人数字人技术,这一技术能在手机或 XR 设备上实现 3D 数字人的实时渲染以及 AI 对话的强大功能,为用户带来逼真的虚拟交互体验。 它是如何实现的呢? 本文将为您揭秘 TaoAvatar 背后的黑科技!

CVPR 2025 Award Candidate | 英伟达等Difix3D+:用单步扩散模型修复 3D 重建伪影

在 3D 重建领域,无论是 NeRF 还是最新的 3D Gaussian Splatting(3DGS),在生成逼真新视角时仍面临一个核心难题:视角一旦偏离训练相机位置,图像就容易出现模糊、鬼影、几何错乱等伪影,严重影响实际应用。 为了解决这个问题,来自英伟达的研究团队联合提出了一种创新方案 —— Difix3D ,通过单步扩散模型对 3D 渲染结果进行 “图像修复”,显著提升新视角图像的质量和一致性。 该工作已被 CVPR 2025 接收,并入选 Best Paper Award 候选。

突破 3D 环境生成瓶颈,EmbodiedGen 助力智能机器人研究

在当前身体现智能(Embodied AI)的发展过程中,创建真实且精确缩放的3D 环境至关重要。 然而,现有的方法仍主要依赖于人工设计的3D 图形,这不仅成本高昂,而且缺乏真实感,限制了其扩展性和通用性。 为了在物理环境中实现通用智能,必须进行真实的模拟、强化学习以及多样化的3D 资产生成。

3D高斯泼溅,可输入视图量高达500!推理速度提升3倍,内存少80%

在增强现实(AR)和虚拟现实(VR)等前沿应用领域,新视角合成(Novel View Synthesis, NVS)正扮演着越来越关键的角色。 近年来,3D高斯泼溅(3D Gaussian Splatting, 3DGS)技术横空出世,凭借其革命性的实时渲染能力和卓越的视觉质量,迅速成为NVS领域的一大突破。 然而,传统3DGS对耗时的「逐场景优化」的依赖,严重限制了其在实际应用中的部署。

视频扩散模型新突破!清华腾讯联合实现高保真3D生成,告别多视图依赖

三维场景是构建世界模型、具身智能等前沿科技的关键环节之一。 尽管Hunyuan3D、Rodin-v1.5、Tripo-v2.5等生成模型已在三维生成领域取得显著进展,但其往往聚焦在物体级别内容生成,难以实现复杂三维场景的构建。 清华大学联合腾讯提出Scene Splatter——从一张图像出发,基于自定义的相机轨迹探索三维场景。

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI新词

AI绘画

大模型

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

Gemini

技术

英伟达

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

代码

AI for Science

腾讯

苹果

算法

Agent

Claude

芯片

具身智能

Stable Diffusion

xAI

蛋白质

开发者

人形机器人

生成式

神经网络

机器学习

AI视频

3D

字节跳动

大语言模型

RAG

Sora

百度

研究

GPU

生成

华为

工具

AGI

计算

生成式AI

AI设计

大型语言模型

搜索

AI模型

视频生成

亚马逊

特斯拉

DeepMind

场景

Copilot

深度学习

Transformer

架构

MCP

编程

视觉