MCP

MCP:AI 界的“USB-C接口”,如何让大模型“能说会干”?

你有没有遇到过这种情况? 让AI助手“帮我订明天去上海的机票”,它只会回你“建议你去XX平台搜索”,却没法真的点几下按钮把票订好? 或者让它“给同事发封邮件说会议改期”,它写好内容后还得你自己复制到邮箱发送?

AI秒变PPT大师!Office-PowerPoint-MCP-Server上线,自动生成专业报告,效率翻倍!

近日,Office-PowerPoint-MCP-Server 成为社区热议的焦点,这款基于 Model Context Protocol(MCP)的开源工具通过 AI 助力用户快速创建和编辑 PowerPoint 演示文稿,为企业报告生成和数据可视化提供了全新解决方案。 AIbase编辑部整理了最新动态,带您深入了解这一工具的强大功能与应用前景。 Office-PowerPoint-MCP-Server:AI驱动的PPT自动化神器Office-PowerPoint-MCP-Server 是一款利用 python-pptx 库开发的 MCP 服务器,旨在通过自然语言指令或代码调用实现 PowerPoint 演示文稿的自动化创建与编辑。

Anthropic 的Claude Code支持与任何远程 MCP 服务器集成

在 AI 行业迅速发展的背景下,Anthropic 公司近日宣布,将其 Claude Code 功能扩展到任何远程的模型上下文协议(MCP)服务器。 自去年 MCP 标准发布以来,该协议逐渐被微软、OpenAI 和谷歌等公司广泛采纳,成为连接 AI 助手与数据系统的重要标准。 Claude Code 是一款强大的编码助手,它允许用户在工作空间中直接编写或管理代码,支持在终端、IDE 内或后台运行。

智能体开发实战 | 基于Dify+MCP实现理财助手智能体

前言AI智能体通过感知环境、自主决策和执行任务,突破传统大模型仅限于语言交互的局限。 例如,当用户指令“订一张明天去北京的机票”时,智能体不仅理解语义,还能自动调用航班查询接口、完成支付并同步至日程系统。 这种能力使其在客服、医疗、智能制造等领域展现出颠覆性潜力。

Microsoft Opensource Azure DevOps Local MCP Server: Seamlessly Manage DevOps Tasks in VS Code

Microsoft Azure DevOps is seamlessly integrating powerful DevOps capabilities into code editors through its new MCP Server project, significantly enhancing developer productivity. Currently in public preview, the Azure DevOps MCP Server allows users to execute various Azure DevOps tasks directly within popular editors like VS Code and VS Code Insiders via a local server.Core Features and Highlights:The core of Azure DevOps MCP Server lies in providing rich Azure DevOps context information for development agents.

MCP 很好,但它不是万灵药!真正的技术进步,往往始于祛魅之后的清醒认知

当下AI领域最炙手可热的概念,莫过于MCP。 MCP 指的是Model Context Protocol(模型上下文协议)。 令人意外的是,一个协议系统的热度,甚至盖过了OpenAI发布的最新模型,成为行业讨论的焦点。

构建AI Agent的最优学习路线总结:MCP、CrewAI和Streamlit

如何通过 MCP(Model Context Protocol) 创建一个结合网络搜索、AI 代理和图像生成的现代研究助手引言:AI 驱动的研究未来已来想象一下,您拥有一个个人研究助手,可以即时搜索网络、分析信息、生成全面的总结,甚至创建相关图像——所有这些都通过一个美观的 Web 界面完成。 如果这个助手还能由尖端的 AI 代理驱动,与外部工具和 API 无缝协作,会怎样? 欢迎体验 MCP-Powered Study Assistant —— 一款结合现代 AI 技术的革命性应用:• 🤖 CrewAI 代理,用于智能研究和写作• 📡 Model Context Protocol (MCP),实现无缝工具集成• 🌐 Streamlit,提供直观的 Web 界面• 🔍 通过 Brave Search API 实现实时网络搜索• 🎨 通过 Segmind API 进行 AI 图像生成这不仅仅是另一个 ChatGPT 包装器——它是一个完整的研究生态系统,展示了 AI 驱动应用的未来。

生成式 AI 在 B 端软件中实践的思考

我一直认为 C 端软件和 AI 的结合会更顺畅一些,例如,笔记工具“墨问”最近推出了 MCP 功能,允许我在各种客户端中与 AI 交互,并将结果通过 MCP 保存至其中。 这是因为大部分情况下,C 端对准确性的容忍度更高。 B 端软件则不同,其对准确性要求极高,尤其在金融、医疗等行业。

用 Dify 智能体实现微信天气助手,轻松获取好友天气信息!

近期,有开发者利用 Dify 平台结合 MCP(多通道协议)技术,创建了一个通过微信自动发送天气信息给好友的智能助手,极大地方便了用户获取天气预报的需求。 本文将为您详细介绍这一新兴应用的开发过程。 首先,开发者需要在 Windows 环境中搭建一个名为 MCP Server 的应用。

智能体开发实战|基于Dify+MCP实现通过微信发送天气信息给好友

前言AI智能体通过感知环境、自主决策和执行任务,突破传统大模型仅限于语言交互的局限。 例如,当用户指令“订一张明天去北京的机票”时,智能体不仅理解语义,还能自动调用航班查询接口、完成支付并同步至日程系统。 这种能力使其在客服、医疗、智能制造等领域展现出颠覆性潜力。

三步搭建MCP服务器,让AI工具直接调用n8n工作流

今天我们将视角转向服务端实现。 n8n 自 1.88.0 版本起,引入了一个革命性特性——MCP Server Trigger 节点。 这一创新让开发者能够将复杂的工作流包装成标准化的 MCP 服务,通过 SSE(Server-Sent Events)协议对外发布。

超实用!Dify调用Java的三种实现方式!

在一些复杂的业务中,我们可能需要使用 Dify 调用外部程序(如 Java 程序),因为这样才能满足业务的特殊需求。 例如,当我们使用 Dify 实现“AI 简历自动筛选器”的时候,我们首先会使用 AI 筛选出符合招聘要求的简历,然后再将简历存放到公司的“人才库”系统中,完成后续流程的招聘需要(预约面试、面试评价、发送 Offer 等操作),这个时候就需要让 Dify 调用 Java 程序了。 那么问题来了,使用 Dify 调用 Java 程序的实现方式有哪些呢?

AI 编程神器 Cursor 1.0 发布:BugBot 代码审查、Memories 记忆、一键 MCP 安装等

Cursor 1.0版本正式发布,新增BugBot自动代码审查工具、Memories记忆功能及一键安装MCP服务器等多项实用功能,显著提升开发体验。#AI编程# #Cursor1.0#

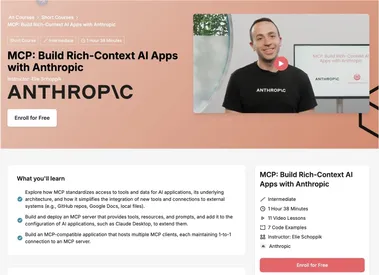

Anthropic 开设一门关于使用 MCP 构建 AI 应用程序免费课程

人工智能技术的快速发展为开发者提供了无限可能,而如何高效连接AI模型与外部数据源成为行业关注的焦点。 近日,Anthropic与DeepLearning.AI合作推出了一门免费课程——“MCP:使用模型上下文协议构建富上下文AI应用”。 该课程旨在帮助开发者掌握Model Context Protocol(MCP),通过标准化协议简化AI应用与外部工具和数据的连接。

MCP原理与实战:下一代AI Agent的底层基建设计

MCP (Model Context Protocol) 模型上下文协议,通俗地讲就是 AI 领域的“通用接口”。 若将大模型视作计算机或智能手机,MCP 则相当于标准化的 USB 接口,不同的大模型都能通过它无缝接入实时数据、外部数据源等。 通过 MCP,开发者无须针对不同的大模型重复编写集成代码,只需遵循统一的标准即可实现兼容。

超实用!Dify快速接入本地MCP服务

Dify 可以通过插件实现 MCP 服务调用,而被调用的 MCP 服务基本可以分为以下两类:通用 MCP 服务(非本地 MCP 服务)。 本地 MCP 服务。 本地 MCP 服务指的是本地通过 Java 或其他语言实现的 MCP 服务器端。

轻松配置Cursor玩转MCP,你学会了吗?

我们来看如何配置 Cursor。 需要注意,低版本 Cursor 也支持 MCP 服务,我用的是 0.48.7 版本。 在 Cursor 设置中,先将版本切换到 Early Access(抢先体验)。

构建强大AI Agent的关键 = Pydantic AI + MCP + Advanced Web Scraping

引言在文中,我将展示一个超快速教程,教你如何使用 Pydantic AI、MCP 和高级网页抓取技术,构建一个强大的智能聊天机器人,适用于商业或个人用途。 MCP 逐渐被接受,因为它是一个开放标准。 我制作了一些非常酷的视频,你一定会喜欢。

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

AI新词

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

英伟达

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

代码

AI for Science

苹果

算法

腾讯

Agent

Claude

芯片

Stable Diffusion

具身智能

xAI

蛋白质

开发者

人形机器人

生成式

神经网络

机器学习

AI视频

3D

RAG

大语言模型

字节跳动

Sora

百度

研究

GPU

生成

工具

华为

AGI

计算

大型语言模型

AI设计

生成式AI

搜索

视频生成

亚马逊

AI模型

DeepMind

特斯拉

场景

深度学习

Transformer

架构

Copilot

MCP

编程

视觉