今天我们将视角转向服务端实现。n8n 自 1.88.0 版本起,引入了一个革命性特性——MCP Server Trigger 节点。这一创新让开发者能够将复杂的工作流包装成标准化的 MCP 服务,通过 SSE(Server-Sent Events)协议对外发布。

图片

图片

为什么这很重要?

想象一下,你精心设计的自动化工作流不再局限于 n8n 内部使用,而是可以作为服务向任何 MCP 客户端提供能力。这种转变意味着工作流从内部工具升级为可复用的服务组件。

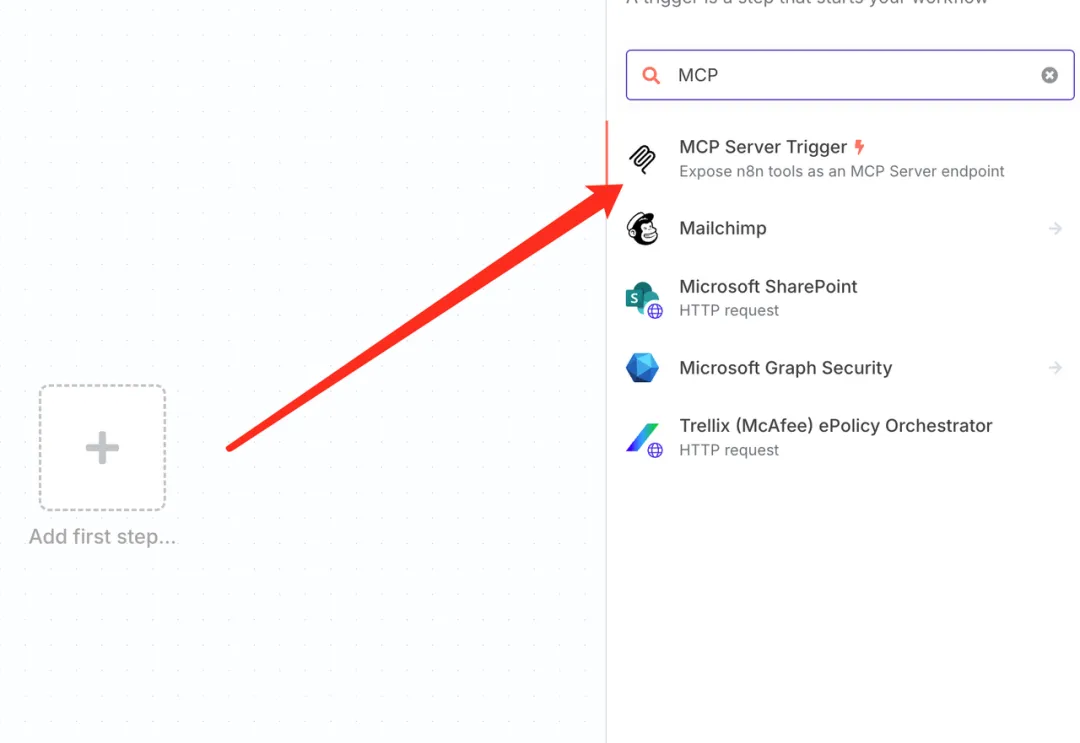

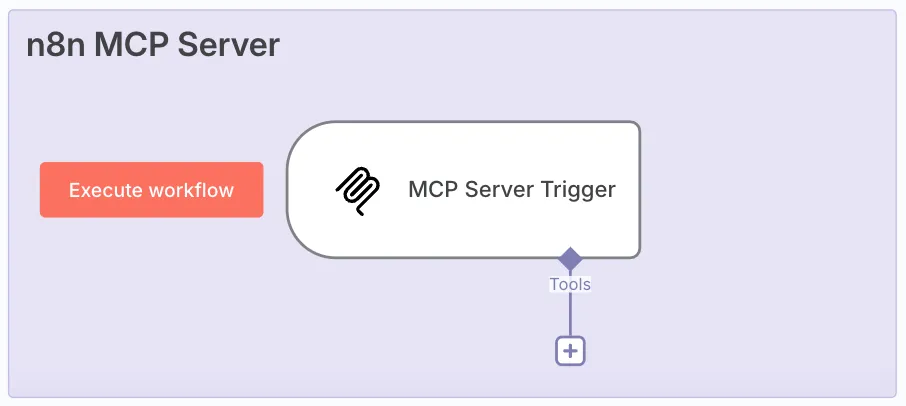

从触发器开始:搭建MCP服务基础架构

核心节点配置

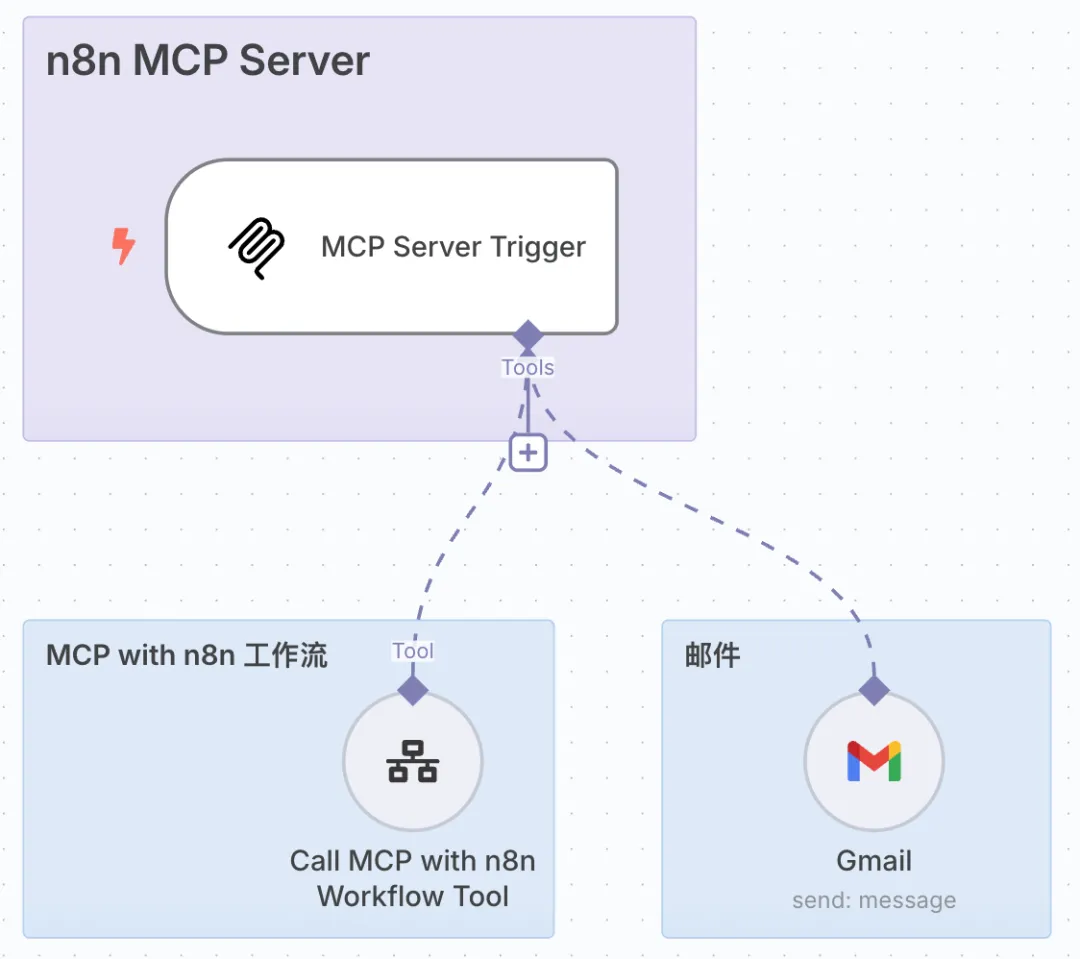

整个 MCP 服务器的构建过程出乎意料地简洁。首先添加一个MCP Server Trigger节点——这就是我们的服务入口点。

图片

图片

打开节点面板,你会发现一个预生成的 SSE 访问地址。这个 URL 就是外部系统调用你服务的通道。为了演示便利,我们暂时禁用身份验证(生产环境中务必启用安全措施)。

图片

图片

构建服务能力矩阵

接下来的步骤体现了 n8n 的模块化哲学。你可以在 MCP Server Trigger 后连接任意数量的工具节点,每个节点都会成为 MCP 服务的一个可调用功能。

图片

图片

我们有两种方式来扩展 MCP 服务的能力:

- 复用现有工作流 - 通过 Call n8n Workflow Tool 节点引入已验证的自动化流程

- 直接添加工具节点 - 将单个功能节点(如 Gmail、Slack 等)直接连接到 MCP 服务器

实战演练:构建多功能MCP服务

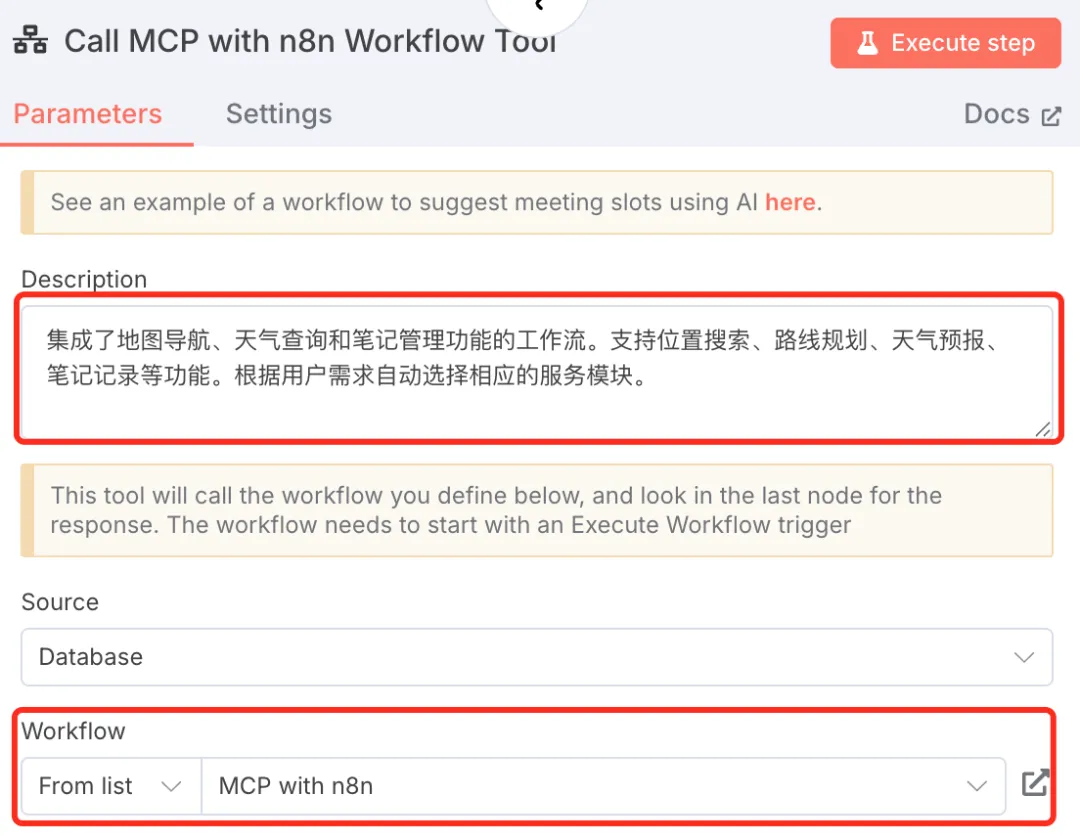

复用现有工作流

既然我们在上一篇文章中已经构建了高德地图查询和 flomo 笔记的工作流,为什么不直接复用这些成果?这就是Call n8n Workflow Tool节点的价值所在。

配置步骤:

- 在 MCP Server Trigger 中 Tools 里,添加 Call n8n Workflow Tool 节点

- 在节点配置中选择要调用的目标工作流

- 设置参数映射,确保MCP请求能正确传递给子工作流

图片

图片

图片

图片

重要技术细节: 被调用的子工作流(如MCP with n8n工作流)必须以 Execute Sub-workflow 触发器开始,而不是其他触发器类型。这是因为它现在扮演的是"工具组件"角色,需要接收外部传入的参数。

图片

图片

工作流能力整合

通过这种混合方式,我们为 MCP 服务构建了三个核心能力:

- 地理位置查询 - 通过 Call n8n Workflow Tool 调用高德地图

- 笔记管理 - 通过 Call n8n Workflow Tool 集成 flomo 笔记服务

- 邮件发送 - 直接添加 Gmail 节点到 MCP Server,采用 AI 自动识别配置

前两个能力复用了我们已有的工作流成果,而邮件功能则是直接在 MCP 服务器中添加 Gmail 工具节点。对于 Gmail 节点,我们将收件人、主题、正文全部设置为 AI 自动识别模式,让 AI Agent 能根据用户输入自动填充邮件内容。

图片

图片

完整服务架构

回到 n8n 画板,我们可以看到最终构建完成的 MCP 服务器架构如下所示:

图片

图片

这个架构清晰地展现了 MCP Server Trigger 作为服务入口,连接着多个工具组件的完整拓扑结构。

AI Agent提示词优化

在 MCP with n8n 子工作流中,AI Agent 的提示词需要精确调整:

复制{{ "Choose proper tool for user input:" + $json.query }}这个看似简单的提示词包含了重要的上下文传递机制。$json.query承载着来自 MCP 客户端的原始请求,AI Agent 据此选择最合适的工具。

服务发布与激活

一键发布流程

MCP 服务的发布过程体现了 n8n "简单即强大"的设计理念。保存工作流后,点击Active按钮将其激活为绿色状态。此时,服务端已准备好接收外部请求。

图片

图片

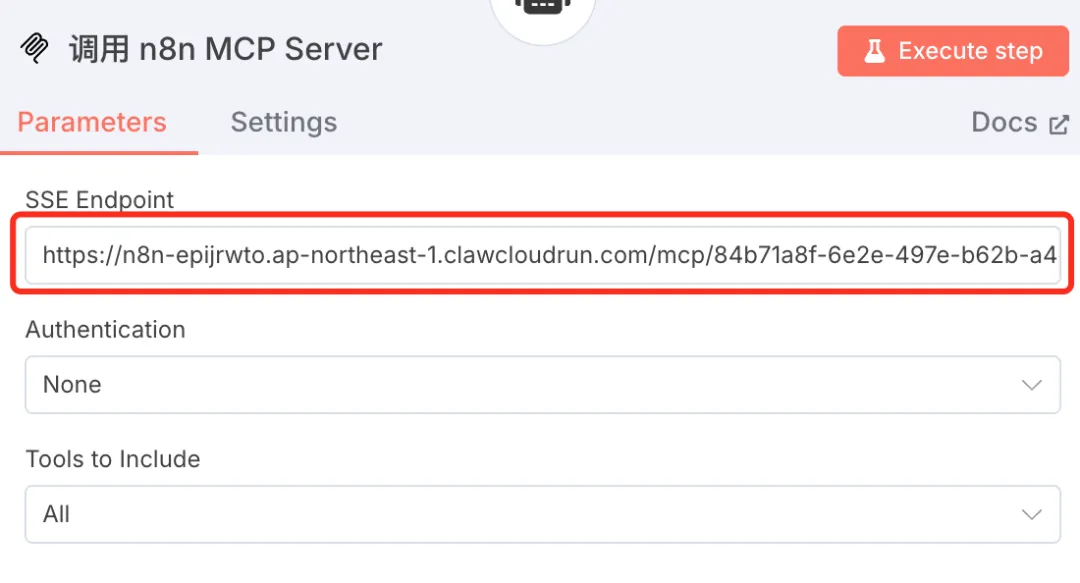

复制 MCP Server Trigger 节点的 Production URL——这就是你的服务访问端点。

客户端连接方案

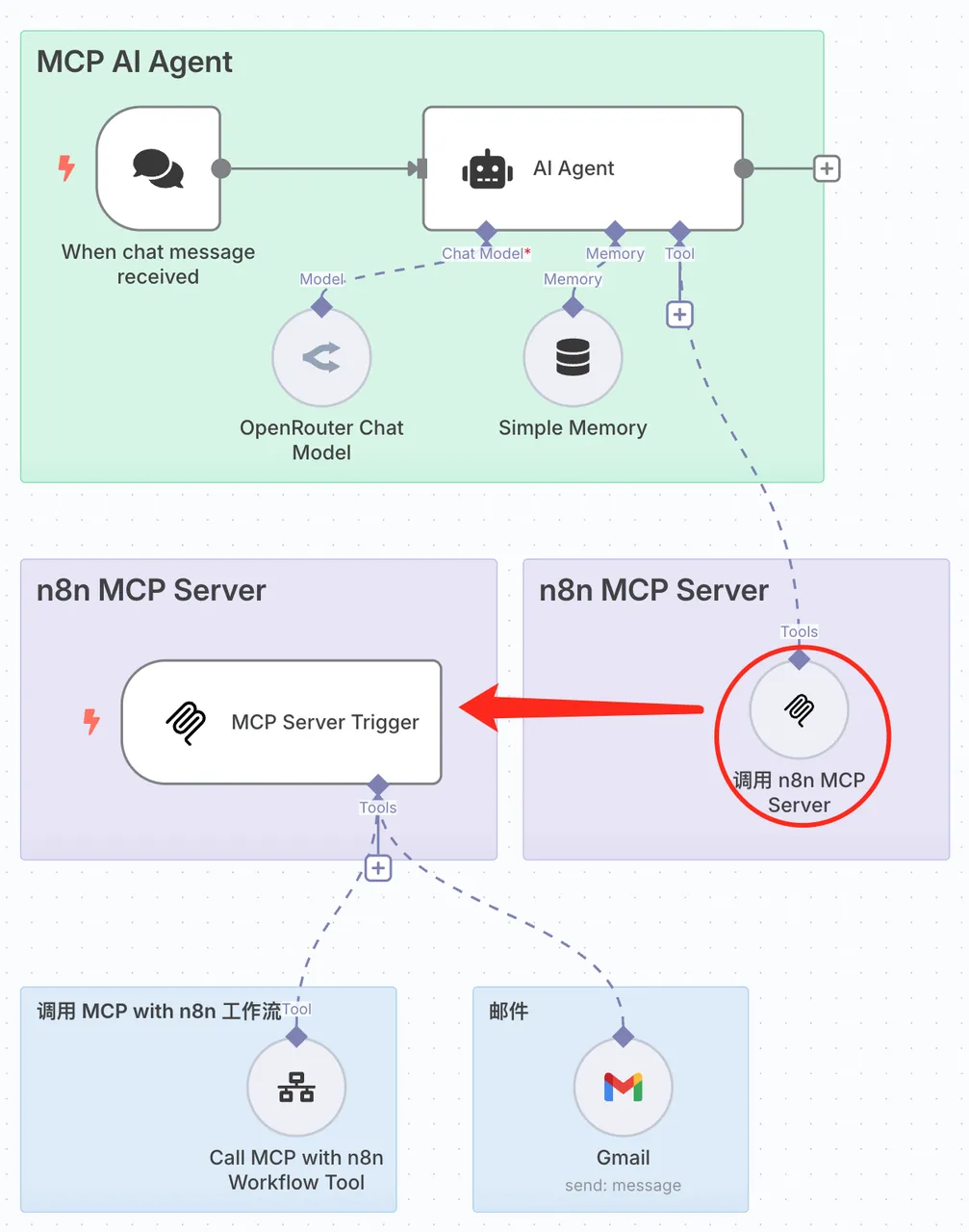

n8n内部调用

最直接的验证方式是在 n8n 内部创建 MCP 客户端。我们可以构建一个 AI Agent,通过 MCP Client Tool 连接刚才创建的服务器。

为了演示方便,我将 MCP AI Agent 和 n8n MCP Server 放在了同一个工作流中。这个 AI Agent 和上一篇文章分享的基本类似,唯一不同的是这里使用的 MCP Client Tool。

图片

图片

MCP Client Tool配置

双击打开 MCP Client Tool 查看配置,可以看到其中的 SSE Endpoint 就是我们刚刚创建的 MCP Server Trigger 提供的 Production URL。

图片

图片

AI Agent系统提示词设置

AI Agent 的系统提示词需要精心设计,让它了解可用的工具能力和使用场景:

复制## Context

- 今天是 {{ $now.format('dd LLL yyyy') }}。

- 当前时间:{{ $now.format('hh:mm a') }} 。

- 你是一个运行在 n8n 工作流中的 AI Agent,拥有多种工具能力

## Available Tools

你可以使用以下工具来帮助用户:

**高德地图工具**:

- 通过专门的工作流提供地理位置查询、路线规划、周边搜索功能

- 提供天气信息查询,包括当前天气和天气预报

- 当用户询问位置、导航、距离、天气等问题时使用

**Flomo 笔记工具**:

- 通过专门的工作流提供笔记记录和管理功能

- 用于记录想法、保存信息、查找历史笔记

- 当用户需要记录笔记时使用

**邮件工具**:

- 直接发送邮件功能

- 当用户需要发送邮件时使用

## Response Guidelines

- 保持回答简短明了,适合语音传递

- 使用简体中文回复

- 不要编造信息,不确定时明确说明

- 根据用户需求选择合适的工具或服务

- 在使用工具前,简要说明你将要做什么同时,我们需要设置 Max Iterations 参数为 10,确保 AI Agent 有足够的迭代次数来完成复杂任务。

图片

图片

执行流程解析

这种设计形成了一个有趣的循环:AI Agent 解析用户指令 → MCP Client 发送请求 → MCP Server 执行工具 → 返回结果给 AI Agent → 转化为自然语言输出。

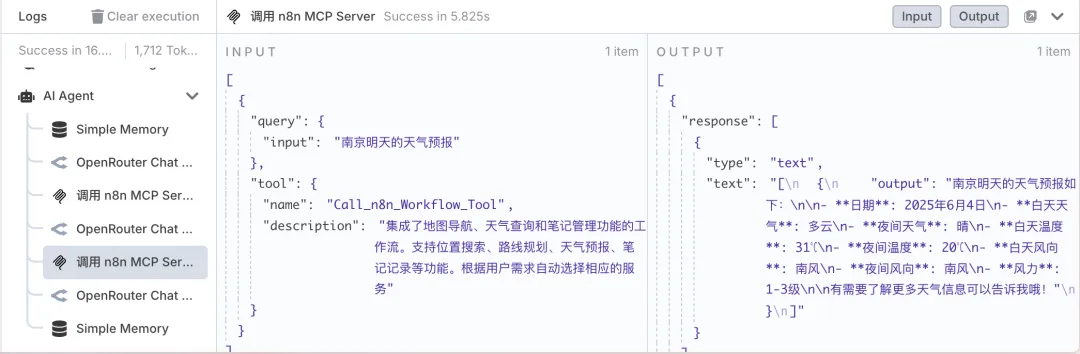

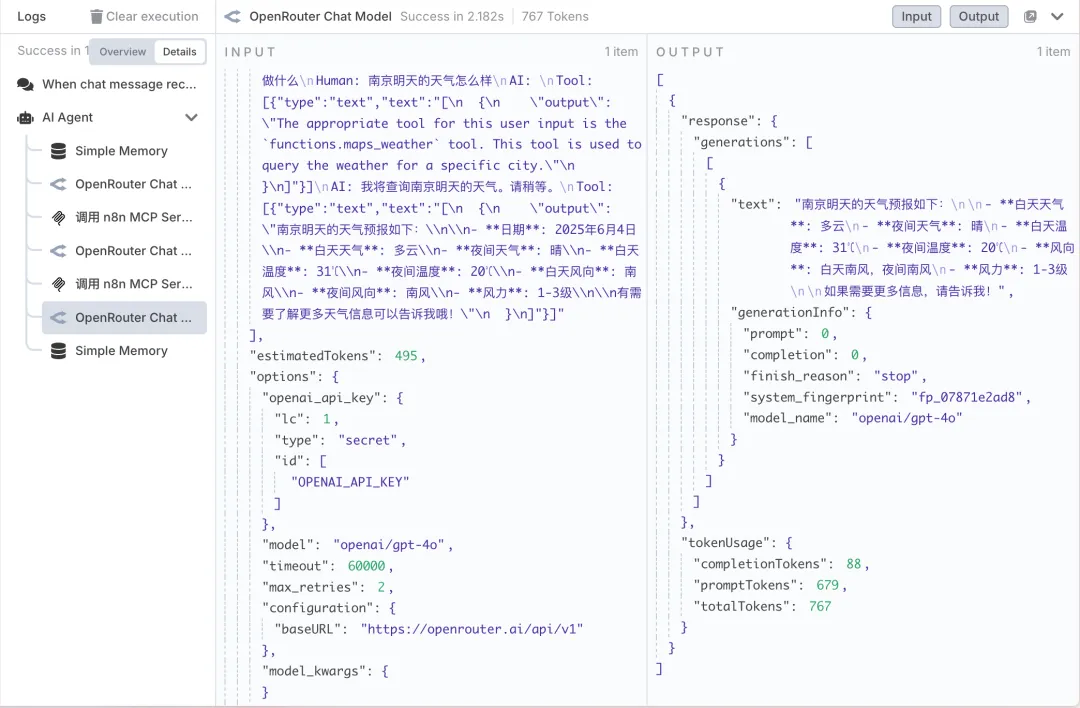

实际执行过程展示

让我们看看这个流程的实际运行效果。当我们输入演示指令后,可以观察到大模型会将我们的自然语言指令智能转化成相应工具的结构化参数,并自动选择最合适的工具组合。

图片

图片

整个执行过程分为几个关键步骤:

- 指令解析 - AI Agent 理解用户意图,识别需要调用的工具

- 参数转化 - 将自然语言转换为工具可接受的结构化参数

- 工具调用 - MCP Client 将请求提交给 MCP Server 执行

- 结果处理 - MCP Server 返回执行结果

- 自然语言输出 - AI Agent 将技术性的返回结果转化为易懂的自然语言呈现给用户

图片

图片

整个流程在 n8n 环境内完成,但通过 MCP 协议实现了清晰的职责分离。用户只需要用自然语言表达需求,剩下的技术细节全部由系统自动处理。

外部系统集成

Claude Desktop配置

对于 Claude Desktop 用户,配置文件如下:

复制{

"mcpServers": {

"n8n": {

"command": "npx",

"args": [

"-y",

"supergateway",

"--sse",

"YOUR_SSE_URL_HERE"

]

}

}

}

Cherry Studio快速接入

Cherry Studio 提供了更直观的配置界面。在 MCP 服务器配置中添加你的 SSE 端点,即可立即使用所有工作流功能。

架构优势分析

服务化转型

MCP Server Trigger 的出现标志着 n8n 从"工作流平台"向"服务化平台"的进化。你的自动化逻辑不再是孤立的脚本,而是可复用的服务组件。

生态系统扩展

这种架构设计打破了平台边界。无论是 Claude、Cherry Studio,还是任何支持 MCP 协议的客户端,都能无缝调用你的 n8n 服务。这种互操作性为企业级集成提供了无限可能。

写在最后

MCP Server Trigger 和 MCP Client Tool 的组合拳,让 n8n 工作流具备了前所未有的灵活性。这不仅简化了外部程序调用 n8n 工具的复杂度,更为构建分布式自动化生态奠定了基础。

当工作流变成服务,当自动化成为基础设施,我们正在见证一个新时代的到来——每个人都能构建和分享自己的 AI 工具箱。