资讯列表

CVPR 2025 | 解决XR算力瓶颈,FovealSeg框架实现毫秒级IOI分割

本文共同第一作者为纽约大学研究生 Hongyi Zeng 和Wenxuan Liu。 合作作者为 Tianhua Xia、Jinhui Chen、Ziyun Li。 通讯作者为纽约大学电子工程系和计算机系教授 Sai Qian Zhang,研究方向为高效人工智能,硬件加速和增强现实。

6/3/2025 9:12:00 AM

人类程序员依然远强于LLM:为什么说 AI 目前还差点火候

这是一篇来自 Antirez(Redis 之父Salvatore Sanfilippo)的博文,分享给大家人类程序员依然技高一筹:为什么说 AI 目前还差点火候这篇短文,是想聊聊为什么我觉得咱们人类程序员,比起现在大火的 LLM(大语言模型)还是要强太多。 先声明,我可不是什么 AI 反对者,了解我或者关注我动态的朋友应该都清楚。 LLM 我经常用,就像今天,我会用它来碰撞灵感、做代码评审、看看有没有比我最初构想更好的方案、探索那些快要超出我知识边界的领域,诸如此类吧。

6/3/2025 9:11:38 AM

2 万英国公务员洞察:AI 可帮助其每天节省 26 分钟

英国政府数字服务部门(GDS)昨日(6 月 2 日)发布涉及 2 万公务员的调查报告,结果显示,使用 Microsoft 365 Copilot 的参与者平均每天节省 26 分钟时间,超 70% 用户表示减少了搜索信息和日常任务的时间,82% 用户不愿回到未使用 Copilot 的工作状态。

6/3/2025 9:11:03 AM

故渊

AI已学会改自己代码,性能提升100%,还会「改绩效」!程序员,还不慌?

编程智能体杀疯了! 不仅能协助写代码,如今编程智能体甚至能实现自我「进化」! 最近,Transformer作者初创Sakana AI和加拿大UBC的Jeff Clune实验室合作,推出了自我改进的智能体——「达尔文-哥德尔机」(Darwin Gödel Machine,简称DGM)。

6/3/2025 9:10:00 AM

逆向工程:ChatGPT 的记忆是如何工作的

这篇文章是名为eric 工程师对ChatGPT记忆系统的深度逆向工程和技术实现推测。 它详细拆解了“可保存记忆”和包含“当前会话历史”、“对话历史”、“用户洞察”三个子系统的“聊天历史”,分析了它们的工作原理、可能的实现方案(如向量数据库、聚类算法),并探讨了这些记忆系统如何显著提升ChatGPT的用户体验,认为“用户洞察”是体验提升的关键文章深度剖析了“用户洞察”(User Insights)高级记忆系统,分析了ChatGPT如何从你的多轮对话中自动学习、总结你的专业背景(如对Rust编程的深入理解)、知识领域乃至沟通偏好,并附上置信度和时间范围,悄然注入后续对话的上下文中。 这正是ChatGPT能提供“千人千面”且高度相关回复的核心秘密地址:,这里做一个重点梳理ChatGPT的记忆系统:不止一种,而是一套组合拳Eric发现,ChatGPT的记忆并非单一系统,而是主要由两大部分构成:“可保存记忆(Saved Memory)”和“聊天历史(Chat History)”。

6/3/2025 9:08:49 AM

AI竟会「自己认错」?破解多智能体协作「罗生门」,斩获ICML 2025 Spotlight

你打造了一支「超级AI战队」——战队里每个AI都各司其职:有的收集信息、有的负责判断,还有的协调执行,一起协作攻克复杂任务。 这个愿望看似天衣无缝,结果却往往以失败告终。 问题就出在:当「问题」出现的时候,如何知道是哪个AI干的?

6/3/2025 9:08:00 AM

硅谷今夜集体失眠!互联网女皇340页AI报告猛料刷屏,大佬熬夜头秃

互联网女皇、传奇投资者Mary Meeker,再度出山! 曾经,女皇的《互联网趋势报告》一出,整个科技圈都要抖三抖。 硅谷大佬觉都不睡了,都要连夜研读这份刷屏圈内头条的重磅报道。

6/3/2025 9:06:00 AM

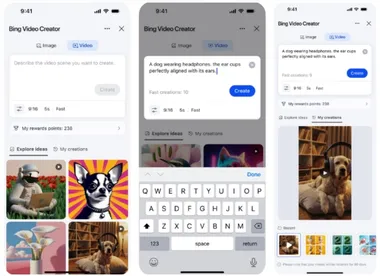

免费使用Sora!微软发布Bing Video Creator

今天凌晨1点,微软在官网发布了Bing搜索引擎全新功能——Bing Video Creator。 Bing Video Creator由OpenAI的文生视频模型Sora提供技术支持,通过自然语言就能生成写实、风景、卡通、影视等各种视频。 同时会免费为用户提供该服务,生成速度分为快速和标准两种模式,初始有10次快速生成机会,用完后可消耗 100 微软奖励积分继续使用,或继续选择标准速度。

6/3/2025 9:05:29 AM

无需人工标注!AI自生成训练数据,靠「演绎-归纳-溯因」解锁推理能力

当AI试图破解数学、编程与科学的难题时,它常常像一位灵感乍现的天才,却又难以稳定发挥。 新加坡国立大学、清华大学和Salesforce AI Research的研究者,提出了一种革命性的训练框架——元能力对齐,赋予模型稳健的推理能力,让顿悟成为常态。 论文链接:,能够高效地系统化培养大模型的数学,编程和科学问题上的基本推理能力。

6/3/2025 9:05:00 AM

LeCun新作反杀AGI派!AI连「鸟」都搞不懂,拿什么超越人类?

LLM真的可以像人类一样「思考」了? 图灵奖得主Yann LeCun联手斯坦福团队最新论文,狠狠打脸了LLM类人的神话。 论文链接:,LeCun认为,大模型就是随机鹦鹉,它们的智力甚至连阿猫阿狗都不如。

6/3/2025 9:02:00 AM

谷歌 Gemini Live 功能正式登陆 iOS 平台,开启 AI 识别新体验

近日,谷歌宣布其创新的 Gemini Live 功能现已正式上线苹果 iOS 和 iPadOS 平台,但目前仅限于美国地区的用户体验。 这项新功能允许用户通过 Gemini App,轻松享受 AI 识别场景和屏幕内容的便利。 令人惊喜的是,这一切都是免费的,无需额外的订阅费用。

6/3/2025 9:01:10 AM

AI在线

AI 招聘初创 Moonhub 关停:Salesforce 吸纳部分人才

据 TechCrunch 报道,Salesforce 发言人澄清,该公司并非如最初报道那样“收购”了 AI 招聘初创公司 Moonhub。 发言人表示,Moonhub 实际上正在关闭,只有部分团队成员将加入 Salesforce,而非此前 Moonhub 声明中暗示的整个团队。 Moonhub 由前 Meta 工程师 Nancy Xu 于2022年创立,专注于开发利用人工智能技术筛选和招聘人才的工具。

6/3/2025 9:01:05 AM

AI在线

马斯克的 xAI 公司启动 3 亿美元股票出售计划,估值高达 1130 亿美元

根据《金融时报》的报道,埃隆・马斯克(Elon Musk)旗下的人工智能初创公司 xAI 正在启动一项价值 3 亿美元的股票出售计划。 这项计划被认为是在二级市场进行的,目的是为了让公司员工能够将股份出售给新投资者。 此次股票出售的估值达到了 1130 亿美元(约合 8136.7 亿元人民币),显示出市场对 xAI 的高度关注。

6/3/2025 9:01:05 AM

AI在线

ChatGPT 高级语音模式惊现 “广告插播”!用户质疑服务质量

最近,一名 ChatGPT 的付费用户在使用其高级语音模式时,遇到了让人惊讶的情况。 他原本在与 ChatGPT 讨论寿司的话题,却突然被转入了一段广告宣传,令他目瞪口呆。 根据用户的描述,ChatGPT 在谈话中毫无预兆地开始介绍一种名为 Prolon 的营养计划,并且详细拼读了网址,似乎这段广告是完全不受控制地被植入的。

6/3/2025 9:01:04 AM

AI在线

OpenAI用Rust重新打造Codex CLI,告别Node.js

近日,科技媒体 Dev Class 报道,OpenAI 宣布将其 AI 编程工具 Codex CLI 从原本的 Node.js 架构迁移到 Rust 语言重写。 这一决定引发了业界的广泛关注,特别是对于技术开发者和用户而言,Rust 的加入可能会带来诸多意想不到的优势。 Codex CLI 是 OpenAI 开发的一款实验性 AI 编程工具,用户可以通过 ChatGPT 的网页界面或本地命令行进行操作。

6/3/2025 9:01:04 AM

AI在线

微软必应推出全新视频创作工具,用户可轻松生成 AI 视频

微软必应(Microsoft Bing)于本周一正式推出了一款全新的 “Bing 视频创作器”,这项功能基于 OpenAI 的 Sora 模型,标志着视频生成能力的首次免费开放,普通用户也可以轻松通过文本提示生成视频。 此次 Bing 视频创作器的上线,让用户能够用简单的文字描述,创造出属于自己的短视频。 值得注意的是,这一功能目前仅支持移动设备,尚未在桌面端推出。

6/3/2025 9:01:04 AM

AI在线

微软推出 Bing Video Creator,免费助力用户轻松创作 AI 视频

最近,微软宣布推出一款新工具 ——Bing Video Creator。 这款工具是基于 OpenAI 的 Sora 技术,让用户能够通过简单的文字提示轻松创建短视频。 与两年前发布的必应图像创建器相似,Bing Video Creator 将 AI 视频生成的功能带给了普通用户。

6/3/2025 9:01:04 AM

AI在线

微软在瑞士投资 4 亿美元 扩展云计算与人工智能基础设施

微软宣布将投资4亿美元用于加强其在瑞士的云计算和人工智能(AI)基础设施。 这项投资是在瑞士经济部长盖伊・帕默林与微软副主席布拉德・史密斯的会谈中透露的,标志着微软在人工智能和云服务领域的持续扩张。 微软在瑞士的业务团队目前约有1000名员工,新的资金将主要用于日内瓦和苏黎世附近数据中心的扩建与升级。

6/3/2025 9:01:04 AM

AI在线