理论

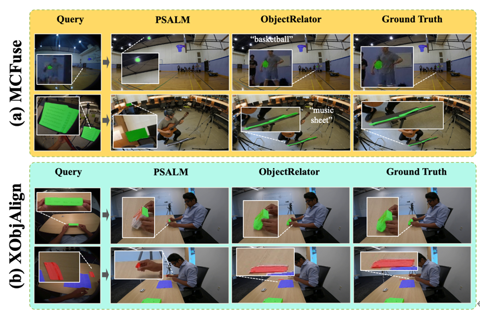

ICCV 2025 Highlight | ObjectRelator: 打破视角次元壁,让AI拥有第一人称与第三人称的“通感”

在人类技能习得过程中,需要在两个视角之间进行流畅的转换。 我们在观看别人的演示过程时,会尝试在脑海中想象自己进行这些操作的场景。 然而这一跨视角理解的能力对于计算机和机器人来说却是一个巨大的挑战,制约着机器人学习、VR 交互等关键领域的发展。

10/12/2025 12:34:00 PM

新闻助手

读万卷书,大模型就能「看」懂视觉世界?Meta揭秘LLM视觉先验的起源

一个只见过文本的大语言模型(LLM),在从未直接看过图像的情况下,竟然能学到可迁移到视觉任务的先验能力 —— 这是 Meta Superintelligence Labs 与牛津团队新论文的发现。 近日,Meta 超级智能实验室(Meta Superintelligence Labs)与牛津大学的研究者发布了一篇长达 33 页的重磅论文,通过超过 100 组受控实验、耗费 50 万 GPU 小时的庞大研究,系统性地揭开了 LLM 视觉先验的来源。 作者提出,视觉先验可分为「推理先验」和「感知先验」,并给出了一套预训练的数据混合配方,用于在只用文本预训练阶段就「播下」视觉能力的种子。

10/11/2025 6:05:23 PM

超越ZIP的无损压缩来了!华盛顿大学让大模型成为无损文本压缩器

当大语言模型生成海量数据时,数据存储的难题也随之而来。 对此,华盛顿大学(UW)SyFI实验室的研究者们提出了一个创新的解决方案:LLMc,即利用大型语言模型自身进行无损文本压缩的引擎。 基准测试结果表明,无论是在维基百科、小说文本还是科学摘要等多种数据集上,LLMc的压缩率都优于传统的压缩工具(如ZIP和LZMA)。

10/11/2025 6:05:23 PM

库克虎口夺食:马斯克盯上的北大校友AI公司被苹果抢走

好家伙,库克一个箭步,从马斯克手里截胡了一家AI公司。 他俩争抢的主角是Prompt AI,一家成立于2023年,专注于CV的初创公司。 其联创之一,是从北大计算机科学毕业的Tete Xiao。

10/11/2025 6:05:23 PM

微调已死?Agentic上下文工程登场,无需微调实现模型进化

是什么,让一位 AI 自动化架构师发出了「微调已死」的感慨? 一篇来自斯坦福大学、SambaNova、UC 伯克利的论文近日引发了广泛讨论。 他们提出了一种名为 Agentic Context Engineering(智能体 / 主动式上下文工程)的技术,让语言模型无需微调也能实现自我提升!

10/11/2025 6:05:23 PM

告别“提示词魔咒”?通义千问发布Qwen3-VL官方指南,手把手教你调用最强视觉模型

编辑 | 听雨出品 | 51CTO技术栈(微信号:blog51cto)就在今天,通义千问发布了Qwen3-VL官方指南,并将其称为“Cookbooks”烹饪书。 图片这本“烹饪书”可谓让用户告别“魔咒”。 因为对于强大的AI模型,尤其是多模态模型,我们常常需要反复尝试、精心设计非常复杂和精确的指令(即“提示词”),才能让模型输出理想的结果。

10/11/2025 4:10:59 PM

听雨

“现阶段就差数据了”Figure 03登《时代》最佳发明榜封面,CEO放话了

刚发布第三代机器人Figure 03、收获全网关注的Figure,很快又因CEO的言论再度引发热议? 事情是这样婶儿的……有网友发推文表示:Figure CEO Brett Adcock最近接受了《时代》采访,《时代》称Figure 03仍存在重大问题,尚未适用于日常工作。 当被问及还需要什么时,Brett回答:数据。

10/11/2025 3:55:41 PM

UC伯克利大牛预警:留给人类能干的活,只剩5年了!

折衣、做饭、拖地,五年后可能都不用你亲自动手! UC伯克利教授、机器人顶级专家Sergey Levine预言:2030年前,机器人就能像家政阿姨一样,独立打理整个家庭。 这不是炫技演示,而是「自我进化飞轮」即将启动的信号。

10/11/2025 3:55:08 PM

陶哲轩用GPT5-Pro跨界挑战!3年无解的难题,11分钟出完整证明

陶哲轩与GPT-5 Pro这对搭档再大发神威,解决了一个3年无人解决的难题。 而且是“不太在自己专业范围内”的问题:微分几何领域的开放问题。 要知道,陶哲轩擅长的分析、数论、组合学等研究的往往是整数、函数、算子的性质。

10/11/2025 3:44:23 PM

77岁「AI教父」Hinton:AI早有意识!我们打造的智能,可能终结人类文明

当大家热议AI算力与应用之时,「AI教父」Hinton猛地扯回「何为人」的原点。 几十年来,Hinton像一位耐心的炼金术士,致力于将模仿大脑运作的理论,锻造成驱动现代AI的强大引擎。 然而,这位创造者如今却站在了自己创造物的阴影之下,发出了沉重的警告。

10/11/2025 3:38:01 PM

Anthropic 最新研究:仅需250份恶意文档,大模型即可被攻陷,无关参数规模

2025年10月8日,英国AI安全研究院、Anthropic、艾伦·图灵研究所与牛津大学OATML实验室等机构联合发布的一项研究,打破了业界关于“大模型越大越安全”的核心假设。 这项研究题为《Poisoning Attacks on LLMs Require a Near-constant Number of Poison Samples》,论文发表于arXiv。 研究团队发现,只需约250个恶意文档,就足以在任意规模的大语言模型(LLM)中植入可触发的后门(Backdoor)。

10/11/2025 3:18:35 PM

熬死5家初创公司老鸟揭露业内残酷真相:70%的Agent产品系OpenAI套壳,没有上下文和工具,智能体就是笨蛋!无限记忆是陷阱

编辑 | 云昭出品 | 51CTO技术栈(微信号:blog51cto). 先坦白一件事:AI Agent 不是魔法。 它们脆弱、多变,更像是喝了咖啡的实习生,而不是能独立完成任务的员工。

10/11/2025 2:04:09 PM

云昭

Vision-Zero:零数据VLM自我进化!陈怡然团队提出零监督训练新范式

本文作者包括来自杜克大学的汪勤思、林阅千、李海教授、陈怡然教授,新加坡国立大学的刘博,马里兰大学的周天翼教授,和 Adobe 的研究员施靖、万锟、赵文天。 开源代码&模型:::,但训练过度依赖人工标注的数据与精心设计的强化学习奖励。 这种依赖带来数据稀缺问题:多模态标注成本高昂,限制了训练数据的规模与多样性。

10/11/2025 1:51:21 PM

刚刚,全球首个GB300巨兽救场!一年烧光70亿,OpenAI内斗GPU惨烈

过去一年,OpenAI在算力上斥资70亿美元。 其中,大模型研发占了最大头——50亿美元,而推理计算仅用了20亿美元。 图片可见,LLM训练正吞噬无尽的算力,这也是OpenAI最近一直在大举扩展超算建设与合作的重要原因。

10/11/2025 10:34:49 AM

新智元

蚂蚁新发万亿开源旗舰大模型,究竟有多强?

国产大模型最近真是百花齐放啊,卷到家了。 这不,蚂蚁最近也发布了他的万亿级开源大模型 Ling 1T,把大模型的数量级又拉升到了新的高度。 那这个大模型到底好不好用呢?

10/11/2025 10:04:00 AM

磊哥

别再给大模型打鸡血,先救救被“智能体”三个字忽悠的预算

“兄弟,我们老板昨天看完路演,拍桌子要上Agent,说三个月让客服成本归零。 ”“归零? 他以为Agent是灭霸,打个响指预算就蒸发?

10/11/2025 9:40:11 AM

大数据AI智能圈

AI 智能体写代码靠谱吗?GitHub 上 567 个 PR 的实证告诉你真相

大家好,我是肆〇柒。 近期 AI 编程工具如 Claude Code 越来越火,但很多人心里打鼓:AI 自动生成的代码真能被开源项目接受吗? 会不会全是“花架子”?

10/11/2025 9:35:05 AM

肆零柒

RLPT:用强化学习“重读”预训练数据,让大模型学会思考

大家好,我是肆〇柒。 今天要和大家分享的是一项来自腾讯大模型部门(LLM Department, Tencent) 与香港中文大学合作的前沿研究——RLPT(Reinforcement Learning on Pre-Training Data)。 面对高质量数据增长见顶、计算资源持续膨胀的矛盾,这项工作提出了一种全新的训练范式:让大模型在原始预训练数据上通过强化学习自主探索推理路径,从而突破传统监督学习的泛化瓶颈。

10/11/2025 9:23:28 AM

肆零柒

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

AI模型

特斯拉

场景

深度学习

亚马逊

架构

Transformer

MCP

Copilot

编程

视觉