工程

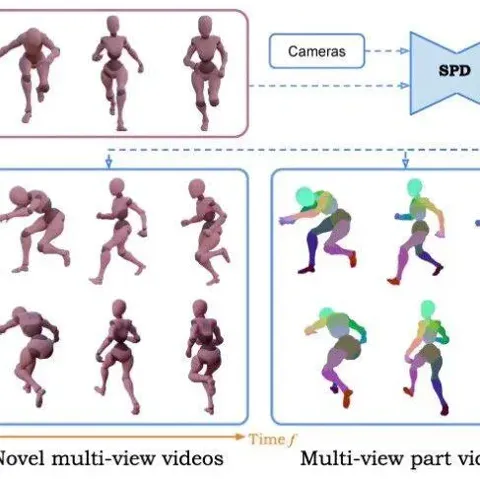

用2D数据解锁3D世界:首个面向运动学部件分解的多视角视频扩散框架

张昊,伊利诺伊大学香槟分校(UIUC)博士生,研究方向涵盖 3D/4D 重建、生成建模与物理驱动动画。 目前在 Snap Inc. 担任研究实习生,曾于 Stability AI 和 上海人工智能实验室实习。

9/22/2025 6:40:00 PM

机器之心

LeCun力荐的JEPA杀入LLM,用CV的思路训练LLM,性能鲁棒性双丰收

LeCun 这次不是批评 LLM,而是亲自改造。 当前 LLM 的训练(包括预训练、微调和评估)主要依赖于在「输入空间」进行重构与生成,例如预测下一个词。 而在 CV 领域,基于「嵌入空间」的训练目标,如联合嵌入预测架构(JEPA),已被证明远优于在输入空间操作的同类方法。

9/22/2025 3:53:00 PM

机器之心

加速近5倍!北大与字节团队提出BranchGRPO,用「树形分叉 + 剪枝」重塑扩散模型对齐

快分叉与稳收敛在扩散 / 流匹配模型的人类偏好对齐中,实现高效采样与稳定优化的统一,一直是一个重大挑战。 近期,北京大学与字节团队提出了名为 BranchGRPO 的新型树形强化学习方法。 不同于顺序展开的 DanceGRPO,BranchGRPO 通过在扩散反演过程中引入分叉(branching)与剪枝(pruning),让多个轨迹共享前缀、在中间步骤分裂,并通过逐层奖励融合实现稠密反馈。

9/22/2025 3:45:00 PM

机器之心

工业级3D世界构建提速90倍!全新框架LatticeWorld让虚拟世界「一句话成真」

本文的作者来自网易、香港城市大学、北京航空航天大学和清华大学等机构。 本文的共同第一作者为网易互娱段颖琳、北京航空航天大学邹征夏、网易互娱谷统伟。 本文的通讯作者为香港城市大学邱爽、网易互娱陈康。

9/21/2025 6:25:00 PM

机器之心

集合通信库VCCL释放GPU极致算力,创智、基流、智谱、联通、北航、清华、东南重磅开源

计算速度与系统稳定性的双重挑战,正推动 AI 基础设施向新一代集合通信技术迈进。 在人工智能迅猛发展的今天,超大规模智算集群已成为推动技术突破的核心基础设施。 海外科技巨头纷纷布局,OpenAI 与甲骨文和软银正在推进「星际之门」项目,计划配备数百万个 GPU,预计耗资超千亿美元;微软、谷歌、xAI 陆续完成十万卡集群交付使用。

9/21/2025 6:11:00 PM

机器之心

Mini-Omni-Reasoner:实时推理,定义下一代端到端对话模型

本文第一作者谢之非,共同第一作者马子阳皆是来自于南洋理工大学的博士生。 通讯作者为新加坡国立大学特聘教授颜水成和南洋理工大学数据与科学系校长讲席教授苗春燕。 共同作者为腾讯AI首席专家叶德珩和新加坡国立大学博士后研究员廖越。

9/20/2025 2:47:00 PM

机器之心

攻克大模型训推差异难题,蚂蚁开源新一代推理模型Ring-flash-2.0

“MoE Long-CoT(长思维链) RL(强化学习)” 这条技术路线存在难以兼顾训练稳定性和效果的难题。 9 月 19 日,蚂蚁百灵大模型团队把 “难啃的骨头” 直接做成开源礼包 ——Ring-flash-2.0。 100B 总参、6.1B 激活,数学 AIME25 拿下 86.98 分,CodeForces elo 分数 90.23,128K 上下文实测 200 token/s。

9/19/2025 7:06:00 PM

机器之心

给大模型「精准手术」:美团智能客服提出逆向学习技术精准纠偏,风险控制提升38%

美团智能客服最新研究,提出了一种逆向学习新技术(简称 “逆学习”),能像 “精准手术” 一样,安全、高效地抑制模型中的特定错误和风险行为,在关键风险控制指标上提升 38 个百分点以上的同时,保障整体服务效果不下降,有效提升用户体验。 ”背景:智能客服场景下的数据回流方案美团智能客服采用的端到端大模型智能体,结合数据回流机制,构建了一套从线上服务中自动收集、筛选并利用真实对话数据的闭环优化方案。 该方案能够持续从用户交互中挖掘优质应答样本(Good Case)与问题样本(Bad Case),显著提升了模型的指令遵循能力、表达自然度和复杂状态推理性能,在多项业务场景中实现了综合问题解决率的有效增长。

9/19/2025 6:59:00 PM

机器之心

腾讯AI Lab首创RL框架Parallel-R1,教大模型学会「并行思维」

自从 Google Gemini 将数学奥赛的成功部分归功于「并行思维」后,如何让大模型掌握这种并行探索多种推理路径的能力,成为了学界关注的焦点。 然而,现有方法多依赖于监督微调(SFT),模型一来只能模仿预先构造的 parallel thinking 数据,难以泛化到真实的复杂任务中,其次这种方式对数据要求很高,往往需要复杂的 data pipeline 来构造。 为解决这些难题,来自腾讯 AI Lab 西雅图、马里兰大学、卡内基梅隆大学、北卡教堂山分校、香港城市大学、圣路易斯华盛顿大学等机构的研究者们(第一作者郑童是马里兰大学博士生,本工作于其在腾讯 AI Lab 西雅图实习期间完成)首创了 Parallel-R1 框架 —— 这是第一个通过强化学习(RL)在通用数学推理任务上教会大模型进行并行思维的框架。

9/17/2025 5:49:00 PM

机器之心

谁说Scaling Law到头了?新研究:每一步的微小提升会带来指数级增长

很多人认为,Scaling Law 正在面临收益递减,因此继续扩大计算规模训练模型的做法正在被质疑。 最近的观察给出了不一样的结论。 研究发现,哪怕模型在「单步任务」上的准确率提升越来越慢,这些小小的进步叠加起来,也能让模型完成的任务长度实现「指数级增长」,而这一点可能在现实中更有经济价值。

9/16/2025 1:24:00 PM

机器之心

从少样本到千样本!MachineLearningLM给大模型上下文学习装上「机器学习引擎」

尽管大型语言模型(LLM)拥有广泛的世界知识和强大的推理能力,被广泛视为优秀的少样本学习者,但在处理需要大量示例的上下文学习(ICL)时仍存在明显局限。 已有工作表明,即使提供多达上百甚至上千条示例,LLM 仍难以从中有效学习规律,其表现往往很快进入平台期,甚至对示例的顺序、标签偏差等较为敏感。 在利用上下文学习解决新任务时,LLM 往往更依赖于自身的强先验以及示例的表面特征,而难以真正挖掘出示例中潜在的因果机制或统计依赖。

9/16/2025 1:19:00 PM

机器之心

多模态BUG修复新SOTA:慕尼黑工大GUIRepair登上SWE-bench Multimodal榜单第一

自动化修复真实世界的软件缺陷问题是自动化程序修复研究社区的长期目标。 然而,如何自动化解决视觉软件缺陷仍然是一个尚未充分探索的领域。 最近,随着 SWE-bench 团队发布最新的多模态 Issue 修复基准 SWE-bench Multimodal,多模态问题修复引起了研究人员的广泛关注,如何有效的解决这类多模态问题对现有的修复系统呈现出关键挑战。

9/16/2025 10:15:00 AM

机器之心

OpenVision 2:大道至简的生成式预训练视觉编码器

本文来自加州大学圣克鲁兹分校(UCSC)、苹果公司(Apple)与加州大学伯克利分校(UCB)的合作研究。 第一作者刘彦青,本科毕业于浙江大学,现为UCSC博士生,研究方向包括多模态理解、视觉-语言预训练与视觉基础模型。 其余作者包括李先航(UCSC)、张乐天(USCS)、王子瑞(Apple)、郑泽宇(UCB)、周郁音(UCSC)。

9/15/2025 8:39:00 PM

机器之心

告别ROS的繁琐, 易用易学的机器人学习系统: 华为诺亚面向机器人学习的开源Python框架

近年来,机器人技术在硬件领域取得了显著突破 —— 无论是 DARPA 机器人挑战赛,还是首届人形机器人自由搏击表演,都展示了令人瞩目的进展。 然而,机器人的自主能力仍明显落后于机器学习的发展步伐。 造成这一差距的关键瓶颈在于软件层面:现有的机器人技术栈学习门槛较高,仍大量依赖 C/C 进行底层开发,工具链分散且硬件集成复杂。

9/15/2025 12:55:00 PM

机器之心

将KV Cache预算降至1.5%!他们用进化算法把大模型内存占用砍下来了

只用 1.5% 的内存预算,性能就能超越使用完整 KV cache 的模型,这意味着大语言模型的推理成本可以大幅降低。 EvolKV 的这一突破为实际部署中的内存优化提供了全新思路。 图源:(KV cache)已经成为大模型快速运行的核心技术,它就像一个「记忆库」,能够保存之前计算过的结果并重复使用,这样就不用每次都重新计算同样的内容。

9/14/2025 1:48:00 PM

机器之心

LLaSO 横空出世:逻辑智能推出全球首个完全开源语音大模型框架,定义 LSLM 研究新基准

在大型语言模型(LLM)的浪潮下,多模态 AI 取得了飞速发展,尤其是在视觉语言(LVLM)领域,已经形成了成熟的研究范式。 然而,与之形成鲜明对比的是,大型语音语言模型(LSLM)的发展却显得零散且步调缓慢。 该领域长期被碎片化的架构、不透明的训练数据和缺失的评估标准所困扰,导致研究之间难以进行公平比较,严重阻碍了技术的可复现性和社区的系统性进步。

9/14/2025 1:42:00 PM

机器之心

小红书智创音频技术团队:SOTA对话生成模型FireRedTTS-2来了,轻松做出AI播客!

小红书智创音频技术团队近日发布新一代对话合成模型 FireRedTTS-2。 该模型聚焦现有方案的痛点:灵活性差、发音错误多、说话人切换不稳、韵律不自然等问题,通过升级离散语音编码器与文本语音合成模型全面优化合成效果。 在多项主客观测评中,FireRedTTS-2 均达到行业领先水平,为多说话人对话合成提供了更优解决方案。

9/14/2025 1:29:00 PM

机器之心

大模型碰到真难题了,测了500道,o3 Pro仅通过15%

基准测试是检验大模型能力的一种方式,一般而言,一个有用的基准既要足够难,又要贴近现实:问题既能挑战前沿模型,又要反映真实世界的使用场景。 然而,现有测试面临着「难度–真实性」的矛盾:侧重于考试的基准往往被人为设置得很难,但实际价值有限;而基于真实用户交互的基准又往往偏向于简单的高频问题。 在此背景下,来自斯坦福大学、华盛顿大学等机构的研究者探索了一种截然不同的方式:在未解决的问题上评估模型的能力。

9/14/2025 1:23:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

大模型

机器人

数据

Midjourney

AI新词

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

马斯克

Gemini

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

AI for Science

Agent

苹果

Claude

芯片

腾讯

Stable Diffusion

蛋白质

开发者

xAI

具身智能

生成式

神经网络

机器学习

3D

人形机器人

RAG

AI视频

大语言模型

研究

百度

Sora

生成

GPU

工具

华为

计算

字节跳动

AI设计

AGI

大型语言模型

搜索

视频生成

生成式AI

场景

DeepMind

深度学习

特斯拉

AI模型

架构

MCP

Transformer

亚马逊

编程

视觉

预测