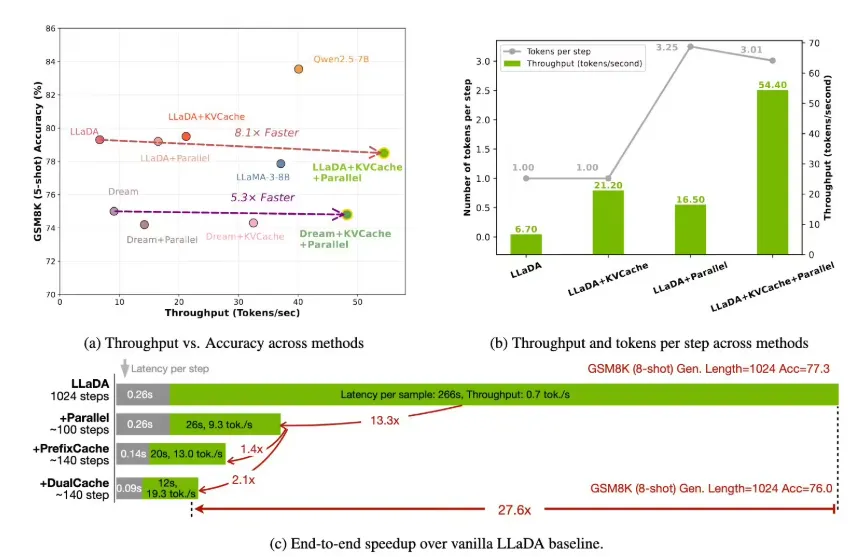

在最近的科技进展中,英伟达与麻省理工学院(MIT)和香港大学联合推出了名为 Fast-dLLM 的新框架,显著提升了扩散模型(Diffusion-based LLMs)的推理速度,最高可达27.6倍。这一创新的成果为语言模型的应用开辟了新天地。

扩散模型被视为自回归模型的有力竞争者,采用了双向注意力机制,使其在理论上能够实现多词元同步生成,从而加快解码速度。然而,实际应用中,扩散模型在推理速度上却常常无法与自回归模型相媲美,因为每一次生成都需要重复计算所有注意力状态,这使得计算成本居高不下。此外,在进行多词元解码时,词元之间的依赖关系易被破坏,影响生成质量,导致其在实际应用中受到限制。

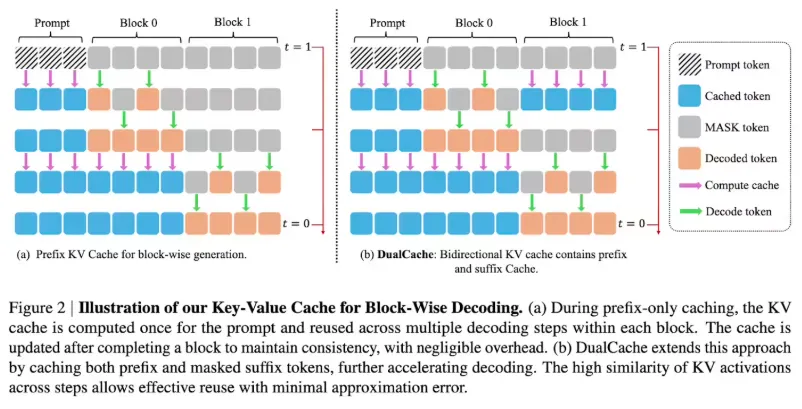

为了克服这些瓶颈,英伟达的研发团队在 Fast-dLLM 框架中引入了两项核心创新:块状近似 KV 缓存机制和置信度感知并行解码策略。KV 缓存通过将序列划分为块,预计算并存储其他块的激活值,减少了计算冗余;而其 DualCache 版本更是进一步提升了效率,利用相邻推理步骤的高相似性来缓存前后缀词元。

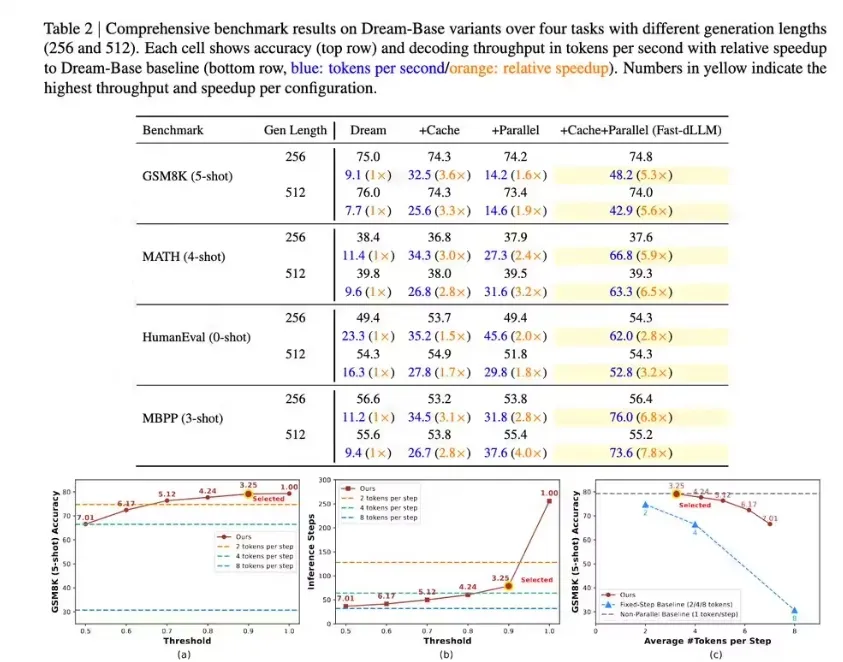

同时,置信度解码策略则根据设定的阈值选择性解码高置信度的词元,从而避免了同步采样可能带来的依赖冲突,确保生成质量不受影响。

Fast-dLLM 在多项基准测试中表现出色。在 GSM8K 数据集上,该框架在生成长度为1024词元时,8-shot 配置下实现了惊人的27.6倍加速,并达到了76.0% 的准确率;在 MATH 基准测试中,其加速倍数为6.5倍,准确率约为39.3%;而在 HumanEval 和 MBPP 测试中,分别实现了3.2倍和7.8倍的加速,准确率保持在54.3% 和接近基线水平。

Fast-dLLM 在加速的同时,准确率仅下降了1-2个百分点,展示了其在速度与质量之间的良好平衡。这一研究成果为扩散模型在实际语言生成任务中的应用提供了更为强大的支持,使其有能力与自回归模型进行竞争,为未来的广泛应用奠定了坚实基础。