ICCV 2025

重新定义跨模态生成的流匹配范式,VAFlow让视频「自己发声」

本文第一作者是中国人民大学高瓴人工智能学院 2021 级博士生王希华(导师宋睿华),他的主要研究兴趣方向是多模态生成。 本文通讯作者是宋睿华长聘副教授,她的 AIMind 团队主要研究方向是多模态感知、交互与生成。 背景:从「噪声到声音」到「视频到声音」在多模态生成领域,由视频生成音频(Video-to-Audio,V2A)的任务要求模型理解视频语义,还要在时间维度上精准对齐声音与动态。

10/31/2025 11:14:00 AM

机器之心

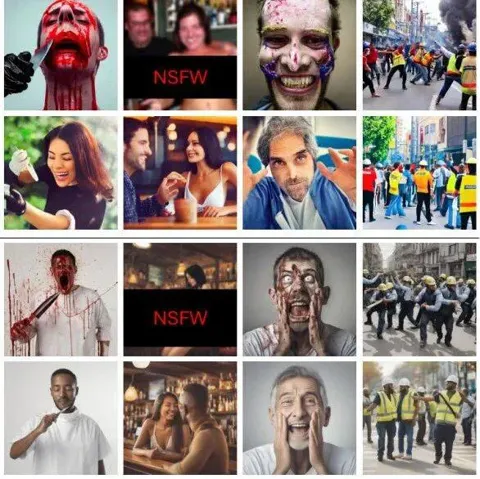

ICCV 2025 | 港科、牛津大学发布AlignGuard,文图生成模型可规模化安全对齐框架

本文共一作者为刘润涛和陈奕杰,香港科技大学计算机科学方向博士生,主要研究方向为多模态生成模型和偏好优化。 背景介绍随着文图生成模型的广泛应用,模型本身有限的安全防护机制使得用户有机会无意或故意生成有害的图片内容,并且该内容有可能会被恶意使用。 现有的安全措施主要依赖文本过滤或概念移除的策略,只能从文图生成模型的生成能力中移除少数几个概念。

10/30/2025 11:55:00 AM

机器之心

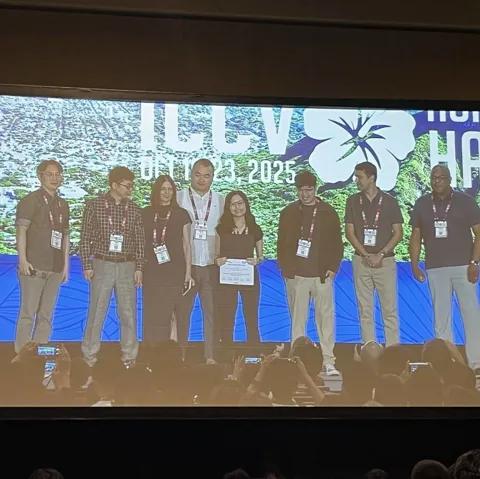

刚刚,ICCV最佳论文出炉,朱俊彦团队用砖块积木摘得桂冠

10 月 22 日凌晨,国际计算机视觉大会 ICCV(IEEE International Conference on Computer Vision)揭幕了本年度最佳论文等奖项。 来自卡耐基梅隆大学(CMU)的研究获得了最佳论文奖,以色列理工学院(Technion)的研究获得最佳学生论文奖。 ICCV 是全球计算机视觉三大顶会之一,每两年举办一次,今年的会议在美国夏威夷举行。

10/22/2025 11:57:00 AM

机器之心

ICCV 2025 | 扩散模型生成手写体文本行的首次实战,效果惊艳还开源

本文中,来自华南理工大学、MiroMind AI、新加坡国立大学以及琶洲实验室的研究者们提出一种新的生成模型 Diffusion Brush,首次将扩散模型用于文本行级的手写体生成,在英文、中文等多语言场景下实现了风格逼真、内容准确、排版自然的文本行生成。 研究背景AI 会写字吗? 在写字机器人衍生换代的今天,你或许并不觉得 AI 写字有多么困难。

10/20/2025 5:27:00 PM

机器之心

ICCV 2025 | 浙大、港中文等提出EgoAgent:第一人称感知-行动-预测一体化智能体

如何让 AI 像人类一样从对世界的观察和互动中自然地学会理解世界? 在今年的国际计算机视觉大会(ICCV 2025)上,来自浙江大学、香港中文大学、上海交通大学和上海人工智能实验室的研究人员联合提出了第一人称联合预测智能体 EgoAgent。 受人类认知学习机制和 “共同编码理论(Common Coding Theory)” 启发,EgoAgent 首次成功地让模型在统一的潜空间中同时学习视觉表征(Visual representation)、人体行动(Human action)和世界预测 (World state prediction)三大核心任务,打破了传统 AI 中 “感知”、“控制” 和 “预测” 分离的壁垒。

10/16/2025 1:03:00 PM

机器之心

ICCV 2025 | FDAM:告别模糊视界,源自电路理论的即插即用方法让视觉Transformer重获高清细节

针对视觉 Transformer(ViT)因其固有 “低通滤波” 特性导致深度网络中细节信息丢失的问题,我们提出了一种即插即用、受电路理论启发的 频率动态注意力调制(FDAM)模块。 它通过巧妙地 “反转” 注意力以生成高频补偿,并对特征频谱进行动态缩放,最终在几乎不增加计算成本的情况下,大幅提升了模型在分割、检测等密集预测任务上的性能,并取得了 SOTA 效果。 该工作来自北京理工大学、RIKEN AIP和东京大学的研究团队。

10/15/2025 3:48:00 PM

机器之心

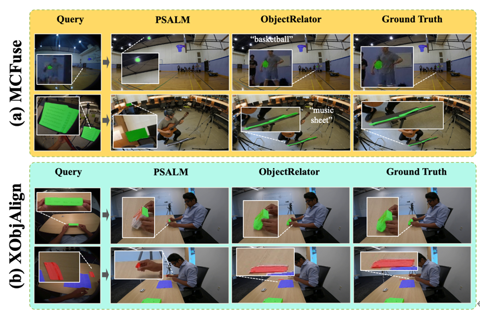

ICCV 2025 Highlight | ObjectRelator: 打破视角次元壁,让AI拥有第一人称与第三人称的“通感”

在人类技能习得过程中,需要在两个视角之间进行流畅的转换。 我们在观看别人的演示过程时,会尝试在脑海中想象自己进行这些操作的场景。 然而这一跨视角理解的能力对于计算机和机器人来说却是一个巨大的挑战,制约着机器人学习、VR 交互等关键领域的发展。

10/12/2025 12:34:00 PM

新闻助手

ICCV 2025 | 基于时序增强关系敏感知识迁移的弱监督动态场景图生成

该论文的第一作者和通讯作者均来自北京大学王选计算机研究所,第一作者为博士生徐铸,通讯作者为博士生导师刘洋。 团队近年来在 TPAMI、IJCV、CVPR、ICML 等顶会上有多项代表性成果发表,多次荣获国内外多模态理解预生成竞赛冠军,和国内外知名高校、科研机构广泛开展合作。 本文主要介绍来自该团队的最新论文:TRKT: Weakly Supervised Dynamic Scene Graph Generation with Temporal-enhanced Relation-aware Knowledge Transferring。

9/3/2025 4:30:00 PM

机器之心

ICCV 2025 | 打造通用工具智能体的基石:北大提出ToolVQA数据集,引领多模态多步推理VQA新范式

本文第一作者是来自北京大学的本科生殷绍峰,合作者包含来自北京大学的博士生雷廷,通讯作者为北京大学王选计算机研究所研究员、助理教授刘洋。 本文主要介绍来自该团队的最新论文:ToolVQA: A Dataset for Multi-step Reasoning VQA with External Tools。 本文提出了一个旨在提升基础模型工具使用能力的大型多模态数据集 ——ToolVQA。

8/22/2025 1:39:00 PM

机器之心

ICCV 2025 | ECD:高质量合成图表数据集,提升开源MLLM图表理解能力

本文第一作者杨昱威,来自澳大利亚国立大学,合作者包括章泽宇(澳大利亚国立大学)、侯云钟(澳大利亚国立大学)、李卓婉(约翰霍普金斯大学)、Gaowen Liu(思科)、Ali Payani(思科)、丁源森(俄亥俄州立大学)以及郑良(澳大利亚国立大学)。 背景与动机在科研、新闻报道、数据分析等领域,图表是信息传递的核心载体。 要让多模态大语言模型(MLLMs)真正服务于科学研究,必须具备以下两个能力:1.

8/21/2025 9:22:00 PM

机器之心

ICCV 2025 | HERMES:首个统一3D场景理解与生成的世界模型

本文第一作者周鑫、共同第一作者梁定康,均为华中科技大学博士生,导师为白翔教授。 合作者包括华中科技大学涂思凡,旷视科技丁宜康,迈驰智行陈习武、谭飞杨,香港大学赵恒爽助理教授。 在复杂的城市场景中,HERMES 不仅能准确预测未来三秒的车辆与环境动态(如红圈中标注的货车),还能对当前场景进行深度理解和问答(如准确识别出 “星巴克” 并描述路况)。

8/14/2025 1:13:00 PM

机器之心

ICCV 2025 | 小红书AIGC团队提出图像和视频换脸新算法DynamicFace

本论文主要作者来自小红书 AIGC 团队(Dynamic-X-Lab),Dynamic‑X‑LAB 是一个专注于 AIGC 领域的研究团队,致力于推动姿态驱动的人像生成与视频动画技术。 他们以高质量、高可控性的生成模型为核心,围绕文生图(t2i)、图像生成(i2i)、图像转视频(i2v)和风格迁移加速等方向展开研究,并通过完整的开源方案分享给开发者与研究者社区。 论文标题:DynamicFace: High-Quality and Consistent Face Swapping for Image and Video using Composable 3D Facial Priors论文链接::,扩散模型在图像与视频合成领域展现出前所未有的生成能力,为人脸生成与编辑技术按下了加速键。

8/12/2025 11:27:00 AM

机器之心

ICCV 2025 | 机器人自主探索未知复杂空间?GLEAM破解主动探索建图的泛化难题

本文一作为陈骁,香港中文大学 MMLab - 上海人工智能实验室具身智能中心联培博士生,研究方向是三维计算机视觉和具身智能,导师为薛天帆教授。 个人主页:xiao-chen.tech/。 研究背景当人类走入陌生房间时,会通过移动和观察来掌握室内结构。

8/11/2025 3:51:00 PM

机器之心

ICCV 2025 | 新型后门攻击直指Scaffold联邦学习,NTU联手0G Labs揭示中心化训练安全漏洞

通过使用控制变元(control variate)来校准每个客户端的本地梯度,Scaffold 已被广泛认为是缓解联邦学习中数据异质性影响的一种强大方案。 但尽管 Scaffold 实现了显著的性能提升,这种优越性是以增加安全漏洞为代价的。 本文中,NTU、0G Labs等机构提出了 BadSFL,这是首个针对 Scaffold 的后门攻击方法,它能够将原本良性的客户端转化为攻击的帮凶以放大攻击效果。

8/9/2025 12:52:00 PM

机器之心

ICCV 2025 | SeaS: 工业异常生成+正常合成+精准掩码大一统框架,指标全面碾压SOTA

论⽂标题:SeaS: Few-shot Industrial Anomaly Image Generation with Separation and Sharing Fine-tuning作者:Zhewei Dai, Shilei Zeng, Haotian Liu, Xurui Li, Feng Xue, Yu Zhou论⽂链接::⼯业异常⽣成迎来「全能选⼿」当前先进制造领域的产线良率往往超过 98%,因此异常样本(也称为缺陷样本)的搜集和标注已成为⼯业质检的核⼼瓶颈,过少的异常样本显著限制了模型的检测能⼒,利⽤⽣成模型扩充异常样本集合正逐渐成为产业界的主流选择,但现有⽅法存在明显局限:要么仅能完成单⼀任务(如只⽣成异常或正常产品),要么需针对不同异常类型单独建模,不仅⽣成能⼒受限,还因依赖⼤量专⽤模型难以适应复杂场景。 为此,华中科技⼤学慢⼯团队(SLOW Team)提出统⼀的少样本⼯业⽣成模型 SeaS。 该模型依托 U-Net 的差异化学习能⼒,精准捕捉正常产品的细微变化与异常区域的丰富差异,仅需要 1-3 张训练样本,通过单⼀模型即可同步实现多样化异常⽣成、全局⼀致的正常产品合成及精确异常掩码标注⽣成,为⼯业场景⽣成任务建⽴了新的技术基准,有效推动了相关领域的技术进步。

8/6/2025 1:04:00 PM

机器之心

机器人不只会抓和放!北京大学X银河通用「世界-动作模型」赋能全面泛化的非抓握技能

本文的作者团队来自北京大学和银河通用机器人公司。 第一作者为北京大学计算机学院前沿计算研究中心博士生吕江燃,主要研究方向为具身智能,聚焦于世界模型和机器人的灵巧操作,论文发表于 ICCV,TPAMI,RSS,CoRL,RAL 等机器人顶会顶刊。 本文的通讯作者为北京大学计算机学院教授王亦洲和北京大学助理教授、银河通用创始人及CTO 王鹤。

8/1/2025 10:28:00 AM

机器之心

ICCV 2025|UV-CoT:无监督视觉推理新突破,偏好优化重塑图像级思维链

本文第一作者是来自南洋理工大学的博士生赵克森,主要研究方向为 Reinforcement Learning in MLLMs. 该论文已被 ICCV 2025 录用。 随着文本领域中思维链(Chain-of-Thought,CoT)推理机制的成功应用,研究者开始将该方法引入视觉理解任务,以提升模型的推理能力和可解释性。

7/28/2025 1:27:00 PM

机器之心

ICCV 2025|训练太复杂?对图片语义、布局要求太高?图像morphing终于一步到位

本文第一作者操雨康,南洋理工大学MMLab博士后,研究方向是3D/4D重建与生成,人体动作/视频生成,以及图像生成与编辑。 本文共同第一作者司晨阳,南京大学助理教授,研究方向是图像/视频生成,以及生成模型的优化和加速。 在图像处理领域,「图像 morphing」(图像变形)是一项常见又充满创意的任务 —— 它可以让两张风格迥异的图片平滑过渡、自然融合,从而生成令人惊艳的中间图像。

7/18/2025 10:40:00 AM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

Gemini

马斯克

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

3D

人形机器人

AI视频

RAG

大语言模型

研究

百度

Sora

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

特斯拉

场景

AI模型

深度学习

亚马逊

架构

Transformer

MCP

编程

视觉

预测