资讯列表

独家丨百川智能联合创始人谢剑将离职

谢剑硕士毕业于武汉大学人工智能方向,2012 年获得硕士学位后加入百度,后在职攻读博士,并获得清华大学计算机科学博士学位。 他曾是百度集团内最年轻晋升为主任研发架构师的工程师之一,同时也是集团总技术委员会成员。 在百度期间,谢剑深度参与并推动了凤巢广告、搜索、智能助手等核心 AI 业务的发展,拥有超过十年在自然语言处理、搜索、计算广告、对话系统和预训练语言模型等方向的算法研发及团队管理经验。

7/11/2025 5:43:00 PM

郑佳美

AI 陪伴赛道,会诞生下一个“泡泡玛特”吗? | GAIR Live

AI 正在从生产工具的角色中抽身,缓慢却坚定地走向一个全新的方向——情绪陪伴。 当算法不再只为效率服务,越来越多的产品开始尝试构建“有灵魂”的存在。 无论是可以挂在胸前、随时回应你情绪的小型硬件,能够在家中自由行走、具备宠物属性的机器人,还是在手机里与你聊天、分享生活的虚拟人,这一代 AI 的设计逻辑已经从“怎么帮你完成任务”,转向“怎么陪你过日子”。

7/11/2025 5:39:00 PM

郑佳美

拍我AI(PixVerse)上线多关键帧生成功能 ,AI视频创作从“片段”迈向“故事性表达”

今天,全球超6000万用户的拍我AI(PixVerse)在首尾帧模块中新增「多关键帧生成」功能。 用户可上传最多7张图片作为关键帧,在首尾帧模式下轻松生成最长30秒的连贯视频,显著增强创作者对AI视频叙事的掌控力。 ▲用户可通过拍我AI网页端首尾帧功能添加最多7张关键帧.

7/11/2025 5:32:21 PM

一水

代码大模型+金融场景:aiXcoder入选TiD 2025年度软件研发优秀案例

2025年7月10日——基于代码大模型的aiXcoder智能化软件开发解决方案,凭借其技术创新和在国有银行的落地应用实践,入选TiD 2025质量竞争力大会“2025年度软件研发优秀案例”。 在该案例中,硅心科技(aiXcoder)将公司独特的领域化智能研发解决方案应用于某国有银行,助力该银行实现代码大模型的私有化部署,以及行内专属大模型的个性化训练和应用。 配合与银行自研云平台深度集成、企业专属研发管理平台和智能搜索系统等深度融合,硅心科技(aiXcoder)支持客户打造了银行专属的智能研发及交付体系,实现代码生成占比从个性化训练前的10%提升至35%、整体开发效率提升30%。

7/11/2025 5:24:00 PM

郑佳美

马蜂窝“AI路书”全面开放,AI旅行助手再添实用功能

日前,马蜂窝正式宣布其深度个性化攻略定制产品“AI路书”向所有用户开放。 与此同时,马蜂窝还同步上线了“AI代订日本餐厅”、“菜单翻译”以及“多语种实时翻译”等几大实用工具。 这一系列举措旨在直击用户出境自由行的核心痛点,实现从行程规划到目的地精细化服务的全链路智能化覆盖。

7/11/2025 5:01:06 PM

AI在线

马斯克吹牛了吗?Grok 4第一波实测出炉:既能完虐o3,也菜到数不清6根手指

网友氪重金体验Grok4。 昨天,马斯克亮相 Grok 4 发布会,一脸骄傲地表示:Grok 现在所有学科都达到博士后水平,没有例外,甚至可以在今年内实现科学新发现。 这一下子激起全球网友的兴趣,即使 Grok 4 的价格不菲,不少网友还是自愿氪金去体验一把。

7/11/2025 4:59:00 PM

机器之心

实测Vidu Q1参考生功能,看到诸葛亮丘吉尔拿破仑在长城拍照留念

这次真的不一样,遇到了「想象力的神」! 以前常说「要把自己活成一支队伍」,如今感谢 AI,真的实现了。 最近,生数科技旗下 AI 视频模型 Vidu Q1 推出参考生功能,极大简化传统内容生产流程,真正实现「一个人就是一个剧组」!

7/11/2025 4:50:00 PM

机器之心

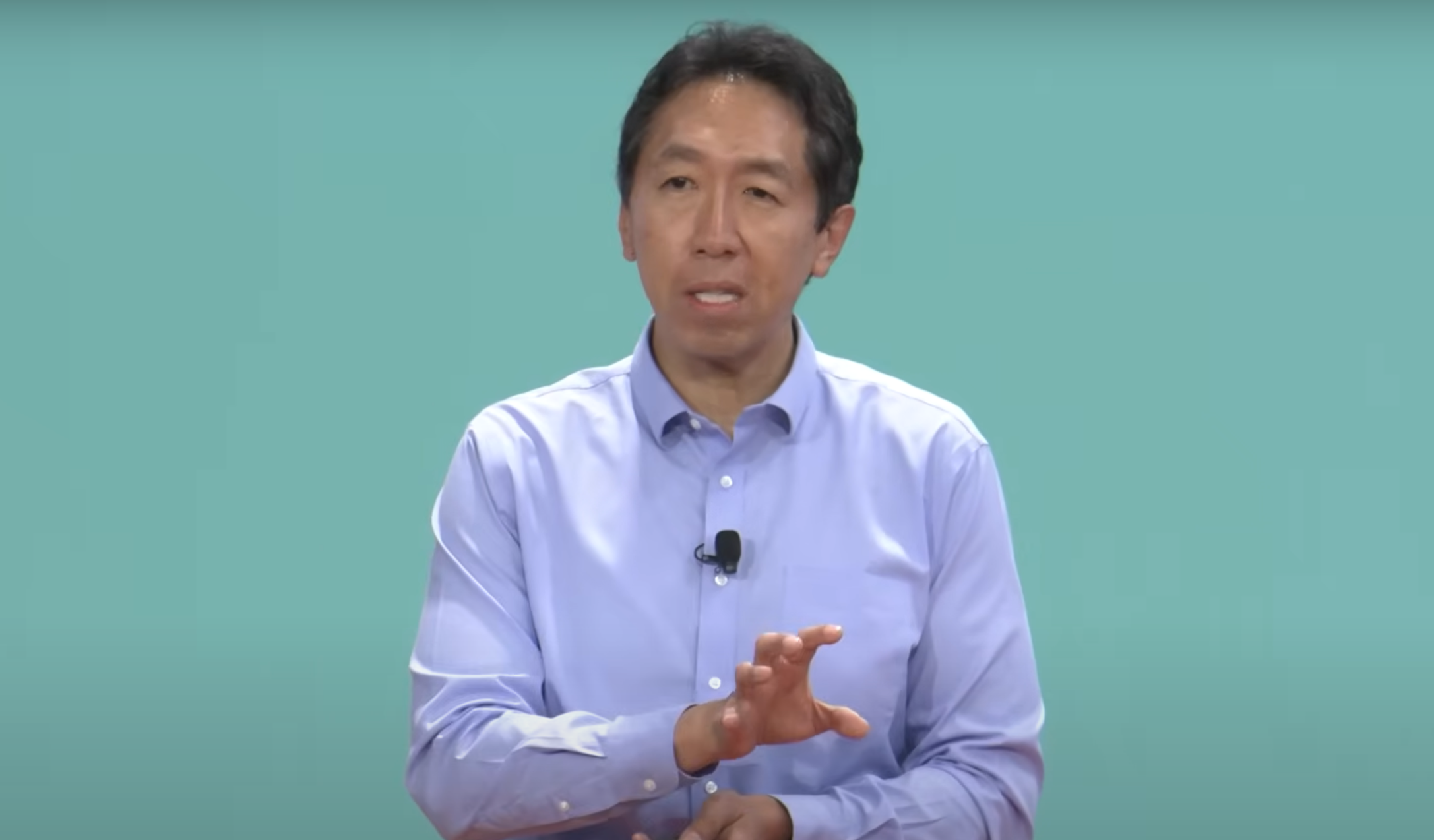

吴恩达YC演讲:AI创业如何快人一步?

天下武功,唯快不破:AI创业亦是如此。 最近吴恩达在YC演讲上倾囊相授,为所有AI创业者提供建议,总结下来就一个字——快! 吴恩达表示:除了强调速度的关键作用,吴恩达还探讨了AI技术如何加速工程和产品反馈,以及学习编码对个人的重要意义。

7/11/2025 4:45:02 PM

鹭羽

广东卫健委:全面上线人工智能辅助影像阅片系统,提高诊断质量和效率

AI在线 7 月 11 日消息,据新华社报道,广东省卫生健康委今日宣布,广东日前已全面上线人工智能辅助影像阅片系统,旨在助力提高影像诊断质量和效率,减轻医生工作压力。 报道称,该人工智能辅助影像阅片系统名为“粤医智影”,基于广东省远程医疗平台建设,涵盖 CT 肺结节、CT 骨密度、CT 肺炎、CT 肋骨骨折、DR 肺结核、DR 四肢骨骨折以及 CT 冠脉钙化积分共 7 类常见检查。 AI在线从报道获悉,医疗卫生机构将医学影像图片上传到广东省远程医疗平台后,系统对医学影像图片进行智能分析、快速阅片,自动生成结构化辅助诊断报告,辅助医生发现与直观定位各类病灶,完成病灶的筛查,快速自动识别并标记多类型病灶。

7/11/2025 4:42:50 PM

浩渺

微软研究院BioEmu登上Science,用生成式AI重塑蛋白质功能研究

7 月 10 日,微软研究院 AI for Science 团队在《Science》杂志发表了题为「Scalable emulation of protein equilibrium ensembles with generative deep learning」的研究成果。 论文::github.com/microsoft/bioemu模型::github.com/microsoft/bioemu-benchmarksColabFold: Foundry: BioEmu 的生成式深度学习模型,能够以前所未有的效率和精度模拟蛋白质的构象变化,为理解蛋白质功能机制和加速药物发现打开了新路径。 从结构预测到功能模拟:蛋白质研究的下一个前沿近年来,AlphaFold 等模型在蛋白质结构预测方面取得了突破性进展,但这些方法通常只能预测单一静态结构,难以捕捉蛋白质在功能过程中所经历的动态变化。

7/11/2025 4:42:00 PM

机器之心

告别Transformer!北大、北邮、华为开源纯卷积DiC:3x3卷积实现SOTA性能,比DiT快5倍!

当整个 AI 视觉生成领域都在 Transformer 架构上「卷生卷死」时,一项来自北大、北邮和华为的最新研究却反其道而行之,重新审视了深度学习中最基础、最经典的模块——3x3 卷积。 他们提出的 DiC (Diffusion CNN),一个纯卷积的扩散模型,不仅在性能上超越了广受欢迎的 Diffusion Transformer (DiT),更在推理速度上实现了惊人的提升。 这项工作证明了,经过精心设计,简单的卷积网络依然能在生成任务中登峰造极。

7/11/2025 4:37:00 PM

机器之心

Day One Global!2025DEMO WORLD企业全球化增长大会圆满举办

7月3-4日,2025DEMO WORLD在上海松江举行,本次大会由上海市经信委、市投促办指导,创业邦主办,上海市松江区投资促进和企业服务中心联合主办,松江区新桥镇、上海松江经开区、上海松江经开区·正泰智电港协办,摩根大通为战略合作伙伴。 为期两天的大会汇聚30 跨国公司、50 CVC机构、112家科技企业。 7月4日DEMO WORLD迎来企业全球化增长大会,三十多位出海实践者汇聚于此,分享全球市场洞察、对话出海经验。

7/11/2025 4:35:12 PM

一水

北京预计 2027 年建成多学科通用科学基础大模型,可服务千万用户

AI在线 7 月 11 日消息,北京市科委中关村管委会、北京市发展改革委、北京市经济和信息化局、北京市海淀区人民政府今日联合发布《北京市加快人工智能赋能科学研究高质量发展行动计划(2025—2027 年)》。 此次发布的《行动计划》围绕关键技术攻关、基础设施建设、领域应用落地、创新生态营造四个维度,提出了开展科学智能的基础理论研究、构建多学科通用的科学基础大模型、研发新一代科学计算智能模拟软件工具、构建开放共享的科学数据平台等 17 项重点任务。 《行动计划》指出,预计到 2027 年,北京将建成多学科通用的科学基础大模型,建设不少于 10 个高质量科学数据库,服务不少于 1000 万用户,推动在不少于 5 个领域开展深度应用,形成 8 个以上标杆应用案例。

7/11/2025 4:30:41 PM

清源

知情人士:智谱同时准备香港、A 股 IPO 工作,A 股上市概率较高

7 月 11 日下午消息,新浪科技从接近智谱 IPO 知情人士处获悉,智谱正同时准备港股和 A 股上市准备工作,且 A 股上市概率较高。 该人士表示,“今年智谱接受了多地国资注资,最近一次包括获得浦东创投集团和张江集团参投的 10 亿元战略融资,在 A 股上市的概率也非常大。 ”对此,智谱方面暂无回应。

7/11/2025 4:16:46 PM

文猛

Meta 离职大牛千字怒揭“黑幕”:内斗、抢功、末位裁员,全是毒瘤

昨天,14 亿年薪被挖的大牛刚刚震惊全网,今天 Meta 就被前研究员怒发「血书」控诉:别再到处撒钱乱挖人了,先治好你们的内斗癌! 2000 字爆料字字泣血,直指 Meta 公司文化崩坏、末位淘汰如毒瘤、团队抢功无下限。 硅谷最贵围城,真的是墙外人想进,墙内人想逃。

7/11/2025 4:13:40 PM

Manus AI官网及社交媒体现变动,中国用户或受影响

日前,通用AI智能体公司Manus近期对其中国区部分业务进行了裁员,并已将核心技术人员迁往新加坡总部。 据悉,Manus目前在中国区的员工总数约为120人。 Manus方面此前对此回应称,此次调整是基于公司自身经营效率的考量,旨在继续专注核心业务发展并提升整体运营效率。

7/11/2025 3:51:10 PM

AI在线

Manus 清空国内多平台账号,前员工透露“不会继续推进”中文版

AI在线 7 月 11 日消息,AI在线今日发现,AI Agent(智能体)平台 Manus 的官方微博和小红书账号的内容已清空。 此外,通过浏览器访问 Manus 官网,显示的不再是“Manus 中文版本正在开发中”,而是“Manus 在你所在的地区不可用”。 近期网传 Manus 对旗下部分国内业务进行裁员,并将核心技术人员迁往新加坡总部。

7/11/2025 3:49:42 PM

汪淼

CIO 落地 AI 的最佳伙伴,飞书开发套件助力企业提升 AI 生产力

过去一年,大模型快速发展,在带来机会的同时,也带来了焦虑,大家普遍关心以下三类问题:一类是关于软件形态,AI 时代的软件会如何演进? Agent 真的会替代 SaaS 吗? 其次是关于工具的,在 AI 时代,开发方式会发生哪些变化?

7/11/2025 3:37:36 PM