共同第一作者包括:陈家棋,斯坦福大学访问学者,复旦大学硕士,研究方向为 LLM Agent和大一统模型;朱小烨,华南理工大学本科,研究方向为 LLM Agent、LLM 和强化学习;王越,康奈尔大学本科,研究方向为 LLM Agent、多模态语言模型。指导老师:Julian McAuley(UCSD)、Li-jia Li (IEEE Fellow, LiveX AI)。

在人工智能内容创作蓬勃发展的今天,跨模态生成技术正在重塑艺术创作和视觉表达的边界。人们对需求也日趋复杂和多样,譬如将静态照片转化为动态视频并叠加环境音效,打造沉浸式的多感官体验。然而,现有生成系统大多受限于训练数据的覆盖范围,或是因复杂的多模型协调而效率低下,难以满足这些日益增长的创意需求。

来自复旦大学、华南理工大学、武汉大学以及 Cornell、UCSD 等机构的研究团队提出了创新的基于符号化表征的生成任务描述框架。该框架将符号化思维引入生成任务建模。这一创新框架构建了一种生成任务的表示方式—— ,通过建立结构化的语义桥梁,使系统能够像人类理解创作意图一样解析和执行复杂的跨模态生成需求。

,通过建立结构化的语义桥梁,使系统能够像人类理解创作意图一样解析和执行复杂的跨模态生成需求。

- 论文标题:Symbolic Representation for Any-to-Any Generative Tasks

- 代码链接:https://github.com/Jiaqi-Chen-00/Any-2-Any

- 论文地址:https://arxiv.org/abs/2504.17261

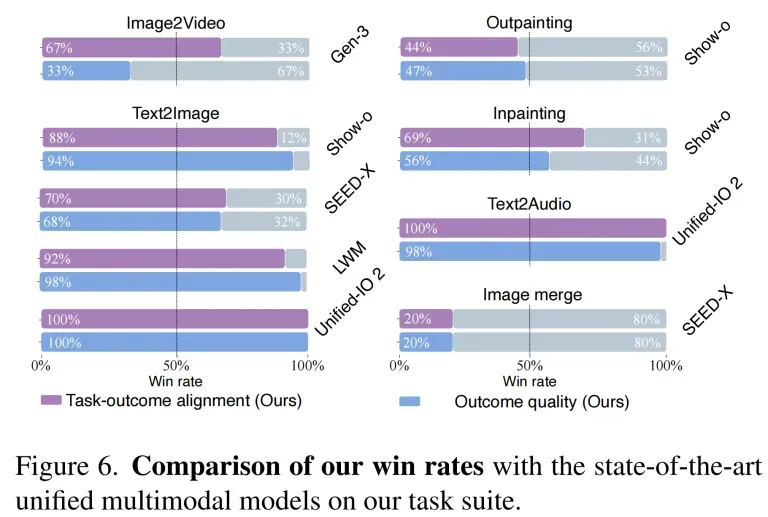

实验证明, 在 12 类 120 项跨模态生成任务中表现出色,在文本到图像任务中以 94% 的胜率超越现有模型,在图像转视频任务中更以 67% 的胜率优于商业系统 Gen-3。该方法不仅在内容质量上与现有的最先进的统一模型相当甚至更优,还提供了更高的效率、可编辑性和可中断性。符号化的任务表示为推进生成式人工智能的能力提供了一种成本效益高且可扩展的基础。

在 12 类 120 项跨模态生成任务中表现出色,在文本到图像任务中以 94% 的胜率超越现有模型,在图像转视频任务中更以 67% 的胜率优于商业系统 Gen-3。该方法不仅在内容质量上与现有的最先进的统一模型相当甚至更优,还提供了更高的效率、可编辑性和可中断性。符号化的任务表示为推进生成式人工智能的能力提供了一种成本效益高且可扩展的基础。

问题背景

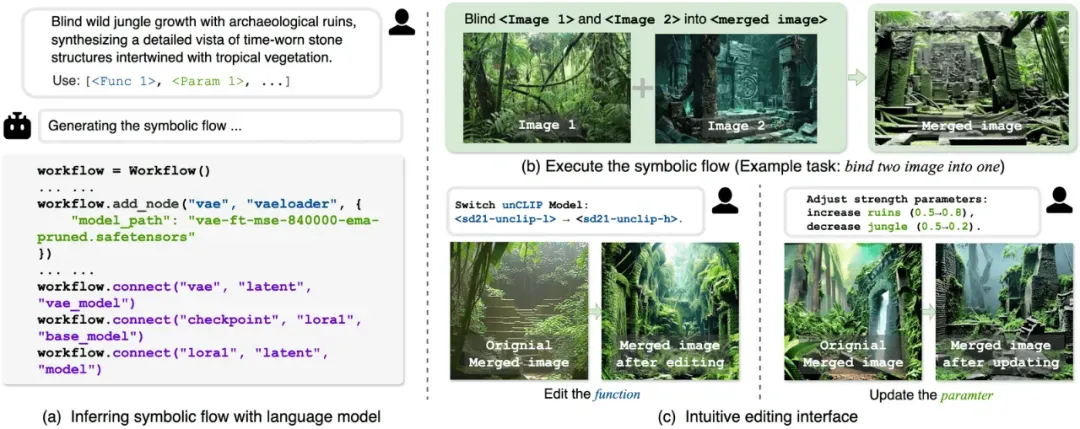

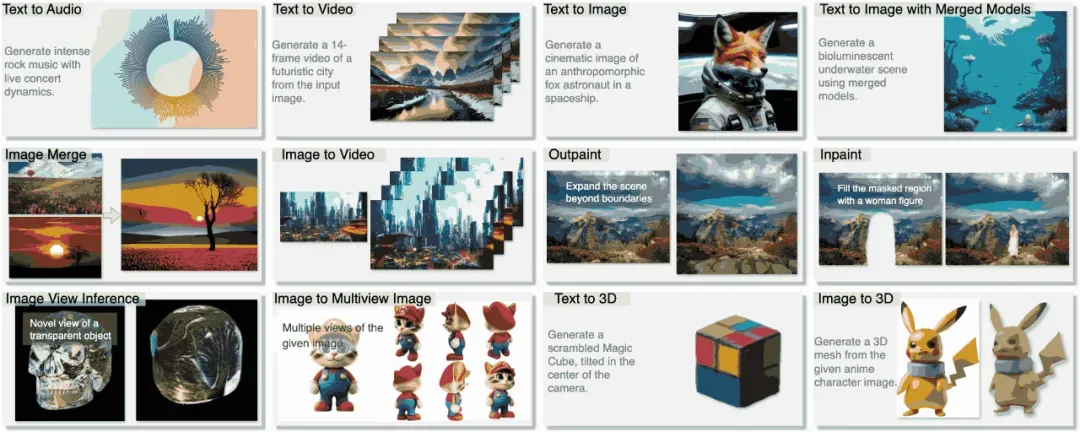

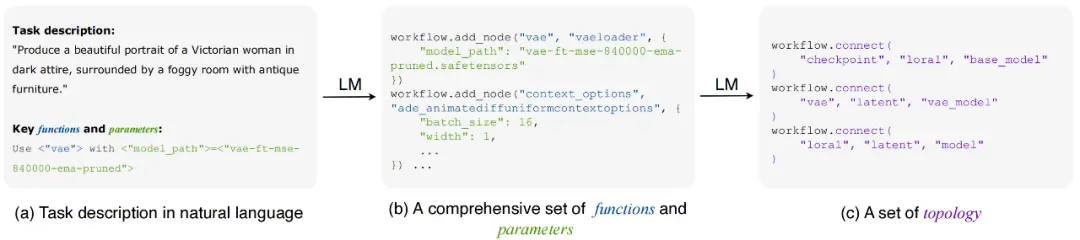

图 1 用于 Any-to-Any 生成任务的一种符号化描述方法。

「将丛林的狂野生长与古老废墟的神秘感融合成一个全新的场景,一定会令人惊叹,」你的艺术家朋友沉思道。「如果还能把这张照片转换成视频,再叠加上鸟鸣声和潺潺流水声——那将营造出一种梦幻般的感官体验。」这些日益复杂、跨模态的创作需求指向了一个根本性挑战:如何设计一个统一模型,能够根据自然语言指令,无缝处理任意输入与输出模态组合的生成任务?这样的任务就是该研究关注的「Any-to-Any」生成任务,如图 2 所示。

图 2 Any-to-Any 生成任务

当前 Any-to-Any 生成任务的方法主要分为隐式神经建模和智能体方法。隐式神经建模需要大量数据训练,虽然能处理常见任务,但对新场景适应能力差且生成过程不可控;智能体方法虽然功能灵活但结构复杂,运行不稳定且效率较低。此外,如果人类设计师用 PS 合成图像时,需要先背诵所有滤镜组合公式才能操作,还有创意可言吗?当前许多方法陷入了这种「知识依赖陷阱」——而真正的 Any-to-Any 生成,应该像儿童搭积木:不需要理解木块分子结构,只需知道它们如何拼接。

于是,研究团队设想构建一个框架:聚焦于统一的任务表示和语言模型友好的接口,从而实现直接的任务指定。使系统能够真正理解并执行用户以自然语言描述的任意生成需求,同时保持执行过程的可控性和可干预性。这一设想从根本上改变了传统生成模型的实现范式,为构建真正意义上的 Any-to-Any 生成系统提供了新的技术路线。

基于符号化表征的生成任务描述框架

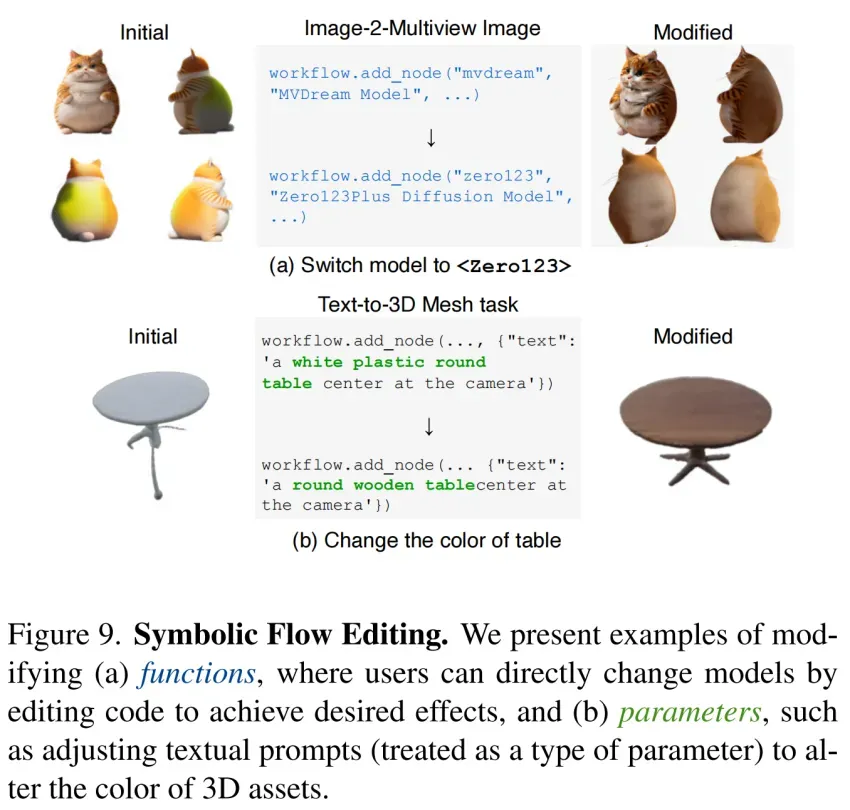

框架设计的核心思路在于对生成任务本质的解构:任何复杂的多模态生成过程,本质上都可以拆解为「做什么」(函数)、「怎么做」(参数)和「执行顺序」(拓扑)三个要素。基于这样的见解,研究提出了 -Language,这是一种正式表示方法,系统地捕捉生成任务的这三个基本组成部分。此外,研究还介绍了一种无需训练的推理引擎,它利用预训练的语言模型作为基础,从输入指令和指定的关键函数中得出符号表示。

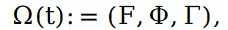

从本质上讲,-Language 将任意生成任务形式化为一个三元组

这一统一的形式化将生成任务分解为三个核心组成部分:计算函数、对应参数,以及阐明其相互关系和数据流动态的拓扑结构。

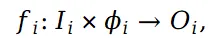

(1)函数是构成生成任务的基本计算单元,其数学形式表示为:

其中: 表示第 i 个函数,

表示第 i 个函数, 是该函数的输入空间,可以包含任意模态的数据(如图像、文本、音频等),

是该函数的输入空间,可以包含任意模态的数据(如图像、文本、音频等), 是该函数的参数配置,

是该函数的参数配置, 是该函数的输出空间。例如,一个图像风格迁移函数可能接收原始图像和风格描述文本作为输入,经过参数调节后输出风格化图像。

是该函数的输出空间。例如,一个图像风格迁移函数可能接收原始图像和风格描述文本作为输入,经过参数调节后输出风格化图像。

(2)参数集合定义为:

其中每个 对应函数

对应函数 的参数空间。参数在函数执行前必须完全指定,用于精确控制函数行为。例如,在图像生成任务中,参数可能包括生成步数、风格强度、分辨率等。

的参数空间。参数在函数执行前必须完全指定,用于精确控制函数行为。例如,在图像生成任务中,参数可能包括生成步数、风格强度、分辨率等。

(3)拓扑结构定义了函数之间的数据流动关系,表示为:

每个数据流是一个具体的连接关系:

其中, 是源函数,

是源函数, 是源函数的特定输出,

是源函数的特定输出, 是目标函数,

是目标函数, 是目标函数的特定输入。

是目标函数的特定输入。

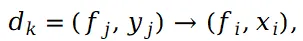

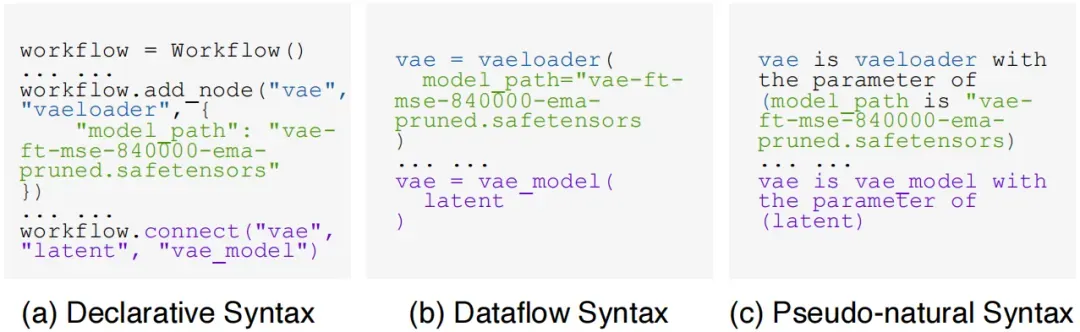

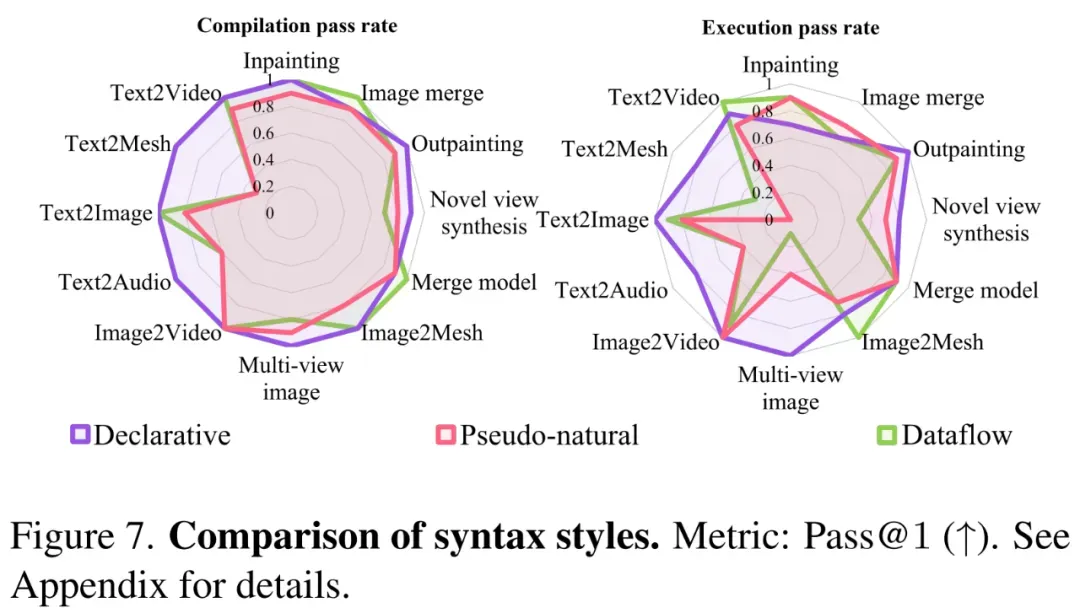

如图 3 所示,框架提供了三种等效但风格迥异的语法形式来表达符号化表示,以满足不同场景的使用需求:

- 声明式语法 (Declarative Syntax):采用组件先定义后连接的范式,将函数与拓扑关系显式分离,特别适合需要组件复用的复杂工作流。

- 数据流语法 (Dataflow Syntax):通过函数链式调用的方式直观展现数据流动路径,更契合线性顺序任务的表达。

- 伪自然语法 (Pseudo-natural Syntax):创新性地采用类自然语言的结构,在保持数学严谨性的同时大幅提升了可读性,为非专业用户提供了更友好的交互界面。

这三种语法在保持 完整表达能力的前提下各有侧重:声明式强调结构化,数据流突出过程性,伪自然注重易用性,后续实验系统评估了它们在大语言模型推理场景中的实际表现。

完整表达能力的前提下各有侧重:声明式强调结构化,数据流突出过程性,伪自然注重易用性,后续实验系统评估了它们在大语言模型推理场景中的实际表现。

图 3 语法风格比较。

- 基于预训练语言模型的符号化流程推断为使方法灵活而稳健地适应生成任务的多样性和复杂性,该研究将高层次的任务描述转化为可执行的符号化流程。如图 4 所示,提出利用语言模型 (LM) 作为推理引擎,从输入指令和指定的关键函数中得出符号表示。

图 4 利用语言模型 (LM) 生成符号化表示。

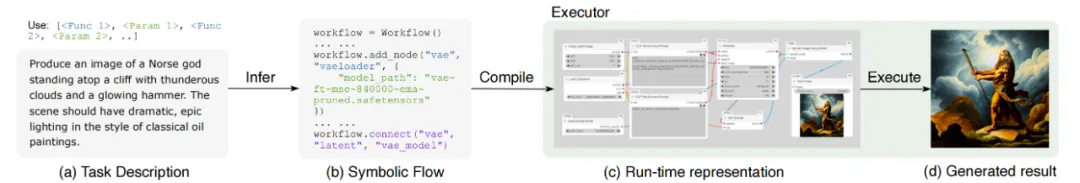

通过三阶段处理实现这一目标:组件推断阶段由语言模型解析任务描述,识别所需的函数 (F) 和参数 (Φ);拓扑构建阶段基于输入输出关系,建立函数间的数据流连接 (T);迭代优化阶段通过错误反馈循环 (R) 持续修正流程,直至满足所有约束条件 (C)。图 5 完整展示了从自然语言描述到可执行工作流程的转换过程,从而实现了跨模态和跨任务类型的任意转换。

图 5 推理和执行的演示。

实验结果

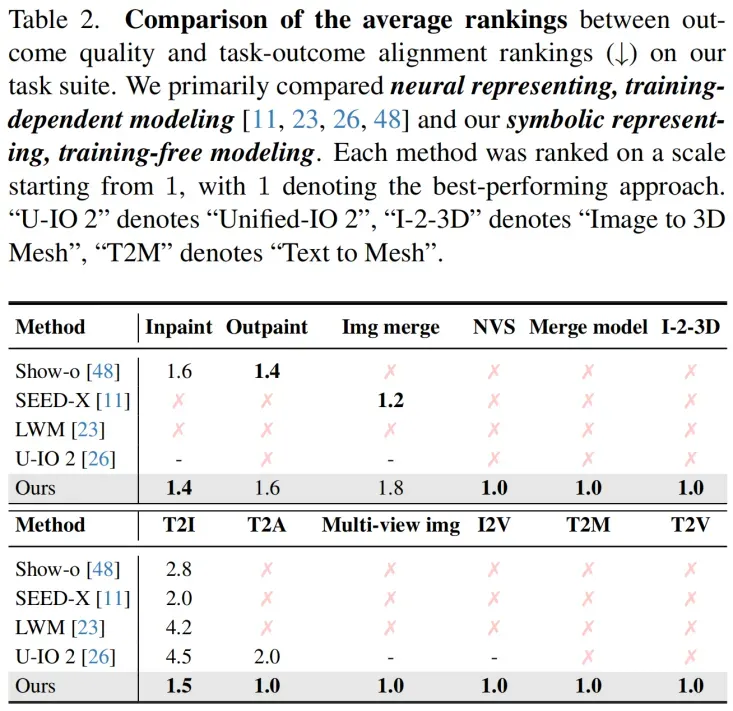

在实验中,该研究构建了一个包含 120 个真实世界生成案例的数据集,涵盖 12 个任务类别,并通过用户研究和可执行性评估验证了方法的有效性。

- 跨模态生成质量评估(用户研究)

针对不同模态转换任务进行了系统的用户评估,以验证该方法在真实场景下的生成质量。实验结果显示,在文本到图像任务中,该方法对 Show-o 的胜率达 94%;在图像转视频任务中,对商业系统 Gen-3 的胜率达 67%;文本到音频任务中,对齐度和质量胜率分别达 100% 和 98%。

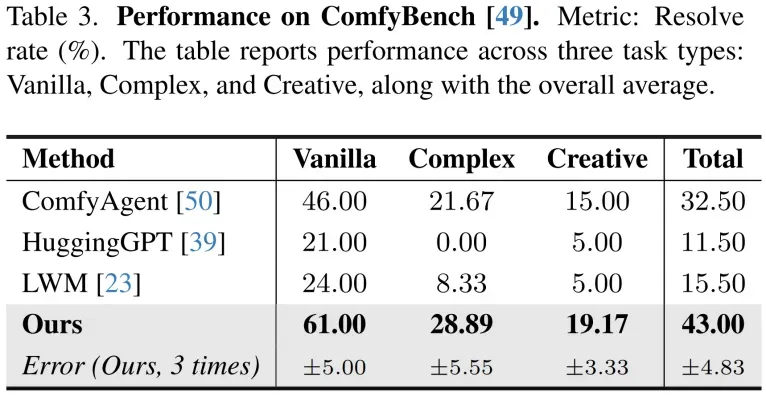

- 复杂工作流执行测试(ComfyBench 基准)

为评估方法处理复杂任务的能力,采用包含多步骤工作流的 ComfyBench 进行测试。实验结果显示,总体成功率 43%,显著优于次优方法(32.5%),在复杂任务(如包含 11 个组件的「模型合并」)上表现突出。

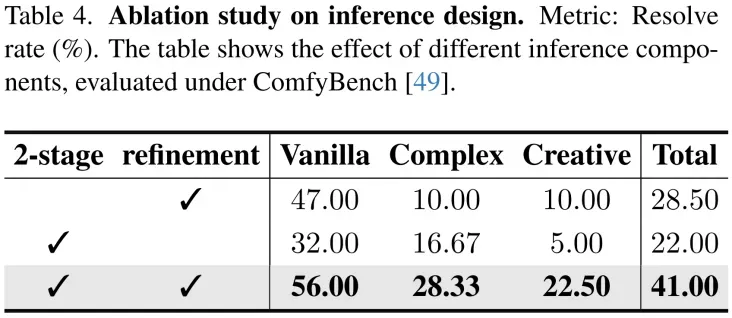

- 消融实验

消融实验证实,两阶段推理架构(组件推断 + 拓扑构建)是系统性能的核心,移除该设计将导致任务完成率下降 35%。

- 对比实验:符号化 v.s. 代理化方法

选取了当前最先进的代理框架 GenAgent 作为基线,在相同任务集上进行对比测试。实验数据显示,在编译阶段,该方法达到 98% 的通过率,相比代理方法的 84% 显著提升 ($p \< 0.001$);执行成功率方面,该方法 87% 的表现远超代理方法的 63%。

- 表示方法本质研究

针对「神经表示 v.s. 符号表示」这一核心问题,研究设计了控制变量实验:在相同计算资源下,符号表示的内存占用仅为神经表示的 1/5。任务修改效率测试显示,修改符号化流程平均耗时 23 秒,而神经方法需要重新训练(平均 4.2 小时);但在端到端推理速度上,神经方法快 1.8 倍,这揭示了符号方法在实时性上的 trade-off。

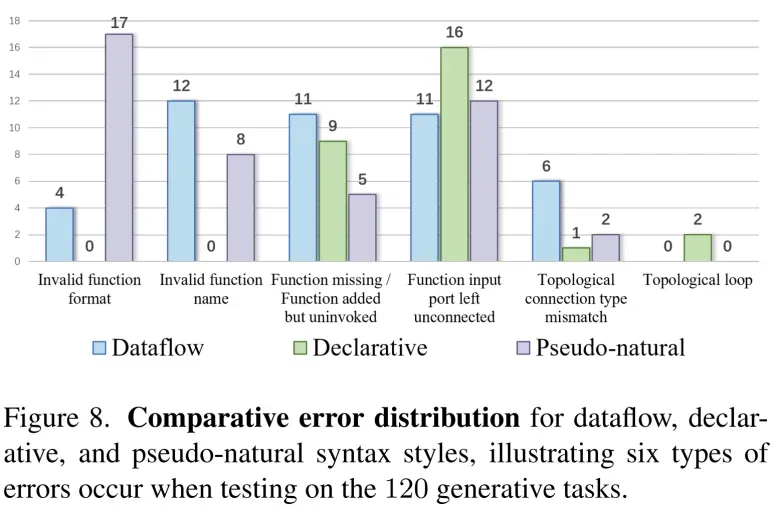

- 显式流程编辑与错误分析

通过对 120 个失败案例的归因分析发现,28% 的错误源于参数范围越界,主要体现在跨模态任务中的单位转换问题;22% 属于模态不匹配错误,多发生在未明确指定输入输出类型的场景中;15% 由于函数缺失导致,这反映了现有函数库仍需扩展。

总结

该研究提出的符号化生成任务描述语言及配套推理引擎,为多模态任务提供了一种无需专门训练的全新高效解决方案。通过利用预训练大语言模型将自然语言指令直接转化为符号化工作流,该方法成功实现了 12 类跨模态生成任务的灵活合成。实验证明,该框架不仅在生成内容质量上媲美现有的先进统一模型,更在效率、可编辑性和可中断性等方面展现出显著优势。符号化任务表示方法或许能为提升生成式 AI 能力提供一条经济高效且可扩展的技术路径。