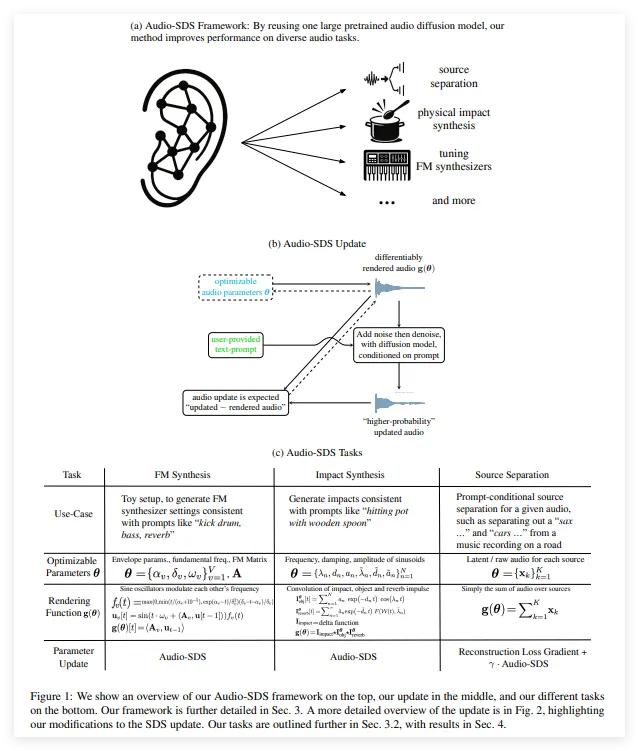

NVIDIA AI研究团队发布了一项突破性技术——Audio-SDS,将Score Distillation Sampling(SDS)技术扩展至文本条件音频扩散模型,显著提升了音效生成、音源分离及多任务音频处理的能力。这一创新成果已在学术界和工业界引发热议。

技术核心:SDS赋能音频扩散模型

Audio-SDS基于NVIDIA此前在图像生成领域广泛应用的SDS技术,通过将其适配到预训练的音频扩散模型,实现了从单一模型到多任务音频处理的跨越。核心创新在于:

通用性扩展:无需重新训练,Audio-SDS可将任意预训练音频扩散模型转化为多功能工具,适用于音效生成、音源分离、FM合成及语音增强等多种任务。

文本条件控制:通过文本提示引导音频生成,支持高度定制化的音效设计,满足创意和工业需求。

高效推理:优化后的SDS算法在保持高质量输出的同时,降低了计算复杂度,提升了实时应用的可行性。

NVIDIA在其技术报告中展示了Audio-SDS的多项演示案例,包括从环境音效生成到复杂音源分离,显示出强大的泛化能力和实用性。相关论文和音频样本已通过官方渠道公开,为开发者提供了丰富的参考资源。

性能亮点:多任务音频处理的标杆

Audio-SDS在多项音频处理任务中展现出卓越性能,尤其在以下场景中表现突出:

音源分离:从混合音频中精准提取目标音轨,适用于音乐制作和视频后期处理。

音效合成:生成逼真的环境音效或创意音效,如爆炸声、风声等,助力游戏开发和虚拟现实(VR)应用。

FM合成与语音增强:支持高质量的频率调制合成和语音清晰度提升,适用于音频编辑软件和智能语音助手。

与传统音频处理模型相比,Audio-SDS无需针对单一任务进行专门训练,极大降低了开发成本和时间。其基于文本条件的生成能力进一步增强了用户交互体验,使非专业用户也能通过简单描述生成高质量音频内容。

应用前景:从创意到工业的广泛赋能

Audio-SDS的发布标志着NVIDIA在AI音频领域的又一里程碑,其潜在应用场景涵盖多个行业:

娱乐与媒体:为电影、游戏和虚拟现实提供沉浸式音效设计,提升用户体验。

智能设备:增强语音助手的语音处理能力,优化噪声环境下的交互效果。

教育与创作:为音乐制作人和内容创作者提供高效工具,降低专业音频处理的门槛。

AIbase观察到,Audio-SDS的开源演示和灵活架构使其有望成为音频处理领域的标杆技术。NVIDIA的持续投入也表明其在AI多模态研究上的战略布局,未来可能进一步扩展至视频、3D建模等领域。

生态与开源:NVIDIA推动AI音频创新

NVIDIA一贯致力于通过开源和生态建设加速AI技术普及。Audio-SDS的论文、代码和演示样本已通过官方渠道发布,开发者可自由访问并基于此进行二次开发。这种开放策略不仅促进了学术研究,也为中小型企业提供了低成本的AI音频解决方案。

此外,NVIDIA的Omniverse平台和Isaac机器人平台近年来在多模态AI应用中表现亮眼,Audio-SDS的推出进一步丰富了其技术生态,为构建统一的AI内容生成框架奠定了基础。

Audio-SDS开启AI音频新篇章

NVIDIA的Audio-SDS以其创新的SDS适配技术和多任务处理能力,为AI音频领域注入了新的活力。从音效生成到音源分离,这款技术展示了AI在音频处理中的无限可能。AIbase将继续关注NVIDIA在AI多模态技术上的最新进展,为读者带来前沿洞察。

项目:https://research.nvidia.com/labs/toronto-ai/Audio-SDS/