小红书近日宣布开源其首个大规模模型 ——dots.llm1,该模型具有1420亿个参数,是一种专家混合模型(MoE)。其设计的一个显著特点是,在推理过程中仅激活140亿参数,这种结构不仅保持了高性能,还大幅降低了训练和推理的成本。

dots.llm1使用了11.2万亿个非合成的高质量训练数据,这在当前开源大模型中显得非常罕见,表明小红书在语言处理方面的强大资源。该模型在中文测试中的表现优异,平均得分91.3,超越了多款竞争对手,如 DeepSeek 的 V2、V3和阿里巴巴的 Qwen2.5系列。

在技术架构方面,dots.llm1采用了单向解码器 Transformer 结构,并将传统前馈网络替换为 MoE。与传统模型不同,MoE 将多个专家网络分开,每个专家网络专注于输入数据的不同特征,从而在推理时只激活一小部分网络进行计算,大幅度节省了算力需求。

具体来说,dots.llm1包含128个路由专家和2个共享专家。每个专家都是一个具有两层前馈结构的网络,使用 SwiGLU 激活函数以捕捉数据中的复杂关系。在处理输入标记时,模型会动态选择出6个最相关的专家和2个共享专家进行运算。

此外,dots.llm1在训练过程中还引入了改进的 RMSNorm 归一化操作,以稳定模型性能和输出。在 MoE 模块中,负载平衡策略的引入确保了所有专家网络的使用均衡,从而避免了过度依赖某些专家的问题。

为了提升模型的训练效率,dots.llm1还使用了 AdamW 优化器,这一优化算法能有效防止模型过拟合并控制梯度爆炸。

数据处理是训练大模型的关键,dots.llm1经过了严格的三级数据处理流水线,确保了训练数据的高质量。经过一系列的过滤和处理,最终形成了11.2万亿个高质量 token 的训练数据。此外,小红书还开源了每1万亿 token 的中间训练检查点,促进学术研究的进一步发展。

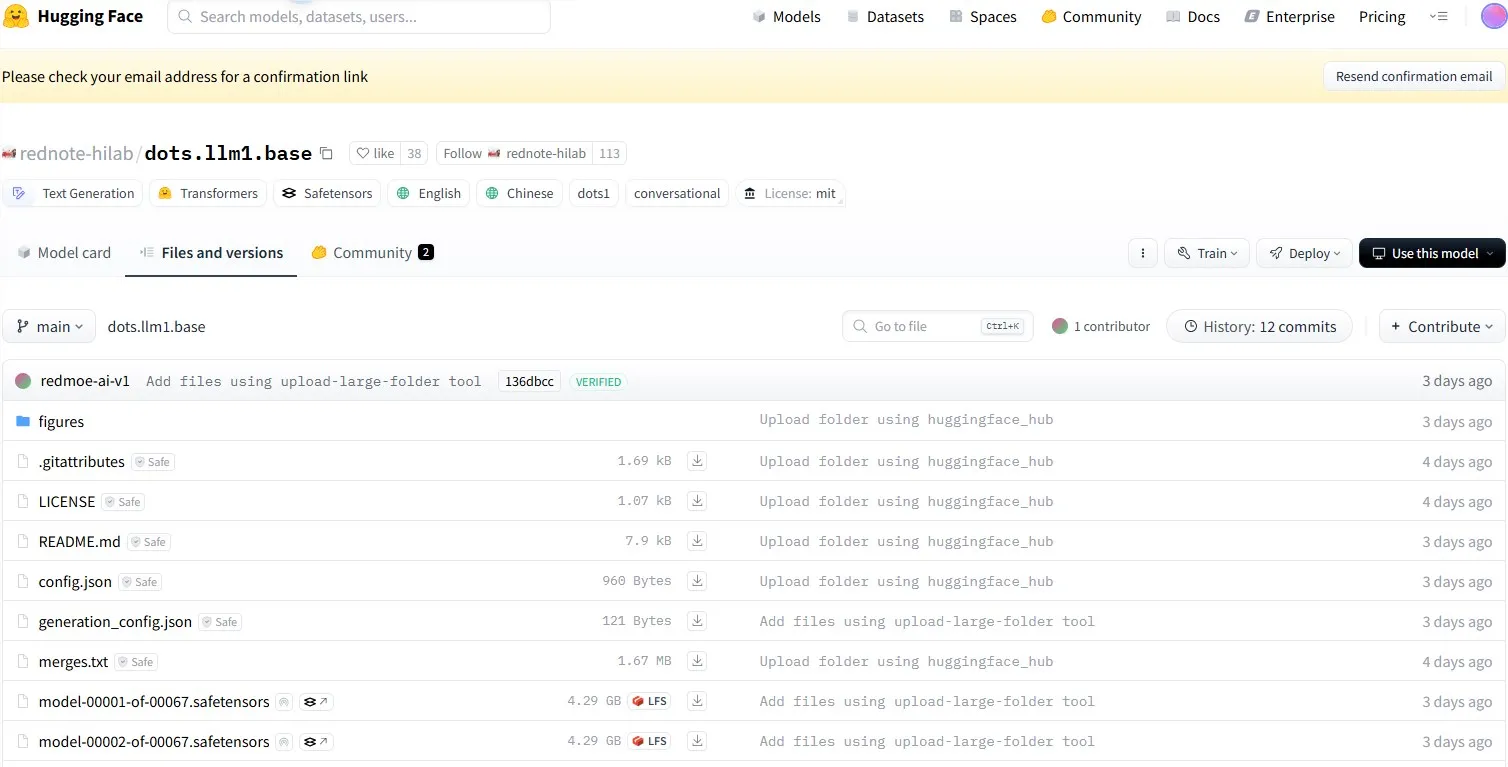

开源地址:https://huggingface.co/rednote-hilab/dots.llm1.base/tree/main

划重点:

🌟 dots.llm1是小红书开源的首个大模型,采用1420亿参数的专家混合结构。

📊 模型使用了11.2万亿个非合成数据,在中文测试中表现优越。

🔍 通过严格的数据处理流水线,确保了高质量训练数据的有效性和可靠性。