Transformer

挑战传统:无归一化层的 Transformer 架构新突破

在深度学习领域,归一化层被视为现代神经网络中不可或缺的组件之一。 最近,一项由 Meta FAIR 研究科学家刘壮主导的研究成果 ——“没有归一化层的 Transformer” 引发了广泛关注。 这项研究不仅提出了一种名为动态 tanh(Dynamic Tanh,DyT)的新技术,还展示了在不使用传统归一化层的情况下,Transformer 架构依然可以实现高效的训练和推理。

Sesame发布CSM模型:实时情感定制 AI语音合成迈向新高度

3月13日,Sesame公司推出其最新语音合成模型CSM,引发业界关注。 据官方介绍,CSM采用端到端基于Transformer的多模态学习架构,能够理解上下文信息,生成自然且富有情感的语音,声音效果贴近真人,令人惊艳。 该模型支持实时语音生成,可处理文本和音频输入,用户还能通过调整参数控制语气、语调、节奏及情感等特性,展现高度灵活性。

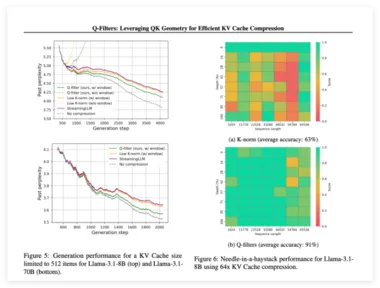

无需训练!Q-Filters 实现 KV 缓存高效压缩,提升推理性能

近年来,基于 Transformer 架构的大型语言模型(LLMs)取得了显著进展,诸如 Gemini-Pro1.5、Claude-3、GPT-4和 Llama-3.1等新模型能够处理成百上千的token。 然而,这些扩展的上下文长度带来了实际应用中的一些重大挑战。 随着序列长度的增加,解码延迟上升,内存限制也成为了一个严重的瓶颈。

基于药效团与GPT从头生成分子,北大开发TransPharmer助力药物发现

编辑 | 萝卜皮深度生成模型推动了药物发现,但生成的化合物通常结构新颖性有限,限制了药物化学家的灵感。 为了解决这个问题,北京大学的研究人员开发了 TransPharmer,这是一种生成模型,它将基于配体的可解释药效团指纹与基于生成预训练 Transformer(GPT)的框架相结合,用于从头生成分子。 TransPharmer 在无条件分布学习、从头生成和药效团约束下的骨架构建方面表现出色。

MIT三人团队:用Transformer解决经验贝叶斯问题,比经典方法快100倍

Transformer 很成功,更一般而言,我们甚至可以将(仅编码器)Transformer 视为学习可交换数据的通用引擎。 由于大多数经典的统计学任务都是基于独立同分布(iid)采用假设构建的,因此很自然可以尝试将 Transformer 用于它们。 针对经典统计问题训练 Transformer 的好处有两个:可以得到更好的估计器;可以在一个有比 NLP 更加容易和更好理解的统计结构的领域中阐释 Transformer 的工作机制。

复旦团队提出Transformer生成的原子嵌入策略,可通过ML提高晶体特性的预测准确性

编辑 | 白菜叶近年来,在化学分子性质与结构预测领域出现了大量基于 Transformer 的训练方法和预测模型,例如 OrbNet、3D-Transformer 等。 科学家们认为这些方法和模型,能够充分发挥 Transformer 架构在处理原子相互作用和捕捉三维结构方面的优势,从而高效地表示原子间复杂的相互作用。 在这些进步的推动下,复旦大学的研究人员开发了自制的 CrystalTransformer 模型,基于 Transformer 架构生成称为 ct-UAE 的通用原子嵌入,该模型为每个原子学习独特的「指纹」,捕捉它们在材料中的功能和相互作用的本质。

啊!DeepSeek-R1、o3-mini能解奥数题却算不了多位数乘法?

我们都知道,普通大模型的数学能力并不好,甚至可能会搞不清楚 9.8 和 9.11 哪个大。 但随着 o1、o3 以及 DeepSeek-R1 等推理模型的到来,情况正在发生变化。 比如 DeepSeek-R1 在竞赛数学基准 AIME 2024 上达到了 79.8% 的准确度,成就了自己头号开源推理模型的地位。

七彩虹推出 “虹光 AI” 助手接入全速版 DeepSeek

七彩虹科技正式宣布,其全新的 “虹光 AI” 智能模型助手已全面接入满血版 DeepSeek R1模型。 这一升级使得七彩虹的笔记本产品在性能和推理效率上得到了显著提升。 此次更新的 “虹光 AI” 助手,基于当前热门的 Transformer 架构,并采用了 MLA 与 Deep Seek MoE 技术,显著降低了内存占用,减少了缓存需求,从而提升了整体的推理效率。

揭示Transformer重要缺陷!北大提出傅里叶分析神经网络FAN,填补周期性特征建模缺陷

AIxiv专栏是AI在线发布学术、技术内容的栏目。 过去数年,AI在线AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。 如果您有优秀的工作想要分享,欢迎投稿或者联系报道。

Transformer能否推理引争议,DeepMind连夜更新论文开源数据集:Transformer真的很强

DeepMind闷声干大事,悄悄训练了一个大小只有270M的Transformer模型,居然不需要搜索,就能实现大师级的下棋水平。 这几天的推特因为这篇2月份发布的论文吵得不可开交,DeepMind团队也赶紧放出了更新后的论文版本,开源了有关数据集和代码,对网上的争议做了回应。 最开始,有位网友分享了DeepMind的这项研究,并提出“Transformer也能用于逻辑任务”的观点,没想到却激起了一场关于Transformer能不能推理的争论。

还是原装Transformer好!北大清华团队同时揭示Mamba等推理短板

AIxiv专栏是AI在线发布学术、技术内容的栏目。过去数年,AI在线AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。

补齐Transformer规划短板又不放弃快速思考,田渊栋团队的Dualformer融合System 1和2双重优势

一个 token 就能控制模型快些解答或慢点思考。OpenAI ο1 模型的发布掀起了人们对 AI 推理过程的关注,甚至让现在的 AI 行业开始放弃卷越来越大的模型,而是开始针对推理过程进行优化了。今天我们介绍的这项来自 Meta FAIR 田渊栋团队的研究也是如此,其从人类认知理论中获得了灵感,提出了一种新型 Transformer 架构:Dualformer。

图灵奖得主Yoshua Bengio新作:Were RNNs All We Needed?

自从 Transformer 模型问世以来,试图挑战其在自然语言处理地位的挑战者层出不穷。这次登场的选手,不仅要挑战 Transformer 的地位,还致敬了经典论文的名字。再看这篇论文的作者列表,图灵奖得主、深度学习三巨头之一的 Yoshua Bengio 赫然在列。

AI 架构 Transformer 再进化:谷歌新方法突破长文本处理,注意力模块内存需求可降至 1/47

科技媒体 marktechpost 昨日(10 月 8 日)发布博文,报道称谷歌公司推出了选择性注意力(Selective Attention)方法,可以提高 Transformer 架构模型的性能。Transformer 架构简介Transformer 是一种革命性的神经网络架构,由谷歌在 2017 年提出,主要用于处理序列数据,特别是在自然语言处理(NLP)领域。Transformer 的核心是自注意力机制,允许模型在处理输入序列时捕捉词与词之间的关系,让模型能够关注输入序列中的所有部分,而不仅仅是局部信息。T

非 Transformer 架构 AI 模型 Liquid 问世,号称性能“凌驾 Meta Llama / 微软 Phi”

去年刚成立的 Liquid AI 公司于 9 月 30 日发布了三款 Liquid 基础模型(Liquid Foundation Models,LFM),分别为 LFM-1.3B、LFM-3.1B 和 LFM-40.3B。这些模型均采用非 Transformer 架构,号称在基准测试中凌驾同规模的 Transformer 模型。AI在线注意到,目前业界在深度学习和自然语言处理方面主要使用 Transformer 架构,该架构主要利用自注意力机制捕捉序列中单词之间的关系,包括 OpenAI 的 GPT、Meta 的

给机器人装上「虫脑」?非Transformer液态神经网络终于来了!MIT CSAIL负责人创业成果

在大模型时代,谷歌 2017 年开创性论文《Attention Is All You Need》中提出的 Transformer 已经成为主流架构。然而,刚刚一家由 MIT 计算机科学与人工智能实验室 (CSAIL) 前研究人员共同创立的初创公司 Liquid AI 却走出了不一样的路线。Liquid AI 表示他们的目标是「探索构建超越生成式预训练 Transformer (GPT) 基础模型的方法」。为了实现这一目标,Liquid AI 推出了其首批多模态 AI 模型:Liquid Foundation Mod

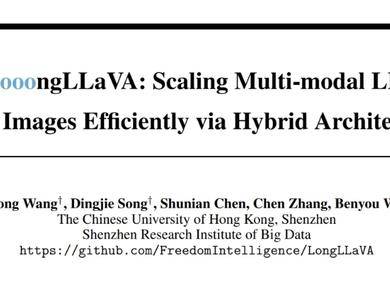

首个Mamba+Transformer混合架构多模态大模型来了,实现单卡千图推理

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:[email protected];[email protected]

CoT能让模型推理能力无上限?田渊栋、LeCun下场反对:两层MLP还能模拟全世界呢

「这相当于在理论上,两层神经网络在理论上可以拟合任何数据,我们就盲目相信并应用在所有场景中。」大模型新范式 OpenAI o1 一经发布,如何「复刻」出 o1 便成为了 AI 圈最热的话题。由于 OpenAI 对技术细节守口如瓶,想从 AI 那里「套话」,让它复述完整的内部推理过程,多问几句,OpenAI 直接发邮件警告要撤销你的使用资格。想从技术报告中想找出点蛛丝马迹,也同样困难。于是,大家将目光转向了以往类似的研究成果,希望从中找到些线索。比如,Google Brain 推理团队创建者 Denny Zhou 立

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

AI新词

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

英伟达

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

代码

AI for Science

苹果

算法

腾讯

Agent

Claude

芯片

Stable Diffusion

具身智能

xAI

蛋白质

开发者

人形机器人

生成式

神经网络

机器学习

AI视频

3D

RAG

大语言模型

字节跳动

Sora

百度

研究

GPU

生成

工具

华为

AGI

计算

大型语言模型

AI设计

生成式AI

搜索

视频生成

亚马逊

AI模型

DeepMind

特斯拉

场景

深度学习

Transformer

架构

Copilot

MCP

编程

视觉