视频生成

图生视频新玩法刷爆外网:图上画两笔就能动起来,终于告别文本提示

现在,AI看你画的就能懂。 Higgsfield AI 这家公司,有点意思。 不仅三天两头上线新功能,在 X 上疯狂刷存在感,还一度被传出和 Meta 洽谈收购事宜,虽然最后不了了之。

8/19/2025 11:09:00 AM

机器之心

腾讯混元开源游戏AI生成新工具!RTX 4090就能制作3A级动态内容

随手拍的一张图,就能秒变3A级游戏大作? ! 刚刚,腾讯全新开源游戏视频生成框架Hunyuan-GameCraft,专为游戏环境设计,让任何人都能轻松搞定游戏制作。

8/14/2025 6:23:20 PM

谷歌Genie3全网玩疯!画质飞跃720P,网友造出西幻RPG游戏

全网疯玩Genie3,惊叹:这才是真正的大世界! 距离上一代Genie2,才刚刚过去7个多月,谷歌世界模型就像开了倍速进化:原本啥也看不清,突然耳聪目明一跃来到720P画质,原来只有几十秒的限时体验,现在也直接拉长到好几分钟。 世界类型也真正实现多重宇宙折叠,自然、历史、奇幻应有尽有。

8/8/2025 9:13:00 AM

一夜颠覆Sora神话,H200单卡5秒出片!全华人团队开源AI引爆视频圈

单块H200,5秒即生一个5秒视频。 最近,UCSD、UC伯克利、MBZUAI三大机构联手,祭出FastWan系视频生成模型。 论文地址:「稀疏蒸馏」全新的训练方案,实现了高效生成,让视频去噪速度实现70倍飙升。

8/7/2025 4:18:35 PM

马斯克再放大招!Grok AI短视频爆火,一夜全网刷屏

Grok的Imagine来了! 刚刚,马斯克宣布:Grok Imagine今天开始向所有Grok Heavy用户推出。 Grok iOS App升级,Imagine功能重磅升级!

8/4/2025 9:17:00 AM

阿里再开源,全球首个MoE视频生成模型登场,电影级美学效果一触即达

继上周开源三连发之后,阿里昨晚又放出了新模型。 这次是全球首个开源的 MoE 架构的视频生成模型 Wan2.2,最大的亮点是具备了电影级美学控制能力。 该模型遵循 Apache 2.0 开源协议。

7/29/2025 3:10:00 PM

机器之心

阿里开源电影级AI视频模型!MoE架构,5B版本消费级显卡可跑

电影级视频生成模型来了。 来自阿里,来自通义——通义万相Wan2.2。 并且率先将MoE架构实现到了视频生成扩散模型中,能够实现电影级效果。

7/29/2025 9:12:00 AM

ICCV高分论文|可灵ReCamMaster在海外爆火,带你从全新角度看好莱坞大片

作为视频拍摄爱好者,你是否曾因为设备限制无法完成想要实现的运镜效果? 例如想要将镜头上移拍摄风景的全貌,但没有入手拍摄无人机;又或是对拍摄素材很满意,但拍摄时手抖影响了成片质量。 作为 AI 视频创作者,是否对于生成视频的内容很满意,然而运镜却不尽人意?

7/24/2025 8:30:00 AM

大神Karpathy都投的AI实时视频生成模型:直播都能立即转,无限时长几乎零延迟

大神Karpathy都忍不住投资的AI初创,带来首个实时扩散视频生成! 用扫帚当麦克风,用盒子当混音台,无需昂贵设备就能开一场沉浸式直播。 喜欢游戏类型但不喜欢游戏的画面?

7/21/2025 8:46:00 AM

无需NeRF/高斯点后处理,视频秒变游戏模型成现实!新方法平均每帧仅需60秒 | ICCV 2025

只需一段视频,就可以直接生成可用的4D网格动画? 来自KAUST的研究团队提出全新方法V2M4,能够实现从单目视频直接生成高质量、显式的4D网格动画资源。 这意味着无需NeRF/高斯点后处理,可直接导入游戏/图形引擎。

7/21/2025 8:45:00 AM

免剪辑直出!AI生成多角色同框对话视频,动态路由精准绑定音频

近年来随着视频生成基础模型的涌现,音频驱动的说话人视频生成领域也取得了显著进展。 但现有方法主要聚焦于单角色场景,现有可生成两个角色对话视频的方法仅能单独地生成两个分离的说话人视频。 针对这一挑战,研究人员提出了首个专注同场景多角色说话视频生成的框架Bind-Your-Avatar该模型基于扩散Transformer(MM-DiT),通过细粒度的嵌入路由机制将「谁在说」与「说什么」绑定在一起,从而实现对音频–角色对应关系的精确控制。

7/17/2025 1:14:05 PM

拍我AI(PixVerse)上线多关键帧生成功能 ,AI视频创作从“片段”迈向“故事性表达”

今天,全球超6000万用户的拍我AI(PixVerse)在首尾帧模块中新增「多关键帧生成」功能。 用户可上传最多7张图片作为关键帧,在首尾帧模式下轻松生成最长30秒的连贯视频,显著增强创作者对AI视频叙事的掌控力。 ▲用户可通过拍我AI网页端首尾帧功能添加最多7张关键帧.

7/11/2025 5:32:21 PM

一水

1080p飞升4k,浙大开源原生超高清视频生成方案,突破AI视频生成清晰度上限

为什么AI生成的视频总是模糊卡顿? 为什么细节纹理经不起放大? 为什么动作描述总与画面错位?

7/2/2025 8:30:00 AM

打破长视频理解瓶颈:HoPE混合位置编码提升VLM长度泛化能力

李浩然,CMU 机器学习系研究生,研究方向是基础模型的长上下文建模、对齐、以及检索增强生成。 如今的视觉语言模型 (VLM, Vision Language Models) 已经在视觉问答、图像描述等多模态任务上取得了卓越的表现。 然而,它们在长视频理解和检索等长上下文任务中仍表现不佳。

6/30/2025 8:50:00 AM

AI秒懂短视频,快手大模型Keye-VL理解力爆表!技术细节全开源

如果有人突然问你:「这张图片中有几颗草莓」? 你会如何快速回复? 面对五彩缤纷的果盘,我们往往需要反复端详,放大图片再逐一清点,耗费不少时间才能得到答案。

6/26/2025 3:05:45 PM

单GPU搞定高清长视频生成,效率×10!引入Mamba机制突破DiT瓶颈 | 普林斯顿&Meta

视频生成模型太贵太慢怎么办? 普林斯顿大学和Meta联合推出的新框架LinGen,以MATE线性复杂度块取代传统自注意力,将视频生成从像素数的平方复杂度压到线性复杂度,使单张GPU就能在分钟级长度下生成高质量视频,大幅提高了模型的可扩展性和生成效率。 实验结果表明,LinGen在视频质量上优于DiT(胜率达75.6%),并且最高可减少15×(11.5×)FLOPs(延迟)。

6/18/2025 4:42:15 PM

10×加速!DCM显著提升视频扩散模型推理效率!HunyuanVideo13B推理时间从1500秒缩短至120秒!

本文由南京大学,香港大学,上海人工智能实验室,中国科学院大学与南洋理工大学 S-Lab 联合完成。 扩散模型在视频合成任务中取得了显著成果,但其依赖迭代去噪过程,带来了巨大的计算开销。 尽管一致性模型(Consistency Models)在加速扩散模型方面取得了重要进展,直接将其应用于视频扩散模型却常常导致时序一致性和外观细节的明显退化。

6/18/2025 4:39:02 PM

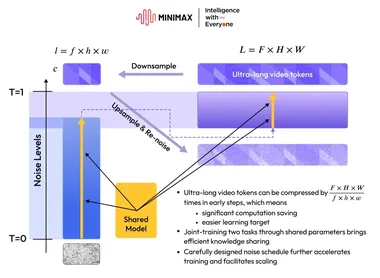

稀宇科技MiniMax推出视频生成模型Hailuo 02

稀宇科技在视频生成领域取得新进展,正式推出全新视频生成模型Hailuo02。 据悉,Hailuo02在处理高度复杂场景如体操动作时表现出色,是目前全球唯一能够实现此类效果的模型。 自去年8月底展示视频生成模型Demo网页以来,稀宇科技推出的海螺视频产品已帮助创作者生成超过3.7亿个视频,此次Hailuo02的推出进一步降低了视频创作门槛,提升了创作质量。

6/18/2025 12:01:54 PM

AI在线

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

马斯克

Gemini

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

开发者

xAI

具身智能

生成式

神经网络

机器学习

3D

人形机器人

AI视频

RAG

大语言模型

研究

百度

Sora

生成

GPU

工具

华为

计算

字节跳动

AI设计

AGI

大型语言模型

搜索

生成式AI

视频生成

场景

DeepMind

特斯拉

深度学习

AI模型

架构

亚马逊

Transformer

MCP

编程

视觉

预测