作为视频拍摄爱好者,你是否曾因为设备限制无法完成想要实现的运镜效果?例如想要将镜头上移拍摄风景的全貌,但没有入手拍摄无人机;又或是对拍摄素材很满意,但拍摄时手抖影响了成片质量。作为 AI 视频创作者,是否对于生成视频的内容很满意,然而运镜却不尽人意?

为了解决以上问题,可灵研究团队提出了一种可将输入视频沿新相机轨迹重新运镜的视频生成模型 ReCamMaster。用户可以上传任意视频并指定新相机拍摄轨迹,实现已有视频的重运镜。该工作还发布了一个高质量多相机同步拍摄的视频数据集 MultiCamVideo-Dataset,数据集和训练、测试代码均已开源。

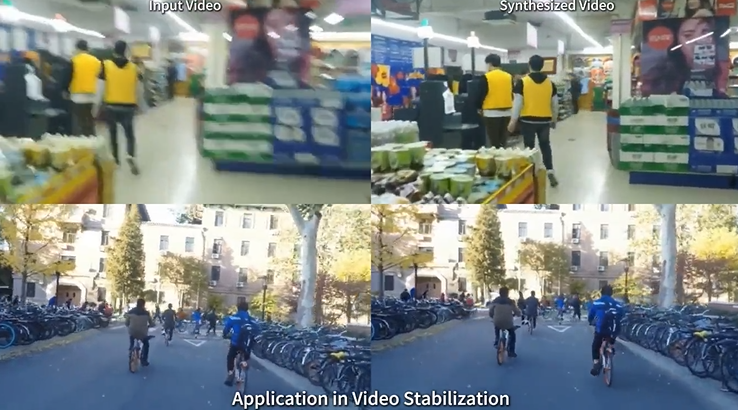

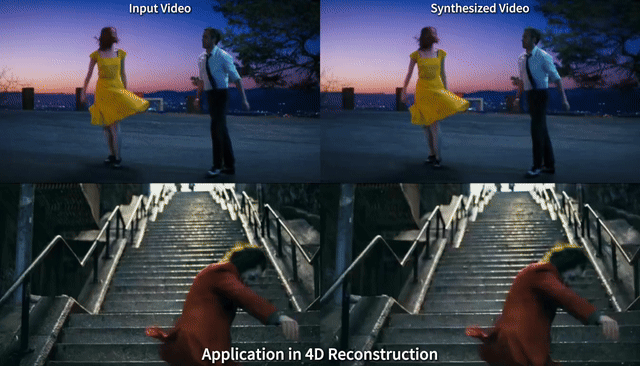

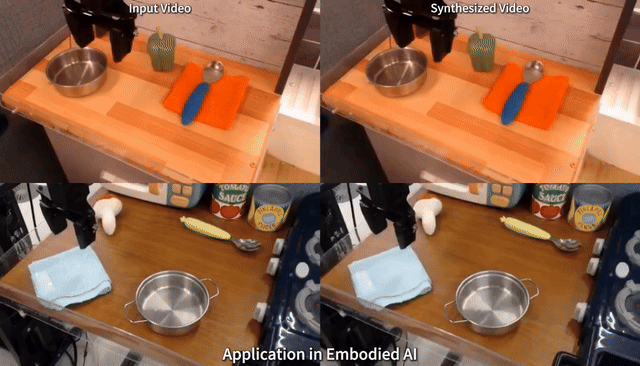

此外,ReCamMaster 在 4D 重建、视频去抖动、自动驾驶、具身智能等领域有较强的应用价值。

- 论文标题:ReCamMaster: Camera-Controlled Generative Rendering from A Single Video

- 项目主页:https://jianhongbai.github.io/ReCamMaster

- 代码:https://github.com/KwaiVGI/ReCamMaster

- 论文:https://arxiv.org/abs/2503.11647

1.ReCamMaster 能力展示

a) 视频重运镜

b) 4D 场景重建

c) 视频去抖动

d) 在自动驾驶、具身智能等场景作为数据生成器

可以观察到,ReCamMaster 生成的视频可以保持原视频中的场景和动态,并在不同场景有较好的泛化性。更多示例请访问项目主页:https://jianhongbai.github.io/ReCamMaster/

2.ReCamMaster 创新点

研究者表示,ReCamMaster 的主要创新点为:

- 提出了一种新的简单且有效的 video conditioning 范式,性能较之前方法有大幅度提升。

- 发布了一个高质量多相机同步拍摄的视频数据集。该数据集在相机可控的视频生成、4D 重建等领域有较高的实用价值。

- 首次将单视频的重运镜效果做到准产品级的性能,验证了视频生成模型在此类任务上的巨大潜力。

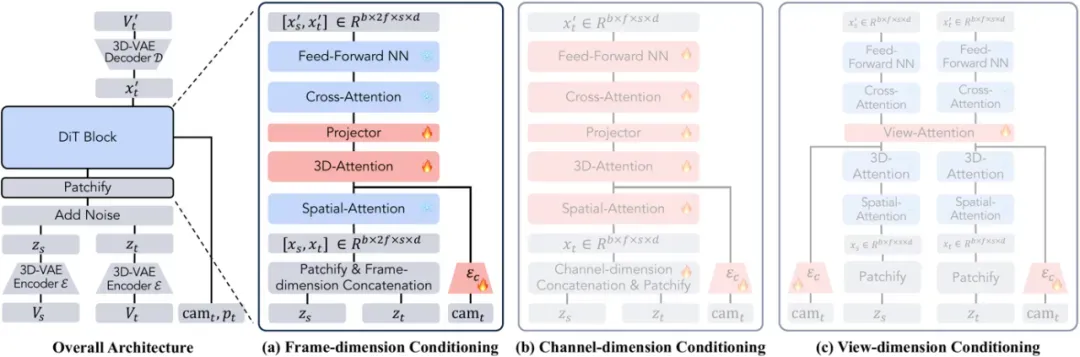

3. ReCamMaster 算法解读

如上图所示,ReCamMaster 的核心创新点在于提出了一种新的 video conditioning 范式,即将 condition video 与 target video 在 patchify 之后沿时间维度拼接。所提出的 video conditioning 范式较之前工作所常用的通道维度拼接有显著的性能提升。

4.MultiCamVideo 数据集

MultiCamVideo 数据集是使用 Unreal Engine 5 渲染的多摄像机同步视频数据集。它包含 13,600 个不同的动态场景,每个场景由 10 个摄像机沿不同的相机轨迹拍摄,总计 136,000 个视频,112,000 个不同的相机轨迹。MultiCamVideo 以 66 个不同的人物为 “主要拍摄对象”,93 种不同的人物动作,和 37 个高质量 3D 环境作为背景。数据集示例如下:

5.ReCamMaster 实验结果

视频中研究者将 ReCamMaster 与最先进的方法进行了比较,ReCamMaster 较 baseline 有较大幅度的性能提升。

6. 总结

在本文中,研究者提出了 ReCamMaster,一种可将输入视频沿新相机轨迹重新运镜的视频生成模型。ReCamMaster 的核心创新点在于提出了一种简单且有效的 video conditioning 范式,其性能显著优于 baseline 方法。此外、研究者还发布了多相机同步视频数据集 MultiCamVideo-Dataset 用于相机可控的视频生成、4D 重建等领域的研究。

更多细节请参阅原论文。