GPU

免费GPU算力部署DeepSeek-R1 32B

前言DeepSeek-R1发布最新版本DeepSeek-R1-0528,显著提升了模型的思维深度与推理能力,在数学、编程与通用逻辑等多个基准测评中取得了当前国内所有模型中首屈一指的优异成绩,并且在整体表现上已接近其他国际顶尖模型,如 o3 与 Gemini-2.5-Pro。 另外,API接口还增加了Function Calling和JsonOutput 的支持。 DeepSeek-R1团队已经证明,大模型的推理模式可以蒸馏到小模型中,与通过强化学习在小模型上发现的推理模式相比,性能更优。

6/12/2025 9:48:27 AM

Meta「轻量级」KernelLLM颠覆GPU内核生成,8B参数碾压GPT-4o

在AI领域,参数规模曾被视为「性能天花板」。 Meta最新发布的KernelLLM,却用8B参数的「小身板」,在GPU内核生成任务中把200B的GPT-4o按在地上摩擦。 这是一个基于Llama 3.1 Instruct进行微调的8B参数模型,旨在将PyTorch模块自动转换为高效的Triton GPU内核。

5/27/2025 3:19:52 PM

新智元

秘塔AI搜索推出全新“极速”模型:最高400 tokens/秒响应速度

近日,秘塔AI搜索正式推出全新“极速”模型,为用户带来更高效、精准的搜索体验。 秘塔AI搜索团队通过在GPU上进行kernel fusion技术,以及在CPU上实施动态编译优化策略,成功在单张H800GPU上实现了最高400tokens/秒的响应速度,大部分问题能在2秒内给出答案。 为了让用户更真切地感受新模型的速度,秘塔AI搜索还特别搭建了一个测速站点(kuai.metaso.cn),用户可随时输入问题,亲自体验新模型带来的快速响应。

5/27/2025 10:01:20 AM

AI在线

NVIDIA全新GeForce GPU震撼亮相!黄仁勋:AI与模拟交织,极致美感颠覆游戏与创作!

NVIDIA在台北COMPUTEX2025大会上正式发布全新GeForce GPU系列,引发全球科技圈热议。 NVIDIA首席执行官黄仁勋在主题演讲中表示:“你在这里看到的都不是艺术,只是恰好很美而已”,强调新GPU通过人工智能与实时模拟的融合,为游戏玩家、内容创作者和AI开发者带来前所未有的视觉与性能体验。 AIbase综合最新动态,深入解析这一突破性发布的技术亮点及其对AI与游戏生态的深远影响。

5/19/2025 6:00:55 PM

AI在线

5090将被秘密定位?美或强制植入「地理追踪」,锁定英伟达高端GPU

最近,美参议员Tom Cotton提出了一项新法案——要为英伟达、AMD等高端GPU装上「地理追踪」功能,防止落入竞争国家手中。 此举,不仅针对的是AI芯片,还涵盖了高性能游戏显卡等硬件。 若是法案通过,这些措施将在6个月后生效。

5/15/2025 2:38:24 PM

Fastino 融资 1750 万美元,利用廉价游戏 GPU 训练 AI 模型

在当今科技行业,AI(人工智能)正迅速崛起,许多巨头公司都在大谈特谈拥有万亿参数的 AI 模型,这些模型通常需要耗费巨资搭建庞大的 GPU 集群。 然而,Fastino 却走了一条不同的道路,利用成本低廉的游戏 GPU 进行 AI 模型训练,并成功获得了由 Khosla Ventures 领投的1750万美元融资。 这一创新的方式使得 Fastino 能够在资源有限的情况下,实现高效的 AI 模型开发。

5/8/2025 12:01:07 PM

AI在线

AI学会“无师自通”?AZR让模型左右互搏,越打越聪明!

一项名为Absolute Zero Reasoner(AZR)的创新项目近日引发广泛关注。 该项目通过一种全新的“绝对零点”训练范式,让大型语言模型(LLM)能够自主提出问题、编写代码、运行验证,并通过自我博弈(self-play)循环提升编程与数学能力。 基于Qwen2.5-7B模型的测试数据显示,AZR在编程能力上提升了5分,数学能力提升了15.2分(满分100分),展现了其在AI自进化领域的巨大潜力。

5/8/2025 10:00:55 AM

AI在线

北京:对采购自主可控 GPU 芯片开展智能算力服务的民营企业按照投资额一定比例给予支持

《北京市促进民营经济健康发展、高质量发展2025年工作要点》近日发布。其中提出,北京将支持民营企业建设智算中心,对采购自主可控GPU芯片开展智能算力服务的企业,按照投资额的一定比例给予支持,还将重点支持民营企业参与绿色创新平台建设。

4/29/2025 4:16:41 PM

远洋

流体力学专用版DeepSeek,单GPU可跑,成本节约高达100倍

又一专业领域成功引入AI工程师! 而且还是基于DeepSeek、Qwen等国产大模型打造,国内研究人员都能用的那种。 不卖关子了,这就是由英国埃克塞特大学初旭副教授团队与北航王文康副教授团队联合打造的OpenFOAMGPT,将AI工程师成功引入计算流体力学(CFD)领域。

4/11/2025 9:22:00 AM

OpenFOAMGPT团队

刚刚,特朗普扼杀全美GPU供应链?科技大厂核心AI算力告急,硅谷陷巨大恐慌

关税大棒一出,连全美的GPU供应链也危在旦夕了? 昨夜,美股经历了5年未遇的史诗级暴跌,更可怕的是,AI界已经被特朗普的关税政策,搞得乱成一锅粥了! 今天,纳斯达克综合指数直接跌超了近6%,与近一年来的新低仅一步之遥。

4/7/2025 8:38:00 AM

新智元

英伟达GPU命名背后:是情怀,也是致敬伟人的智慧! 新智元 新智元 2025年04月05日 12:17

在上周结束的GTC大会上,老黄用两个多小时向我们介绍了英伟达过去一年的进展。 其中,最让人们关注就是「每年一更」的用于未来AI工厂的GPU芯片架构路线图。 2024年,Blackwell GPU发布;2025年上半年,Blackwell GPU已经全面发货;2025年下半年,推出Blackwell Ultra;2026年下半年,将重磅发布Vera Rubin;2027年下半年,推出Rubin Ultra;再往后,就是2028年上市的Feynman。

4/7/2025 8:07:00 AM

新智元

25万GPU,估值350亿美元冲刺IPO!财务定时炸弹,GenAI不祥之兆

美国云服务公司CoreWeave,已提交上市文件,即将IPO。 这是美国近期首个有意义的科技IPO,也是首个直接与AI热潮相关的IPO。 CoreWeave虽然有25万GPU,却频频受到质疑。

3/21/2025 12:56:44 PM

新智元

苏州发布加快发展AI芯片产业的若干措施||苏州市加快发展AI芯片产业的若干措施

《苏州市加快发展AI芯片产业的若干措施(征求意见稿)》公开征求意见。 其中提到,做强骨干核心企业。 聚焦GPU通用型芯片、ASIC专用型芯片、FPGA半定制化芯片、存算一体芯片、硅光芯片等重点方向,加大招商力度,加快引育一批带动性强的优质项目、头部企业,对重点项目在空间保障、场地建设、人才引进等方面予以综合支持。

3/18/2025 1:45:00 PM

AI在线

狂投AI!英伟达风险投资激增,2024年出手49次,远超往年总和!

在人工智能革命的浪潮中,没有哪家公司比英伟达更具优势。 自从两年多前 ChatGPT 引爆市场以来,这家高性能 GPU 巨头的收入、盈利能力和现金储备一路飙升,其股价也随之水涨船高。 凭借日益增长的财富,英伟达正积极扩大其在人工智能领域的投资版图,尤其是在初创企业方面。

3/17/2025 10:28:24 AM

AI在线

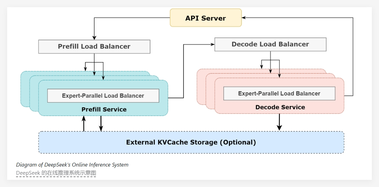

DeepSeek开源周第六天:极致推理优化系统,提高GPU计算效率

在人工智能(AI)技术快速发展的今天,DeepSeek 团队推出了其全新的 DeepSeek-V3/R1推理系统。 这一系统旨在通过更高的吞吐量和更低的延迟,推动 AGI(通用人工智能)的高效发展。 为了实现这一目标,DeepSeek 采用了跨节点专家并行(Expert Parallelism,EP)技术,显著提高了 GPU 的计算效率,并在降低延迟的同时,扩展了批处理规模。

3/3/2025 9:45:00 AM

AI在线

尴尬!OpenAI CEO称内部GPU短缺,GPT-4.5发布将分阶段进行

日前,,OpenAI 首席执行官山姆・阿尔特曼(Sam Altman)在社交平台 X 上宣布,因公司 GPU 资源耗尽,最新模型 GPT-4.5的发布将被迫采取分阶段的方式。 阿尔特曼表示,GPT-4.5的规模巨大且成本高昂,因此需要 “成千上万” 的 GPU 才能支持更多的 ChatGPT 用户接入该模型。 据悉,GPT-4.5将首先向 ChatGPT Pro 的订阅用户开放,预计于本周四启动。

2/28/2025 9:03:00 AM

AI在线

AI工厂中的炒作与现实

AI工厂作为新兴的数据中心概念,正引领着AI处理技术的革新,然而,其真正潜力如何?成本与挑战又有哪些?本文将深入探讨AI工厂的现状与未来。 你可能听说过“AI工厂”这个词,但它到底意味着什么?到目前为止,这个概念更多地被炒作而非明确定义,主要是由英伟达在推动。 该公司的愿景是数据中心里装满高端AI加速器,但这个愿景是现实可行的,还是只是战略营销手段?简而言之,AI工厂是专为AI处理而设计的专业化数据中心,而非用于托管数据库、文件存储、业务应用或网络服务等传统工作负载。

2/28/2025 8:00:00 AM

Andy Patrizio

DeepSeek开源FlashMLA:Hopper GPU解码新标杆,测评大揭秘!

DeepSeek今天正式启动为期五天的开源成果发布计划,首个亮相的项目是FlashMLA。 这一开源项目将先进的MLA算法与GPU优化技术相结合,为大模型推理提供了一套高性能、低延迟的解码方案。 FlashMLA是一款专门为Hopper GPU(比如H800 SXM5)优化的高效MLA解码内核,旨在加速大模型的计算任务,尤其是在NVIDIA高端显卡上提升性能。

2/25/2025 10:09:00 AM

新闻助手

资讯热榜

早鸟票倒计时3天|第四届全国大模型智能生成大会(LMG 2025)

美国女子使用ChatGPT生成号码购彩中奖10万美元:概率事件而非AI预测能力

AI音乐创作成程序员新副业:单曲播放破200万,版权收入数万元

OpenAI 紧急暂停 Sora生成马丁・路德・金形象,AI 视频生成引发热议!

推理提速4倍!莫纳什、浙大提出动态拼接,大小模型智能协作

AI 模型“炒股”比拼!DeepSeek 收益超14%,Gemini2.5Pro 惨亏四成

全新开源的DeepSeek-OCR,可能是最近最惊喜的模型!

AICoding减慢了软件交付!旧金山创始人警告:AI改变了节奏,压力更大!团队七成时间耗在外环;AI泡沫非坏事;解决问题是关键

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

机器人

数据

大模型

Midjourney

开源

Meta

智能

微软

用户

AI新词

GPT

学习

技术

智能体

马斯克

Gemini

图像

Anthropic

英伟达

AI创作

训练

论文

LLM

代码

算法

芯片

Stable Diffusion

AI for Science

腾讯

苹果

Claude

Agent

蛋白质

开发者

生成式

神经网络

xAI

机器学习

3D

人形机器人

研究

AI视频

生成

百度

大语言模型

Sora

工具

GPU

具身智能

RAG

华为

计算

字节跳动

AI设计

搜索

AGI

大型语言模型

视频生成

场景

深度学习

架构

DeepMind

视觉

预测

Transformer

伟达

编程

生成式AI

AI模型

特斯拉

Copilot