GPU

全球 AI 面临 6000 亿美元难题,人工智能泡沫正在接近临界点

【新智元导读】AI 基础设施的巨额投资,和实际的 AI 生态系统实际收入之间,差距已经到了不可思议的地步。曾经全球 AI 面临的 2000 亿美元难题,如今已经翻成了 6000 亿美元。现在,业内关于 AI 模型收入的质疑声,已经越来越大。动辄投入几万亿美元打造基础设施,跟部分国家的 GDP 不相上下,然而从 AI 模型中得到的回报,究竟能有几何?在 2023 年 9 月,来自红杉资本的 David Cahn 发表了一篇名为《AI 的 2000 亿美元问题》的文章,目的是探讨:「AI 的收入都去哪了?」根据报告,当

7/4/2024 5:14:30 PM

清源

13瓦功耗处理10亿参数,接近大脑效率,消除LLM中的矩阵乘法来颠覆AI现状

编辑 | 萝卜皮通常,矩阵乘法 (MatMul) 在大型语言模型(LLM)总体计算成本中占据主导地位。随着 LLM 扩展到更大的嵌入维度和上下文长度,这方面的成本只会增加。加州大学、LuxiTech 和苏州大学的研究人员声称开发出一种新方法,通过消除过程中的矩阵乘法来更有效地运行人工智能语言模型。这从根本上重新设计了目前由 GPU 芯片加速的神经网络操作方式。研究人员描述了如何在不使用 MatMul 的情况下创建一个自定义的 27 亿参数模型,性能与当前最先进的 Transformer 模型相当。该研究以「Scal

7/4/2024 3:42:00 PM

ScienceAI

首个类 Sora 开源复现方案,Open Sora 可在英伟达 RTX 3090 显卡上 AI 生成视频:最高 4 秒 240P

作为全球首个类 Sora(OpenAI 的文本生成视频模型)开源复现方案,Open-Sora 可以在英伟达 RTX 3090 GPU 上基于文本生成视频,最高可以生成 240P 分辨率、时长最长 4 秒的视频。处理 AI 任务的 GPU 云服务提供商 Backprop 展示了基于 Open-Sora V1.2 的 AI 环境,展示 4 个基于提示词生成的视频。Backprop 表示:“在 RTX 3090 GPU 上,用户可以生成最高 240p、时长 4 秒的视频,生成 2 秒视频大约需要 30 秒,4 秒视频大约

6/28/2024 2:11:17 PM

故渊

Yandex 开源 LLM 训练工具节省高达 20% 的 GPU 资源

跨国科技公司 Yandex 最近推出了 YaFSDP,这是一种用于训练大型语言模型 (LLM) 的开源方法。YaFSDP 是目前最有效的公开可用工具,用于增强 GPU 通信并减少 LLM 训练中的内存使用量,与 FSDP 相比,其训练速度提升最高可达 26%,具体取决于架构和参数数量。通过使用 YaFSDP 减少 LLM 的训练时间可以节省高达 20% 的 GPU 资源。Yandex 承诺为全球人工智能社区的发展做出贡献,将YaFSDP开源提供给全球的 LLM 开发人员和人工智能爱好者即是履行此承诺的其中一步。“目

6/11/2024 5:18:00 PM

新闻助手

马斯克称将为 xAI 购买约 30 万块英伟达 AI 芯片,预估至少花费 90 亿美元

马斯克北京时间今天凌晨在回复一则投票时透露,xAI 的下一项重大举措可能是在明年夏天购买约 30 万块配备 CX8 网络的 B200 芯片。xAI 已在近期获得了 60 亿美元(IT之家备注:当前约 435.6 亿元人民币)融资,公司估值达到约 180 亿美元(当前约 1306.8 亿元人民币)。目前,xAI 计划通过加大对 GPU 集群的投资,大幅扩展其 AI 相关的产品组合。今年 4 月,X 平台(推特)博主“The Technology Brother”曾发帖表示,Meta 公司目前已经拥有约 35 万个 H

6/3/2024 4:44:09 PM

清源

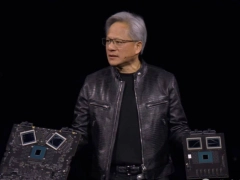

英伟达黄仁勋解读“CEO 数学”:花小钱,办大事

英伟达首席执行官黄仁勋日前在 2024 台北电脑展前夕提出了一个有趣的概念 ——“CEO 数学”。“买得越多,省得越多,” 黄仁勋在演讲中表示,“这就是 CEO 数学,它并不完全准确,但却很有效。”乍一听让人困惑?黄仁勋随后解释了这个概念的含义。他建议企业同时投资图形处理器 (GPU) 和中央处理器 (CPU)。这两种处理器可以协同工作,将任务完成时间从“100 个单位缩短到 1 个单位”。因此,从长远来看,增加投资反而能节省成本。这种结合使用 CPU 和 GPU 的做法在个人电脑领域已经很普遍。“我们往一台 10

6/3/2024 11:26:54 AM

远洋

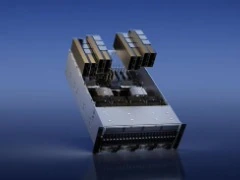

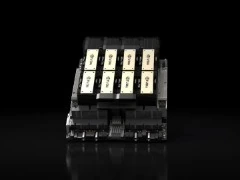

黄仁勋一口气解密三代 GPU,量产英伟达 Blackwell 解决 ChatGPT 全球耗电难题

感谢IT之家网友 佳宜 的线索投递!【新智元导读】刚刚,老黄又高调向全世界秀了一把:已经量产的 Blackwell,8 年内将把 1.8 万亿参数 GPT-4 的训练能耗狂砍到 1/350;英伟达惊人的产品迭代,直接原地冲破摩尔定律;Blackwell 的后三代路线图,也一口气被放出。就在刚刚,老黄手持 Blackwell 向全世界展示的那一刻,全场的观众沸腾了。它,是迄今为止世界最大的芯片!▲ 眼前的这块产品,凝聚着数量惊人的技术如果用老黄的话说,它就是「全世界迄今为止制造出来的最复杂、性能最高的计算机。」▲ 8

6/3/2024 9:26:06 AM

汪淼

马斯克旗下 xAI 公司宣布 B 轮融资达 60 亿美元

感谢埃隆・马斯克(Elon Musk)旗下人工智能初创公司 xAI 今日在博客文章中宣布,该公司已在 B 轮融资中筹集了 60 亿美元(IT之家备注:当前约 435.6 亿元人民币),投资方包括 Andreessen Horowitz 和红杉资本等。xAI 表示,这笔资金将用于把 xAI 的首批产品推向市场、建设先进的基础设施并加速未来技术的研发。“未来几周将会有更多消息公布,xAI 的投前估值为 180 亿美元”马斯克在 X 上的一篇帖子中回应融资公告时表示。xAI 于 2023 年 7 月成立,去年 11 月推

5/27/2024 2:29:13 PM

汪淼

世界最大开源 AI 社区 Hugging Face 将免费提供 1000 万美元共享 GPU,帮助小企业对抗大公司

世界最大的开源 AI 社区 Hugging Face(IT之家注:通称“抱抱脸”)日前宣布,将提供 1000 万美元的免费共享 GPU 帮助开发者创造新的 AI 技术。具体来看,Hugging Face 这次做出此举的目的是帮助小型开发者、研究人员和初创公司对抗大型 AI 公司,避免 AI 进步陷入“集中化”。Hugging Face 首席执行官 Clem Delangue 在接受 The Verge 采访时表示,对能够投资社区感到很幸运,此次之所以能够进行投资,是因为公司“已经盈利,或正走在盈利的路上”。前段时间

5/16/2024 9:25:39 PM

清源

扎克伯格:AI 数据中心 GPU 紧缺正在缓解,电力将成新瓶颈

Meto CEO 马克・扎克伯格(Mark Zuckerberg)近日在接受油管 Dwarkesh Patel 频道采访时表示,AI 数据中心的 GPU 紧缺已在缓解过程中,未来的瓶颈将是电力供应。扎克伯格首先提到,此前一段时间,IT 企业即使资金充足也难以买到全部所需数量的 AI GPU,但这一情况目前已开始缓解。目前新建的单一数据中心在整体功耗方面可达到 50~100MW 乃至 150MW;但扎克伯格认为 1GW 级别的数据中心不会很快出现,毕竟这相当于将一整个核电机组的发电能力用于训练 AI(IT之家注:作为

5/13/2024 1:29:39 PM

溯波(实习)

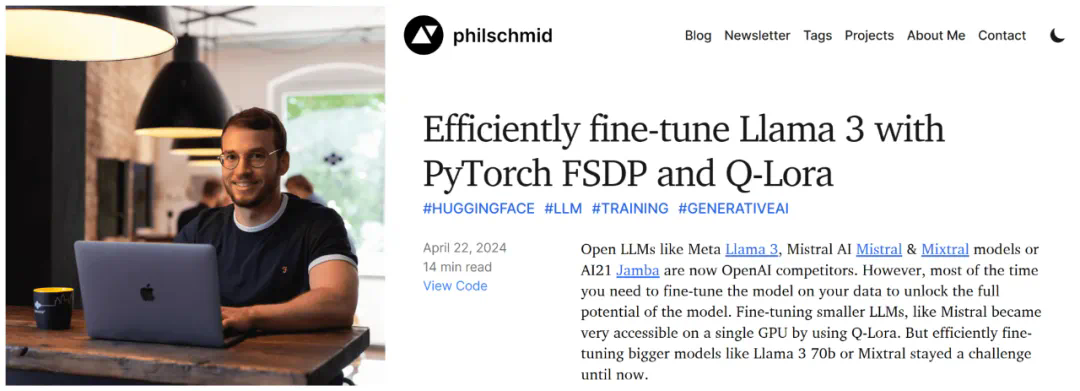

仅用250美元,Hugging Face技术主管手把手教你微调Llama 3

大语言模型的微调一直是说起来容易做起来难的事儿。近日 Hugging Face 技术主管 Philipp Schmid 发表了一篇博客,详细讲解了如何利用 Hugging Face 上的库和 fsdp 以及 Q-Lora 对大模型进行微调。我们知道,Meta 推出的 Llama 3、Mistral AI 推出的 Mistral 和 Mixtral 模型以及 AI21 实验室推出的 Jamba 等开源大语言模型已经成为 OpenAI 的竞争对手。不过,大多数情况下,使用者需要根据自己的数据对这些开源模型进行微调,才能

5/6/2024 2:41:00 PM

机器之心

英特尔 Falcon Shores GPU 明年晚些时候推出,已为 AI 负载重构

英特尔在上月末举行的一季度电话财报会议上明确,Falcon Shores GPU 将于 2025 年晚些时候推出。另据外媒 HPCwire 报道,该处理器正重新设计,以适应 AI 产业需求。英特尔 CEO 帕特・基辛格称,Falcon Shores 将结合完全可编程的架构和 Gaudi 3 加速器优异的系统性能,用户可在两代硬件间实现顺利且无缝的升级转换。英特尔表示,AI 业界正转向 Python 或 Triton 等更高级别的软件抽象,采用开放式软件平台以减少依赖。而英特尔的软件堆栈正日趋成熟,可消除从 Gaud

5/6/2024 1:39:37 PM

溯波(实习)

老黄最新采访出炉!自述 61 年坚持成就了英伟达,AI 革命点燃全世界

【新智元导读】过去一年的时间,英伟达市值突破 2 万亿美元,一举成为 21 世纪的 AI 巨头。在老黄的最新采访中,向我们展示了即将到来的工业革命是怎样的。全球进入 2 万亿美元俱乐部的公司,仅有 4 家 —— 微软、苹果、谷歌,以及英伟达。在过去一年中,位于加利福尼亚的计算机芯片制造商英伟达,市值从 1 万亿,飙升到 2 万亿美元。这得益于大模型掀起的 AI 狂潮,急剧放大了全世界对算力的需求。从 Grace 架构,到全新的 Blackwell,英伟达的创新为生成式 AI 和加速计算,带来了突破性的进步。那么,这

4/29/2024 3:49:12 PM

清源

英伟达 H100 AI GPU 短缺缓解,交货时间从 3-4 个月降至 2-3 个月

曾几何时,英伟达用于人工智能计算的 H100 GPU 供不应求。然而据 Digitimes 报道,台积电的台湾地区总经理 Terence Liao 表示,过去几个月英伟达 H100 的交货等待时间已经大幅缩短,从最初的 3-4 个月降至目前的 2-3 个月(8-12 周)。服务器代工厂商也透露,相比 2023 年几乎无法买到英伟达 H100 的情况,目前供应瓶颈正在逐步缓解。尽管交货等待时间有所缩短,Terence Liao 表示,对于人工智能硬件的需求仍然非常旺盛。即使价格昂贵,用于人工智能的服务器采购也正在取代

4/11/2024 9:32:44 AM

远洋

仅次于 Meta,马斯克透露特斯拉囤积的英伟达 H100 芯片数量

埃隆・马斯克麾下的特斯拉和其神秘的以人工智能为核心的公司 xAI,储备了大量的英伟达 H100 系列芯片。特斯拉意欲借此攻克自动驾驶的终极难题 ——L5 级自动驾驶,而 xAI 则肩负着实现马斯克的“终极真相人工智能”愿景。X 平台用户“The Technology Brother”最近发布消息称,Meta 公司已经囤积了全球最多的 H100 GPU,数量达到惊人的 35 万块。然而,马斯克对该排行榜将特斯拉和 xAI 的排名边缘化表示不满(1 万颗),并指出“如果计算正确,特斯拉应该是第二名,xAI 将是第三名”

4/9/2024 9:00:48 AM

远洋

英伟达开卷价格!最新 Blackwell GPU 架构 / 成本揭秘,彰显老黄的「仁慈」

【新智元导读】老黄新 GPU 深夜炸场,超高规格的背后也付出了不小的代价,小编带大家深入了解一下新架构的硬件细节和成本,新显卡的售价究竟高不高?英伟达也不得不开始卷了老黄的新 GPU 又在深夜炸场,震撼了所有的观众。除了硬件参数上的震撼之外,大家伙最想知道的还是新 GPU 的售价会不会同样震撼。下面就让我们从规格参数、工艺节点、封装设计等方面来深入分析一下新一代 Blackwell GPU 的系统、定价、利润,以及 Jensen's Benevolence(老黄的仁慈)在这个大模型的时代,英伟达正处于世界之巅,拥有

4/2/2024 5:45:36 PM

清源

英伟达 AI 芯片 H200 开始供货,性能相比 H100 提升 60%-90%

感谢据日本经济新闻今日报道,英伟达的尖端图像处理半导体(GPU)H200 现已开始供货。H200 为面向 AI 领域的半导体,性能超过当前主打的 H100。根据英伟达方面公布的性能评测结果,以 Meta 公司旗下大语言模型 Llama 2 处理速度为例,H200 相比于 H100,生成式 AI 导出答案的处理速度最高提高了 45%。市场调研机构 Omdia 曾表示,2022 年英伟达在 AI 半导体市场约占 8 成的份额,与此同时 AMD 等竞争对手也在开发对抗英伟达的产品,竞争愈演愈烈。英伟达当地时间 3 月 1

3/28/2024 6:19:52 PM

清源

首个 AI 游戏引擎或颠覆任天堂 / 暴雪?0 代码即可创建,黄仁勋预测 5-10 年游戏完全由 AI 生成

【新智元导读】还有什么领域没有被 AI 渗透?继音乐之后,首个 AI 游戏引擎已经完全凭几个字,就能创建游戏资产和动画了。老黄预测,未来 5-10 年我们将看到完全由 AI 生成的游戏。「未来 5-10 年,我们可以看到完全由 AI 生成的游戏」。这是近日 GTC 2024 大会之后,黄仁勋接受媒体时采访时发表的最新看法。其实,现在的游戏创建,早已到了只说一句话的地步了!近日,一家专注研发无代码游戏引擎的初创公司 BuildBox AI,发布了新一代 AI 游戏引擎 ——Buildbox 4 Alpha。它可以做到

3/25/2024 4:55:06 PM

清源

资讯热榜

早鸟票倒计时3天|第四届全国大模型智能生成大会(LMG 2025)

美国女子使用ChatGPT生成号码购彩中奖10万美元:概率事件而非AI预测能力

AI音乐创作成程序员新副业:单曲播放破200万,版权收入数万元

OpenAI 紧急暂停 Sora生成马丁・路德・金形象,AI 视频生成引发热议!

推理提速4倍!莫纳什、浙大提出动态拼接,大小模型智能协作

AI 模型“炒股”比拼!DeepSeek 收益超14%,Gemini2.5Pro 惨亏四成

全新开源的DeepSeek-OCR,可能是最近最惊喜的模型!

AICoding减慢了软件交付!旧金山创始人警告:AI改变了节奏,压力更大!团队七成时间耗在外环;AI泡沫非坏事;解决问题是关键

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

机器人

数据

大模型

Midjourney

开源

Meta

智能

微软

用户

AI新词

GPT

学习

技术

智能体

马斯克

Gemini

图像

Anthropic

英伟达

AI创作

训练

论文

LLM

代码

算法

芯片

Stable Diffusion

AI for Science

腾讯

苹果

Claude

Agent

蛋白质

开发者

生成式

神经网络

xAI

机器学习

3D

人形机器人

研究

AI视频

生成

百度

大语言模型

Sora

工具

GPU

具身智能

RAG

华为

计算

字节跳动

AI设计

搜索

AGI

大型语言模型

视频生成

场景

深度学习

架构

DeepMind

视觉

预测

Transformer

伟达

编程

生成式AI

AI模型

特斯拉

Copilot