EMNLP 2025

EMNLP 2025 | 视频理解Token压缩新范式,减少70.8%推理延迟!

在大语言模型的浪潮中,视频大语言模型(VideoLLMs)正以惊人的速度进化,生成的响应越来越精细。 然而,“慢”与计算量大依然是制约其大规模应用的最大痛点。 视频序列中海量视觉token导致的二次方复杂度,让处理一个长视频往往需要漫长的等待,尤其在高分辨率或长序列场景下。

12/15/2025 3:33:00 PM

新闻资讯

跨层压缩隐藏状态同时加速TTFT和压缩KV cache!

我们都知道 LLM 中存在结构化稀疏性,但其底层机制一直缺乏统一的理论解释。 为什么模型越深,稀疏性越明显? 为什么会出现所谓的「检索头」和「检索层」?

11/13/2025 1:10:00 PM

机器之心

EMNLP 2025 | CARE:无需外部工具,让大模型原生检索增强推理实现上下文高保真

近日,来自 MetaGPT、蒙特利尔大学和 Mila 研究所、麦吉尔大学、耶鲁大学等机构的研究团队发布 CARE 框架,一个新颖的原生检索增强推理框架,教会 LLM 将推理过程中的上下文事实与模型自身的检索能力有机结合起来。 该框架现已全面开源,包括训练数据集、训练代码、模型 checkpoints 和评估代码,为社区提供一套完整的、可复现工作。 项目主页::: & 数据集:“外部搜索”到“原生检索”的转变1、现有方法的困境目前解决上下文保真度问题主要有两条路:1.

10/6/2025 6:22:00 PM

机器之心

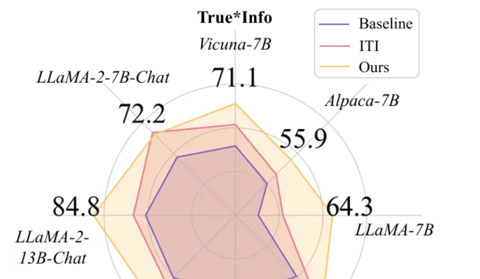

大模型“精细化”对齐,真实性提升25.8%刷新SOTA!token级精准编辑,无需训练即插即用

提升大模型对齐能力新方法,在TruthfulQA任务上真实性指标提升25.8%,刷新当前最优性能! 方法名为Token-Aware Editing (TAE),是一种token感知的推理时表征编辑方法。 该方法首次系统性地从token层面解决了传统表征编辑技术的问题,无需训练、即插即用,可广泛应用于对话系统、内容审核、偏见mitigation等场景。

9/27/2025 12:58:47 PM

衡宇

EMNLP 2025|vivo 等提出 DiMo-GUI:模态分治+动态聚焦,GUI 智能体推理时扩展的新范式

本文入选 EMNLP 2025 Main ConferenceEMNLP会议全称为Conference on Empirical Methods in Natural Language Processing,由国际计算语言学协会ACL举办,是自然语言处理和人工智能领域最重要的学术会议之一。 EMNLP 2025会议共有8174篇投稿,Main Conference接收率仅为22.16%。 项目主页:,针对多模态大语言模型(MLLMs)在复杂图形用户界面(GUI)定位任务中的挑战,通过动态视觉推理与模态感知优化显著提升性能。

9/4/2025 11:58:42 AM

互联网算法团队

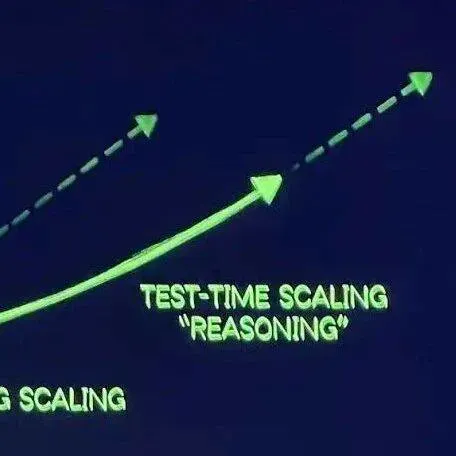

告别无效计算!新TTS框架拯救19%被埋没答案,推理准确率飙升

大语言模型通过 CoT 已具备强大的数学推理能力,而 Beam Search、DVTS 等测试时扩展(Test-Time Scaling, TTS)方法可通过分配额外计算资源进一步提升准确性。 然而,现有方法存在两大关键缺陷:路径同质化(推理路径趋同)和中间结果利用不足(大量高质量推理分支被丢弃)。 为解决这些问题,华为诺亚方舟实验室联合香港中文大学等机构的研究人员提出逐步推理检查点分析(SRCA)框架 —— 在推理步骤间引入 “检查点”,并集成两大核心策略:(1)答案聚类搜索(Answer-Clustered Search):根据中间检查点答案对推理路径进行分组,在保证质量的同时维持路径多样性;(2)检查点候选增强(Checkpoint Candidate Augmentation):利用所有中间答案辅助最终决策。

9/2/2025 3:09:00 PM

机器之心

EMNLP 2025 | 动态压缩CoT推理新方法LightThinker来了

随着 AI 技术的飞速发展,从「快思考」到 「慢思考」,大语言模型(LLMs)在处理复杂推理任务上展现出惊人的能力。 无论是我们熟知的思维链(CoT),还是更复杂的深度思考模式(Thinking),都让 AI 的回答日益精准、可靠。 然而,这种性能的提升并非没有代价。

8/28/2025 2:12:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

Gemini

马斯克

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

特斯拉

场景

AI模型

深度学习

亚马逊

架构

Transformer

MCP

编程

Copilot

视觉