大语言模型

人工智能中的智能体内存:持久内存是如何重新定义大语言模型应用程序的

译者 | 张哲刚审校 | 重楼人工智能(AI) 从根本上改变了我们的生活、工作以及通信方式。 GPT-4、BERT、Llama 等大语言模型 (LLM) 在对话式人工智能方面取得了显著进步,不但响应迅速,而且做到了拟人化。 即便如此,这些系统仍然普遍存在一个致命缺陷,那就是无法在单个会话之外保留上下文信息。

首个科学计算基座大模型BBT-Neutron开源!突破大科学装置数据分析瓶颈

高能物理是探索宇宙基本组成与规律的前沿科学领域,研究粒子在极高能量下的相互作用,是揭示宇宙起源、暗物质与暗能量等未解之谜的重要手段。 高能物理实验(如粒子对撞实验、暗物质与暗能量实验等)产生的数据量极为庞大且复杂,传统的数据分析方法在处理海量数据和复杂物理结构时,面临计算瓶颈。 近期,arXiv上更新了一篇名为《Scaling Particle Collision Data Analysis 》的论文。

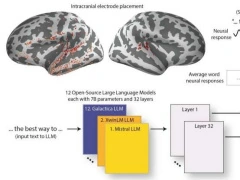

美国哥伦比亚大学研究:大语言模型正在变得越来越像人类大脑

哥伦比亚大学和费因斯坦医学研究所的研究团队近期进行了一项研究,探索了LLM与大脑神经反应的相似性。研究表明,随着LLM技术的进步,这些模型不仅在性能上有所提升,而且结构上也越来越接近人类大脑。

谷歌发布 FACTS Grounding 基准:Gemini、GPT-4o、Claude 当评委,成 AI 大语言模型“幻觉照妖镜”

12 月 18 日消息,谷歌 DeepMind 团队于 12 月 17 日发布博文,宣布推出 FACTS Grounding 基准测试,评估大型语言模型(LLMs)根据给定材料是否准确作答,并避免“幻觉”(即捏造信息)的能力,从而提升 LLMs 的事实准确性,增强用户信任度,并拓展其应用范围。 数据集在数据集方面,ACTS Grounding 数据集包含 1719 个示例,涵盖金融、科技、零售、医疗和法律等多个领域,每个示例包含一篇文档、一条要求 LLM 基于文档的系统指令和随附的提示词。 示例文档长度不一,最长可达 32000 个 token(约 20000 字)。

Differential Transformer: 通过差分注意力机制提升大语言模型性能

Transformer模型已经成为大语言模型(LLMs)的标准架构,但研究表明这些模型在准确检索关键信息方面仍面临挑战。 今天介绍一篇名叫Differential Transformer的论文,论文的作者观察到一个关键问题:传统Transformer模型倾向于过分关注不相关的上下文信息,这种"注意力噪声"会影响模型的性能。 在这篇论文中,作者注意到transformer模型倾向于关注不相关的上下文。

清华本科生获NeurIPS Math-AI 杰出论文奖:REBASE算法让小模型实现推理大突破

刚刚由清华大学本科生伍垟圳为一作的论文《推理Scaling Laws:面向语言模型问题求解的计算最优推理实证分析》在顶级AI学术会议NeurIPS 2024 Math-AI上荣获杰出论文奖(Outstanding Paper Award)。 这项研究不仅刷新了人们对推理阶段计算优化的理解,还为如何在有限计算资源下实现更高效的大语言模型(LLM)推理提供了全新的思路论文亮点:推理阶段的计算优化新突破1. 小模型也能打败大模型:重新定义推理阶段的效率论文系统性地研究了不同模型大小和推理策略在固定计算预算下的表现,发现小模型(如Llemma-7B)在结合高级推理算法后,能够实现比大模型(如Llemma-34B)更优的成本性能平衡。

如何在安卓手机上本地安装和运行LLM?

译者 | 布加迪审校 | 重楼了解如何将AI的力量径直带入到你的安卓手机上:没有云,没有互联网,只有纯粹的设备端智能! 在安卓手机上本地运行大语言模型(LLM)意味着你可以在不依赖云服务器或互联网连接的情况下访问人工智能(AI)模型。 这种本地环境通过确保数据安全、并在设备端来确保隐私。

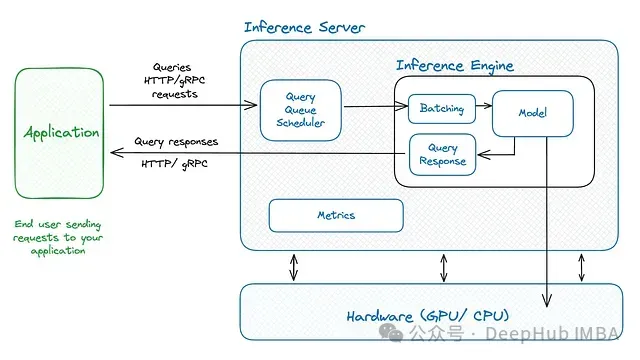

ORCA:基于持续批处理的LLM推理性能优化技术详解

大语言模型(LLMs)推理过程中的批处理优化面临显著挑战,这主要源于其推理过程的迭代特性。 核心问题在于批处理中的各个请求完成时间存在差异,这导致资源释放和新请求整合的复杂性显著提高,特别是在处理不同完成阶段的请求时。 当批处理中序列的生成长度差异较大时,GPU资源利用率往往不够理想。

Hymba:结合注意力头和SSM头的创新型语言模型方案

近年来,大语言模型(LLM)在各个领域取得了显著成效。 但现有的Transformer架构存在计算复杂度高、内存消耗大等问题。 而状态空间模型(SSM)如Mamba虽然具有常数复杂度和优化的硬件性能,但在记忆回溯任务上表现较弱。

从本地部署到企业级服务:十种主流LLM推理框架的技术介绍与对比

大语言模型(Large Language Models, LLMs)的部署是一项具有技术挑战性的工作。 随着模型架构日益复杂,以及硬件需求不断提升,部署过程变得愈发复杂。 业界已经发展出多种解决方案,使LLM的部署和扩展变得更加便捷。

将大语言模型集成到现有软件系统的完整指南

译者 | 布加迪审校 | 重楼随着最近应用迅速普及开来、人工智能(AI)得到广泛采用,大语言模型(LLM)已变得备受广大公司企业、开发人员和非开发人员的欢迎,因为它们为用户提供了诸多好处。 它们帮助开发人员调试代码并生成代码片段,还帮助澄清看似复杂的编程概念和任务,从而提高生产力。 只要用于训练的数据集涵盖主题,使用LLM的非开发人员就可以受益于对问题做出快速且定制的响应和答复。

LLM破局泛化诊断难题,MSSP刊登北航PHM实验室健康管理大模型交叉研究

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:[email protected];[email protected]。

如何借助Cortex运行本地LLM

译者 | 布加迪审校 | 重楼AI行业正在经历一场转变,转向更小巧更高效的大语言模型(LLM),从而使用户能够在本地机器上运行模型,无需功能强大的服务器。 本教程将指导你借助Cortex运行本地LLM,着重介绍其独特的功能和易用性,使任何拥有标准硬件的人都可以享用AI。 注意:Cortex目前正在积极开发中,这可能会导致bug或某些功能无法正常运行。

Salesforce 首席执行官:大语言模型可能已接近技术上限,AI 的未来是智能体

他认为人工智能的未来在于自主代理(即俗称的“AI智能体”),而不是目前用于训练 ChatGPT 等聊天机器人的大型语言模型(LLM)。

多样任务真实数据,大模型在线购物基准Shopping MMLU开源|NeurIPS&KDD Cup 2024

谁是在线购物领域最强大模型? 也有评测基准了。 基于真实在线购物数据,电商巨头亚马逊终于“亮剑”——联合香港科技大学、圣母大学构建了一个大规模、多任务评测基准Shopping MMLU,用以评估大语言模型在在线购物领域的能力与潜力。

Nature:「人类亲吻难题」难倒 LLM,所有大模型全部失败

Nature 上的一项研究,全面驳斥了 LLM (大语言模型)具有类人推理能力的说法。研究者设定的「人类亲吻难题」把 7 个大模型彻底绕晕。最终研究者表示,与其说 LLM 是科学理论,不如说它们更接近工具,比如广义导数。

谷歌Gemini咒骂学生凸显AI失控风险

随着AI技术的迅猛发展,大语言模型应用(例如谷歌的Gemini和OpenAI的ChatGPT)已逐渐融入日常生活,帮助人们完成作业、解答各种问题。 然而,最近的一起事件再次引发了对AI模型潜在风险的广泛关注。 Gemini咒骂学生去死近日,一位Reddit学生用户分享了一段与Google聊天机器人Gemini的对话,令人不寒而栗。

SMoA: 基于稀疏混合架构的大语言模型协同优化框架

在大语言模型(LLM)快速发展的背景下,研究者们越来越关注如何通过多代理系统来增强模型性能。 传统的多代理方法虽然避免了大规模再训练的需求,但仍面临着计算效率和思维多样性的挑战。 本文提出的稀疏代理混合(Sparse Mixture-of-Agents, SMoA)框架,通过借鉴稀疏专家混合(Sparse Mixture-of-Experts, SMoE)的设计理念,有效解决了这些问题。

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI新词

AI绘画

大模型

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

英伟达

Gemini

智能体

技术

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

AI for Science

代码

腾讯

苹果

算法

Agent

Claude

芯片

具身智能

Stable Diffusion

xAI

蛋白质

人形机器人

开发者

生成式

神经网络

机器学习

AI视频

3D

字节跳动

大语言模型

RAG

Sora

百度

研究

GPU

生成

华为

工具

AGI

计算

生成式AI

AI设计

大型语言模型

搜索

亚马逊

AI模型

视频生成

特斯拉

DeepMind

场景

Copilot

深度学习

Transformer

架构

MCP

编程

视觉