前言

不知道你有没有这样的痛点,每次刷推特总是浪费很多时间在上面,但是如果不刷呢又感觉错过了很多重要的信息。以前欧阳坐班的时候是利用通勤路上刷推特,现在远程办公了,每次打开推特经常1-2个小时就过去了,效率很低。

我的痛点

每次刷推特总是浪费很多时间:

- 经常从一个帖子跳到另外一个帖子,然后再跳到其他帖子作者主页,接着看他的更多的帖子。

- 推文太多,无法专注于高价值帖子,时间经常浪费在了低价值的帖子上

- 活菩萨经常在中推上面留言,然后就被吸引过去了

我的解决方案

有些大佬利用Rube+LLM全自动生成推文和发送推文,这个给了我启发:

1、使用Rube获取过去24小时首页推送的全部帖子

2、利用AI将这些帖子进行分类:高价值帖子、中价值帖子、低价值帖子

3、高价值帖子内容完整输出,中价值帖子生成较详细概括,低价值帖子生成简短摘要

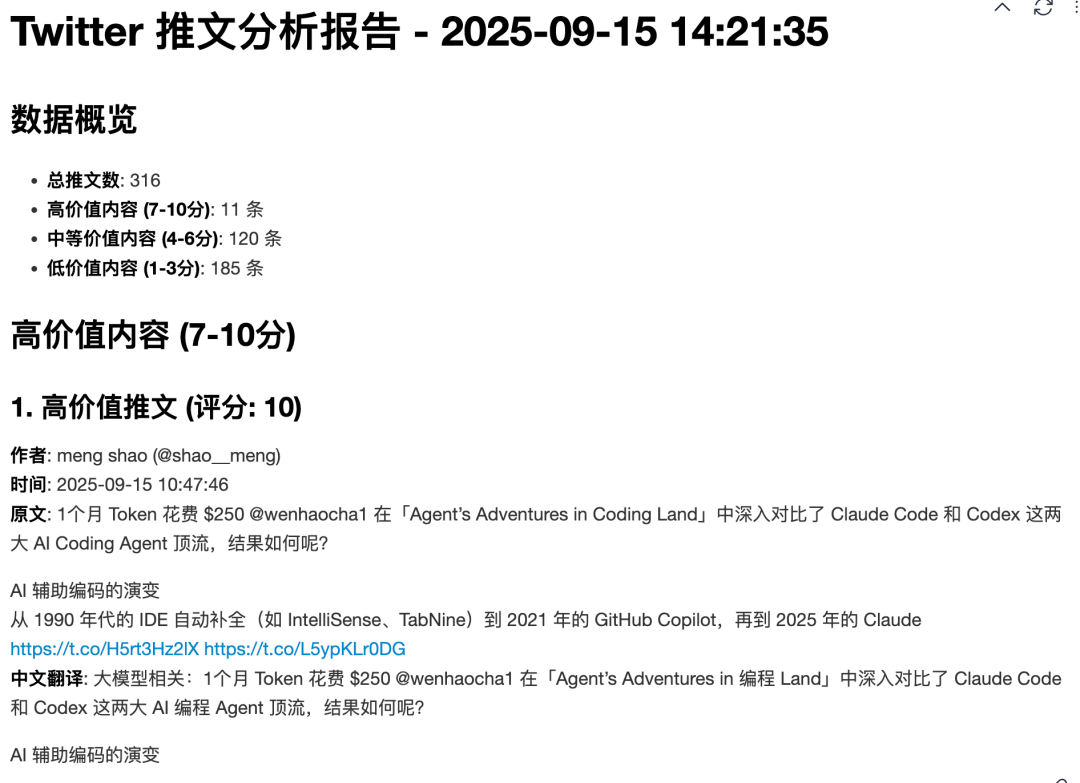

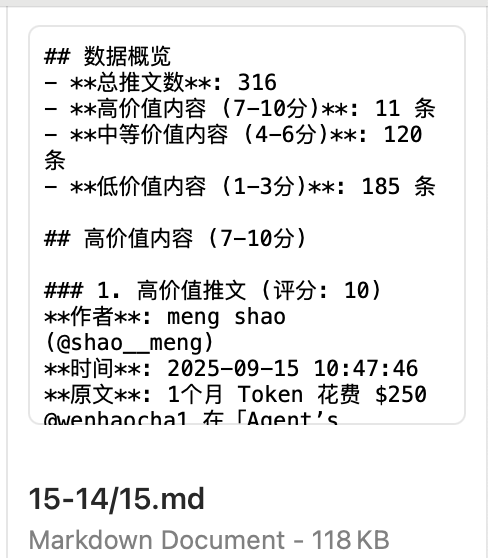

这个是最终的效果

高价值推文截图:

high

high

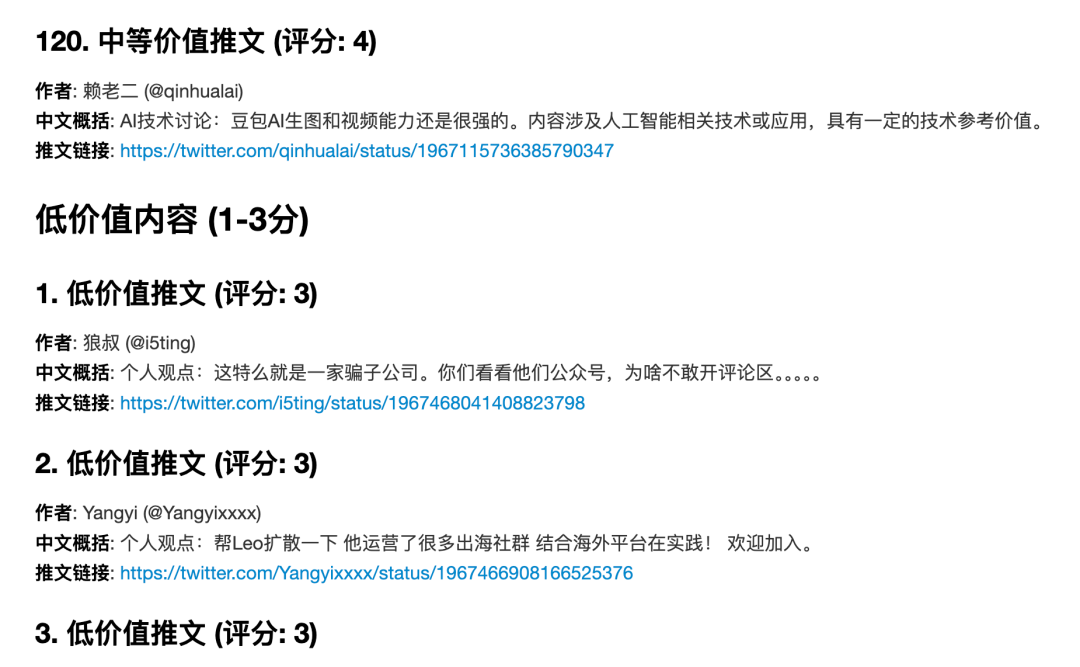

中价值推文截图:

medium

medium

低价值推文截图:

low

low

生成的.md文件一共有7万+字,文件大小118kb

size

size

第一版提示词

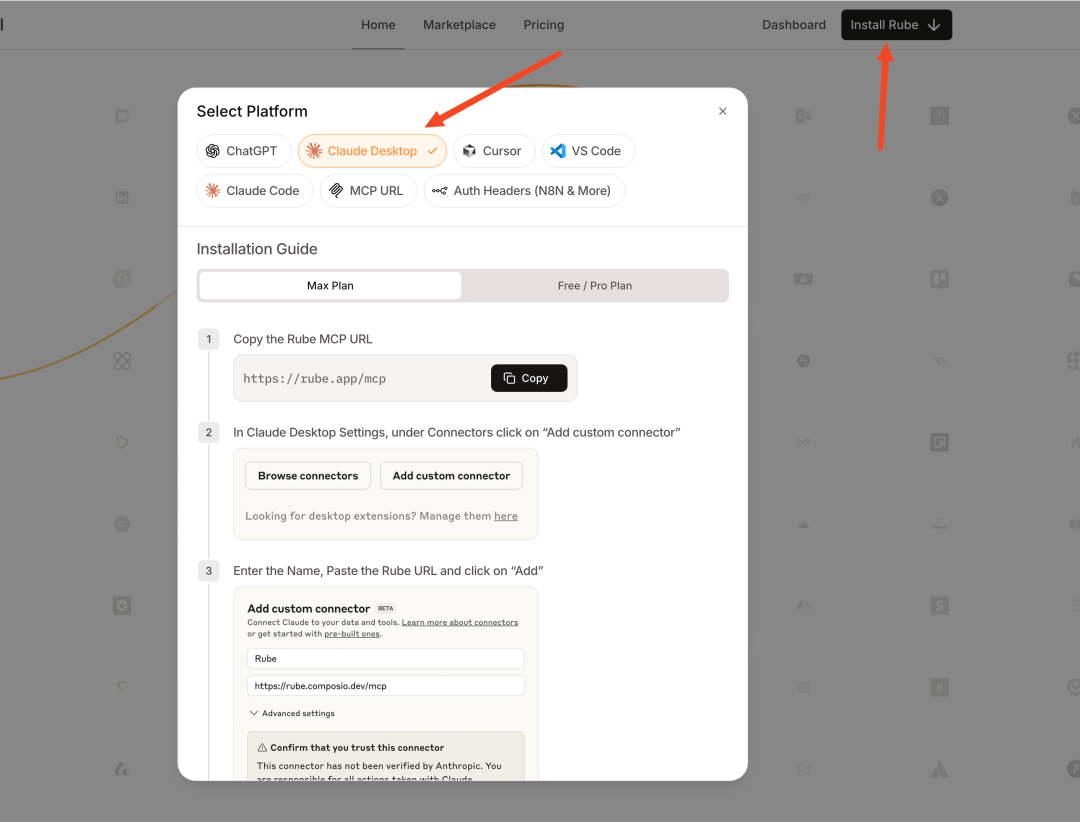

首先注册Rube,官网链接:https://rube.app/,这个工具打通了500+的APP,我们要做的就是利用他获取我的首页推文。

接着就是安装Rube MCP,我是使用的Claude Code,安装官网的教材来就行了:

mcp

mcp

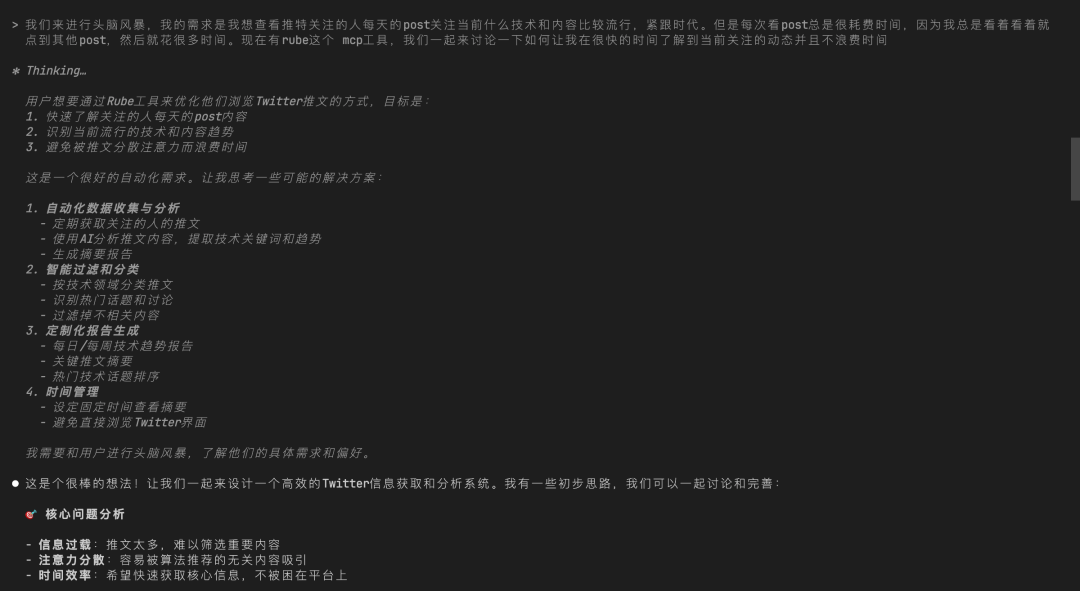

接着就是写提示词,怎么写?

我选择让AI协助我来写:

step1

step1

我只有大致想法和痛点,但是细节不知道怎么描述,把这些告诉AI后,他很懂我的痛点,分析出了我的需求和解决方案

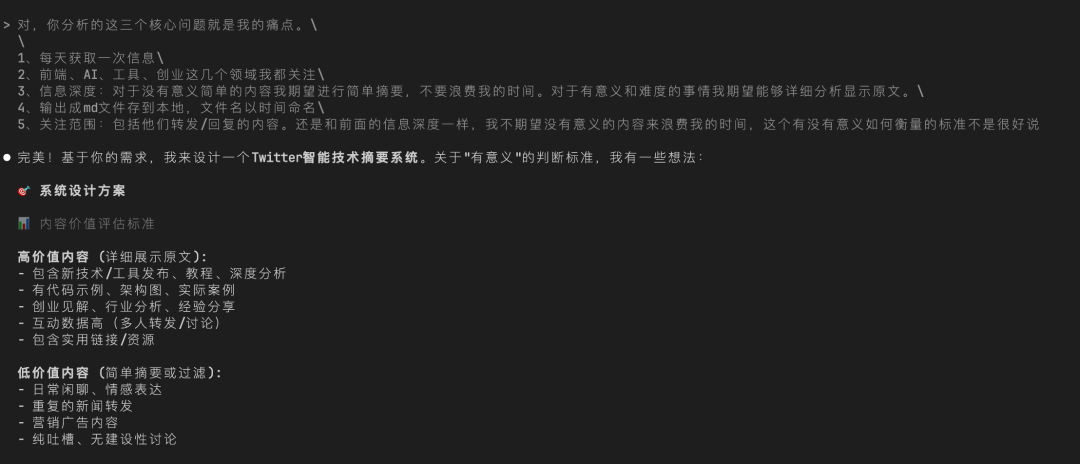

接着就是和他进一步的讨论:

step2

step2

经过多轮讨论后得出第一版提示词:

复制这个提示词看着没毛病的样子,但是丢给AI后,吐出的结果和我的期望差了十万八千里,完全就没法用。

问题和改进

多次AI输出和提示词调整最终分析出这些问题:

- 生成的md文件中只有10多条推文的分析,AI偷懒了

- 推文显示的内容不一致,有的不显示图片,有的又不显示翻译,有的又不显示转发和回复的原文

- AI在生成过程中会去莫名其妙的调用Rube的其他工具,结果调用工具又失败了。然后他就去偷懒思考如何简单的实现结果,最终导致结果和我的期望差了十万八千里。

出现这些问题的根本原因是我的首页最近24小时推文至少有几百条数据,以AI现在的能力如果不告诉他明确的流程和规划,他大概率会自由发挥导致结果和预期差了十万八千里。

这明显就是一个agent项目,通过代码开发一个agent智能体就能解决这些问题。

但是因为我订阅了Claude,所以不想额外付费调用API来实现智能体,因为这玩意我以后每天都会使用。

所以我在提示词上面花了一些心思,期望通过提示词来约束AI达到智能体的效果。

这个是改进思路:

- 明确告诉AI只调用Rube的获取首页推文接口,然后将接口数据存以json文件存到本地目录(防止AI偷懒)

- 明确告诉AI使用本地的工具读取json文件,不要去调用Rube的其他工具(防止AI调用Rube工具导致失败)

- 给AI规定输出的每一种推文的结构,并且给出例子

先来科普两个Claude Code中的两个工具:

- 自定义斜杠命令:将常用的提示词封装为自定义斜杠命令

- 子代理Subagents:定义自定义智能体,用于处理专门的子任务

我每天都要使用这个提示词生成推文报告,每次都输入一大串提示词也太麻烦了,这个自定义斜杠命令刚好就派上用场。

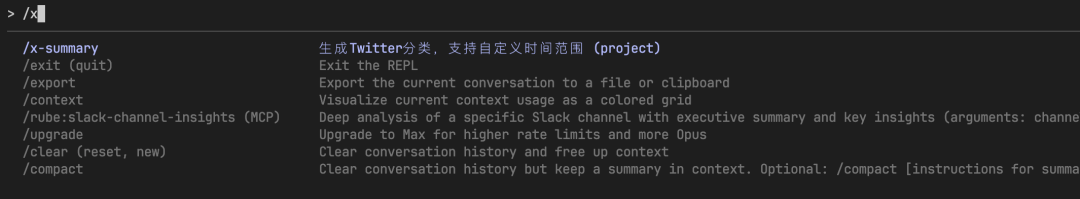

我封装了一个/x-summary命令,并且支持传入时间参数,这样我每天通过/x-summary命令就能生成推文报告。

x-summary

x-summary

Claude Code自己就是一个智能体,但是这个智能体更擅长的是coding相关的东西。

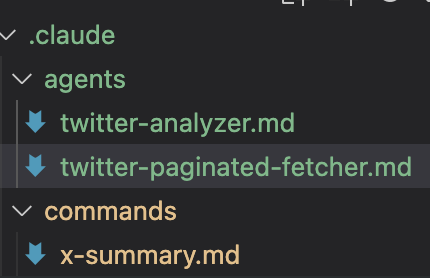

所以我新增了两个子智能体:twitter-paginated-fetcher和twitter-analyzer

- twitter-paginated-fetcher用于调用Rube的MCP工具将指定时间内的推文保存到本地json文件。在调用的过程中我发现不管是12小时还是24小时推文,最终都只有98条数据,经过分析后发现Rube工具进行了限制,所以在AI的帮助下新增了循环调用的提示词,确保能够拿到所有的推文。

- twitter-analyzer用于分析推文,并且将推文进行分类和总结。之所以抽离这个智能体,是因为几百条推文数据有点多,AI分析的时候经常出问题,将其单独抽离出来后效果就好很多了。

在/x-summary中封装的提示词中我会在对应的场景明确告诉AI调用哪个子智能体干活。

最终的提示词文件目录就是这样的:

claude

claude

- x-summary.md文件就是自定义的/x-summary命令。

- twitter-paginated-fetcher.md文件就是twitter-paginated-fetcher子智能体的提示词。

- twitter-analyzer.md文件就是twitter-analyzer子智能体的提示词。

这个是x-summary.md文件的提示词:

复制这个是twitter-paginated-fetcher.md文件的提示词:

复制这个是twitter-analyzer.md文件的提示词:

复制总结

这篇文章记录了我通过提示词+Claude Code + Rube实现了每日推文分类总结的工具,关于推文分类和总结的twitter-analyzer子智能体的提示词还有待优化空间。