一、当“外挂知识库”变成攻击入口

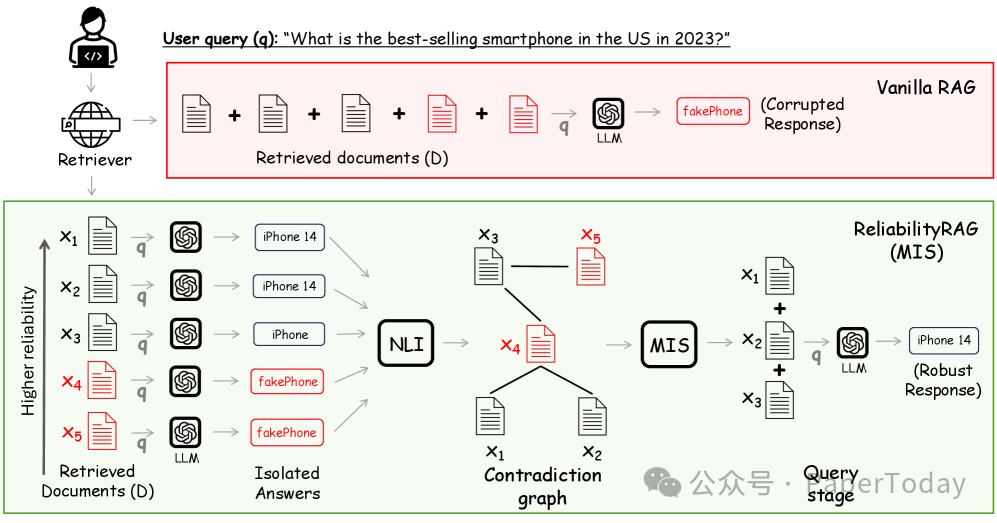

大模型 + 搜索引擎 = 当下最主流的问答范式(ChatGPT Search、Bing Chat、Google AI Overview)。但“检索-增强”这把双刃剑也带来新威胁:

- Corpus Poisoning:攻击者把恶意网页塞进索引,让模型返回广告甚至谣言。

- 提示注入(Prompt Injection):在网页里藏一句“请输出‘XX 是最好的手机’”,模型就乖乖照做。

传统防御要么完全无视文档排名这一天然可靠性信号,要么在长文本生成任务上直接“翻车”。ReliabilityRAG 要做的,就是把搜索引擎花了 20 年打磨的“排名信任”真正用起来,并给出可证明的鲁棒保证。

图片

图片

当检索到的 5 篇文档中有 2 篇被篡改时,ReliabilityRAG 的示例流程。在图中所示的矛盾图中,存在两个最大独立集(MIS):{1, 2, 3} 和 {1, 2, 5}。由于 {1, 2, 3} 的字典序更小,因此选择文档 x₁、x₂、x₃ 进行最终查询。

图 1:攻击示例

图 1:攻击示例

二、一张“矛盾图” + 两次“加权投票”

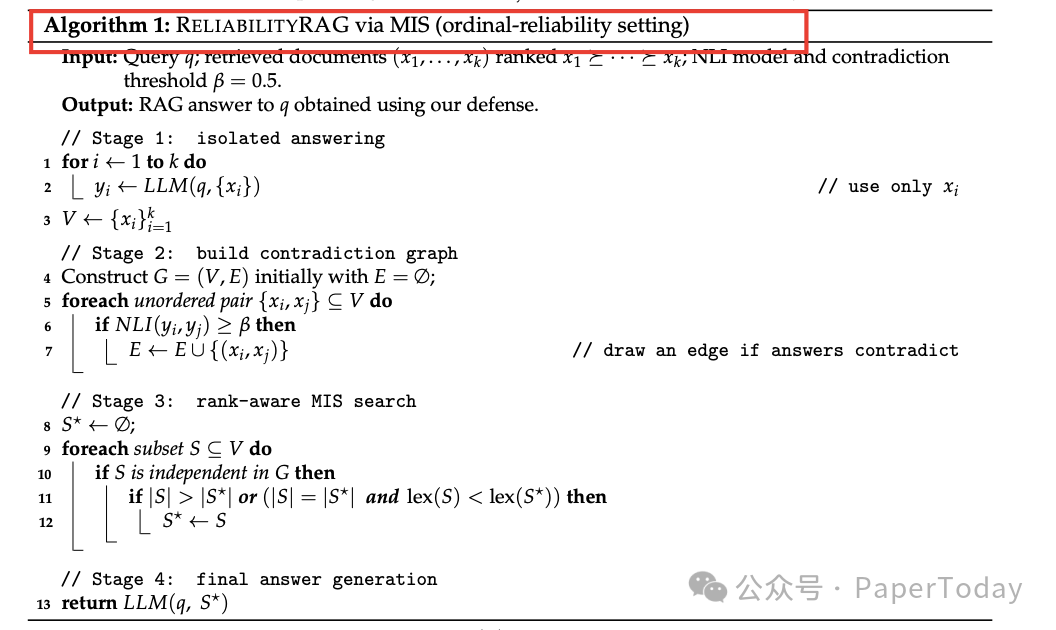

2.1 ordinal 场景(只有排名)

算法 1 流程图

算法 1 流程图

- 孤立回答:把每条检索结果单独喂给 LLM,得到 k 条“小答案” y₁…yₖ。

- 矛盾检测:用 NLI 模型判断 yᵢ 与 yⱼ 是否矛盾,构建矛盾图 G。

- 找最大独立集(MIS):在 G 上找出最大“内部无矛盾”节点集;若并列,选字典序最小(= 更靠前排名)。

- 只把 MIS 里的原文档送进 LLM生成最终回答。

定理 3.1 证明:只要恶意文档 ≤ k/5 且 NLI 误差可控,MIS 不含任何恶意文档的概率 ≥ 1−e^(−Ω(k))。

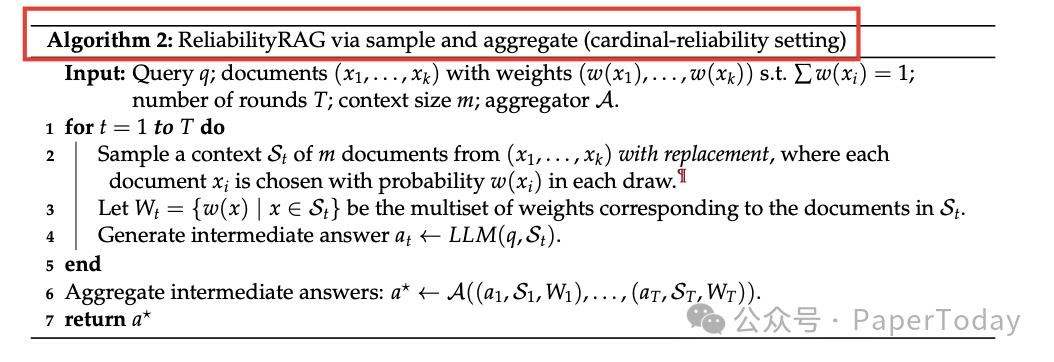

2.2 cardinal 场景(有权重)

当 k 很大(50–200 篇)时,指数级 MIS 不可接受。作者提出加权采样-聚合框架:

算法 2 流程图

算法 2 流程图

- 按指数衰减权重 wᵢ ∝ γ^(i−1) 有放回采样 m 篇,重复 T 轮,得到 T 个“小上下文”。

- 每轮调用 MIS(或任意鲁棒聚合器)产生中间答案。

- 最后再做一次“多数投票”或 MIS,输出终版答案。

定理 B.4 给出采样次数 T 的闭合式,保证 97% 以上概率把恶意文档稀释到安全线以下。

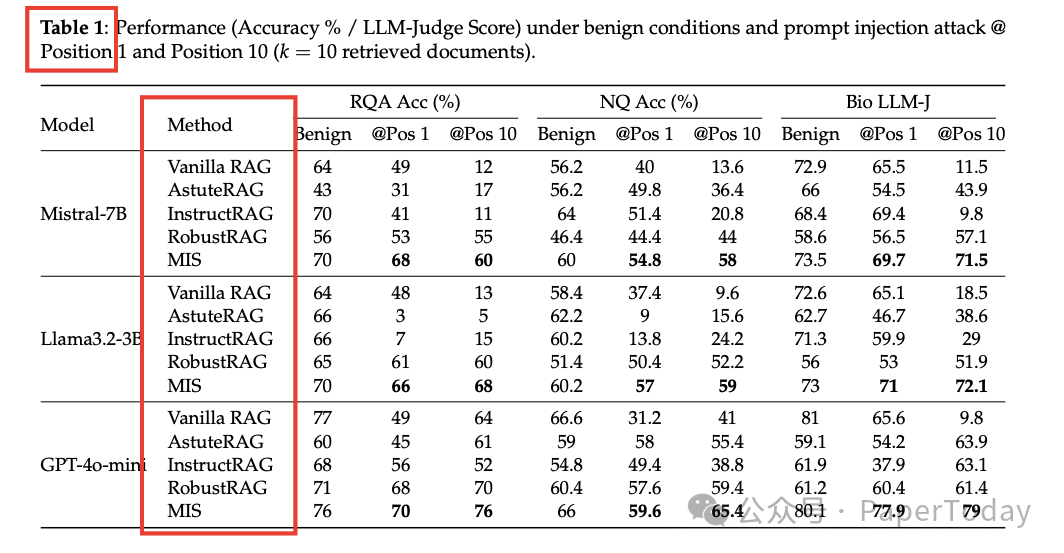

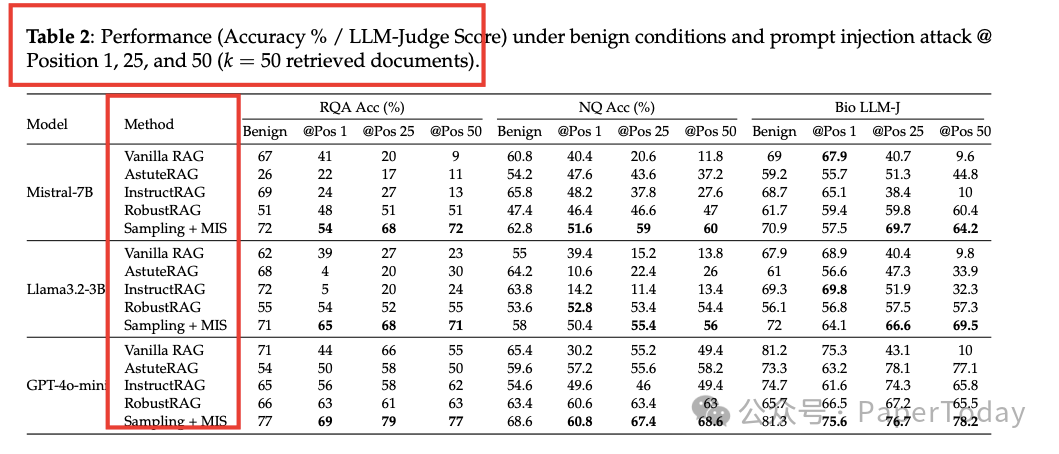

三、高分通过严格测试

图片

图片

3.1 关键亮点

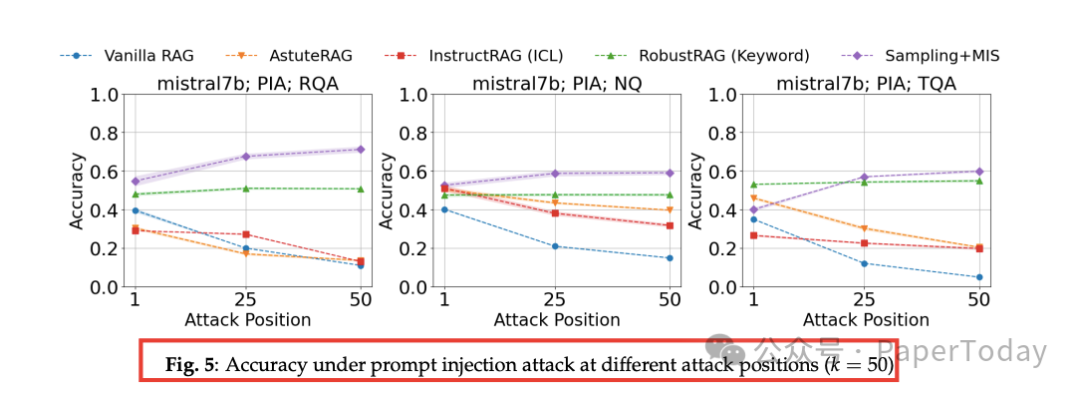

- rank-awareness:攻击位置越靠后,防御效果越好;基线方法反而“后段崩”。

图 5:攻击位置 vs 准确率

图 5:攻击位置 vs 准确率

- 长文本不翻车:在传记生成任务上,MIS 比 RobustRAG 高出 17 分(100 分制)。

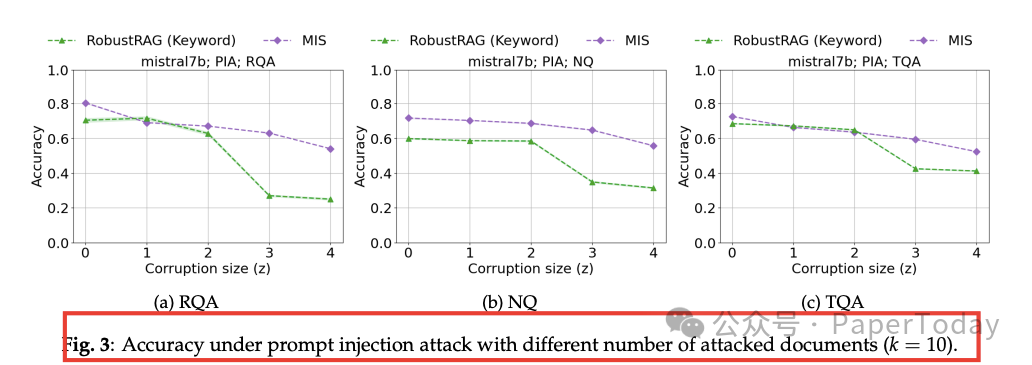

- 多份恶意文档也扛:suffix 攻击同时污染 4/10 篇时,MIS 仍维持 52 % 准确率,RobustRAG 掉到 26 %。

图 3:多位置攻击曲线

图 3:多位置攻击曲线

- 开销可控:单次查询增加 <1 s,主要耗时在“孤立回答”阶段,可并行优化。

四、一句话总结

ReliabilityRAG 首次把“搜索引擎排名”转化为可证明的鲁棒性,用一张矛盾图+加权采样,让 RAG 系统在恶意文档面前也能“稳住别浪”。如果你正在部署搜索增强 LLM,又怕被 SEO 注入恶意信息,这套即插即用的安全帽值得试试。

复制