OpenMemory MCP(Model Context Protocol)正式推出,为AI工具提供统一的本地记忆共享解决方案。这一开源工具允许用户将AI交互内容存储在本地,并通过MCP协议共享至支持的客户端,如Claude、Cursor和Windsurf,只需维护一份记忆内容即可实现跨工具上下文同步。AIbase观察到,OpenMemory MCP的发布迅速引发开发者热议,被认为是提升AI工作流效率的重大创新。

核心功能:本地存储,跨工具共享

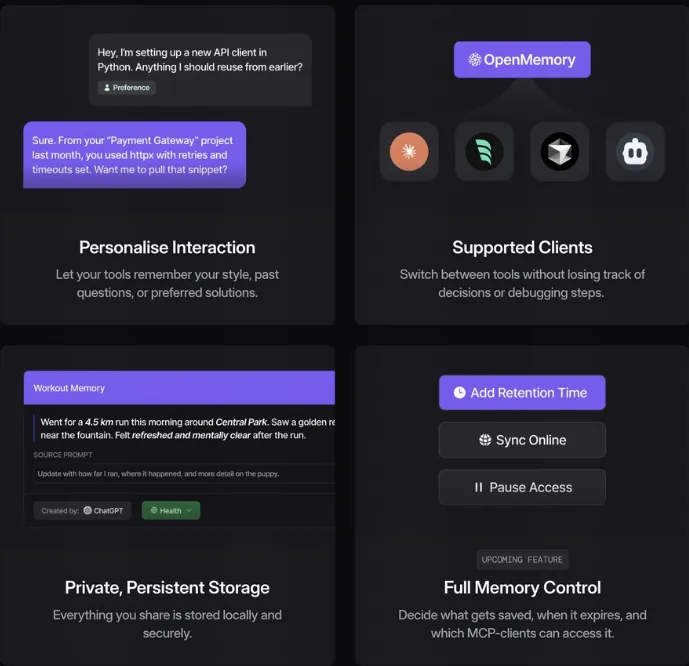

OpenMemory MCP通过本地记忆层,为MCP兼容客户端提供持久化、上下文感知的记忆管理。其主要功能包括:

统一本地存储:所有AI交互内容(如项目需求、代码风格偏好)存储于用户设备,确保数据隐私与控制权。

跨工具记忆共享:支持Claude、Cursor、Windsurf等MCP客户端无缝访问同一记忆库,无需重复输入上下文。

元数据增强:记忆内容附带话题、情绪和时间戳等元数据,便于搜索与管理。

可视化仪表板:内置OpenMemory仪表板提供集中管理界面,支持添加、浏览、删除记忆及控制客户端访问权限。

AIbase了解到,OpenMemory MCP通过Qdrant向量数据库和Server-Sent Events(SSE)实现高效记忆存储与实时通信。社交媒体反馈显示,开发者对工具的本地化运行和跨工具一致性评价极高,尤其适合多工具协作场景(https://github.com/mem0ai/mem0/tree/main/openmemory)。

应用场景:从开发到设计无缝衔接

OpenMemory MCP在实际应用中展现了强大潜力:

跨工具项目流:用户在Claude Desktop定义项目技术需求,在Cursor构建代码,在Windsurf调试问题,所有工具共享OpenMemory中的上下文,避免重复说明。

偏好持久化:在任一工具中设置代码风格或语气偏好,其他MCP客户端可直接读取,确保风格一致。

游戏角色设计:设计师在不同AI工具中调整角色属性,只需在OpenMemory MCP中更新一次,所有工具即可同步修改。

AIbase编辑团队注意到,OpenMemory MCP的完全本地化设计(无云端上传)满足了隐私敏感用户的需求。官方演示表明,工具安装仅需Docker和简单配置,5分钟即可在https://localhost:3000访问仪表板(https://docs.mem0.ai/openmemory)。

技术优势与局限:隐私与兼容并重

OpenMemory MCP基于Mem0框架,采用MCP标准化协议,通过向量搜索技术实现语义记忆匹配,而非简单关键词查找。其跨客户端记忆访问功能让用户无需为每个工具单独维护上下文,显著提升效率。然而,社交媒体指出,工具的客户端兼容性目前局限于MCP支持的应用,需更多主流工具(如VS Code的GitHub C opilot)加入MCP生态。此外,初次配置可能对非技术用户有一定门槛,未来需优化安装流程。

行业背景:AI记忆管理的竞争热潮

OpenMemory MCP的发布正值AI记忆管理技术快速演进。Pieces MCP Server通过长期记忆支持时间和来源查询,强调IDE集成;Supermemory MCP则尝试连接Google Drive和Notion等外部数据源。AIbase分析认为,OpenMemory MCP以其完全本地化和跨工具共享的特性,在隐私与通用性上占据优势。Mem0团队的开源策略(GitHub星数已超5000)进一步加速了其社区采用,预计将推动MCP协议成为AI工具交互的标准。

AI记忆层的未来蓝图

OpenMemory MCP的推出标志着AI工具从孤立记忆向统一记忆层的转型。AIbase编辑团队预计,未来工具可能扩展至支持更多数据源(如Slack、Notion),并优化移动端兼容性,满足实时协作需求。然而,生态扩展与用户体验的平衡将是关键挑战,需更多客户端加入MCP协议。Mem0团队表示,下一阶段将聚焦仪表板功能增强与多语言支持(https://mem0.ai)。