记忆

OpenMemory MCP发布!AI记忆本地共享,Claude、Cursor一键同步效率翻倍!

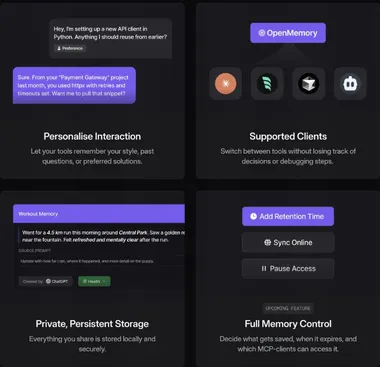

OpenMemory MCP(Model Context Protocol)正式推出,为AI工具提供统一的本地记忆共享解决方案。 这一开源工具允许用户将AI交互内容存储在本地,并通过MCP协议共享至支持的客户端,如Claude、Cursor和Windsurf,只需维护一份记忆内容即可实现跨工具上下文同步。 AIbase观察到,OpenMemory MCP的发布迅速引发开发者热议,被认为是提升AI工作流效率的重大创新。

5/14/2025 5:00:52 PM

AI在线

告别对话断层:Mem0动态存储技术实现AI代理记忆永续

Mem0 研究团队近日发布突破性内存架构,旨在解决AI系统在长期对话中的"健忘症"问题。 名为Mem0 和Mem0g的两种新型内存系统,能让大型语言模型(LLM)在数周甚至数月的对话中保持连贯一致性,实现更接近人类的记忆能力。 传统AI系统受限于固定上下文窗口,无法在长期交互中有效记忆关键信息。

5/9/2025 10:01:50 AM

AI在线

当心 AI 给你“洗脑”,MIT 最新研究显示大模型成功给人类植入错误记忆

AI 竟然可以反过来“训练”人类了!(震惊.jpg)MIT 的最新研究模拟了犯罪证人访谈,结果发现大模型能够有效诱导“证人”产生虚假记忆,并且效果明显优于其他方法。网友辣评:仔细想想,AI 诱导人类产生虚假记忆,这个现象其实在我们生活中已经出现了!还有网友说:我觉得还挺有意思的!有种《2077》的既视感~而马库斯的观点也还是一如既往的悲观:这种发展趋势也太可怕了!AI 如何“训练”人类为了研究大模型对人类记忆的影响,团队找来了 200 位志愿者,并把他们平分成 4 个组:控制变量组:志愿者直接回答问题,没有任何干预

9/6/2024 2:21:40 PM

汪淼

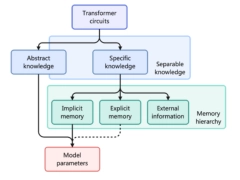

院士领衔推出大模型的第 3 种记忆:比参数存储和 RAG 都便宜,2.4B 模型越级打 13B

给大模型加上第三种记忆格式,把宝贵的参数从死记硬背知识中解放出来!中科院院士鄂维南领衔,上海算法创新研究院等团队推出 Memory3,比在参数中存储知识以及 RAG 成本都更低,同时保持比 RAG 更高的解码速度。在实验中,仅有 2.4B 参数的 Memory3 模型不仅打败了许多 7B-13B 的模型,在专业领域任务如医学上的表现也超过了传统的 RAG 方法,同时推理速度更快,“幻觉”问题也更少。目前相关论文已上传到 arXiv,并引起学术界关注。知识按使用频率分类这一方法受人脑记忆原理启发,独立于存储在模型参数

7/8/2024 11:09:43 PM

清源

ChatGPT 真能记住你的话吗?DeepMind 与开源大佬揭示 LLM 记忆之谜

【新智元导读】LLM 有记忆能力吗?有,也没有。虽然 ChatGPT 聊天时好像可以记住你之前说的话,但实际上,模型在推理时记不住任何内容,而且它们在训练时的记忆方式也不像我们想象的那么简单。Django 框架的创始人之一、著名开发者 Simon Willison 最近发表了一篇博客文章,核心观点是 —— 虽然很多 LLM 看起来有记忆,但本质上是无状态函数。文章地址: 和 FireFox 的联合创始人、JavaScript 发明者 Brendan Eich 也在推特上称赞这篇博客。似乎有记忆的 LLM从计算机科学

6/1/2024 2:47:56 PM

清源

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

AI for Science

苹果

腾讯

Agent

Claude

芯片

Stable Diffusion

蛋白质

具身智能

xAI

开发者

生成式

人形机器人

神经网络

机器学习

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

字节跳动

华为

AGI

计算

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

亚马逊

AI模型

特斯拉

场景

深度学习

Transformer

架构

MCP

Copilot

编程

视觉