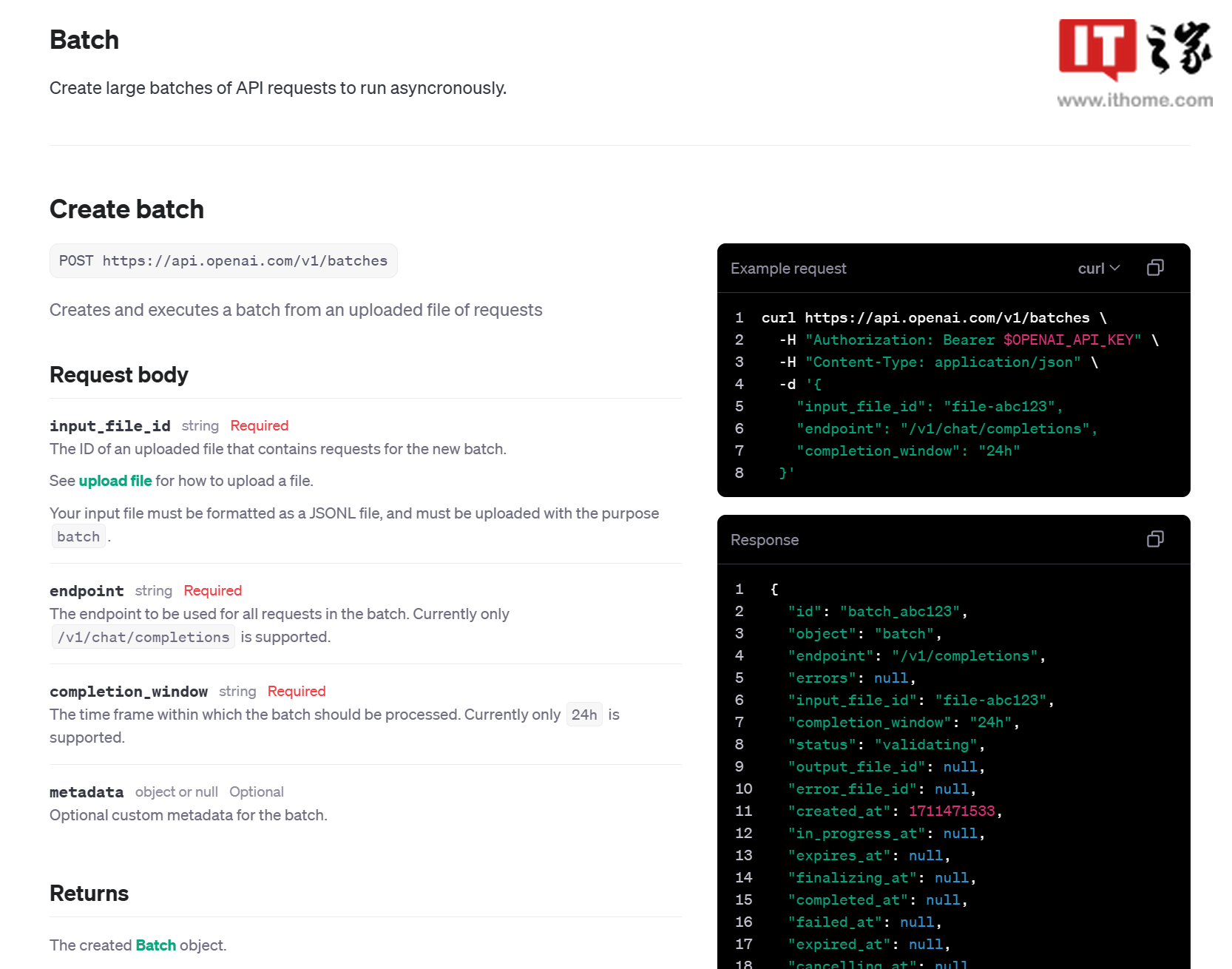

新的 Batch API 适用于异步任务处理,如当开发者需要处理大量文本、图片、摘要时,就可以使用该 API,OpenAI 会在 24 小时内给出处理结果。这样 OpenAI 可以在非高峰期处理,节约服务器资源,并为开发者提供半价优惠,解锁更高的速率限制。

新的 Batch API 支持使用以下模型:

gpt-3.5-turbo

gpt-3.5-turbo-16k

gpt-4

gpt-4-32k

gpt-4-turbo-preview

gpt-4-turbo

gpt-3.5-turbo-0301

gpt-3.5-turbo-16k-0613

gpt-3.5-turbo-1106

gpt-3.5-turbo-0613

gpt-4-0314

gpt-4-turbo-2024-04-09

gpt-4-32k-0314

gpt-4-32k-0613

OpenAI 已经在 API 文档中介绍了详细使用方法,包括如何创建、取回、取消 Batch 批处理等,IT之家有需要的开发者提供官方介绍如下:

- Batch API 示例 - OpenAI API 文档

- Batch API 常见问题与解答 | OpenAI 帮助中心