资讯列表

AI 招聘初创 Moonhub 关停:Salesforce 吸纳部分人才

据 TechCrunch 报道,Salesforce 发言人澄清,该公司并非如最初报道那样“收购”了 AI 招聘初创公司 Moonhub。 发言人表示,Moonhub 实际上正在关闭,只有部分团队成员将加入 Salesforce,而非此前 Moonhub 声明中暗示的整个团队。 Moonhub 由前 Meta 工程师 Nancy Xu 于2022年创立,专注于开发利用人工智能技术筛选和招聘人才的工具。

马斯克的 xAI 公司启动 3 亿美元股票出售计划,估值高达 1130 亿美元

根据《金融时报》的报道,埃隆・马斯克(Elon Musk)旗下的人工智能初创公司 xAI 正在启动一项价值 3 亿美元的股票出售计划。 这项计划被认为是在二级市场进行的,目的是为了让公司员工能够将股份出售给新投资者。 此次股票出售的估值达到了 1130 亿美元(约合 8136.7 亿元人民币),显示出市场对 xAI 的高度关注。

ChatGPT 高级语音模式惊现 “广告插播”!用户质疑服务质量

最近,一名 ChatGPT 的付费用户在使用其高级语音模式时,遇到了让人惊讶的情况。 他原本在与 ChatGPT 讨论寿司的话题,却突然被转入了一段广告宣传,令他目瞪口呆。 根据用户的描述,ChatGPT 在谈话中毫无预兆地开始介绍一种名为 Prolon 的营养计划,并且详细拼读了网址,似乎这段广告是完全不受控制地被植入的。

OpenAI用Rust重新打造Codex CLI,告别Node.js

近日,科技媒体 Dev Class 报道,OpenAI 宣布将其 AI 编程工具 Codex CLI 从原本的 Node.js 架构迁移到 Rust 语言重写。 这一决定引发了业界的广泛关注,特别是对于技术开发者和用户而言,Rust 的加入可能会带来诸多意想不到的优势。 Codex CLI 是 OpenAI 开发的一款实验性 AI 编程工具,用户可以通过 ChatGPT 的网页界面或本地命令行进行操作。

微软必应推出全新视频创作工具,用户可轻松生成 AI 视频

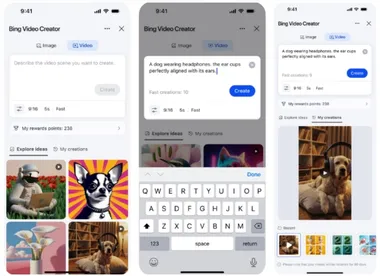

微软必应(Microsoft Bing)于本周一正式推出了一款全新的 “Bing 视频创作器”,这项功能基于 OpenAI 的 Sora 模型,标志着视频生成能力的首次免费开放,普通用户也可以轻松通过文本提示生成视频。 此次 Bing 视频创作器的上线,让用户能够用简单的文字描述,创造出属于自己的短视频。 值得注意的是,这一功能目前仅支持移动设备,尚未在桌面端推出。

微软推出 Bing Video Creator,免费助力用户轻松创作 AI 视频

最近,微软宣布推出一款新工具 ——Bing Video Creator。 这款工具是基于 OpenAI 的 Sora 技术,让用户能够通过简单的文字提示轻松创建短视频。 与两年前发布的必应图像创建器相似,Bing Video Creator 将 AI 视频生成的功能带给了普通用户。

微软在瑞士投资 4 亿美元 扩展云计算与人工智能基础设施

微软宣布将投资4亿美元用于加强其在瑞士的云计算和人工智能(AI)基础设施。 这项投资是在瑞士经济部长盖伊・帕默林与微软副主席布拉德・史密斯的会谈中透露的,标志着微软在人工智能和云服务领域的持续扩张。 微软在瑞士的业务团队目前约有1000名员工,新的资金将主要用于日内瓦和苏黎世附近数据中心的扩建与升级。

OpenAI 计划将 ChatGPT 打造成超级助手,直击苹果 Siri 市场

根据近期曝光的 OpenAI 战略文件,该公司计划在2025年上半年将 ChatGPT 打造成一款 “超级助手”,以挑战苹果的 Siri 市场地位。 这份文件通过美国司法部对谷歌的反垄断案件被解密,透露了 OpenAI 对于 ChatGPT 未来发展的宏伟蓝图。 文件中指出,OpenAI 希望 ChatGPT 成为一个具备 T 型技能的智能助手。

AI数学能力暴涨100%,自进化直逼RL极限!CMU新作颠覆认知

通往AGI最大的绊脚石,便是互联网数据不够用了! DeepSeek-R1、OpenAI的o系推理模型出世,不再单纯依赖人类标注「标准答案」,而是通过RL实现破局。 但问题来了——当前,LLM依然需要人类设计「正确信号」来指导训练。

RAG系列:解析优化 - 不同文件类型统一转换成Markdown

引言在 RAG 系统中,文件解析是构建知识库和实现高效信息检索的关键环节。 随着系统需要处理的文件类型日益增多(如PDF、Word、Excel、PPT、HTML等),如何高效解析并利用这些异构数据成为核心挑战。 由于每种文件类型的数据结构和内容(如PDF的复杂排版、Excel的表格结构、PPT的多媒体元素)都不一致,在实际的应用场景中,我们需要对不同文件类型实现不同的解析器,解析之后还需要根据不同文件的结构实现对应的文档分块方法。

SFT在帮倒忙?新研究:直接进行强化学习,模型多模态推理上限更高

随着 OpenAI 的 o1/o3 和 Deepseek-R1 等具备强大推理能力的大语言模型相继问世,学界普遍采用「监督微调 强化学习」的两阶段训练范式:先通过推理数据进行监督微调(SFT),再通过强化学习(RL)进一步提升性能。 这种成功模式启发了研究人员将其优势从纯文本领域拓展到视觉 - 语言大模型(LVLM)领域。 但近日的一项研究成果却给出了一个惊人的发现:「SFT 可能会阻碍学习 —— 经常导致出现伪推理路径,而 RL 则是在促进真正的多模态推理!

微软再放LLM量化大招!原生4bit量化,成本暴减,性能几乎0损失

最近,微软亚研院的研究团队开源了原生1bit精度的大模型:BitNet b1.58 2B4T。 还没过几天,原班人马带着第二代BitNet v2来了! 这次性能几乎0损失,但占用内存和计算成本显著降低!

挑战强化学习后训练霸权!全新无监督方法仅需1条数据+10步优化

无需标注数据、无需繁琐奖励设计,只用10步就能见效——「熵最小化」或许比强化学习更适合大语言模型快速升级。 强化学习(RL)近年来在大语言模型(LLM)的微调中大获成功,但高昂的数据标注成本、复杂的奖励设计和漫长的训练周期,成为制约RL进一步应用的瓶颈。 Ubiquant研究团队提出了一种极为简单有效的无监督方法——One Shot熵最小化(Entropy Minimization,EM),仅用一条无标签数据,训练10步内即可显著提升LLM性能,甚至超过使用成千上万数据的RL方法。

机器学习轻量化加速的五大核心技术突破

译者 | 朱先忠审校 | 重楼简介无论你是在准备面试,还是在工作中构建机器学习系统,模型压缩都已成为一项必备技能。 在大语言模型(LLM)时代,模型规模越来越大,如何压缩这些模型以使其更高效、更小巧、更易于在轻量级机器上使用,这一挑战从未如此严峻。 在本文中,我将介绍每位机器学习从业者都应该理解和掌握的四种基本压缩技术。

揭开大模型“伪遗忘”,港理工等团队:结构不变就是没忘

近年来,大语言模型(LLMs)的能力突飞猛进,但随之而来的隐私风险也逐渐浮出水面。 训练中暴露的敏感信息往往被模型“记住”,引发广泛关注。 在此背景下,机器遗忘(Machine Unlearning)技术应运而生,目标是在不影响整体能力的前提下,有选择性地抹除特定知识。

Mamba核心作者新作:取代DeepSeek在用的注意力机制,专为推理打造

曾撼动Transformer统治地位的Mamba作者之一Tri Dao,刚刚带来新作——提出两种专为推理“量身定制”的注意力机制。 在保持模型性能不变的情况下,将解码速度和吞吐量最高提升2倍,大大优化了模型的长上下文推理能力。 这项研究的三位作者均来自普林斯顿大学,论文主要有两大贡献:其一,提出Grouped-Tied Attention(GTA),与已集成到LLaMA 3的注意力机制GQA质量相当,但KV缓存用量减少约50%。

SSM+扩散模型,竟造出一种全新的「视频世界模型」

在这个 AI 技术与应用大爆发的时代,我们最不缺的就是「热词」,从自回归到扩散模型,从注意力机制到状态空间模型,从思维链到推理模型…… 有时候,其中一些热词会聚拢一处,为 AI 世界创造出新的可能性。 今天我们要介绍的这项研究便是如此,集齐了长上下文、状态空间模型(SSM)、扩散模型、世界模型等「热词」,创造了一种全新的「视频世界模型」。 该研究来自斯坦福大学、普林斯顿大学和 Adobe Research,在社交网络上引起了不少关注。

全流程拆解:如何使用 LM Studio 优化本地 LLM ?

Hello folks,我是 Luga,今天我们来聊一下人工智能应用场景 - 如何通过 LM Studio 优化本地 LLM 性能。 在人工智能浪潮席卷全球的 2025年,本地 LLM 的性能优化已成为开发者和企业关注的焦点。 随着计算资源需求激增,如何在本地环境中提升模型的效率、降低延迟并释放其最大潜力,成为了亟待解决的关键挑战。