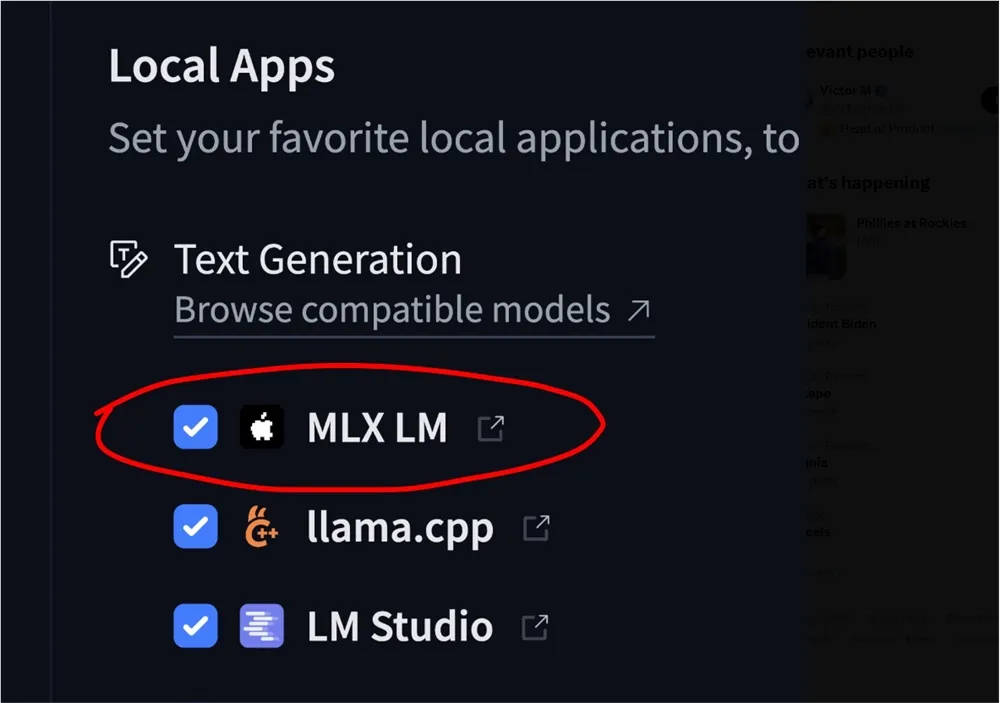

近日,MLX-LM现已直接集成到Hugging Face平台。这一里程碑式的更新为Apple Silicon设备(包括M1、M2、M3和M4芯片)用户提供了前所未有的便利,使其能够以最高速度在本地运行超过4400种大型语言模型(LLM),无需依赖云服务或等待模型转换。

这一集成进一步推动了本地化AI开发的普及,为开发者和研究人员提供了更高效、灵活的工具。

MLX-LM与Hugging Face的深度融合MLX是Apple机器学习研究团队开发的一个专为Apple Silicon优化的机器学习框架,旨在充分利用M系列芯片的神经引擎(ANE)和Metal GPU的强大性能。

MLX-LM作为其子包,专注于大语言模型的训练与推理,近年来因其高效性和易用性受到广泛关注。通过与Hugging Face的集成,MLX-LM现可直接从Hugging Face Hub加载模型,无需额外的转换步骤,极大地简化了工作流程。

地址:https://huggingface.co/models?library=mlx