RAG、MCP 和 FunctionCall 等都是 AI 的核心技术,同时也是面试中最长问的知识点,那么今天就来看下:RAG 技术及其执行流程。

概述

RAG(Retrieval-Augmented Generation,检索增强生成)是指在将原始问题发送给大语言模型之前,先通过外部知识库将数据进行注入,之后先在知识库中检索相关信息,然后再将检索结果和原始问题一起发送给大模型组织、整理答案的一种技术手段。

通过这种实现方式,大语言模型可以获取到特定领域的相关信息,并能够利用这些信息进行回复,从而降低了发生幻觉的可能性。

RAG 优势:

- 提高准确性:通过引用外部知识库,减少幻觉现象。

- 实时更新:允许模型访问最新信息,解决知识局限性问题。

- 经济高效:与重新训练模型相比,降低了更新成本。

执行流程

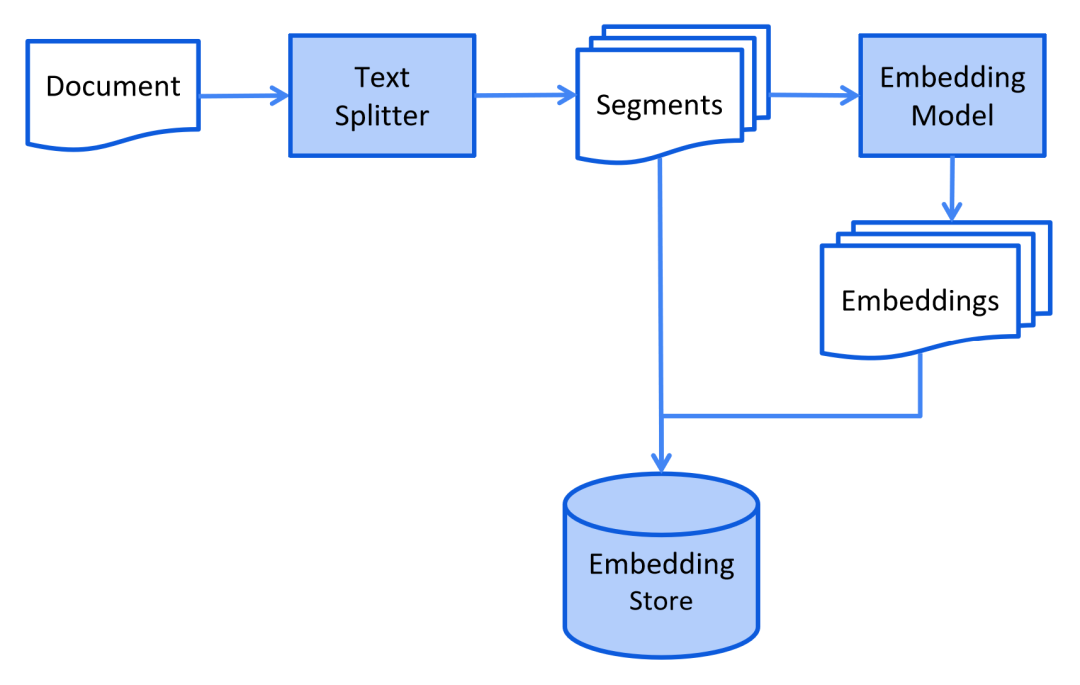

RAG 执行流程通常分为以下两个阶段:

1.生成索引阶段:这个阶段通常包括文档清理,以及分词也就是将它们拆分为更小的数据块,并把这些数据库转换成向量,最后存储在向量数据库的过程。

图片

图片

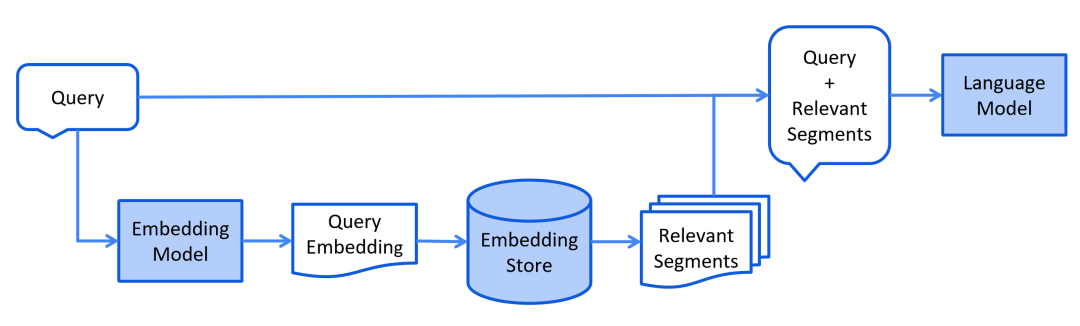

2. 检索阶段:使用用户提出的问题,在向量数据库中检索查询的过程。

图片

图片

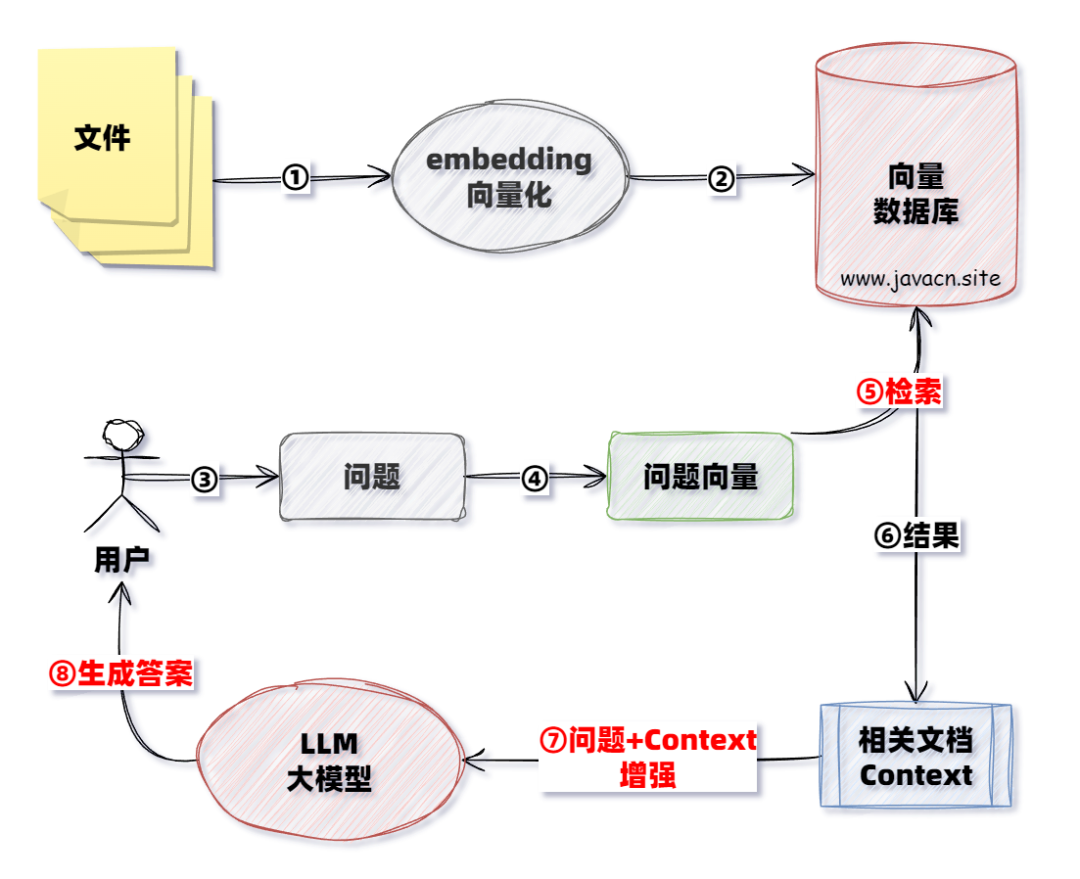

整体执行流程

图片

图片

使用场景

RAG 典型使用场景有以下几个。

1. 企业级知识问答系统

- 场景:公司内部文档(如 HR 政策、技术手册、客户 FAQ)的智能问答。

- 痛点:传统 LLM 无法访问非公开数据,且知识可能过时。

- RAG 作用:实时检索内部知识库,生成准确且可溯源的答案。

2.客服与技术支持

- 场景:电商、SaaS 产品的客户支持(如订单状态查询、故障排查)。

- 痛点:需依赖实时数据(订单、库存)和动态知识(如促销规则)。

- RAG 作用:结合用户实时数据(如订单 ID)和知识库,生成个性化回答。

3.医疗与法律咨询

- 场景:辅助医生查询最新诊疗指南,或律师分析判例库。

- 痛点:对事实准确性要求极高,且知识需更新(如新药品、法律条文)。

- RAG 作用:从权威数据库(如 PubMed、法律条文库)检索证据,减少幻觉。

小结

RAG 是给大模型“外接”知识库,让大模型能够更加精准回答问题的一种技术实现手段。它的执行主要分为两个阶段:索引生成阶段(知识库添加到向量数据库的过程),检索阶段(根据用户输入信息在向量数据库查询结果的阶段),当然其中有一些执行细节也需要了解并在面试中回答出来。