Anthropic宣布,Claude Sonnet 4的上下文长度,现在达到了史无前例的100万个token。

图片

图片

这项功能已经正式上线Anthropic API,并同步登陆Amazon Bedrock,Google Cloud的Vertex AI也即将支持。

相比之前的20万个token,这次扩展是5倍的飞跃。换句话说,Claude Sonnet 4现在可以一次性处理超过七万五千行代码,或几十篇学术论文,无须拆分,无须反复输入。

上下文窗口的扩大,显著扩展了大语言模型可处理任务的规模。

过去常见模型上下文在几千至数万字,现在可覆盖整套工程级代码、成百页文档及对话历史。

AI开始“理解全局”,不仅是处理局部

百万token带来的,不只是模型“记忆更久”,而是彻底提升了处理复杂任务的能力。

一位开发者现在可以将整套代码工程上传给Claude,包括源码、测试、文档,Claude可以一次性加载全部内容,并且理解模块之间的架构关系。

这意味着,Claude不仅能帮你“写一段函数”,还能指出某个类的设计在整体系统中是否合理,甚至发现跨文件的冗余和依赖错误。

法律、科研、工程等领域同样受益。

研究人员可以一次性让Claude读取上百份论文或技术文档,它能识别术语间的交叉引用、辨别观点之间的逻辑关系,并提供高质量的整合和总结。

对于构建AI代理的开发者来说,这也意味着Claude能够维护多轮对话的一致性与连贯性。

从前,调用工具时每次都得重新输入规则;现在,你可以把所有API文档、工具说明和历史调用记录打包上传,Claude能准确回忆、无缝对接。

这不仅让AI更聪明,更让AI更像人类合作者:理解语境、知道全貌、反应一致。

图片

图片

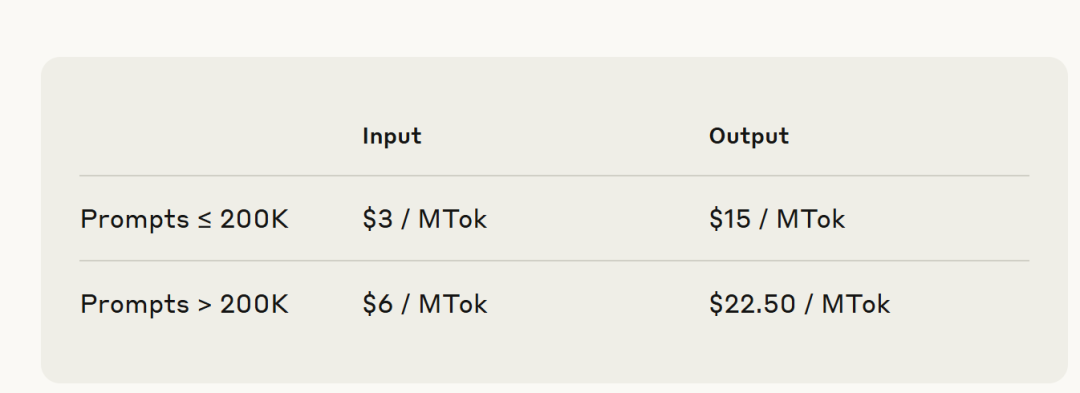

Claude Sonnet 4的百万token功能,定价也有所变化。

在200K以内的输入,每百万token收取3美元,输出为15美元;而超过200K的部分,输入为6美元、输出为22.5美元。

为了降低负担,Anthropic提供了prompt缓存与批量处理机制,最多能再节省50%的成本。

这项长上下文功能目前处于公测阶段,面向API使用者中的Tier 4等级与定制客户开放。

除了Anthropic平台本身,Amazon Bedrock已支持该功能,Google Cloud平台也将很快上线。

未来,这项能力还将推广到Claude的其他产品线。

via https://www.anthropic.com/news/1m-context