自2017年Transformer模型提出以来,Self-attention机制凭借其强大的建模能力,逐渐成为深度学习领域的核心操作。

然而,随着人工智能模型的规模不断扩张,单纯依靠简单直接「堆参数、堆数据」提升性能的模式正逐渐遇到瓶颈。面对大模型训练代价高昂、性能增长趋缓等挑战,学术界和产业界亟需新的网络架构创新。

近日,范鹤鹤(浙江大学)、杨易(浙江大学)、Mohan Kankanhalli(新加坡国立大学)和吴飞(浙江大学)四位老师提出了一种具有划时代意义的神经网络基础操作——Translution。

该研究认为,神经网络对某种类型数据建模的本质是:

1)为某一数据元素(如卷积核里的中心元素或自注意力机制里的query)寻找相关元素或区域;

2)对相关元素形成的区域进行有效编码,获取该区域真正的、独立于其他外部因素无关的内在结构的表征。

据此,在理论框架与实现机制上,Translution实现了Self-Attention(自注意力)与Convolution(卷积)的有机融合与统一,构建出一种更具普适性的神经计算机制。

论文:Translution: Unifying Self-attention and Convolution for Adaptive and Relative Modeling

论文链接:https://arxiv.org/pdf/2510.10060

代码链接:https://github.com/hehefan/Translution

突破瓶颈重新思考深度学习两大机制

自注意力机制(Self-Attention)自Transformer模型提出以来,已成为自然语言处理和多模态大模型的核心结构;而卷积神经网络(CNN)则长期主导计算机视觉领域。

图片

图片

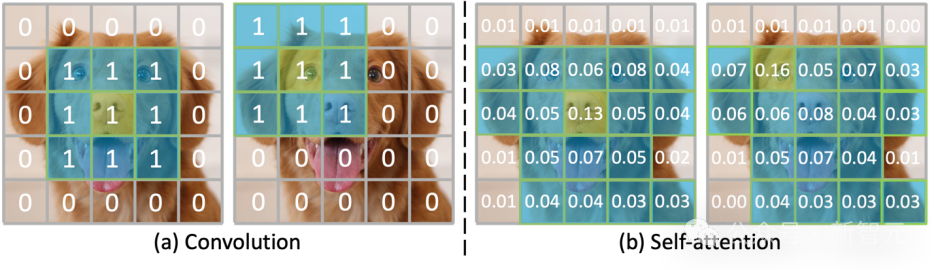

图1:Convolution在捕获关联区域时较为「死板」,可以视为固定大小的attention;Self-attention可以自适应地捕捉关联区域

二者的成功揭示了深度神经网络的两条关键路径:

- Self-Attention能够在全局范围内自适应地捕捉特征关联,但依赖绝对位置编码(absolute positional embedding),导致模型在处理位置变化时缺乏稳定性;

- Convolution则通过固定的局部卷积核捕获相对结构信息,具备强大的平移不变性,但无法像注意力那样灵活地选择相关区域。

图片

图片

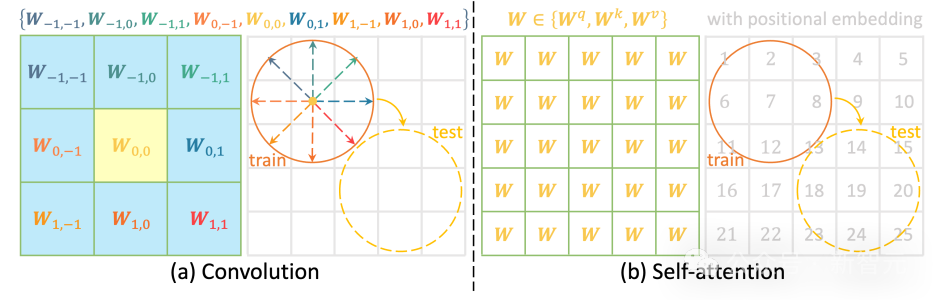

图2:在对相关区域进行编码时,Convolution为每个方向和距离都赋予一个可学习参数矩阵,使其可以捕捉与绝对位置无关的真实结构;而Self-attention通常将绝对位置融入到特征中,当位置发生变化,可能无法识别原先结构。

两种机制各有所长,却始终割裂。Translution的出现,正是为了弥合这一理论与应用的鸿沟。

Translution,Self-Attention和Convolution的大一统

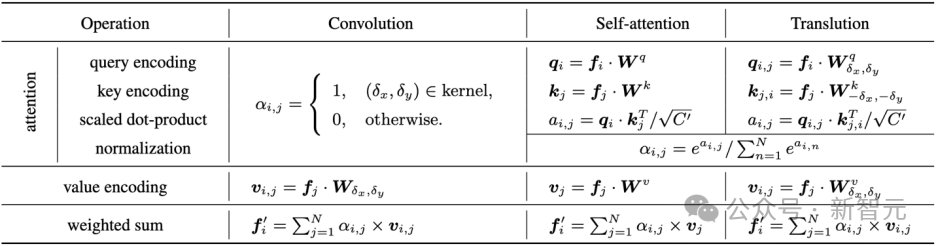

Translution的核心思想,是将Self-Attention的自适应区域选择能力与Convolution的相对结构建模能力进行统一。

在传统的自注意力计算中,Query、Key、Value的投影矩阵在所有位置上共享,无法感知元素之间的方向和距离关系。

Translution则创新性地为每一种相对偏移(offset)分配独立的参数矩阵,从而在计算Query、Key、Value时引入方向性和相对位置信息,实现了真正意义上的相对编码(relative encoding)。

图片

图片

表1:Translution对Self-Attention与Convolution的统一。Self-Attention与Convolution可以分别看作是Translution的两种特例:Self-Attention简化了相对位置编码,Convolution简化了注意力求解(用感受野代替)

这意味着,Translution不仅能像自注意力那样动态聚焦于最相关的区域,还能像卷积一样感知局部结构关系,实现了「自适应识别+相对建模」的融合。这一特性使模型在处理图像、文本乃至三维空间数据时,能够对形状、位置、顺序等结构变化保持更强的稳定性和泛化性。

α-Translution在高性能与可训练性之间找到平衡

由于Translution在每个方向上引入了独立参数矩阵,其参数量呈指数级增长,远超当前GPU显存所能承载。为解决这一问题,提出了轻量化版本——α-Translution。

通过在特征维度上引入分解式低秩编码,α-Translution将大规模矩阵压缩为多层可组合子空间映射,从而在保证性能的同时,将参数量与显存占用降低至原版的数十分之一。

实验表明,α-Translution在性能上显著优于传统Self-Attention,而计算成本可控,是当前硬件条件下最具潜力的过渡方案。

在视觉与语言任务上,全面超越Self-Attention

技术报告在计算机视觉和自然语言建模两个领域开展了系统性实验。

结果显示,在多个benchmark上,Translution及其轻量化版本α-Translution均显著优于基于Self-attention的Transformer架构:

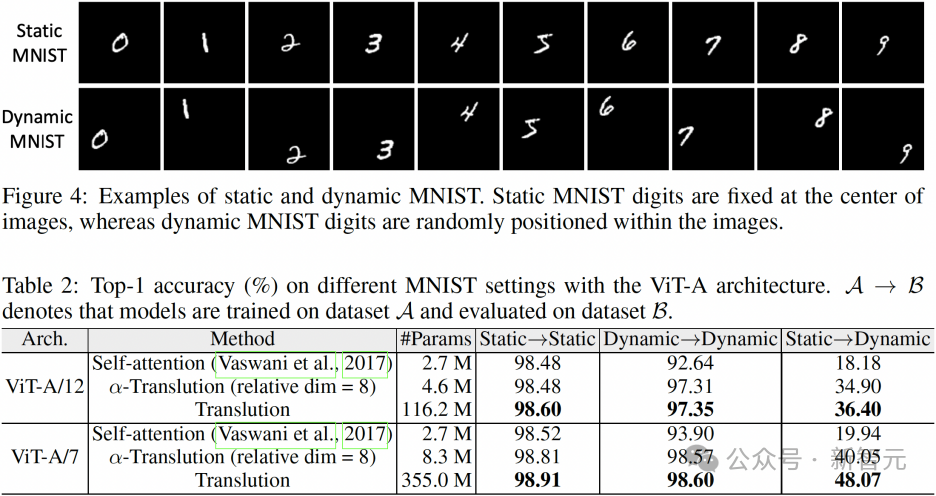

•在基于ViT架构的动态MNIST分类实验中,Translution对位置变化表现出极强的鲁棒性,识别精度显著优于Self-Attention。

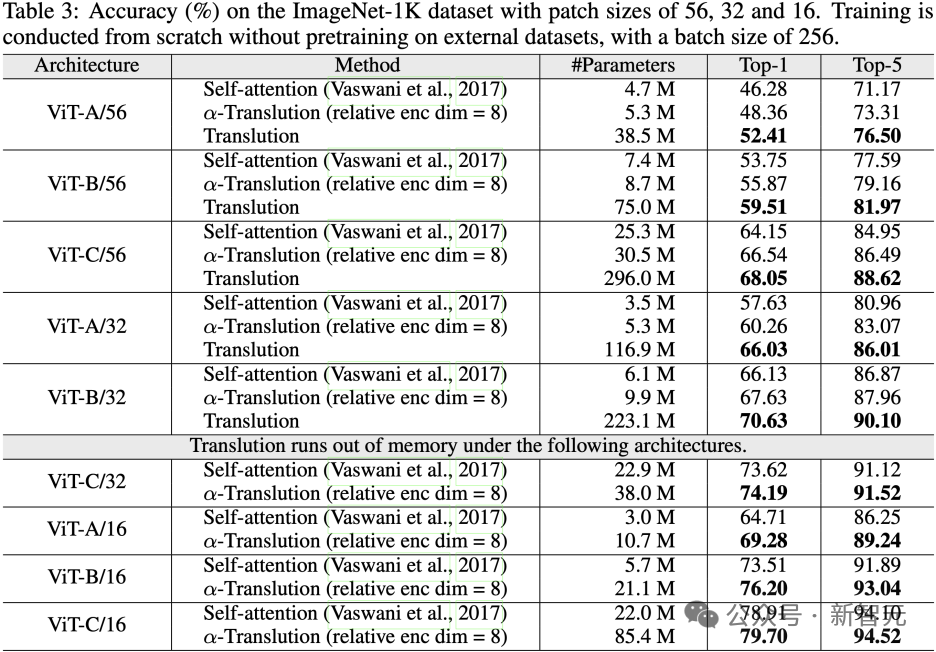

•在基于ViT架构的ImageNet分类任务上,Translution的Top-1准确率较Self-Attention最高提升超过6%。

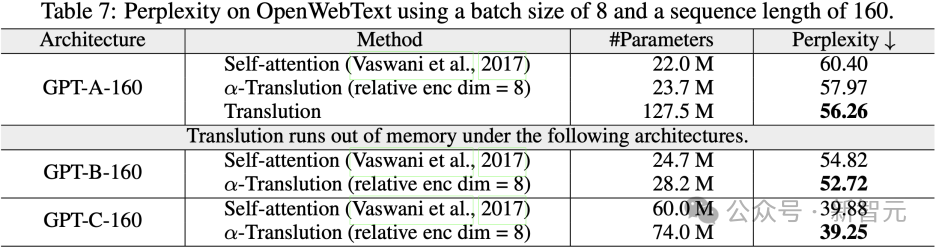

•在基于GPT架构的OpenWebText语言建模中,Translution的困惑度(Perplexity)相比Self-Attention有效降低,展现出更强的语言建模能力。

图片

图片

表2:当在静态MNIST数据集上进行训练、动态数据集上进行测试,Translution(包括α-Translution)取得了明显高于Self-attention的准确率,展现出其对位置变化的强大适应能力。

图片

图片

表3:基于Translution构建的ViT在ImageNet数据集上取得明显优于Self-attention的准确率

图片

图片

表4:在自然语言建模的任务上,基于Translution构建的GPT也取得了超过Self-attention的性能

这些结果表明,Translution不仅在视觉任务中能够准确捕获空间结构关系,也能在文本序列中理解词语之间的相对依赖,展现出跨模态的普适性。

灵魂拷问Translution性能提升源自参数量增多?

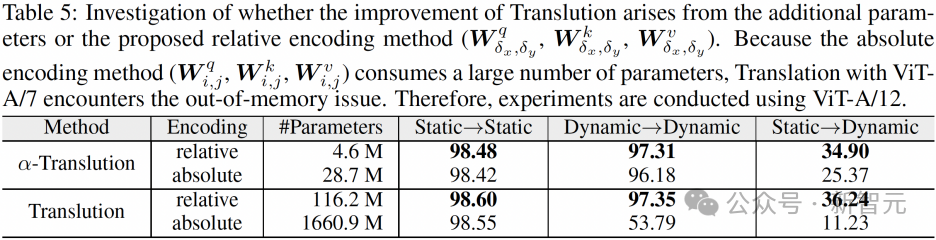

为了验证Translution的性能提升究竟源于参数规模的增加,还是源于所提出的相对建模机制,作者们设计了更具「挑战性」的对照实验:他们将Translution中的相对矩阵替换为绝对矩阵。

这一替换会导致参数量显著增加。如果「绝对Translution」的表现优于「相对Translution」,则说明性能提升主要来自参数增多;反之,则证明提升源于相对建模机制本身。

实验结果如表所示,「相对Translution」在准确率上远超「绝对Translution」,充分证明了性能提升确实源自所提出的相对建模方法。

图片

图片

表5:具有更少参数的「相对Translution」取得了更高的准确率,证明了Translution带来的性能提升正是由所提出的相对建模引起的。

结束语:Translution不仅是一项技术创新,更是一次对深度神经网络本质的重新思考。

尽管其大规模应用有赖于未来更强大的算力支撑,但它为新一代神经网络的发展开辟了新的方向,也为人工智能的未来注入了新的活力。

参考资料:

https://arxiv.org/pdf/2510.10060