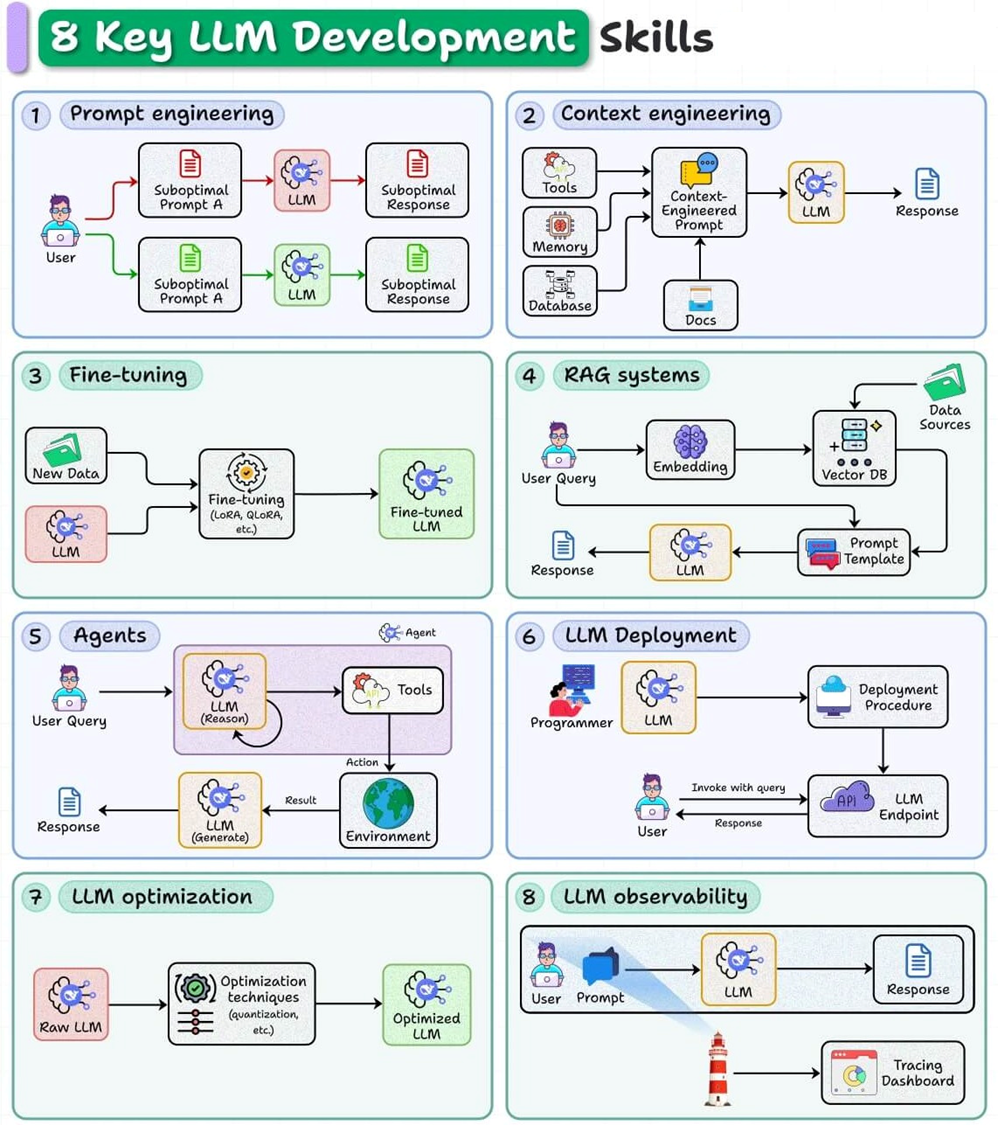

很多人以为使用大语言模型(LLM)只是“写提示词(prompting)”。但如果目标是打造生产级(production-grade)的 AI 系统,仅仅依赖提示词远远不够。

图片

图片

真正的 LLM 开发需要系统性的工程能力:模型如何设计、部署、优化与运维。

本文整理了 AI 工程师必须掌握的 8 项核心技能,它们构成了 LLM 应用开发的八大支柱。

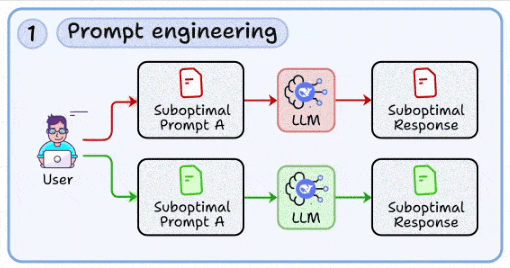

1. Prompt Engineering —— 提示词工程

这是 LLM 开发的入门技能。

图片

图片

目标是 设计结构化的提示词,减少歧义,让模型输出更稳定、更可控。

- 快速迭代不同提示词版本

- 利用 Chain-of-Thought、Few-shot 示例等模式稳定回答

- 把提示词设计当作“可复现的工程任务”,而不是纯粹的“文案试错”

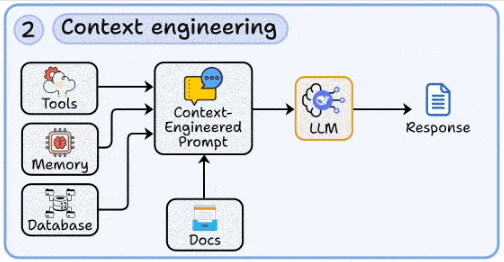

2. Context Engineering —— 上下文工程

LLM 并不是无所不知,需要动态注入外部数据。

图片

图片

- 从数据库、文档、工具结果、长期记忆中注入上下文

- 设计合理的上下文窗口,平衡信息完整性与 Token 成本

- 处理检索噪声与上下文塌缩,尤其在长上下文场景下

这项技能是 RAG 和智能体的基础。

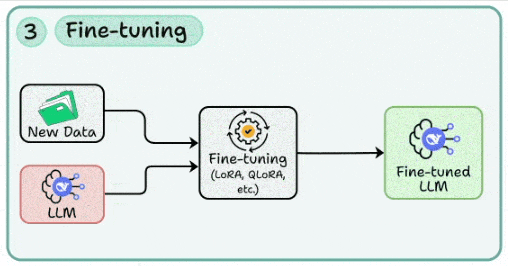

3. Fine-tuning —— 模型微调

当基础模型不能完全满足业务需求时,就需要微调。

图片

图片

- 使用 LoRA / QLoRA 等高效方法,用领域数据适配模型

- 构建数据清洗与标注管道:去重、格式化、质量筛选

- 平衡“过拟合”与“泛化”,避免模型只记住训练样本

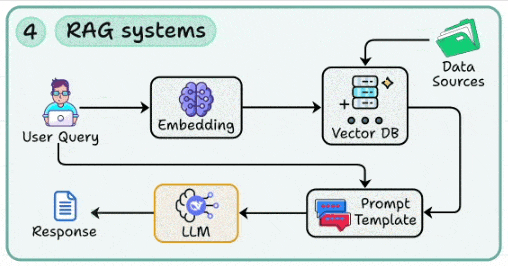

4. RAG 系统 —— 检索增强生成

RAG(Retrieval-Augmented Generation)是减少“幻觉”的关键技术。

图片

图片

- 通过 向量数据库 + Embedding 检索外部知识

- 构建高召回率与高精度的检索管道(分块、索引、查询重写)

- 使用提示模板,把检索到的上下文和用户问题融合

这几乎是所有企业级 LLM 应用的标配能力。

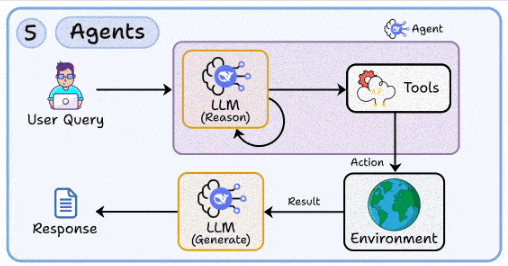

5. Agents —— 智能体

RAG 解决了知识增强,但要实现自主决策与复杂流程,需要 Agent 技术。

图片

图片

- 构建多步推理循环,驱动 LLM 使用工具完成任务

- 管理环境交互、状态流转、错误恢复

- 为推理失败或外部 API 出错设计回退机制

换句话说,Agent 让 LLM 从“聊天机器人”进化为“可行动的助手”。

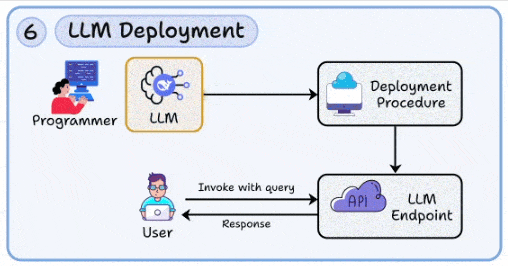

6. LLM Deployment —— 模型部署

从原型到生产,部署是不可或缺的一步。

图片

图片

- 将模型打包为 可扩展的 API 服务

- 管理 延迟、并发、故障隔离(如自动扩缩容、容器编排)

- 增加安全与成本监控:请求审计、滥用防护、Token 成本追踪

像 Beam 这样的开源框架能加速部署流程。

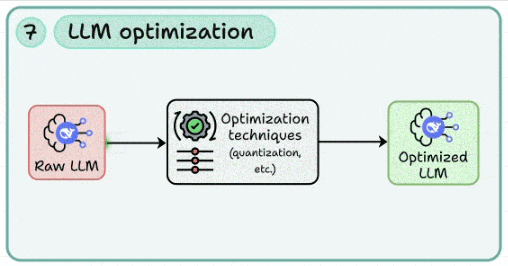

7. LLM Optimization —— 模型优化

生产中,性能与成本往往比参数量更重要。

图片

图片

- 应用 量化(Quantization)、剪枝(Pruning)、蒸馏(Distillation)

- 在速度、准确率、硬件占用之间做权衡

- 持续进行性能分析,避免优化过度影响功能

优化是让 LLM 从“能跑”到“跑得快、跑得省”的必修课。

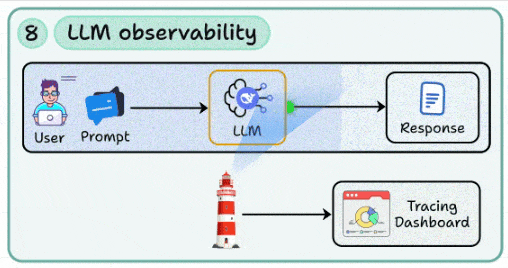

8. LLM Observability —— 可观测性

没有监控的 AI 系统是不可控的。

图片

图片

- 构建 日志、链路追踪、监控面板,追踪提示词与模型响应

- 监控 Token 消耗、延迟波动、提示词漂移

- 把观测数据反馈到开发迭代中,实现持续改进

这是 LLM 应用的“运维基石”。

如果说 Prompt Engineering 是 LLM 开发的起点,那么 上下文工程、RAG、Agent、微调、优化、部署与可观测性,才是把 LLM 真正带入生产的关键技能。

未来的 AI 工程师,不只是会写提示词,更要懂 AI + 系统工程 的全链路能力。