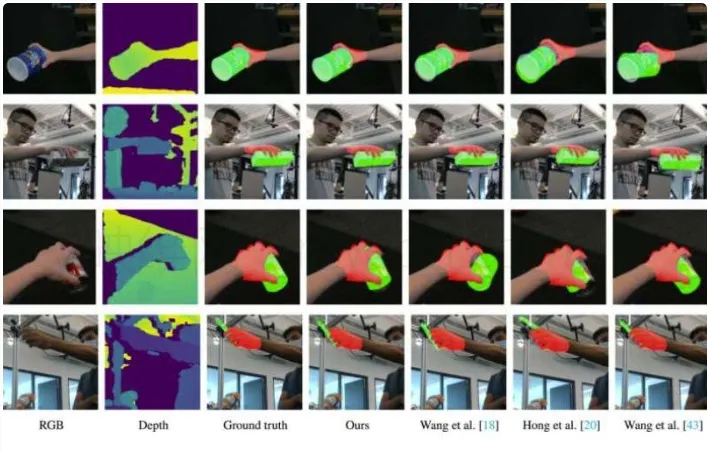

在增强现实(AR)等应用中,手持物体的姿态估计是一项至关重要但颇具挑战性的任务。近期,日本芝浦工业大学的研究团队提出了一种基于 Vote 机制的多模态融合框架,显著提高了这一领域的准确性,令人瞩目地提升了13.9% 的姿态估计精度。

这一新方法的核心在于有效整合来自 RGB(颜色)和深度图像的数据,特别是在手遮挡物体的情况下。研究团队指出,现有的姿态估计技术往往在手部遮挡时遇到精度下降的难题,而手与物体之间的非刚性转换则进一步加剧了这一问题。例如,当我们握住一个软球时,手的力量会扭曲物体的形状,导致估计变得更加复杂。

为了解决这些挑战,芝浦工大的团队设计了一个创新的深度学习框架。该框架包含四个主要部分:从 RGB-D 图像中提取高维特征的主干网络、Vote 模块、基于 Vote 的新型融合模块以及手部感知物体姿态估计模块。首先,研究者通过2D 和3D 骨架预测手和物体的关键点。随后,各个骨干中的 Vote 模块独立为关键点进行投票,最后通过基于 Vote 的融合模型将投票结果整合。

这套新颖的 Vote 机制利用了局部信息并结合通道关注机制,动态地将 RGB 和深度数据结合,克服了手部遮挡和数据不对齐带来的困难,从而实现了更加精准的手持物体姿态估计。此外,手感知物体姿态估计模块通过自注意机制捕捉手与物体关键点间的复杂关系,进一步提高了估计精度。

研究者在多个公共数据集上进行了实验,结果显示,该框架的准确性和稳健性都有了显著提高,最高可达15%。在实际应用中,框架实现了76.8% 的平均精度和仅40毫秒的推理时间,显示出其良好的实用性和部署潜力。这一方法不仅提升了姿态估计的准确性,还为 AI 系统在沉浸式 AR/VR 技术中的应用开辟了新的可能性。