编辑 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

由于传统的AI 基准测试技术已被证明不够充分,AI 开发者开始采用更具创造性的方式来评估生成式 AI 模型的能力。对于一组开发者来说,这就是微软旗下的沙盒建造游戏 Minecraft。

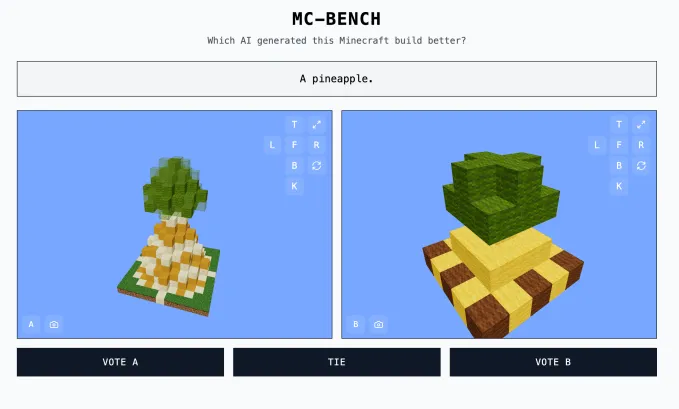

Minecraft Benchmark (或 MC-Bench)网站是合作开发的,目的是让人工智能模型在面对面的挑战中相互竞争,用 Minecraft 创作来回答提示。用户可以投票选出哪个模型做得更好,只有在投票后,他们才能看到每个 Minecraft 构建都是由哪个人工智能完成的。

Minecraft 基准测试

Minecraft 基准测试

对于创办 MC-Bench 的 12 年级学生 Adi Singh 来说,Minecraft 的价值不在于游戏本身,而在于人们对它的熟悉程度——毕竟,它是有史以来最畅销的电子游戏。即使对于没有玩过这款游戏的人来说,仍然可以评估哪种块状菠萝表现更好。

“Minecraft 让人们更容易看到(人工智能开发的)进展,”辛格告诉 TechCrunch。“人们已经习惯了 Minecraft,习惯了它的外观和氛围。”

MC-Bench 目前列出了 8 名志愿者。根据 MC-Bench 网站,Anthropic、Google、OpenAI 和阿里巴巴已为该项目使用其产品运行基准测试提供补贴,但这些公司与其他公司并无关联。

辛格说:“目前,我们只是在进行简单的构建,以反思我们与 GPT-3 时代相比取得了多大的进步,但我们可以预见到自己会扩展到这些长期计划和以目标为导向的任务。”“游戏可能只是一种测试代理推理的媒介,它比现实生活中更安全,而且在测试方面更易于控制,在我看来,这更理想。”

其他游戏,如《精灵宝可梦红》、 《街头霸王》和《你画我猜》也被用作人工智能的实验基准,部分原因是人工智能的基准测试艺术非常棘手。

研究人员经常在标准化评估中测试人工智能模型,但其中许多测试都让人工智能拥有主场优势。由于训练方式的原因,模型天生擅长解决某些特定类型的问题,尤其是需要死记硬背或基本推断的问题。

简而言之,很难理解 OpenAI 的 GPT-4 可以在 LSAT 中取得 88% 的成绩,但却无法辨别“strawberry”这个词中有多少个“R”。Anthropic的Claude 3.7 Sonnet在标准化软件工程基准测试中的准确率为 62.3%,但它在玩 Pokémon 方面的表现却比大多数五岁儿童还要差。

图片来源:Minecraft Benchmark

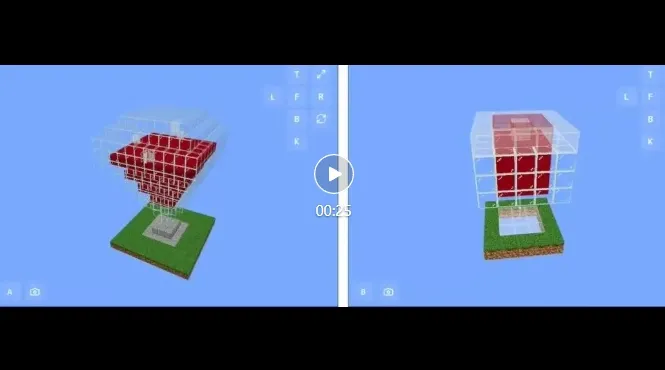

图片来源:Minecraft Benchmark

MC-Bench 从技术上来说是一个编程基准,因为模型被要求编写代码来创建提示的构建,例如“雪人弗罗斯蒂”或“原始沙滩上迷人的热带海滩小屋”。

但对于大多数 MC-Bench 用户来说,评估雪人是否看起来更好比深入研究代码更容易,这使得该项目具有更广泛的吸引力 - 并因此有可能收集更多关于哪些模型持续得分更高的数据。

当然,这些分数是否对 AI 的实用性有重大影响还有待商榷。不过,Singh 坚称,这是一个强烈的信号。

“目前的排行榜与我自己使用这些模型的经验非常接近,这与许多纯文本基准测试不同,”Singh 说。“也许 [MC-Bench] 可以帮助公司了解他们是否朝着正确的方向前进。”

基准链接:https://mcbench.ai/