在一个新的人工智能编程挑战赛中,结果引发了广泛关注。由 Laude Institute 主办的 K 奖大赛于最近公布了首位获奖者,令人惊讶的是,获得5万美元奖金的巴西程序员爱德华多・霍查・德・安德拉德(Eduardo Rocha de Andrade)在比赛中仅回答正确了7.5% 的问题。这一成绩无疑为人工智能领域的现状敲响了警钟。

K 奖是由 Databricks 和 Perplexity 的联合创始人安迪・孔温斯基(Andy Konwinski)发起的,旨在推动 AI 模型在真实编程问题上的表现。孔温斯基表示:“我们很高兴能够建立一个真正具有挑战性的基准。” 与目前普遍存在的测试系统相比,K 奖的设计更加严格,通过采用 “无污染” 的方式,确保测试模型的能力不受训练集的影响。

图源备注:图片由AI生成,图片授权服务商Midjourney

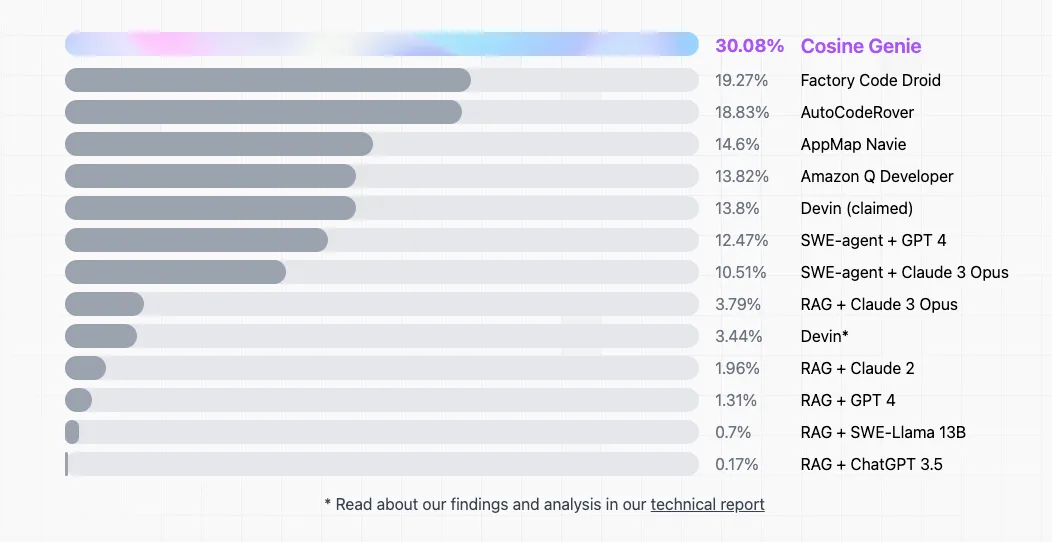

与其他基准测试如 SWE-Bench 不同,K 奖不允许模型在提交前接触到特定的问题,而是使用在截止日期之后从 GitHub 提取的新问题。虽然许多 AI 编程工具已经涌现,但这项新挑战却显示出目前模型的局限性。K 奖的顶尖成绩与 SWE-Bench 中75% 的顶尖得分形成了鲜明对比,这让人们开始怀疑是否存在基准测试的污染问题。

孔温斯基对未来充满信心,并承诺如果有开源模型能够在测试中得分超过90%,他将提供100万美元的奖励。他希望这项挑战能成为整个行业的警钟,让大家认识到目前的 AI 技术仍有很大的提升空间。他补充道:“如果我们连10% 的成绩都达不到,那现实就很残酷了。”

这次比赛引发了行业内对于 AI 评估标准的热烈讨论,许多研究者认为像 K 奖这样的项目对于解决 AI 的评估问题至关重要。普林斯顿大学的研究者萨亚什・卡普尔(Sayash Kapoor)表示:“我们需要新的测试来评估现有的基准,如果没有这样的实验,我们无法判断问题的根源。”

K 奖不仅为 AI 模型设立了新的挑战标准,也为整个行业提供了一个反思的机会,让人们重新审视当前的人工智能技术和其应用的可行性。