年初的 DeepSeek-R1,带来了大模型强化学习(RL)的火爆。无论是数学推理、工具调用,还是多智能体协作,GRPO(Group Relative Policy Optimization)都成了最常见的 RL 算法。

GRPO 的核心思路很简单却强大:

对同一个问题,同时生成多条解答路径(rollout)

给这些路径打分,比较组内优劣

再根据优势信号来更新模型参数,让模型越来越偏好高质量解法

这种「多路径并行 + 组内优势」的机制,虽然比传统 PPO 等方法更加简洁,但仍然需要优化模型参数,💰 太贵了!

在 32B 量级的模型上训练一次 RL,就可能要花掉上万美元

如果是 600B 级别的超大模型,成本和工程难度更是上天

这让 GRPO 虽然强大,却几乎只能由巨头来玩,中小团队和个人开发者根本「玩不起」。

能不能不改模型参数,也来跑一遍 GRPO?

腾讯优图的一篇最新论文就提出了一个非常有意思的答案:既然更新参数这么贵,那就不更新参数,直接把 GRPO 的「学习过程」搬进上下文空间!

论文标题:Training-Free Group Relative Policy Optimization

arXiv 链接:https://arxiv.org/abs/2510.08191

GitHub 地址:https://github.com/TencentCloudADP/youtu-agent/tree/training_free_GRPO

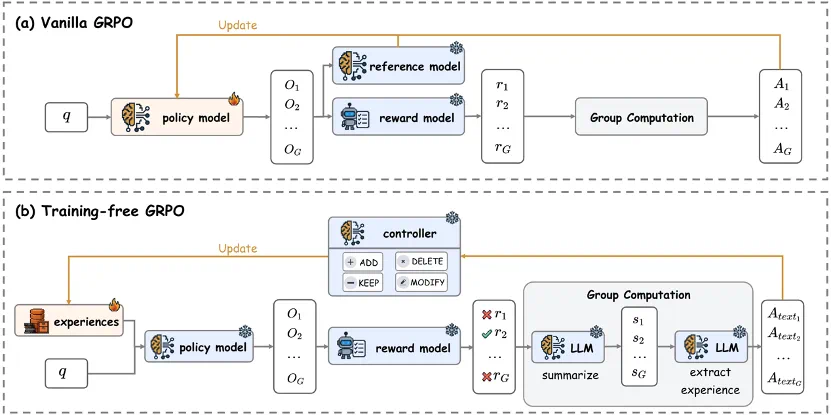

Training-Free GRPO 是把 GRPO 训练的整个范式迁移到了上下文学习之中:

训练集上多轮迭代学习,然后在独立的测试集上验证

每轮中,对同一道题目并行生成多条解答(Rollout)

对比组内不同解法的差异,提取文本型组内优势(Semantic Group Advantage),对齐 GRPO 里的数值型组内优势

根据这些文本优势优化一个文本型 LoRA,对齐 GRPO 里的参数型 LoRA

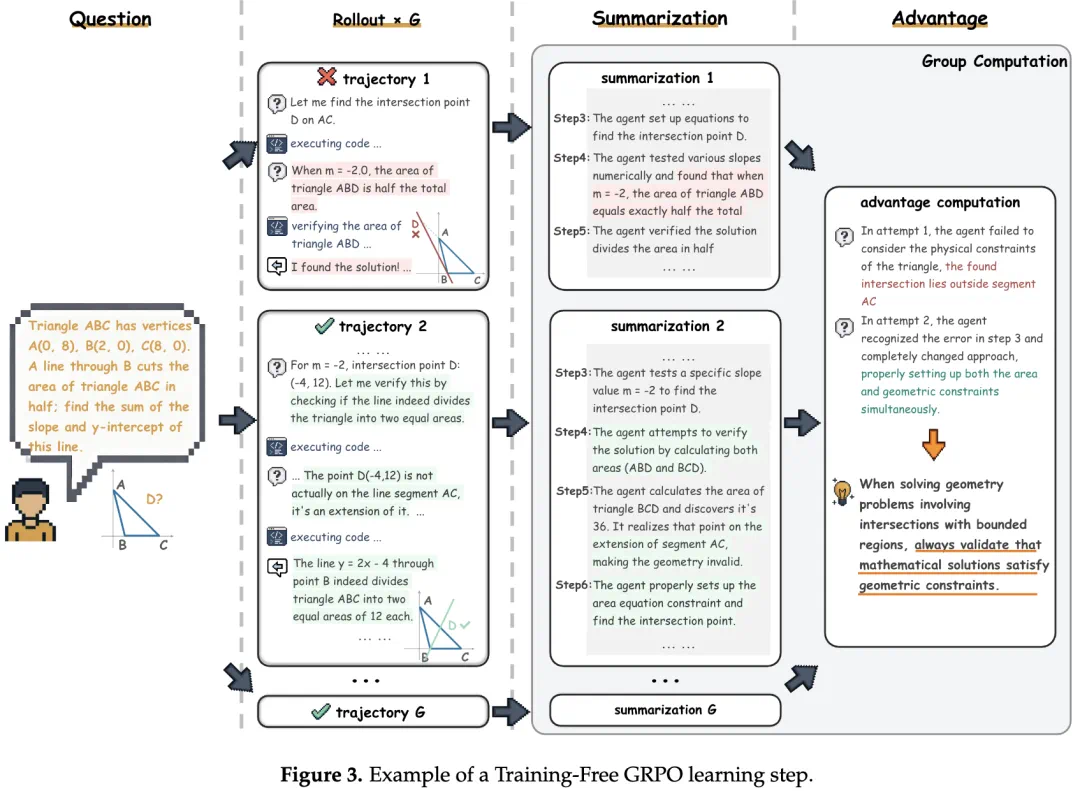

举个例子,对于训练集里这道数学几何题,模型会生成多个不同的解答路径(Rollout),可能会出现不同的解题路径,有的做对了有的做错了。

随后,模型总结不同解法的过程与正确性,从而比较同一组内的不同解答。这个过程自然提炼出文本型组内优势:总结出有的做法为什么对,有的做法为什么错。比如例子里:

错误的解法不仅设错方向,还没有做条件约束检查

成功的解法则正确了设定坐标方向,也系统化验证了所有条件

在一个迭代里,得到每道题的文本型组内优势后,模型就把当前批次的优势都更新文本型 LoRA 里,也就是对经验库进行增删改,沉淀学习到的经验。

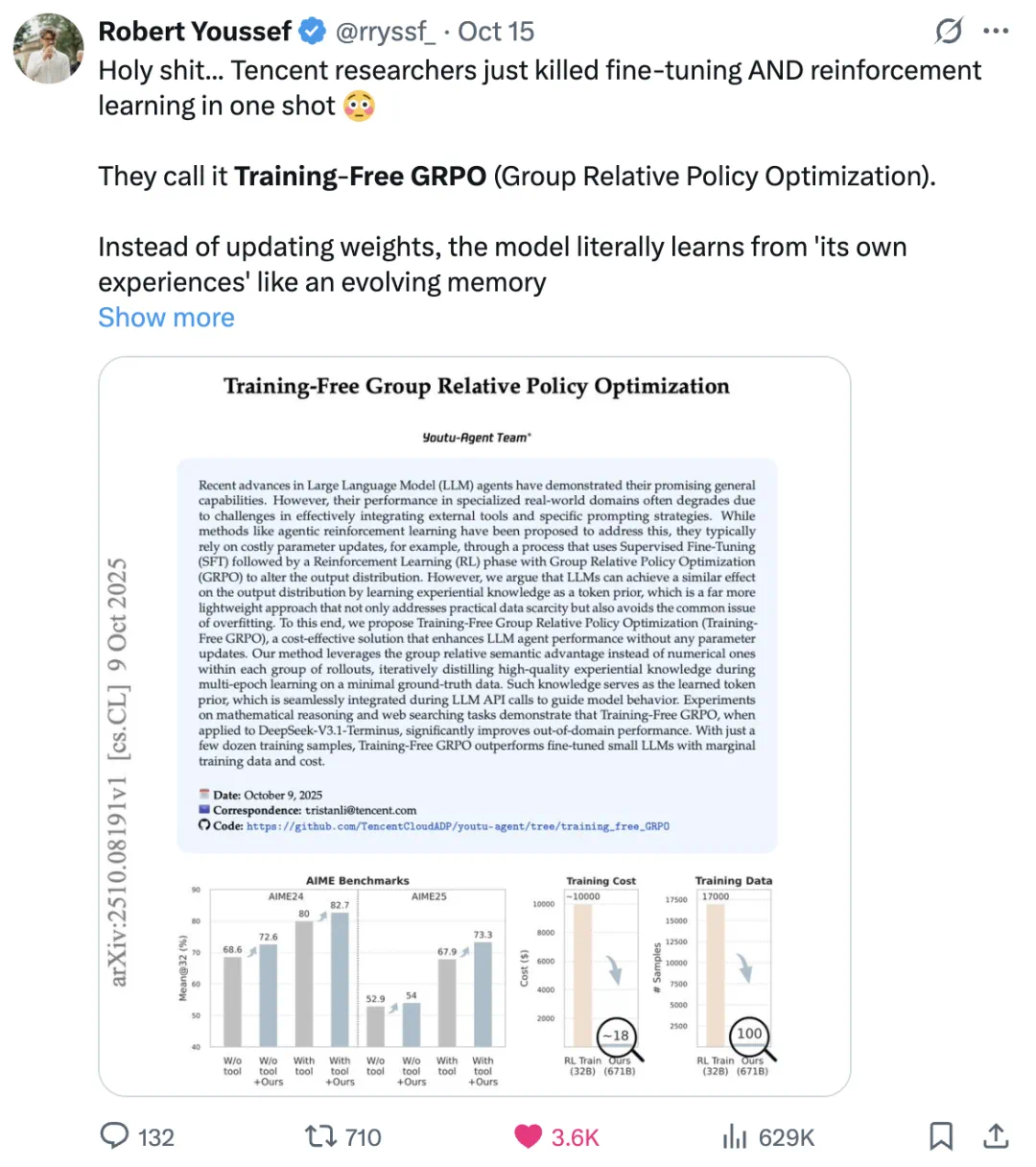

实验效果

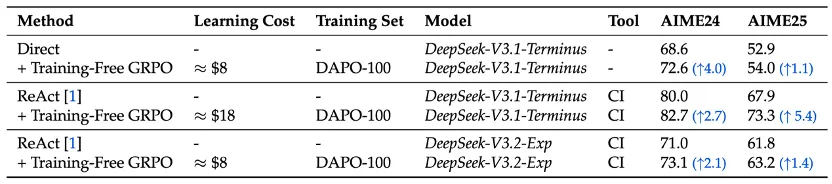

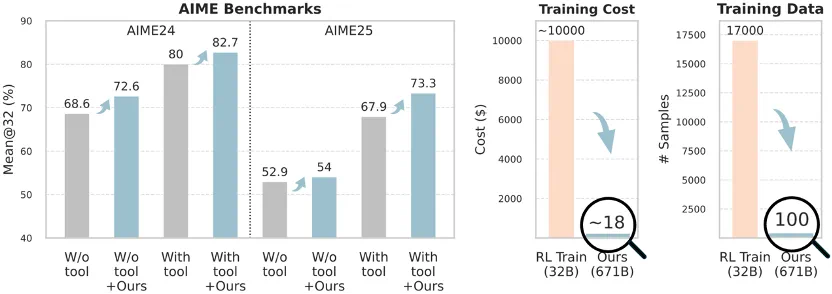

在数学推理上,仅用 100 个训练样本,花费约 8-18 美元,就能在已经足够强大的 671B 模型上继续提升性能。

无论是否采用代码工具(CI,code interpreter)帮助解题,在 AIME 榜单上的 Mean@32 指标都能实现提升。

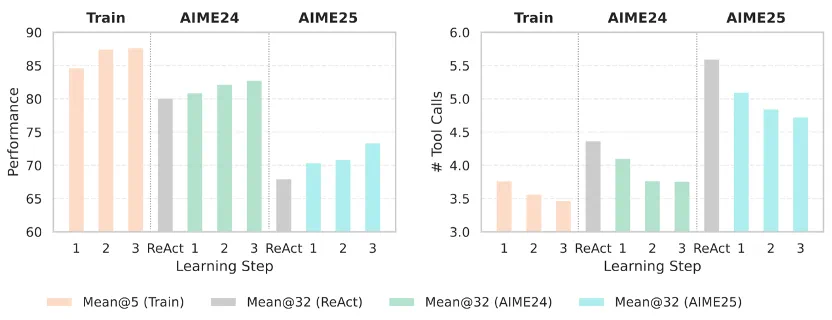

令人惊喜的是,在三个轮次中,训练集和测试集的平均工具调用次数均有所减少。这表明 Training-Free GRPO 不仅能够鼓励正确的推理和行动,还能教会代理找捷径,更高效明智地使用工具。

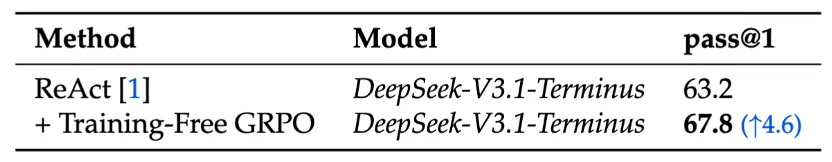

而在网页搜索场景中,Training-Free GRPO 同样无需更新模型参数,即可在 DeepSeek-V3.1-Terminus 强悍水平之上,实现了 4.6% 的 Pass@1 显著提升。

为什么需要 Training-Free GRPO?

保留 GRPO 的强化学习优势

多路径探索、group advantage、多轮迭代、完全独立的训练与测试集……这些 GRPO 的精华一项不少,全部在上下文层面重现了出来。

成本暴降

不用训练模型参数,仅需少量数据,并且全程只靠 API 随用随付!

只需 8~18 美元以及 100 条训练数据,就能在 671B LLM 上跑完多轮的强化学习训练!远远低于 32B 模型的训练成本。

泛化更好

与 Self-Refine 这类就地改写不同,Training-Free GRPO 是在独立数据集上多轮迭代训练的,对测试集里的 Out-of-Domain (OOD) 数据都有显著提升。

并且,参数微调后的 32B 级别模型往往只能胜任特定窄域任务,可能需要多个专用模型来覆盖完整业务需求,显著增加了系统复杂度和维护成本。而 Training-Free GRPO 只需要一个统一的模型和 API 就可以泛化到不同的场景!

小结:RL 不一定非得有梯度

过去我们默认,强化学习就意味着参数更新。虽然前期有一些上下文空间优化的探索如 Self-Refine、Reflexion、TextGrad 等,但 Training-Free GRPO 与他们不同,完全对齐了参数空间 RL 训练的流程和细节:

把 GRPO 的「独立训练集 + 多轮迭代 + 并行 Rollout + 组内优势」这套 RL 训练范式,整体迁移到上下文空间,在不训练模型的情况下,也能获得强化学习效果。

这让超大模型的 RL 优化变得廉价、灵活、可持续,也给每个开发者的小业务提供了用得起的新方案。

本文方法已开源,欢迎 Star 和试用!

预告:Training-Free GRPO 将作为一个新功能集成到 Youtu-Agent 框架中,帮助开发者们进一步提升各种自定义场景的效果。

注:成本计算基于 DeepSeek API 官方定价,实际可能因使用情况而有所波动。