中科院

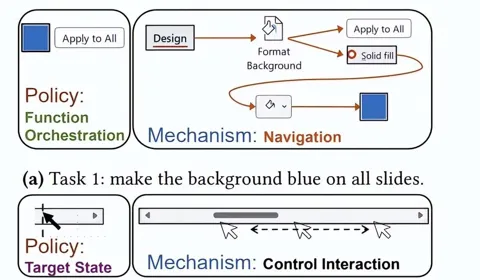

拜拜了GUI!中科院团队“LLM友好”计算机使用接口来了

大模型Agent帮你自动操作电脑,理想很丰满,现实却骨感。 现有的LLM智能体,几乎都绕不开两大核心“痛点”:成功率低:稍微复杂一点的任务,Agent就“翻车”,常常卡在某个步骤不知所措。 效率差:完成一个简单任务,Agent需要和系统进行几十轮“极限拉扯”,耗时漫长,看得人着急。

不靠英伟达,中科院在国产 GPU 上跑通 76B 类脑大模型

过去几年,大模型几乎都依赖 Transformer,它支撑了 GPT、Claude、Gemini 等一众前沿模型的进步,但也一直被诟病:一旦文本变长,计算量和内存消耗就会成倍膨胀,百万级 token 几乎不可承受。 与此同时,大模型训练几乎完全依赖 NVIDIA 的 GPU 体系。 从算力到软件栈,整个行业被牢牢绑定在 CUDA 上,硬件自主化成了迟迟迈不过去的门槛。

手术刀式去噪突破LLM能力上限,从头预训练模型下游任务平均提高7.2% | 中科院&阿里

RefineX团队 投稿. 量子位 | 公众号 QbitAI在噪声污染严重影响预训练数据的质量时,如何能够高效且精细地精炼数据? 中科院计算所与阿里Qwen等团队联合提出RefineX,一个通过程序化编辑任务实现大规模、精准预训练数据精炼的新框架。

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

AI新词

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

英伟达

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

代码

AI for Science

苹果

算法

腾讯

Agent

Claude

芯片

Stable Diffusion

具身智能

xAI

蛋白质

开发者

人形机器人

生成式

神经网络

机器学习

AI视频

3D

RAG

大语言模型

字节跳动

Sora

百度

研究

GPU

生成

工具

华为

AGI

计算

大型语言模型

AI设计

生成式AI

搜索

视频生成

亚马逊

AI模型

DeepMind

特斯拉

场景

深度学习

Transformer

架构

Copilot

MCP

编程

视觉