图像生成

好玩!AI“穿越”新玩法火了:根据12岁照片生成23岁的你

中国有句古话,“三岁看大,七岁看老”——现在,AI技术把这句话变得更直观了。 外国一网友让ChatGTP根据她12岁的照片推测她23岁的样子,结果居然还挺准的? 新玩法一出,很多人兴致勃勃地参与到了这场“穿越”里,甚至脑洞大开地尝试了很多新奇玩法。

7/13/2025 12:37:00 PM

闻乐

扩散语言模型写代码!速度比自回归快10倍

谁说扩散模型只能生成图像和视频? 现在它们能高质量地写代码了,速度还比传统大模型更快! Inception Labs推出基于扩散技术的全新商业级大语言模型——Mercury。

7/10/2025 2:54:13 PM

谢赛宁团队新作:不用提示词精准实现3D画面控制

曾几何时,用文字生成图像已经变得像用笔作画一样稀松平常。 但你有没有想过拖动方向键来控制画面? 像这样,拖动方向键(或用鼠标拖动滑块)让画面里的物体左右移动:还能旋转角度:缩放大小:这一神奇操作就来自于谢赛宁团队新发布的 Blender Fusion框架,通过结合图形工具 (Blender) 与扩散模型,让视觉合成不再仅仅依赖文本提示,实现了精准的画面控制与灵活操作。

7/4/2025 8:52:00 AM

GitHub一周2000星!国产统一图像生成模型神器升级,理解质量双up,还学会了“反思”

国产开源统一图像生成模型,技术重大升级! 新进展来自智源研究院:一模支持文生图、图像编辑、主题驱动图像生成的OmniGen,2.0新版本正式发布。 具体来说,OmniGen2在保持简洁架构的基础上,显著增强了上下文理解能力、指令遵循能力和图像生成质量。

7/3/2025 3:01:26 PM

字节图像生成新模型:主打多主体一致性,新基准数据集同时亮相

设定角色,让AI照“本”生成主角不变的不同图像,对于各路AIGC工具来说一直是不小的挑战。 而现在,字节再进一步,最新发布多主体控制生成模型Xverse——既可以对设定好的每个主体进行精确控制,也不会破坏图像的生成质量。 多主体?

7/3/2025 9:09:51 AM

AI一眼认出95万物种,还能分辨雄雌老幼,2亿生物图像炼成“生命视觉”大模型

让AI看懂95万物种,并自己悟出生态关系与个体差异!俄亥俄州立大学研究团队在2亿生物图像数据上训练了BioCLIP 2模型。 大规模的训练让BioCLIP 2取得了目前最优的物种识别性能。 而更令人惊喜的是,即使在训练过程中没有相应监督信号,BioCLIP 2还在栖息地识别、植物疾病识别等5个非物种任务中给出了远超DINOv2的准确率。

6/30/2025 8:52:00 AM

图像界的DeepSeek!12B参数对标GPT-4o,5秒出图,消费级硬件就能玩转编辑生成

图像模型开源还得是FLUX! Black Forest Labs刚刚宣布开源旗舰图像模型FLUX.1 Kontext[dev],专为图像编辑打造,还能直接在消费级芯片上运行。 只有小小的12B,更少的参数,更快的推理,性能更是媲美GPT-image-1等一众闭源模型。

6/30/2025 8:48:50 AM

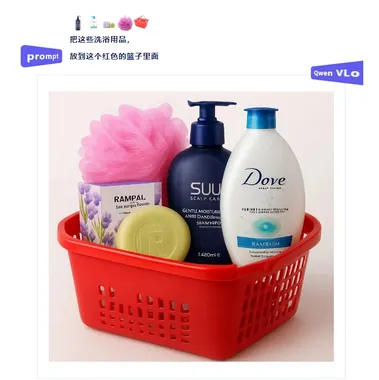

通义千问发布多模态统一理解与生成模型Qwen VLo

近日,Qwen VLo多模态大模型正式发布,该模型在图像内容理解与生成方面取得了显著进展,为用户带来了全新的视觉创作体验。 据介绍,Qwen VLo在继承原有Qwen-VL系列模型优势的基础上,进行了全面升级。 该模型不仅能够精准“看懂”世界,更能基于理解进行高质量的再创造,真正实现了从感知到生成的跨越。

6/28/2025 10:00:43 AM

AI在线

国产SOTA新模型精准get“画(3+6)条命的动物” | 开源

生成图像这件事,会推理的AI才是好AI。 举个例子,以往要是给AI一句这样的Prompt:(3 6)条命的动物。 我们人类肯定一眼就知道是猫咪,但AI的思考过程却是这样的:△虽然生成了猫,但思考过程不对思考的过程还是把“(3 6)”里的数字分开来处理,并没有真正get到其背后“九条命的动物=猫”的本意。

6/20/2025 2:37:59 PM

DPO与GRPO谁更胜一筹?港中文、北大等联合发布首个系统性对比研究

近年来,强化学习 (RL) 在提升大型语言模型 (LLM) 的链式思考 (CoT) 推理能力方面展现出巨大潜力,其中直接偏好优化 (DPO) 和组相对策略优化 (GRPO) 是两大主流算法。 如今,这股 RL 的浪潮也涌向了图像生成领域。 当我们将自回归图像生成也视为一种序列化的 CoT 推理过程时,一个核心问题浮出水面:DPO 和 GRPO 在这个新战场上表现如何?

6/20/2025 9:06:00 AM

何恺明改进了谢赛宁的REPA:极大简化但性能依旧强悍

在建模复杂的数据分布方面,扩散生成模型表现出色,不过它的成果大体上与表征学习(representation learning)领域关联不大。 通常来说,扩散模型的训练目标包含一个专注于重构(例如去噪)的回归项,但缺乏为生成学习到的表征的显式正则化项。 这种图像生成范式与图像识别范式差异明显 —— 过去十年来,图像识别领域的核心主题和驱动力一直是表征学习。

6/13/2025 8:53:00 AM

扩散语言模型真的会比自回归好?理论分析结果可能恰恰相反

本工作来自北京大学智能学院贺笛老师课题组与蚂蚁集团武威团队。 贺笛老师在机器学习领域获得过多项荣誉,包括 ICLR 2023 杰出论文奖与 ICLR 2024 杰出论文奖提名。 扩散模型近年来在图像生成领域取得了令人瞩目的成就,其生成图像的质量和多样性令人惊叹。

6/11/2025 9:21:28 AM

像素蛋糕 “方糖大模型” 成功获批,成为国内影像行业首个备案图像大模型

近日,像素蛋糕公司自主研发的 “方糖大模型” 正式通过国家网信办的备案,成为国内影像行业首个获得官方资质的应用级图像大模型。 这一成就不仅标志着方糖大模型在技术上的突破,也显示了其在安全性和规范性方面达到了国家标准。 方糖大模型的成功备案是人工智能领域的重要里程碑,特别是在图像生成技术日益发展的背景下。

5/29/2025 11:01:24 AM

AI在线

CVPR2025|MCA-Ctrl:多方协同注意力控制助力AIGC时代图像精准定制化

本文由中国科学院计算技术研究所研究团队完成,第一作者为硕士生杨晗,通讯作者为副研究员安竹林,助理研究员杨传广。 论文标题:Multi-party Collaborative Attention Control for Image Customization论文地址::,生成式人工智能(Generative AI)技术的突破性进展,特别是文本到图像 T2I 生成模型的快速发展,已经使 AI 系统能够根据用户输入的文本提示(prompt)生成高度逼真的图像。 从早期的 DALL・E 到 Stable Diffusion、Midjourney 等模型,这一领域的技术迭代呈现出加速发展的态势。

5/12/2025 2:16:52 PM

港大&Adobe联合提出图像生成模型PixelFlow,可直接在原始像素空间中运行,无需VAE即可进行端到端训练

香港大学和Adobe联合提出了一种直接在原始像素空间中运行的图像生成模型PixelFlow,这种方法简化了图像生成过程,无需预先训练的变分自编码器 (VAE),并使整个模型能够端到端训练。 通过高效的级联流建模,PixelFlow 在像素空间中实现了可承受的计算成本。 它在 256x256 ImageNet 类条件图像生成基准上实现了 1.98 的 FID。

4/29/2025 9:21:19 AM

AIGC Studio

GPT-4o图像生成能力集成GPTs,开启个性化图像机器人新篇章

OpenAI宣布GPT-4o的图像生成能力正式集成到GPTs(自定义GPT)平台,为开发者与创作者提供了构建个性化图像生成机器人的强大工具。 据AIbase了解,这一更新允许用户通过GPTs打造专属图像生成应用,如海报设计机器人或特定艺术风格生成器,极大地提升了创作灵活性与共享性。 社交平台上的热烈讨论凸显了其广泛影响力,相关功能已向ChatGPT Plus、Pro及Team用户开放。

4/27/2025 5:00:38 PM

AI在线

GPT-4o图像生成功能现已集成至自定义GPTs

2025年4月26日 AIbase报道:OpenAI近日宣布,其旗舰多模态模型GPT-4o的图像生成功能现已正式集成至ChatGPT的自定义GPTs功能中。 这一更新标志着用户创建的定制化AI助手能够直接生成和编辑图像,为内容创作、设计和教育等领域带来更多可能性。 无缝集成的图像生成体验GPT-4o的图像生成功能此前已于2025年3月25日起在ChatGPT和Sora平台向免费、Plus、Pro和Team用户逐步开放。

4/27/2025 9:00:21 AM

AI在线

UniToken:多模态AI的“全能选手”,一次编码搞定图文理解与图像生成!

首次在统一框架内实现理解与生成的“双优表现”,打破了多模态统一建模的僵局! 复旦大学和美团的研究者们提出了UniToken——一种创新的统一视觉编码方案,在一个框架内兼顾了图文理解与图像生成任务,并在多个权威评测中取得了领先的性能表现。 UniToken通过融合连续和离散视觉表征,有效缓解了以往方法中“任务干扰”和“表示割裂”的问题,为多模态统一建模提供了新的范式。

4/25/2025 9:10:00 AM

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

机器人

大模型

数据

Midjourney

开源

Meta

智能

微软

用户

AI新词

GPT

学习

技术

智能体

马斯克

Gemini

图像

Anthropic

英伟达

AI创作

训练

LLM

论文

代码

算法

Agent

AI for Science

芯片

苹果

腾讯

Stable Diffusion

Claude

蛋白质

开发者

生成式

神经网络

xAI

机器学习

3D

RAG

人形机器人

研究

AI视频

生成

大语言模型

具身智能

Sora

工具

GPU

百度

华为

计算

字节跳动

AI设计

AGI

大型语言模型

搜索

视频生成

场景

深度学习

DeepMind

架构

生成式AI

编程

视觉

Transformer

预测

AI模型

伟达

亚马逊

MCP