Scaling Laws

Scaling Laws起源于1993年?OpenAI总裁:深度学习的根本已揭秘

AI 也要「考古」式科研? 人工智能的「第一性原理」扩展定律(Scaling Laws),把模型性能与算力等资源投入联系在了一起,是如今人们构建更先进大模型重要的参考标尺。 有关扩展定律的起源,存在很多种说法,有人认为是 2020 年 OpenAI 提出的,有人认为是 2017 年百度发现的,详情可参阅我们之前的报道《遗憾不?

9/2/2025 3:14:00 PM

机器之心

苹果发现原生多模态模型Scaling Laws:早融合优于后融合,MoE优于密集模型

让大模型进入多模态模式,从而能够有效感知世界,是最近 AI 领域里人们一直的探索目标。 目前我们见到的很多多模态大模型应用是「组合式」的:其中集成了数个单独预训练的组件,例如将视觉编码器连接到 LLM 上并继续进行多模态训练;而在谷歌 Gemin 2.0 推出之后,原生多模态模型(NMM)被认为是正确的方向。 但从零开始训练的多模态大模型真的是更好的方法吗?

4/12/2025 3:52:00 PM

机器之心

大模型量化训练极限在哪?腾讯混元提出低比特浮点数训练Scaling Laws

AIxiv专栏是AI在线发布学术、技术内容的栏目。 过去数年,AI在线AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。 如果您有优秀的工作想要分享,欢迎投稿或者联系报道。

1/16/2025 9:06:00 PM

机器之心

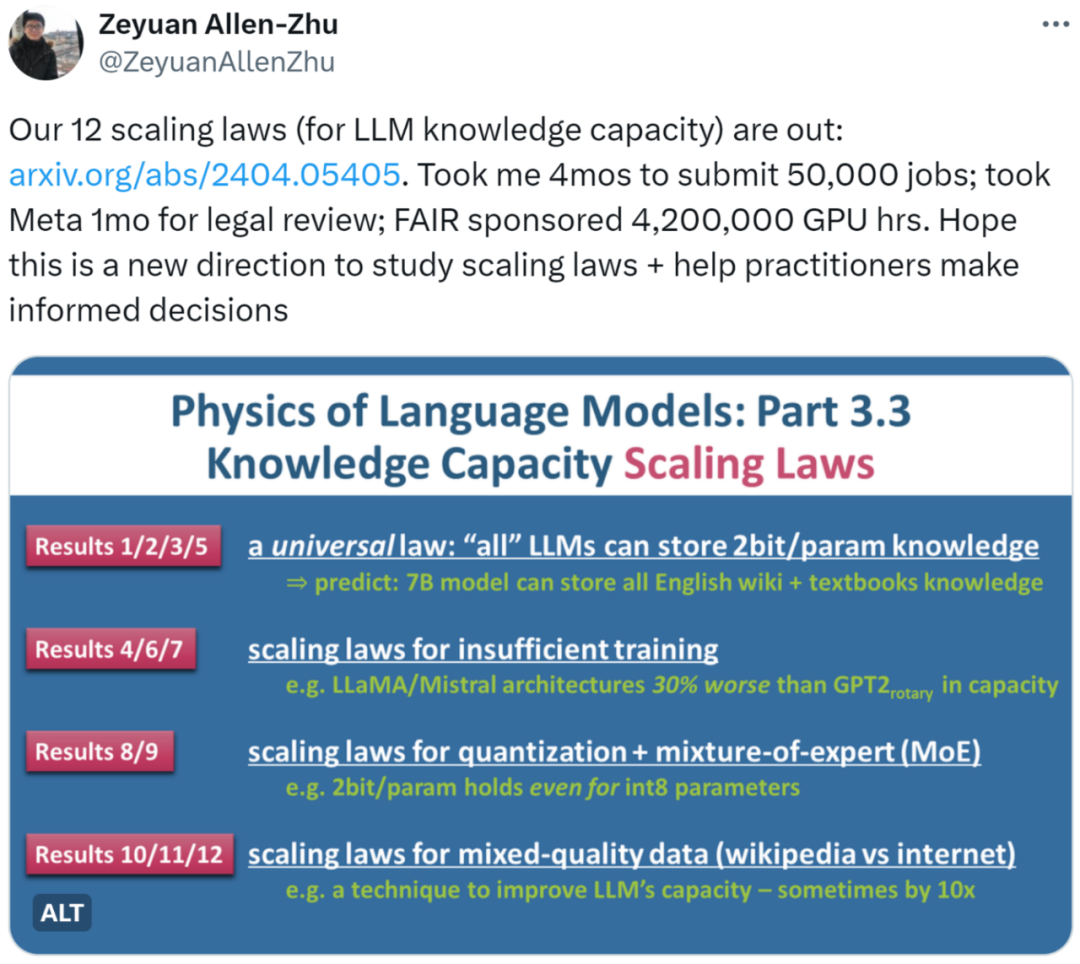

Llama架构比不上GPT2?神奇token提升10倍记忆?

一个 7B 规模的语言模型 LLM 能存储多少人类知识?如何量化这一数值?训练时间、模型架构的不同将如何影响这一数值?浮点数压缩 quantization、混合专家模型 MoE、以及数据质量的差异 (百科知识 vs 网络垃圾) 又将对 LLM 的知识容量产生何种影响?近日,朱泽园 (Meta AI) 和李远志 (MBZUAI) 的最新研究《语言模型物理学 Part 3.3:知识的 Scaling Laws》用海量实验(50,000 条任务,总计 4,200,000 GPU 小时)总结了 12 条定律,为 LLM 在

4/10/2024 2:49:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

腾讯

Agent

Claude

芯片

Stable Diffusion

具身智能

蛋白质

xAI

开发者

生成式

人形机器人

神经网络

机器学习

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

字节跳动

工具

华为

AGI

计算

大型语言模型

AI设计

搜索

生成式AI

视频生成

亚马逊

DeepMind

AI模型

特斯拉

场景

深度学习

Transformer

架构

MCP

Copilot

编程

视觉