LoRA

1100多个模型殊途同归,指向一个「通用子空间」,柏拉图又赢一回?

模型架构的重要性可能远超我们之前的认知。 最近,约翰斯・霍普金斯大学的一项研究发现:1100 多个不同的神经网络,即使在完全不同的数据集上训练、用不同的初始化和超参数,最终学到的权重都会收敛到一个共享的低维子空间。 这似乎是说明:存在一个「先验的」数学结构,所有神经网络都在逼近它。

12/14/2025 9:00:00 PM

机器之心

StereoAdapter:北大首提自监督,适配水下双目深度估计

水下环境中的深度感知对水下机器人自主导航、目标检测和三维重建等任务至关重要。 相比单目方法,双目视觉可以通过双目相机直接获得具有度量尺度的3D深度,避免了单目深度固有的尺度不确定性。 然而,将现有视觉算法直接应用于水下场景会遇到显著挑战。

10/27/2025 1:13:00 AM

新智元

Thinking Machines又发高质量博客:力推LoRA,不输全量微调

LoRA 在绝大多数后训练场景下,能以远低于全量微调的成本,获得几乎同等的效果。 Thinking Machines 将这一现象形容为 LoRA 的低遗憾区间(low-regret region)——即便不用全量微调,选择 LoRA 也不会让人后悔。 最近,Thinking Machines 真实高产啊。

9/30/2025 7:21:00 PM

机器之心

小学生都能看懂!12个常用的AI大模型术语科普

想快速掌握大模型关键技术? 本文从 AI 产品经理视角,深入浅出剖析 Agent、MCP 等术语,涵盖定义、原理、应用场景及相关概念关系,为你构建清晰知识体系,助你在大模型浪潮中把握技术核心,提升产品竞争力。 在大模型快速演进的今天,我们每天都能听到各种新词横飞—Agent、SFT、MCP、RAG、LoRA……仿佛不懂这些术语,就跟不上AI时代的脚步。

9/9/2025 1:55:04 AM

A ad钙

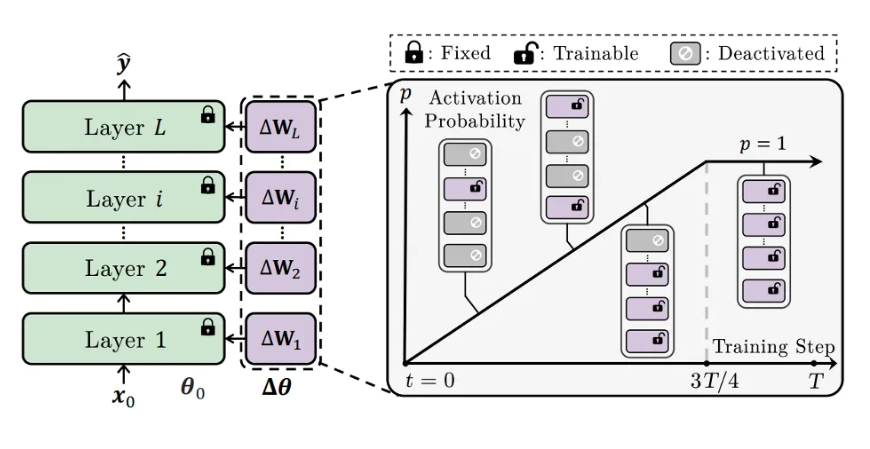

ICML 2025 | CoTo:让LoRA训练「渐入佳境」,模型融合、剪枝样样精通

本文第一作者庄湛,香港城市大学和南方科技大学联合培养博士生,研究方向是迁移学习、扩散模型、大模型微调等。 本文通讯作者魏颖,浙江大学「百人计划」研究员,博士生导师,研究方向包括持续学习、迁移学习、组合泛化以及在科学领域中的应用等。 通讯作者张宇,南方科技大学副教授,研究方向包括深度学习、多任务学习、迁移学习、元学习以及在计算机视觉和自然语言处理方面的应用。

7/26/2025 11:02:00 PM

机器之心

Lora微调实操演示(下):五次训练详解(免费GPU)

五月底写过一篇 Lora 微调的概念铺垫文章,这篇来结合阿里云的一个开源项目和免费试用 GPU 来做个完整的训练过程演示。 Lora微调实操教程(上):人话版概念详解(附案例)注:本篇演示的脚本部分在参考 aliyun_acp_learning 开源项目基础上有部分删减和调整。 后文相关配置和训练过程中的实际耗时也会进行标注说明。

7/14/2025 9:00:13 AM

韦东东

Lora微调实操教程(上):人话版概念详解(附案例)

知识星球中,上个月有个关于让 LLM 学习公司内部业务和产品逻辑中,微调、RAG、提示词三者效果对比的提问。 我当时给出了一个经典的客服场景数据集构建示例,鉴于后续又陆续有人评论和私信来问,从这篇开始,专门写两篇内容来做个粗浅的分享。 之所以要分两篇内容,我想还是在做具体的微调案例演示前,把一些基本概念尽可能的讲清楚,这样感兴趣的话在复现下期案例和二开时,能够在自己的业务场景下对参数调优更有的放矢些。

7/11/2025 10:31:11 AM

韦东东

重磅突破!ICEdit推出LoRA尺度修改功能:AI图像编辑迎来精细控制新时代

备受瞩目的AI图像编辑工具ICEdit迎来重大更新,其Hugging Face演示空间正式上线LoRA尺度修改功能,为全球创作者带来前所未有的图像精细控制体验。 这一革命性功能允许用户通过简单调整LoRA权重,实现对编辑强度与效果的灵活掌控,大幅提升创作自由度。 AIbase观察到,此次升级显著增强了ICEdit在多任务图像编辑领域的核心竞争力,迅速吸引了全球开发者和创意人士的热切关注。

5/9/2025 11:04:21 AM

AI在线

Remade AI 开源 8 款 Wan2.1 特效 LoRA,掀起 AI 视频创作新热潮

3 月 12 日,AI创新团队Remade AI 在Hugging Face平台震撼发布 8 款基于Wan2. 1 模型的开源特效LoRA,引发科技圈广泛关注。 这 8 款特效包括“挤压”(Squish)、“蛋糕化”(Cakeify)、“膨胀”(Inflate)、“缩小”(Deflate)、“射击”(Shooting)、“旋转”(Rotate)、“肌肉增强”(Muscle)和“压扁”(Crush),为AI视频生成注入全新创意可能。

3/13/2025 9:51:00 AM

AI在线

视频训练LoRA来了!Ostris 用 20 张照片打造惊艳 Wan 2.1 LoRA

2025年3月9日,美国加利福尼亚州——开源模型正让文生视频技术变得越来越有趣。 AI 开发者 Ostris(@ostrisai)近日在 X 平台上分享了他使用自家照片训练的 Wan2.1LoRA 模型成果,仅凭约20张照片和一块家用 RTX4090显卡,便实现了令人惊叹的视频生成效果。 这一成果不仅展示了开源技术的潜力,也引发了 X 社区对视频 LoRA 训练工具的热烈讨论。

3/10/2025 9:00:39 AM

AI在线

机器学习|从0开始大模型之模型LoRA训练

1、LoRA是如何实现的? 在深入了解 LoRA 之前,我们先回顾一下一些基本的线性代数概念。 1.1、秩给定矩阵中线性独立的列(或行)的数量,称为矩阵的秩,记为 rank(A) 。

12/26/2024 12:46:25 AM

周末程序猿

在家中完成LLM微调高效指南(上)

编辑 | 言征出品 | 51CTO技术栈(微信号:blog51cto)LLM在生成文本和理解信息方面非常有效,但它们最终受限于训练数据的语料库。 例如,如果你让一个通用的预训练模型回答与你的业务特定流程或操作有关的问题,最好的结果是它拒绝,最坏的情况是它会信誓旦旦地给出一个看似合理但错误的答案。 当然,你可以通过自己训练一个模型来解决这个问题,但所需的资源往往超出实际可行的范围。

11/11/2024 1:33:28 PM

言征

LoRA、完全微调到底有何不同?MIT 21页论文讲明白了

本文旨在了解两种微调大型语言模型方法之间的差异:完全微调和低秩自适应 (LoRA)。 这两种方法都用于将预训练模型适应特定的下游任务,但它们却有所不同。 微调(Fine-tuning)是将经过预训练的大语言模型应用于下游任务的关键范例。

11/11/2024 1:13:00 PM

机器之心

超详细!写给设计师的LoRa模型训练SOP

写在前面:

在推进 AIGC 技术在我们业务中的应用过程中,我发现许多同事,特别是设计师和跨部门协作的团队,对 LoRA 模型在图像生成中的真正价值理解还不够深入。我们似乎更多地停留在"别人在做,我也要做"的从众心态,而没有真正认识到 LoRA 模型的战略意义和变革潜力。

这种认知差距可能会导致我们在实践中走一些弯路,无法充分发挥 LoRA 模型的优势,也难以实现 AIGC 技术在业务中的最大化赋能。因此,我针对 LoRA 模型训练流程进行了系统梳理和优化,希望能给大家一些启发,帮助我们更好地理解和应用这一强大的工

4/8/2024 6:51:01 AM

NIC

比LoRA还快50%的微调方法来了!一张3090性能超越全参调优,UIUC联合LMFlow团队提出LISA

2022 年底,随着 ChatGPT 的爆火,人类正式进入了大模型时代。然而,训练大模型需要的时空消耗依然居高不下,给大模型的普及和发展带来了巨大困难。面对这一挑战,原先在计算机视觉领域流行的 LoRA 技术成功转型大模型 [1][2],带来了接近 2 倍的时间加速和理论最高 8 倍的空间压缩,将微调技术带进千家万户。但 LoRA 技术仍存在一定的挑战。一是 LoRA 技术在很多任务上还没有超过正常的全参数微调 [2][3][4],二是 LoRA 的理论性质分析比较困难,给其进一步的研究带来了阻碍。UIUC 联合

4/1/2024 2:37:00 PM

机器之心

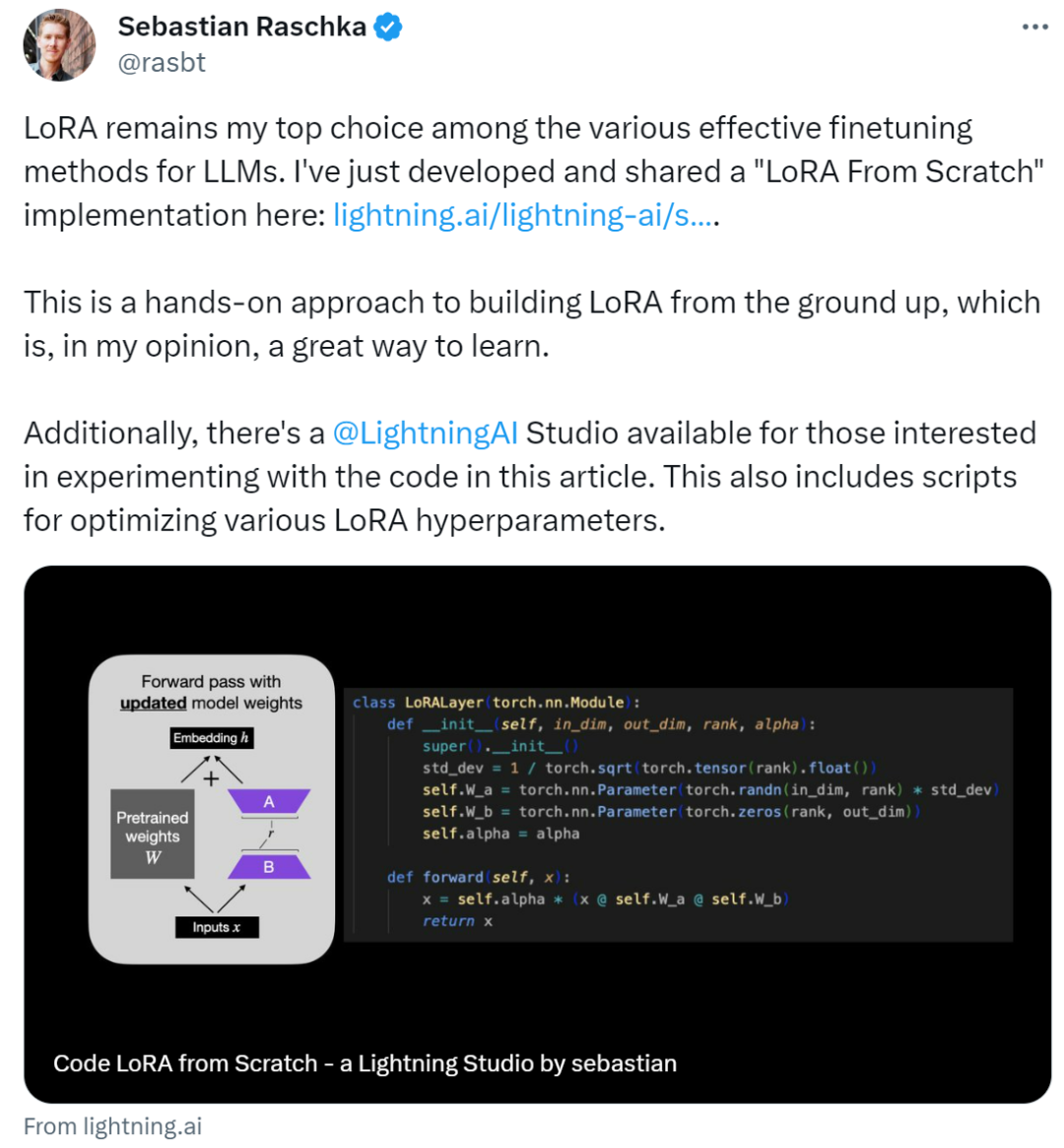

如何从头开始编写LoRA代码,这有一份教程

作者表示:在各种有效的 LLM 微调方法中,LoRA 仍然是他的首选。LoRA(Low-Rank Adaptation)作为一种用于微调 LLM(大语言模型)的流行技术,最初由来自微软的研究人员在论文《 LORA: LOW-RANK ADAPTATION OF LARGE LANGUAGE MODELS 》中提出。不同于其他技术,LoRA 不是调整神经网络的所有参数,而是专注于更新一小部分低秩矩阵,从而大大减少了训练模型所需的计算量。由于 LoRA 的微调质量与全模型微调相当,很多人将这种方法称之为微调神器。自发布

3/20/2024 2:43:00 PM

机器之心

告别冷启动,LoRA成为大模型「氮气加速器」,提速高达300%

用 LoRA 打造更快的 AI 模型。AI 模型功能越来越强大,结构也越来越复杂,它们的速度也成为了衡量先进程度的标准之一。如果 AI 是一辆豪华跑车,那么 LoRA 微调技术就是让它加速的涡轮增压器。LoRA 强大到什么地步?它可以让模型的处理速度提升 300%。还记得 LCM-LoRA 的惊艳表现吗?其他模型的十步,它只需要一步就能达到相媲美的效果。这是怎么做到的?Raphael G 的博客详细说明了 LoRA 如何在提高模型推理效率和速度方面取得显著成效,并介绍了这一技术实现的改进及其对 AI 模型性能的重大

1/2/2024 2:11:00 PM

机器之心

不是大模型全局微调不起,只是LoRA更有性价比,教程已经准备好了

这是作者 Sebastian Raschka 经过数百次实验得出的经验,值得一读。增加数据量和模型的参数量是公认的提升神经网络性能最直接的方法。目前主流的大模型的参数量已扩展至千亿级别,「大模型」越来越大的趋势还将愈演愈烈。这种趋势带来了多方面的算力挑战。想要微调参数量达千亿级别的大语言模型,不仅训练时间长,还需占用大量高性能的内存资源。为了让大模型微调的成本「打下来」,微软的研究人员开发了低秩自适应(LoRA)技术。LoRA 的精妙之处在于,它相当于在原有大模型的基础上增加了一个可拆卸的插件,模型主体保持不变。L

12/4/2023 5:13:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

AI模型

特斯拉

场景

深度学习

亚马逊

架构

Transformer

MCP

Copilot

编程

视觉