奖励

克服奖励欺骗:Meta 发布全新后训练方式 CGPO 编程水平直升 5%,打破 RLHF 瓶颈

CGPO 框架通过混合评审机制和约束优化器,有效解决了 RLHF 在多任务学习中的奖励欺骗和多目标优化问题,显著提升了语言模型在多任务环境中的表现。 CGPO 的设计为未来多任务学习提供了新的优化路径,有望进一步提升大型语言模型的效能和稳定性。 近年来,随着大规模语言模型(LLMs)的发展,特别是通用大模型的应用场景愈发广泛,RLHF 逐渐成为调整和优化语言模型输出的主流方法。

11/1/2024 10:31:28 PM

问舟

昆仑万维发布奖励模型 Skywork-Reward,登顶 RewardBench 排行榜

昆仑万维发布了两款全新的奖励模型 Skywork-Reward-Gemma-2-27B 和 Skywork-Reward-Llama-3.1-8B。在奖励模型评估基准 RewardBench 上,这两款模型分别位列排行榜上的第一和第三位。奖励模型(Reward Model)是强化学习(Reinforcement Learning)中的核心概念和关键组成,它用于评估智能体在不同状态下的表现,并为智能体提供奖励信号以指导其学习过程,让智能体能够学习到在特定环境下如何做出最优选择。奖励模型在大语言模型(Large Lan

9/13/2024 3:00:14 PM

沛霖(实习)

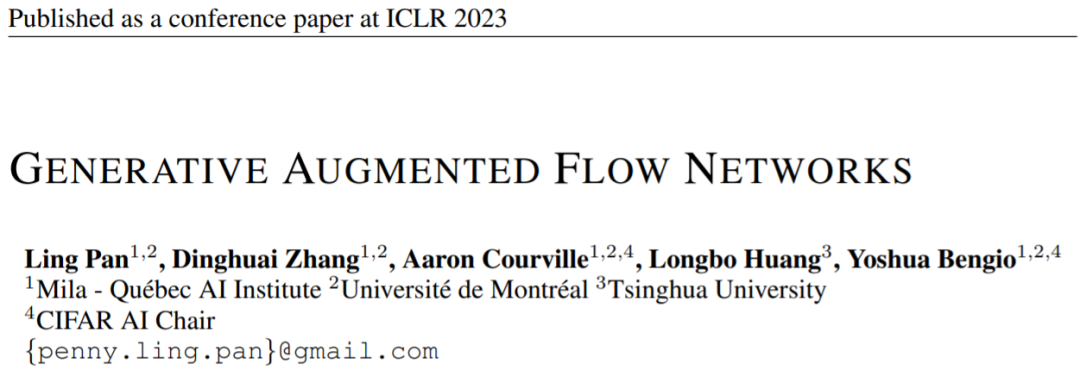

ICLR 2023 Spotlight | Yoshua Bengio团队新作,生成拓展流网络

本工作已入选 ICLR 2023 Spotlight,也是 GFlowNets 领域第一篇 Spotlight 文章。

5/3/2023 5:55:00 PM

机器之心

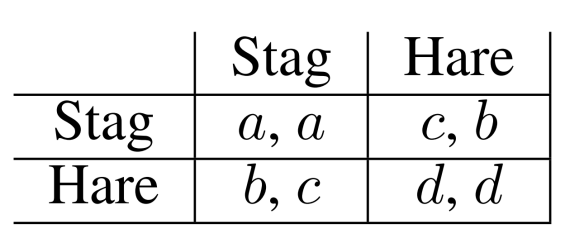

通过奖励随机化发现多智能体游戏中多样性策略行为,清华、UC伯克利等研究者提出全新算法RPG

在这篇论文中,研究者提出了一个在 reward-space 进行探索的新算法 RPG(Reward-Randomized Policy Gradient),并且在存在多个纳什均衡 (Nash Equilibrium, NE) 的挑战性的多智能任务中进行了实验验证,实验结果表明,RPG 的表现显著优于经典的 policy/action-space 探索的算法,并且发现了很多有趣的、人类可以理解的智能体行为策略。除此之外,论文进一步提出了 RPG 算法的扩展:利用 RR 得到的多样性策略池训练一个新的具备自适应能力的策

3/11/2021 2:46:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

AI模型

特斯拉

场景

深度学习

亚马逊

架构

Transformer

MCP

Copilot

编程

视觉